在AGI的探索中,我们再次突破大模型的能力边界。

作为GLM系列的最新版本,GLM-4.6是我们最强的代码Coding模型(较GLM-4.5提升27%)。在真实编程、长上下文处理、推理能力、信息搜索、写作能力与智能体应用等多个方面实现全面提升。如下:

- 高级编码能力:在公开基准与真实编程任务中,GLM-4.6的代码能力对齐Claude Sonnet 4,是国内已知的最好的Coding模型。

- 上下文长度:上下文窗口由128K→200K,适应更长的代码和智能体任务。

- 推理能力:推理能力提升,并支持在推理过程中调用工具。

- 搜索能力:增强了模型在工具调用和搜索智能体上的表现,在智能体框架中表现更好。

- 写作能力:在文风、可读性与角色扮演场景中更符合人类偏好。

GLM-4.6 已上线智谱MaaS平台bigmodel.cn,即将在Hugging Face、ModelScope开源,遵循MIT协议。

性能:Coding能力创国产模型新高

1.综合评测

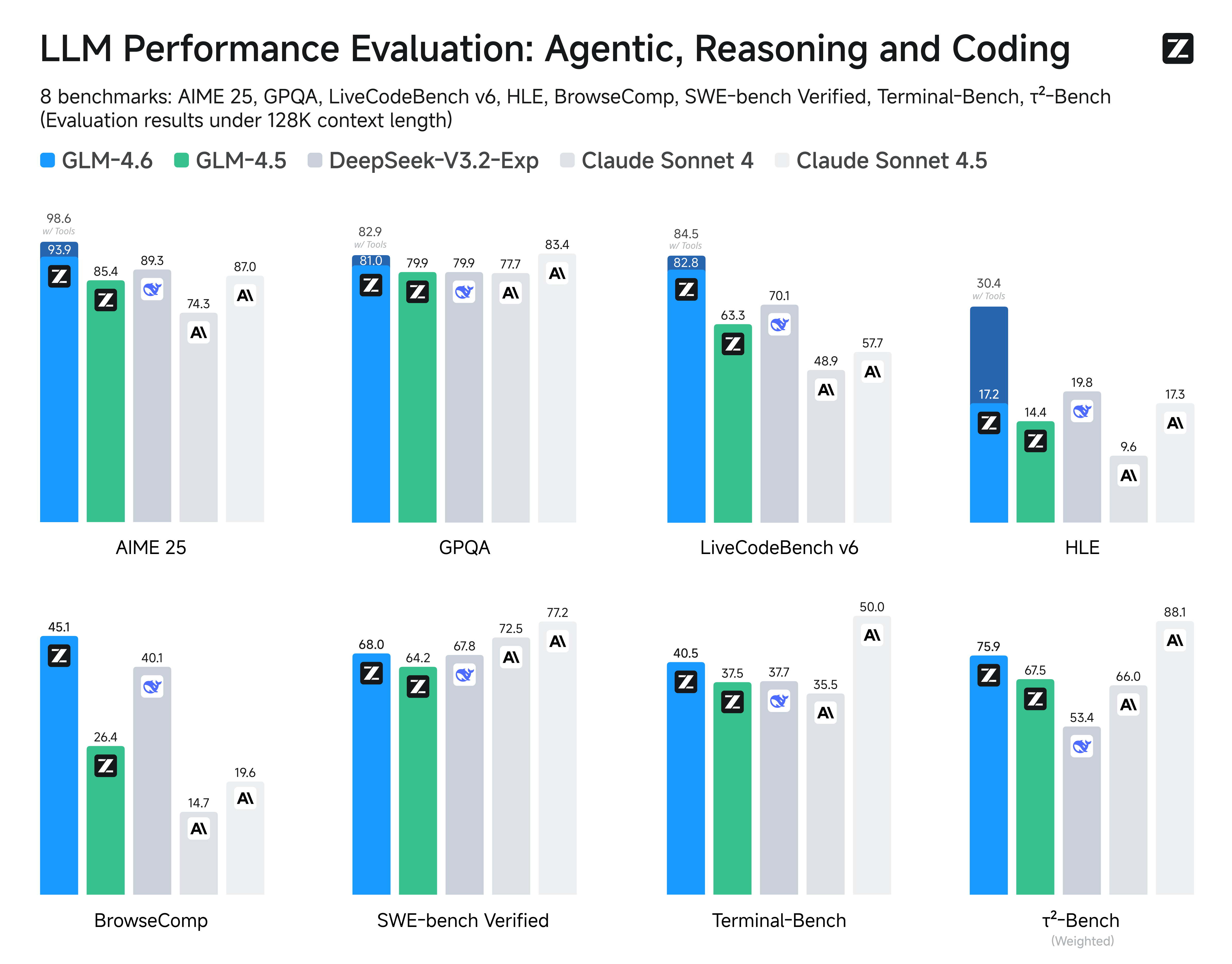

在8大权威基准:AIME 25、GPQA、LCB v6、HLE、SWE-Bench Verified、BrowseComp、Terminal-Bench、τ^2-Bench、GPQA 模型通用能力的评估中,GLM-4.6在大部分权威榜单表现对齐Claude Sonnet 4,稳居国产模型首位。

2.真实编程评测

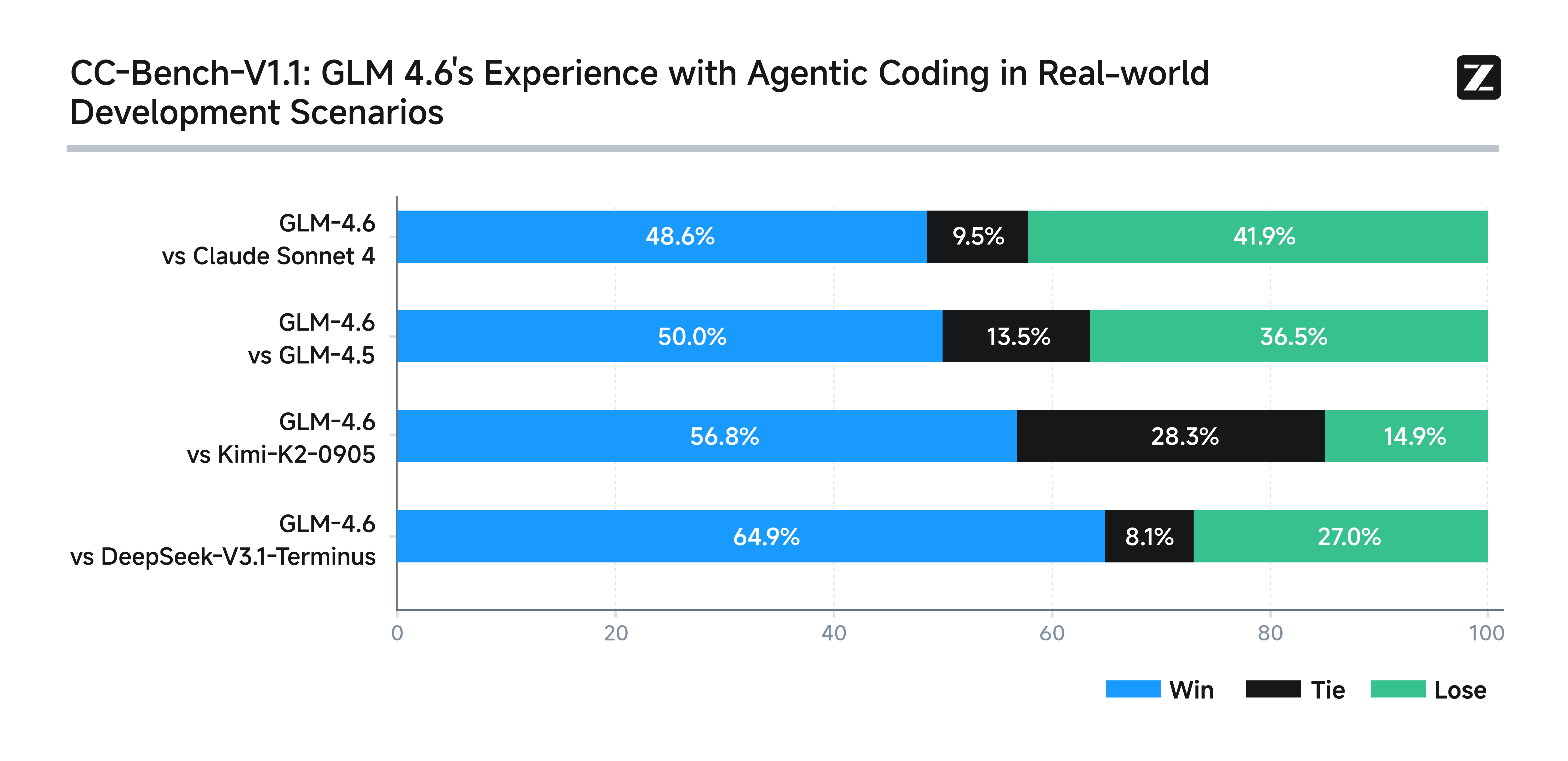

为了测试模型在实际编程任务中的能力,我们在Claude Code环境下进行了74个真实场景编程任务测试。结果显示,GLM-4.6实测超过Claude Sonnet 4,超越其他国产模型。

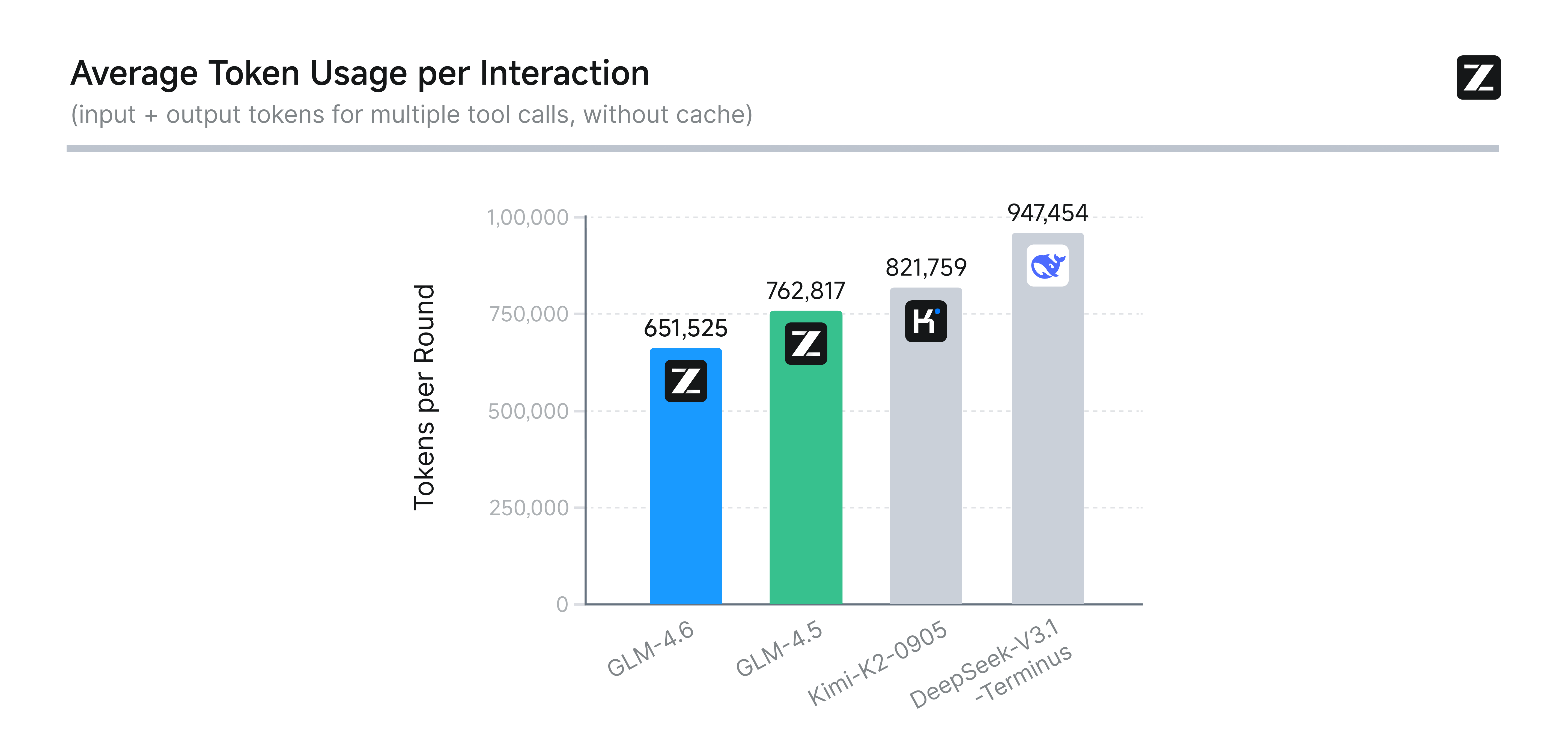

在平均token消耗上,GLM-4.6比GLM-4.5节省30%以上,为同类模型最低。

为确保透明性与可信度,智谱已公开全部测试题目与Agent轨迹,供业界验证与复现(链接:https://huggingface.co/datasets/zai-org/CC-Bench-trajectories)。

适配:寒武纪、摩尔线程芯片

GLM-4.6已在寒武纪领先的国产芯片上实现FP8+Int4混合量化部署,这是首次在国产芯片投产的FP8+Int4模型芯片一体解决方案,在保持精度不变的前提下,大幅降低推理成本,为国产芯片在大模型本地化运行上开创了可行路径。

基于vLLM推理框架部署,摩尔线程新一代GPU可基于原生FP8精度稳定运行GLM-4.6,充分印证了MUSA架构和全功能GPU在生态兼容与快速支持方面的强大优势。

GLM-4.6和寒武纪、摩尔线程国产芯片的组合,即将通过智谱MaaS平台正式面向大众和企业提供服务。未来,国产原创GLM大模型与国产芯片将联合推动在模型训练和推理环节的性能与效率优化。

价格:Coding Plan 全面升级

随着GLM-4.6发布,智谱同步升级GLM Coding Plan(最低20元包月畅玩套餐):1/7价格享受到Claude的9/10智商。

同时推出GLM Coding Plan企业版套餐,为企业级用户提供兼具安全、成本效益与国际顶尖性能的编码套餐。

此前订阅GLM Coding Plan包月套餐的用户自动升级至GLM-4.6,新增:

- 图像识别与搜索能力。

- 支持Claude Code、Roo Code、Kilo Code、Cline等10+主流编程工具。

- 面向高频重度开发者提供GLM Coding Max,是Claude Max (20x) plan三倍用量。

获取与体验

- 智谱MaaS平台bigmodel.cn、z.ai、智谱清言已全面支持GLM-4.6;

- 海外用户可通过z.ai、OpenRouter使用 API;

- 开源部署:GLM-4.6模型将在Hugging Face、ModelScope发布;

- 开发者和企业通过bigmodel.cn直接购买GLM Coding Plan套餐/企业版套餐。

GLM-4.6的上一代模型GLM-4.5首次在单个模型中实现将推理、编码和智能体能力原生融合。GLM-4.5在代码能力上的突出表现让其取得一些成绩,在OpenRouter上稳居全球前十供应商,自发布后智谱MaaS平台API商业化实现10倍以上增长。

67

67

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?