Scrapy框架的初步运用

上午刚配置好scrapy框架,下午我就迫不及待的做了一个小demo来测试一下,结果证明scrapy真是太强大了。我感觉等对它掌握到炉火纯青的地步后,就没有什么数据是爬不到的了,O(∩_∩)O哈哈~。

以下步骤是建立在成功安装并配置好scrapy的基础上的.

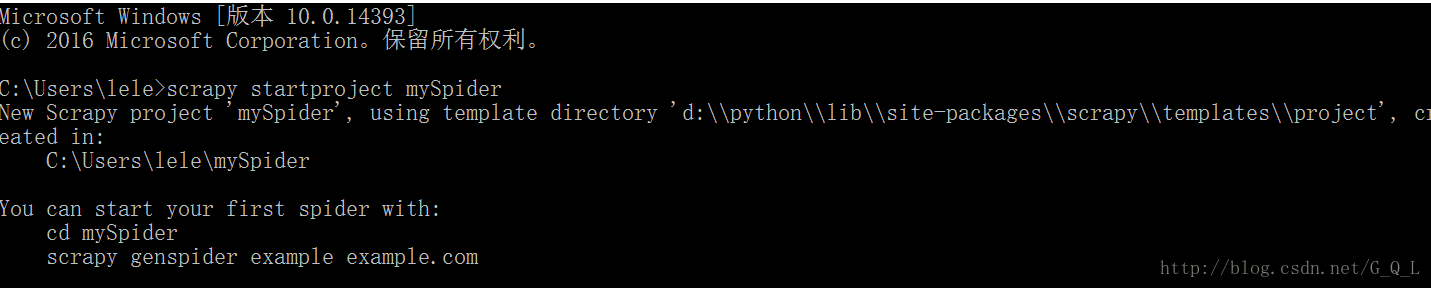

1.新建一个Scrapy项目

打开cmd控制台界面

输入:scrapy startproject myScrapy

下面是创建的工程中所包含的文件:

__init__.py:项目的初始化文件;

items.py:项目的目标文件

pipelines.py:项目的管道文件

settings.py:项目的设置文件

spiders/:存放爬虫代码的文件

spiders/__init__.py:爬虫的初始话文件

2.定义Item

Items是保存爬取到的数据的容器,其使用方法和python字典类似, 它提供了额外保护机制来避免拼写错误导致的未定义字段错误,这类似与ORM中的映射关系。

这是items.py中的默认代码:

import scrapy

class mySpiderItem(scrapy.Item):

#name = scrapy.Field()

pass

本文介绍了使用Scrapy框架创建爬虫项目的过程,包括新建项目、定义Item、创建爬虫文件、修改settings文件和管道文件,最终成功将数据保存到JSON文件中,展示了Scrapy的强大数据爬取能力。

本文介绍了使用Scrapy框架创建爬虫项目的过程,包括新建项目、定义Item、创建爬虫文件、修改settings文件和管道文件,最终成功将数据保存到JSON文件中,展示了Scrapy的强大数据爬取能力。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1638

1638

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?