Hadoop3.0.0的新特新

–最底版本的Java版本由Java7升级为Java8

–HDFS支持纠删码技术(即EC技术,它的基本原理是把M份原始数据通过矩阵运算的方式,生成K份效验数据。这样在整个M+K份数据中,丢失任何K份都可以正常恢复。最常见的糾删码配置大概会给每一份原始数据生成0.5份冗余效验数据。这样就会把整个集群的存储成本减半。糾删码的代价就是在出现故障的时候要重新执行矩阵运算来恢复数据。所以它的基本思路可以说就是计算换存储。)

–YARN Timeline Service v.2

–重写shell脚本

–Mapreduce task-level native优化

–支持多余2个的NameNode,进一步增强集群的可靠性。

先决条件

1、支持平台

GNU/Linux目前被作为开发以及生产平台,Hadoop目前在GNU/Linux平台上搭建2000多个节点的集群。

Hadoop目前也支持Windows平台。

2、所需软件

Linux和Windows所需软件包括:

1)Java选择Sun公司发行的jdk1.8 ;

2)ssh 必须安装并且保证 sshd一直运行,以便Hadoop 脚本管理远端Hadoop守护进程。此外,在ssh安装的基础上,再安装pdsh

3、安装软件

如果你的集群没有要求的软件,你必须去安装这些软件。

例如,在CentOS上:

# yum -y install ssh

# yum -y install pdsh

下载Hadoop3.0链接地址如下

http://www.apache.org/dyn/closer.cgi/hadoop/common/hadoop-3.0.0-alpha1/hadoop-3.0.0-alpha1.tar.gz

1、准备启动Hadoop集群

解压下载的Hadoop包,在Hadoop包中编辑etc/hadoop/hadoop-env.sh配置文件如下:

# set to the root of your Java installation

export JAVA_HOME=/usr/java/latest

尝试如下命令:

$ bin/hadoop

2、本地模式

默认的,Hadoop被配置为为分布式模式,作为一个单个Java进程。这对debug调试很有用。

本地模式实例如下:

$ mkdir input

$ cp etc/hadoop/*.xml input

$ bin/hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-3.0.0-alpha1.jar grep input output 'dfs[a-z.]+'

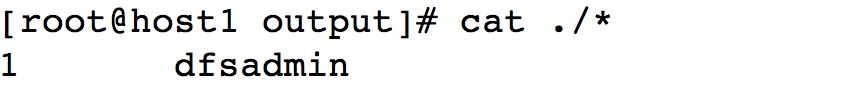

$ cat output/*运行结果如下:

3、伪分布式模式

Hadoop也可以以为分布式的模式运行在单个节点上,其中Hadoop的守护进程运行在不同的Java进程中。

(1)配置

编辑etc/hadoop/core-site.xml如下:

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>编辑etc/hadoop/hdfs-site.xml如下:

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration>编辑etc/hadoop/yarn-site.xml如下:

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<property>

<name>mapreduce.admin.user.env</name>

<value>HADOOP_MAPRED_HOME=$HADOOP_COMMON_HOME</value>

</property>

<property>

<name>yarn.app.mapreduce.am.env</name>

<value>HADOOP_MAPRED_HOME=$HADOOP_COMMON_HOME</value>

</property>

</configuration>编辑etc/hadoop/mapred-site.xml如下:

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<property>

<name>mapreduce.admin.user.env</name>

<value>HADOOP_MAPRED_HOME=$HADOOP_COMMON_HOME</value>

</property>

<property>

<name>yarn.app.mapreduce.am.env</name>

<value>HADOOP_MAPRED_HOME=$HADOOP_COMMON_HOME</value>

</property>

</configuration>(2)配置ssh免密码登录

$ ssh-keygen -t rsa

$ ssh-copy-id localhost验证ssh免密码登录

$ ssh loclahost(3)格式化NameNode

$ bin/hadoop namenode -format(4)启动HDFS

$ sbin/start-dfs.sh(5)启动YARN

$ sbin/start-yarn.sh(6)通过jsp命令查看启动的服务是否正常

423

423

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?