3、人工智能与深度学习

GPU(图形处理器)在人工智能与深度学习领域的应用是革命性的,极大地推动了这两个领域的发展和普及。以下是GPU在人工智能与深度学习中的关键作用和优势:

1. 并行处理能力GPU设计之初是为了处理图形和视频中的大量并行计算任务,如像素渲染。这种并行架构恰好也适用于深度学习中涉及的大量矩阵运算和向量运算。与CPU相比,GPU拥有更多的核心(CUDA核心或流处理器),能够同时执行成千上万的计算任务,大大加快了训练神经网络的速度。

2. 加速训练和推理深度学习模型的训练通常涉及反向传播算法,需要在大量数据上执行多次迭代,这对计算能力有极高的要求。GPU可以显著减少模型训练的时间,从原本可能需要数周缩短到数小时甚至更少。同时,GPU也加速了模型的推理过程,即使用训练好的模型对新数据进行预测。

3. 框架和库的支持主流的深度学习框架,如TensorFlow、PyTorch、MXNet等,均提供了对GPU的原生支持,使得开发者能够轻松地在GPU上部署和运行他们的模型。此外,NVIDIA等GPU制造商提供了CUDA、cuDNN等工具和库,进一步优化了深度学习算法在GPU上的执行效率。

4. 大规模模型和数据处理随着深度学习模型的复杂度增加,如Transformer架构的出现,模型的参数量可达数十亿甚至上千亿。GPU的高并行处理能力使得处理这类超大规模模型成为可能,同时也能高效处理海量训练数据。

5. 能效比和成本效益尽管GPU在绝对功耗上可能高于CPU,但由于其在处理深度学习任务时的效率极高,因此在能效比上表现出色。这意味着使用GPU进行训练和推理在总体上更为经济,尤其是考虑到时间成本和资源利用率。

6. 推动技术进步和应用创新GPU的广泛应用降低了深度学习技术的入门门槛,使得更多企业和研究机构能够开展相关研究和应用开发。这不仅促进了人工智能技术的飞速发展,还催生了众多创新应用,如图像识别、自然语言处理、自动驾驶、医疗影像分析等。

总之,GPU在人工智能与深度学习领域扮演了核心角色,不仅解决了计算资源的瓶颈问题,还促进了算法模型的迭代和创新,推动了整个人工智能行业的发展。

4、光线追踪技术

光线追踪技术(Ray Tracing)是一种先进的图形渲染方法,它模拟了光线在真实世界中的物理行为,包括光线如何与物体表面交互(反射、折射、散射等),进而生成高度逼真的图像效果。在图形处理器(GPU)领域,光线追踪技术的集成和优化是近年来图形处理技术发展的重要里程碑,尤其是在游戏和视觉效果产业中。以下是一些关键点:

实时光线追踪

•硬件加速:NVIDIA在2018年推出的Turing架构GPU首次将专用的光线追踪硬件单元——RT Core集成到消费级产品中,大大加速了光线追踪的计算过程,实现了实时的光线追踪效果。AMD在其RDNA 2架构的GPU中也加入了硬件加速光线追踪支持。

•光线与场景交互:光线追踪技术不仅计算光线直接击中物体表面的情况,还能精确模拟光线在场景中的多次反弹,产生更自然的阴影、反射、全局光照等效果,显著增强了场景的真实感。

•DLSS与FSR:为了弥补光线追踪带来的性能损失,NVIDIA的Deep Learning Super Sampling (DLSS) 和AMD的FidelityFX Super Resolution (FSR) 等技术利用AI算法提升帧率,同时保持高质量的图像输出,这些技术在光线追踪游戏中尤为重要。

渲染技术的融合

•混合渲染:现代游戏和图形应用程序通常采用混合渲染方法,结合光线追踪与传统的光栅化技术,以平衡图像质量和性能。光线追踪主要用于处理复杂光照和反射,而光栅化处理其他图形元素,两者结合可达到最佳效果。

开发者支持与生态系统

•API支持:Microsoft DirectX Raytracing (DXR) 和Khronos Group的Vulkan Ray Tracing扩展等API的推出,使得开发者能够更容易地在游戏和应用程序中实现光线追踪效果。

•工具和库:NVIDIA RTX、AMD Radeon Rays等工具和库帮助开发者更高效地利用GPU的光线追踪功能,简化开发流程。

应用领域

•游戏:光线追踪技术显著提升了游戏的视觉效果,让游戏画面更加真实,增强了沉浸感。

•电影与视觉效果:在影视制作中,光线追踪被用来创造逼真的场景和特效,特别是在环境光照、反射和阴影处理上。

•建筑设计与可视化:帮助设计师和建筑师在设计阶段就能准确预览建筑在不同光线条件下的真实效果。

总之,GPU中的光线追踪技术是图形渲染领域的一大进步,它推动了图形表现力的边界,为用户带来了前所未有的视觉体验,并在多个行业中展现出广泛的应用潜力。随着技术的持续进步和普及,光线追踪将成为未来图形处理技术的标准配置。

5、GPU与CPU

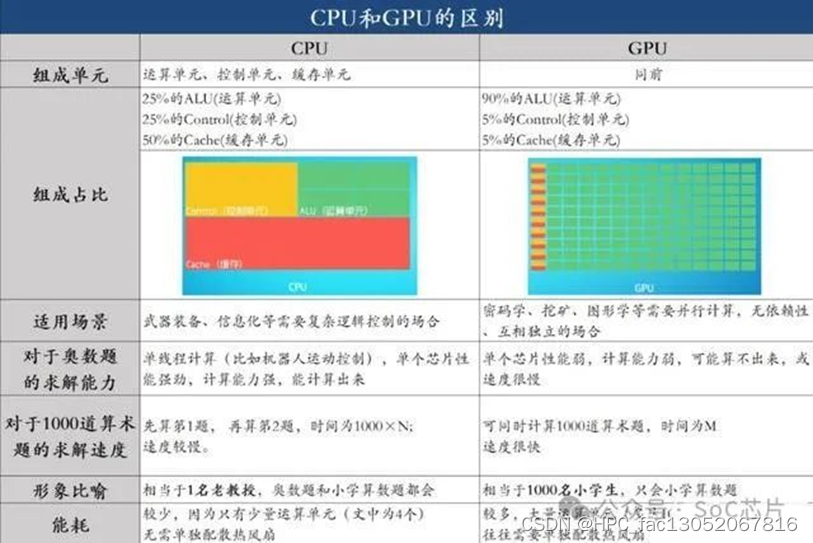

GPU芯片与服务器芯片(通常指的是CPU芯片)在设计目的、架构特点、以及应用领域上有着明显的差异,下面是两者的对比分析:

1.设计目的与架构特点

GPU芯片(Graphics Processing Unit):

•设计目的:起初设计用于图形处理和渲染,后来因其并行处理能力被广泛应用于高性能计算、机器学习、深度学习等领域。

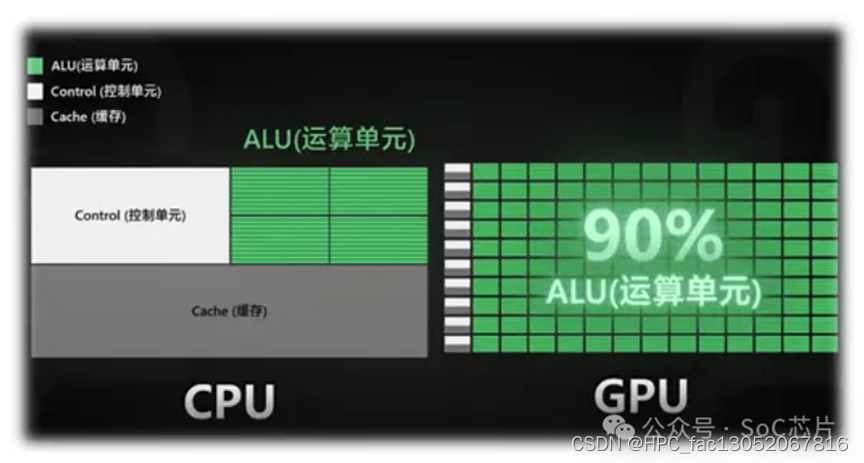

•架构特点:GPU包含大量核心(CUDA核心、流处理器等),每个核心相对简单,但数量庞大,适合执行大量简单且并行的任务。它们拥有宽大的并行计算能力,能够在同一时间内处理成千上万个线程,适合大规模矩阵运算和向量运算。

•内存架构:GPU通常配备较大的显存,用于存储图形数据和计算过程中临时数据,以及专为并行计算优化的缓存和内存访问机制。

服务器芯片(CPU):

•设计目的:服务器芯片主要设计用于执行复杂的系统任务和管理,处理各种系统和应用程序的指令序列,擅长处理低并行度、高复杂度的任务。

•架构特点:CPU包含较少但更复杂的逻辑核心,每个核心能够处理更复杂的指令集,支持高级的线程管理和分支预测等特性。CPU强调单线程性能和低延迟响应。

•内存架构:CPU与系统内存(RAM)的交互更加频繁,通常配备较小的缓存层级(L1、L2、L3缓存),用于加速数据访问和降低延迟。

2.应用领域

GPU:

•图形处理与渲染:游戏、3D建模、影视后期制作等。

•高性能计算:科学研究、气候模拟、分子动力学等。

•人工智能与机器学习:深度学习训练和推理、自然语言处理、图像识别等。

CPU:

•服务器管理:数据库处理、网页服务器、云服务等。

•企业应用:ERP系统、CRM系统、大数据分析等。

•通用计算:操作系统运行、软件服务、企业后台处理等。

3.结合使用

在实际应用中,GPU和CPU经常结合使用,特别是在数据中心和高性能计算环境中。CPU负责复杂的控制逻辑和任务调度,而GPU则承担大量并行计算任务,两者互补,共同提升系统的处理能力和效率。

综上所述,GPU和服务器芯片各有专长,适合不同类型的工作负载。选择哪种芯片取决于应用的具体需求,如是否需要高度并行处理能力、是否侧重于低延迟响应或是处理大量图形和数据运算等。

7824

7824

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?