1.背景介绍

强化学习(Reinforcement Learning, RL)是一种人工智能技术,它通过在环境中执行一系列动作来学习如何取得最大化的奖励。在过去的几年里,强化学习已经取得了显著的进展,并在许多领域得到了广泛的应用,如游戏、机器人控制、自动驾驶等。

然而,随着互联网的普及和技术的不断发展,网络安全也成为了一个重要的问题。网络安全涉及到的领域非常广泛,包括防火墙、恶意软件检测、网络辅助攻击、网络流量分析等。在这些领域,强化学习可以被应用于优化网络安全策略,提高网络安全系统的效率和准确性。

本文将讨论如何将强化学习与网络安全结合起来,以提高网络安全系统的性能。我们将从以下几个方面进行讨论:

- 背景介绍

- 核心概念与联系

- 核心算法原理和具体操作步骤以及数学模型公式详细讲解

- 具体代码实例和详细解释说明

- 未来发展趋势与挑战

- 附录常见问题与解答

2.核心概念与联系

=========

在网络安全领域,强化学习可以被应用于优化网络安全策略,提高网络安全系统的效率和准确性。具体而言,强化学习可以用于优化防火墙策略、恶意软件检测策略、网络辅助攻击策略等。

在这些领域,强化学习的目标是找到一种策略,使得在给定的环境中,系统可以最大化获得奖励。奖励可以是正面的(例如,防火墙策略正确阻止了恶意攻击)或负面的(例如,恶意软件检测策略误报了有害软件)。

强化学习与网络安全的联系主要体现在以下几个方面:

- 强化学习可以用于优化网络安全策略,提高网络安全系统的效率和准确性。

- 强化学习可以用于学习网络安全策略,以便在未知的网络环境中进行有效的攻击预测和防御。

- 强化学习可以用于优化网络安全策略,以便在有限的计算资源和时间内实现最大化的安全性。

3.核心算法原理和具体操作步骤以及数学模型公式详细讲解

在这里,我们将详细讲解强化学习中的强化学习与网络安全的结合,以及相关的算法原理和操作步骤。

3.1 强化学习基本概念

强化学习是一种机器学习技术,它通过在环境中执行一系列动作来学习如何取得最大化的奖励。强化学习系统由以下几个组成部分:

- 代理(Agent):强化学习系统中的主要组成部分,负责执行动作并接收环境的反馈。

- 环境(Environment):强化学习系统中的另一个重要组成部分,负责提供给代理的状态和奖励信息。

- 状态(State):代理在环境中的当前状态。

- 动作(Action):代理可以执行的动作。

- 奖励(Reward):代理执行动作后接收的奖励信息。

强化学习的目标是找到一种策略,使得在给定的环境中,系统可以最大化获得奖励。

3.2 强化学习与网络安全的结合

在网络安全领域,强化学习可以被应用于优化网络安全策略,提高网络安全系统的效率和准确性。具体而言,强化学习可以用于优化防火墙策略、恶意软件检测策略、网络辅助攻击策略等。

在这些领域,强化学习的目标是找到一种策略,使得在给定的环境中,系统可以最大化获得奖励。奖励可以是正面的(例如,防火墙策略正确阻止了恶意攻击)或负面的(例如,恶意软件检测策略误报了有害软件)。

3.3 核心算法原理

强化学习中的强化学习与网络安全的结合,可以使用以下几种算法:

-

Q-Learning:Q-Learning是一种基于表格的强化学习算法,它可以用于学习状态-动作对的价值函数。Q-Learning的目标是找到一种策略,使得在给定的环境中,系统可以最大化获得奖励。

-

Deep Q-Network(DQN):DQN是一种基于神经网络的强化学习算法,它可以用于学习状态-动作对的价值函数。DQN的目标是找到一种策略,使得在给定的环境中,系统可以最大化获得奖励。

-

Policy Gradient:Policy Gradient是一种基于策略梯度的强化学习算法,它可以用于学习策略。Policy Gradient的目标是找到一种策略,使得在给定的环境中,系统可以最大化获得奖励。

在这些算法中,强化学习与网络安全的结合,可以通过以下几个步骤实现:

-

定义环境:在网络安全领域,环境可以是防火墙策略、恶意软件检测策略、网络辅助攻击策略等。

-

定义状态:在网络安全领域,状态可以是网络流量、网络连接、网络设备等。

-

定义动作:在网络安全领域,动作可以是允许或拒绝网络连接、删除或保留恶意软件等。

-

定义奖励:在网络安全领域,奖励可以是正面的(例如,防火墙策略正确阻止了恶意攻击)或负面的(例如,恶意软件检测策略误报了有害软件)。

-

训练代理:通过执行动作并接收环境的反馈,训练代理以找到一种策略,使得在给定的环境中,系统可以最大化获得奖励。

3.4 数学模型公式详细讲解

在强化学习中,我们需要定义一些数学模型来描述环境、状态、动作、奖励和策略。以下是一些常用的数学模型公式:

- 状态-动作价值函数(Q-value):

Q(s,a)=E[Rt+γmaxa′Q(s′,a′)∣St=s,At=a]Q(s, a) = E[R_t + \gamma \max_{a’} Q(s’, a’) | S_t = s, A_t = a]Q(s,a)=E[Rt+γa′maxQ(s′,a′)∣St=s,At=a]

其中,Q(s,a)Q(s, a)Q(s,a) 表示在状态 sss 下执行动作 aaa 后的期望奖励。RtR_tRt 表示时间 ttt 的奖励,γ\gammaγ 表示折扣因子。

- 策略:

π(s)=argmaxaQ(s,a)\pi(s) = \arg \max_a Q(s, a)π(s)=argamaxQ(s,a)

其中,π(s)\pi(s)π(s) 表示在状态 sss 下执行的最佳动作。

- 策略梯度:

∇θJ(θ)=∑s,aπθ(s)∇aQπ(s,a)\nabla_{\theta} J(\theta) = \sum_{s, a} \pi_{\theta}(s) \nabla_{a} Q^{\pi}(s, a)∇θJ(θ)=s,a∑πθ(s)∇aQπ(s,a)

其中,J(θ)J(\theta)J(θ) 表示策略的目标函数,πθ(s)\pi_{\theta}(s)πθ(s) 表示策略 π\piπ 在状态 sss 下的概率分布,Qπ(s,a)Q^{\pi}(s, a)Qπ(s,a) 表示策略 π\piπ 在状态 sss 下执行动作 aaa 后的期望奖励。

在网络安全领域,我们可以将这些数学模型应用于优化防火墙策略、恶意软件检测策略、网络辅助攻击策略等。

4.具体代码实例和详细解释说明

在这里,我们将提供一个具体的代码实例,以说明如何将强化学习与网络安全结合起来。

import numpy as np

import tensorflow as tf

# 定义环境

class NetworkSecurityEnvironment:

def __init__(self):

# 初始化环境

def reset(self):

# 重置环境

def step(self, action):

# 执行动作并返回新的状态、奖励和是否结束

def render(self):

# 渲染环境

# 定义代理

class NetworkSecurityAgent:

def __init__(self, env):

# 初始化代理

def choose_action(self, state):

# 根据状态选择动作

def learn(self, state, action, reward, next_state, done):

# 学习

# 训练代理

env = NetworkSecurityEnvironment()

agent = NetworkSecurityAgent(env)

for episode in range(1000):

state = env.reset()

done = False

while not done:

action = agent.choose_action(state)

next_state, reward, done = env.step(action)

agent.learn(state, action, reward, next_state, done)

state = next_state

在这个代码实例中,我们定义了一个网络安全环境和一个网络安全代理。代理通过执行动作并接收环境的反馈,学习如何取得最大化的奖励。

5.未来发展趋势与挑战

在未来,强化学习与网络安全的结合将继续发展,以提高网络安全系统的性能。以下是一些未来发展趋势和挑战:

-

深度强化学习:深度强化学习将在网络安全领域得到广泛应用,以解决更复杂的网络安全问题。

-

自适应网络安全策略:通过强化学习,我们可以开发自适应网络安全策略,以便在未知的网络环境中进行有效的攻击预测和防御。

-

有限计算资源和时间:在有限的计算资源和时间内,如何实现最大化的安全性,将成为一个重要的挑战。

-

隐私保护:在网络安全领域,隐私保护是一个重要的问题。如何在保护隐私的同时,实现强化学习与网络安全的结合,将成为一个重要的挑战。

6.附录常见问题与解答

在这里,我们将提供一些常见问题与解答:

Q: 强化学习与网络安全的结合,有哪些应用场景?

A: 强化学习与网络安全的结合,可以应用于优化防火墙策略、恶意软件检测策略、网络辅助攻击策略等。

Q: 强化学习与网络安全的结合,有哪些挑战?

A: 强化学习与网络安全的结合,面临的挑战包括有限的计算资源和时间、隐私保护等。

Q: 如何评估强化学习与网络安全的结合效果?

A: 可以通过评估代理在环境中的表现,以及实际网络安全场景中的效果,来评估强化学习与网络安全的结合效果。

给大家的福利

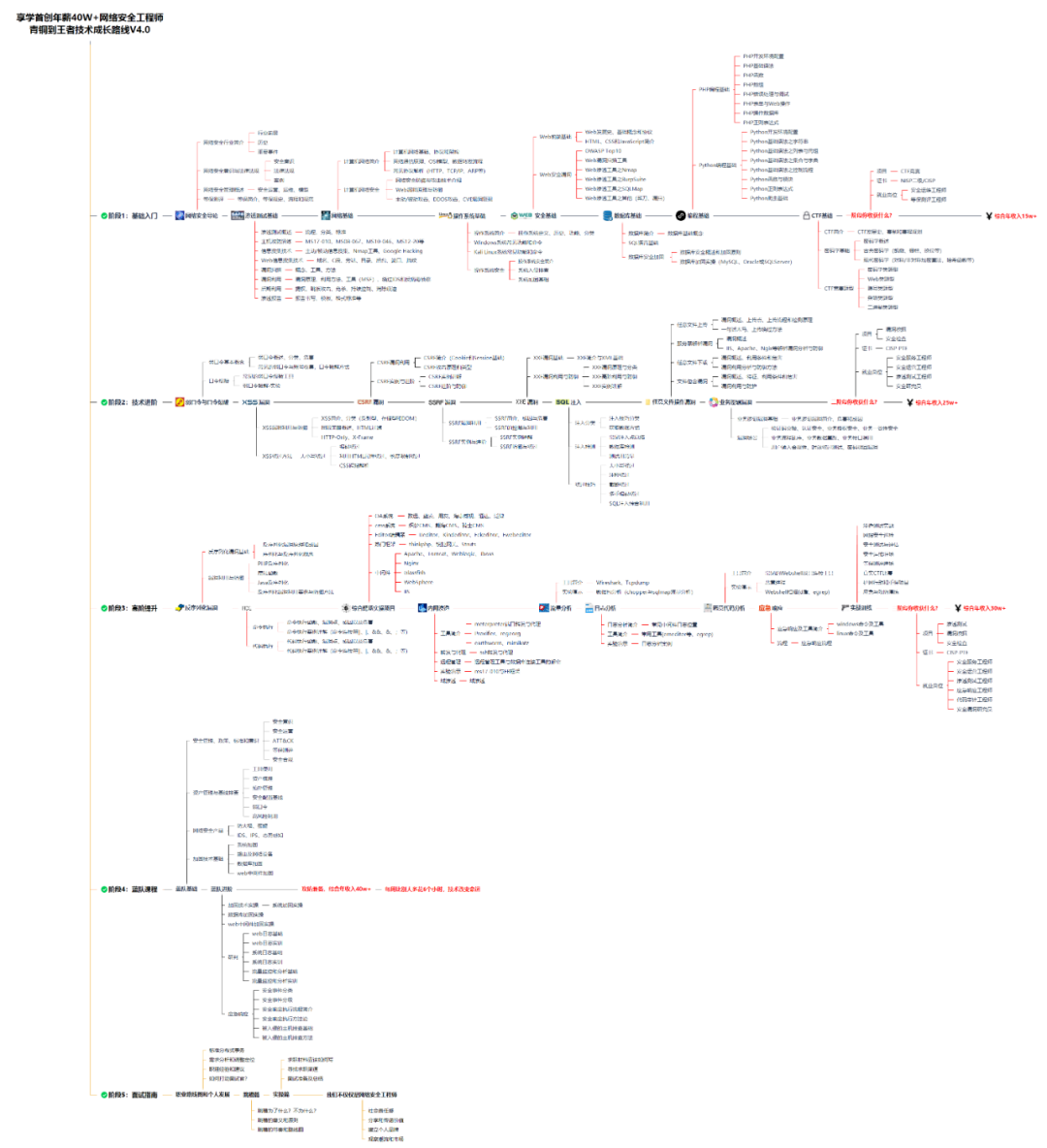

零基础入门

对于从来没有接触过网络安全的同学,我们帮你准备了详细的学习成长路线图。可以说是最科学最系统的学习路线,大家跟着这个大的方向学习准没问题。

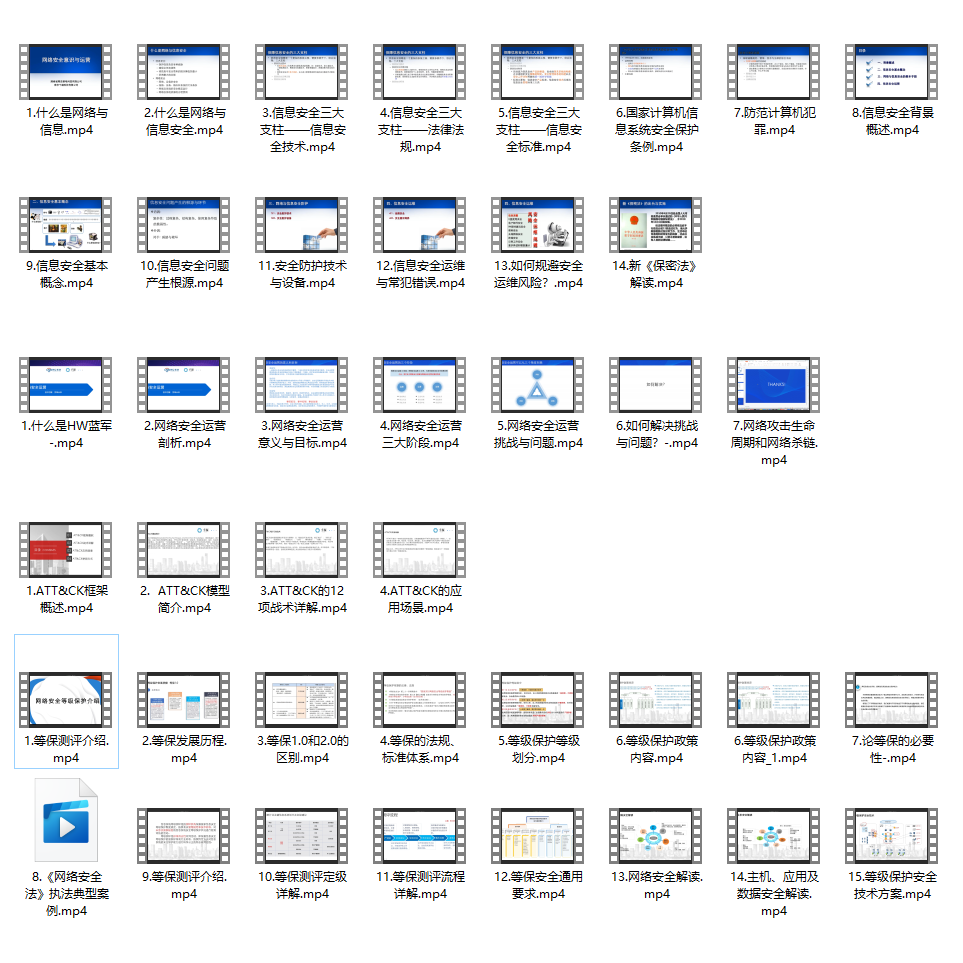

同时每个成长路线对应的板块都有配套的视频提供:

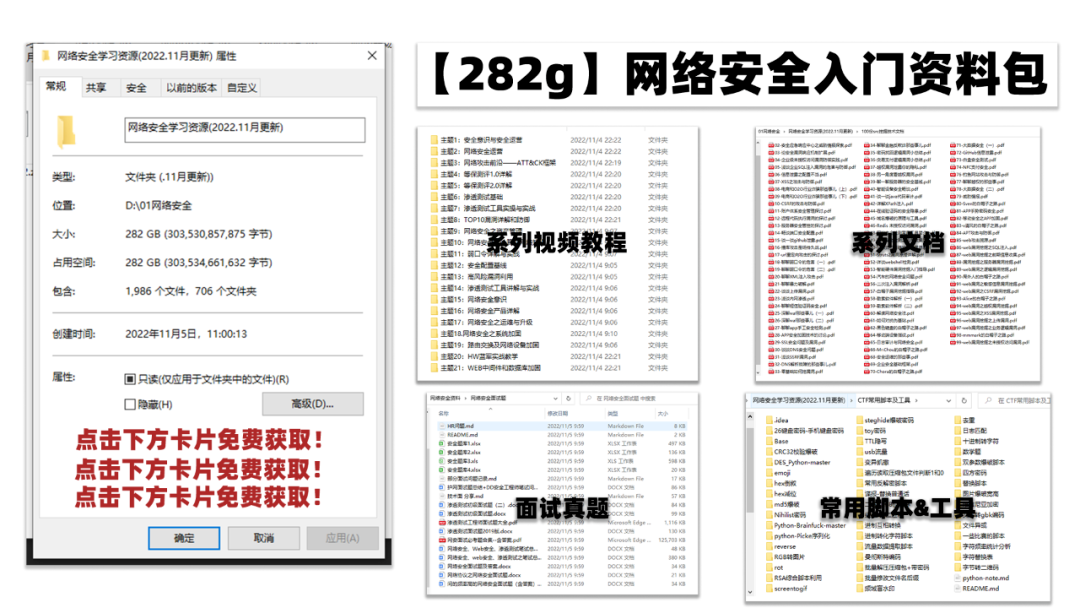

因篇幅有限,仅展示部分资料

朋友们如果有需要全套《网络安全入门+进阶学习资源包》,可以扫描下方二维码免费领取(如遇扫码问题,可以在评论区留言领取哦)~

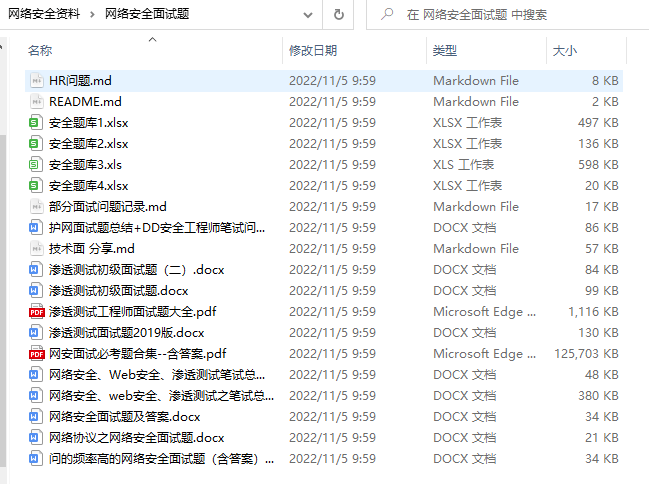

网络安全面试题

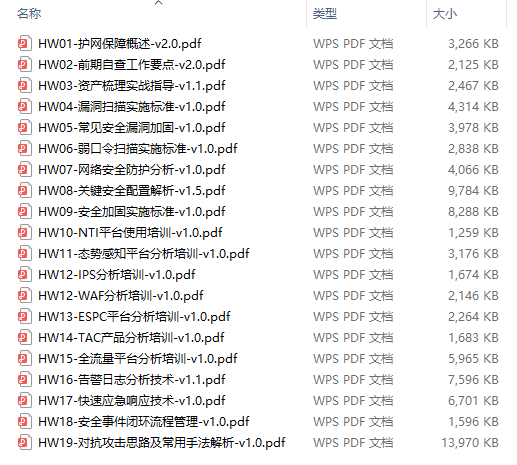

绿盟护网行动

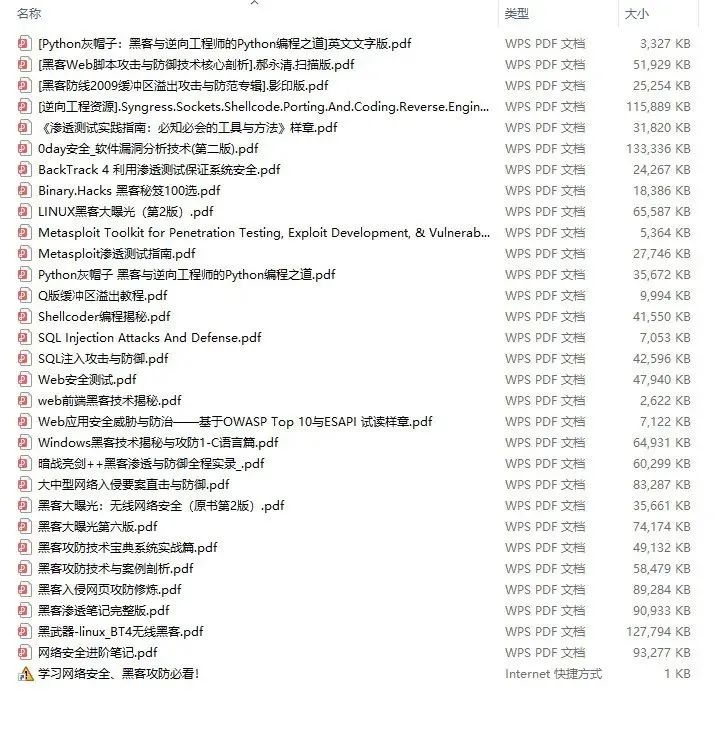

还有大家最喜欢的黑客技术

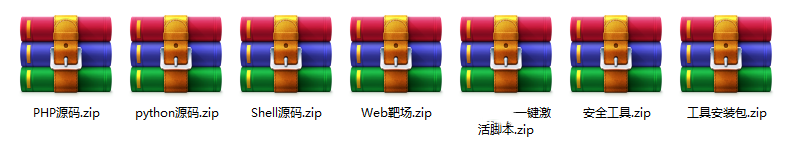

网络安全源码合集+工具包

所有资料共282G,朋友们如果有需要全套《网络安全入门+黑客进阶学习资源包》,可以扫描下方二维码免费领取(如遇扫码问题,可以在评论区留言领取哦)~

本文探讨了强化学习如何与网络安全相结合,以优化防火墙策略、恶意软件检测等,通过核心算法原理和实例阐述了如何利用Q-Learning、DQN和PolicyGradient等算法来提高网络安全系统的效率和准确性。未来趋势包括深度强化学习和自适应策略,同时面临挑战如计算资源限制和隐私保护。

本文探讨了强化学习如何与网络安全相结合,以优化防火墙策略、恶意软件检测等,通过核心算法原理和实例阐述了如何利用Q-Learning、DQN和PolicyGradient等算法来提高网络安全系统的效率和准确性。未来趋势包括深度强化学习和自适应策略,同时面临挑战如计算资源限制和隐私保护。

3551

3551

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?