本博客是除草除虫机器人相关技术介绍

本机器人的未来会进一步迭代

关于yolo和mfc详细介绍看本人后面一篇博客

没有广告啊!!!

技术分析

产品外形及描述:中间一个主体,旁边是轮子。身体上有一个向下的摄像头。

技术介绍:

1:yolo的目标检测

Yolo1的大致运行流程

预处理阶段

当输入一张图片进入网络时,首先会将图片进行卷积池化等一系列的操作。最终处理为一个7*7*30的张量。(因为此处是训练好的模型,所有结果都是较为真实的)

就像这样,每一个小网格称为一个grid cell。一共7*7=49个

每一个grid cell又会生成两个bounding box(也就是预测框)

后续就写为 bbox

接下来就是后处理操作了

实质:将7*7*30的张量变成最终的目标检测结果。

因为每一个bbox都会对框内的图像进行预测所以会生成

7*7*2*20个数字

一共有98个竖条,每个竖条含义二十个数。

这个时候会对这些数进行非极大值抑制NMS。

非极大值抑制:

非极大值抑制,首先将这98个竖条的第一行拿出来,将概率低于某一个值的数全部设为0。然后将按照概率大小从大到小排序。

然后选出概率最大的框框,和所有比较,如果IOU值大于某一个阈值时,概率小的框就会谁为0。然后选出第二高概率,操作和第一步一样。最后选出几个最好的框框。

(对非极大值抑制的理解:选出对某一物体识别效率最高的框,和一些对识别有用的框。)

最后将最有效的框框在图中标出。那么预测阶段就完成了

所以:yolo1可以帮助我们不依靠人来辨别杂草,而是通过机器来识别杂草。从而达到节省人力的目的。

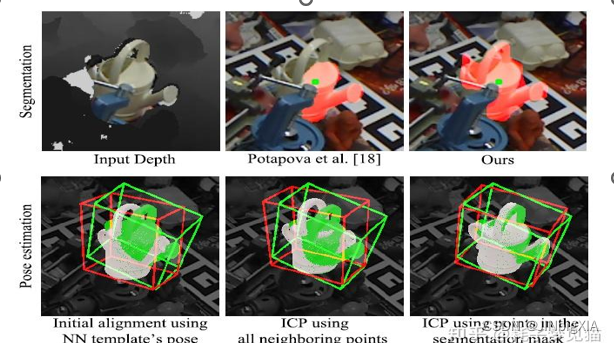

2:建立三维模型(ORK算法)来识别物体

如果后续要加上采摘的功能,就需要次技术来建立三维模型,这样就可以使用机械臂更好的采摘。

大致使用的流程为:

1创建需要识别的物体模型,建立模型数据库

2针对模型进行训练,生成识别模型模板

3使用训练后的识别模型实现物体识

3:mfc或java搭建软件控制平台

为了更好的操作和使用机器人,可以使用mfc写一个界面,来实现远程控制机器人的目的。

4:搭载北斗导航系统

在机器人上装一个定位,保证机器人的安全。

5:利用红宝石和二氧化碳激光器输出的激光除虫

一些农业害虫进行照射时,害虫纷纷死亡。 科学家们发现,不同种类的昆虫,对不同波长的激光有着不同的敏感性。 摸清了昆虫中各类害虫对激光的敏感波长,在用激光杀虫时便可以选择那些使害虫致死的激光波长,有目标地杀死真正的害虫,而不用担心在激光杀虫时杀死有益的昆虫。

机器人功能:

1:能够识别杂草,害虫,农作物,植物的是否可食用

2:通过机械臂精确抓取农作物果实,和草药

3:安装定位系统更方便得了解到机器人的具体位置。自动巡航功能

4:激光除虫

5:精确对杂草喷洒农药

6:拆卸摄像头,以备不时之需。

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?