1 前言

在之前的博客中,多次提到理想汽车以及小米汽车都在使用VLM模型,在理想汽车中VLM大模型作为慢系统去思考复杂场景下车辆的行为;而在小米汽车中主要用于识别复杂场景并进行提示,两者在使用上还是有区别的。

理想汽车:《自动驾驶---各大车企的端到端之旅》

小米汽车(内容节选官方微博):本次更新正式接入 VLM 视觉语言大模型,系统可识别复杂道路环境和特殊交通规则区域,并通过文字和语音提示。

那么本篇博客就深入介绍VLM大模型在自动驾驶上的应用,后续会继续针对车企发表的论文进行阐述。

2 VLM视觉语言大模型

本篇博客结合量产实际情况以及相关论文进行说明,不当之处,欢迎交流。其实早在2024年2月份的时候,笔者曾写了一篇关于VLM模型的博客《自动驾驶---End-to-end用于Planning行为规划》:喂给GPT-4V一张前世摄像头的图片,它会给出图片中的内容描述,并可以给出驾驶建议,但是只讲了应用,甚至认为大模型落地量产还需要一段时间。

在前一段时间,笔者已经详细描述过VLM视觉语言大模型的基本原理《大模型---一文看懂视觉语言大模型VLM》,有兴趣的读者可以浏览,可作为本篇博客的基础知识。

2.1 相关研究

随着自动驾驶技术的不断发展,提高自动驾驶系统在复杂环境中的感知、决策和交互能力成为关键挑战。传统的自动驾驶方法主要依赖于专门设计的传感器融合和机器学习算法,这些方法在面对多样化和动态变化的场景时,往往缺乏灵活性和通用性。视觉语言模型(VLM)在自然语言处理和计算机视觉领域取得了显著进展,能够处理和理解视觉和语言信息的复杂关系。将 VLM 应用于自动驾驶领域,有望为自动驾驶系统带来更强大的语义理解、场景描述和决策能力,从而提升自动驾驶的安全性和可靠性。

早期的UniAD给出的式分段式或者多模块的模型串接起来,形成一个端到端的大模型,如下图a所示,其中包括感知、预测以及规划模块。

2.2 研究目的

《VLM-AD》旨在探索如何将视觉语言模型有效地集成到自动驾驶系统中,以实现更智能、灵活和安全的驾驶决策,有一点不同的是该方案中的VLM模型仅用于监督,不在线参与实时推理。具体目标包括:

- 开发一种基于 VLM 的自动驾驶框架,能够融合视觉和语言信息,实现对驾驶场景的全面理解。

- 利用 VLM 的语义理解能力,提高自动驾驶系统对复杂交通场景的感知和决策能力,例如识别交通标志、理解道路规则和预测其他道路使用者的行为。

- 在各种真实和模拟的驾驶场景中验证基于 VLM 的自动驾驶系统的有效性和安全性。

2.3 研究方法

(1)视觉语言模型选择与改进

论文研究团队选择了在自然语言处理和计算机视觉领域表现出色的预训练视觉语言模型作为基础模型。为了适应自动驾驶的特定需求,对模型进行了一系列的改进和微调,以下三点在量产中也会作为重点方向,具体包括:

- 数据增强:使用大量的自动驾驶相关图像和视频数据对模型进行预训练,这些数据包括不同天气、光照条件下的道路场景、交通标志和车辆等。通过数据增强技术,提高模型对自动驾驶场景的适应性和泛化能力。

- 任务特定微调:针对自动驾驶任务,如目标检测、场景分类和路径规划等,对模型进行微调。通过在这些任务上的训练,使模型能够更好地理解和处理自动驾驶相关的视觉和语言信息。

- 模型压缩与优化:为了满足自动驾驶系统对实时性和计算资源的严格要求,对模型进行压缩和优化。采用剪枝、量化等技术减少模型的参数数量和计算复杂度,同时保持模型的性能。

(2)自动驾驶框架设计

VLM-AD 框架包含两个主要组成部分。第一个部分是标注分支,在这个分支中,利用视觉语言模型(VLM)来生成额外的信息,从而创建一个用作监督的补充数据集。第二个部分是设计的辅助模块,其目的是与这些额外的监督信息保持一致,并且能够在规划模块之后有效地集成到任何端到端(E2E)模型中。

利用一个视觉语言模型(VLM)作为 “教师”,生成自由形式的推理内容和结构化的动作标注信息。这些信息会被转化为监督信号,使模型能够通过辅助的文本对齐模块和动作分类模块来学习更丰富的表征。因此,该方法能够提供更优的规划结果和可解释的动作预测,并且在推理阶段不需要使用视觉语言模型(VLM)。

2.4 实验与研究成果

(1)实验验证

在多个真实和模拟的驾驶场景中对基于 VLM 的自动驾驶系统进行了实验验证。实验场景包括城市道路、高速公路、停车场等不同类型的环境,涵盖了各种复杂的交通情况,如交通拥堵、交叉路口、环岛等。

(2)研究成果(结论)

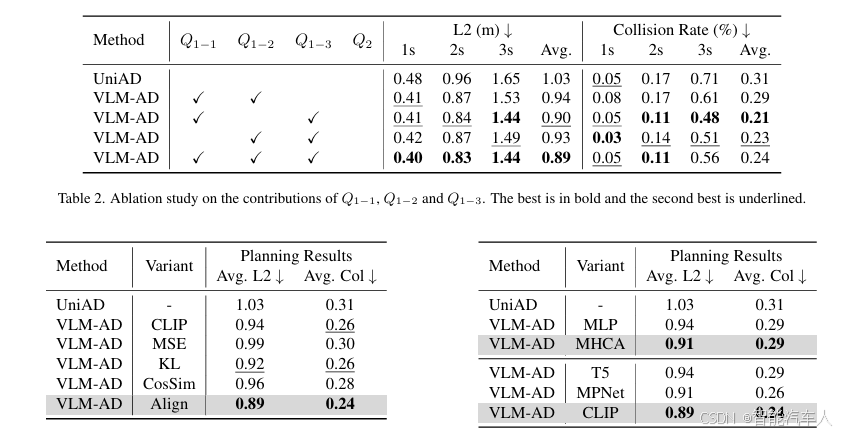

VLM-AD是一种通过利用视觉语言模型(VLM)作为辅助 “教师” 来增强端到端自动驾驶模型的新方法。通过包含非结构化推理文本和结构化动作标签的针对性问题来整合基于 VLM 的标注信息,在训练过程中加入了额外的推理和动作监督,丰富了训练内容。在 nuScenes 数据集上显著提高了规划的准确性,并降低了碰撞率,同时通过动作预测使其输出轨迹具有可解释性。重要的是,VLM-AD 在推理过程中不需要视觉语言模型(VLM),这使得它能够即插即用地应用于现实场景的部署中,而无需额外的推理成本。

2.5 局限性与未来展望

(1)局限性

- 计算资源需求:尽管对 VLM 进行了压缩和优化,但基于 VLM 的自动驾驶系统仍然对计算资源有较高的要求。在实际应用中,需要强大的计算硬件来支持模型的实时运行,这可能会增加系统的成本和复杂性。

- 数据依赖:VLM 的性能高度依赖于大量的训练数据。在自动驾驶领域,获取高质量的标注数据仍然是一个挑战,尤其是对于一些罕见的交通场景和特殊情况。此外,数据的隐私和安全问题也需要进一步解决。

- 模型可解释性:VLM 通常是一个复杂的深度学习模型,其决策过程往往难以解释。在自动驾驶领域,模型的可解释性对于保证系统的安全性和可靠性至关重要。因此,如何提高 VLM 在自动驾驶中的可解释性是一个需要进一步研究的问题。

(2)未来展望

- 轻量级模型研发:未来的研究将致力于开发更轻量级的 VLM,进一步降低模型的计算资源需求,使其能够在资源受限的硬件平台上高效运行。这可能包括探索新的模型架构、优化算法和压缩技术,以提高模型的性能和效率。

- 少样本学习与自监督学习:为了减少对大量标注数据的依赖,将研究少样本学习和自监督学习技术在自动驾驶中的应用。通过这些技术,模型可以在少量标注数据的情况下进行有效的学习,或者利用无标注数据进行自监督学习,从而提高模型的泛化能力和适应性。

- 模型可解释性研究:为了提高 VLM 在自动驾驶中的可解释性,将探索新的方法和技术,如基于注意力机制的可视化方法、因果推理和模型蒸馏等。这些方法可以帮助解释模型的决策过程,提高系统的透明度和可靠性。

- 多模态融合与协同:未来的自动驾驶系统将融合更多的传感器数据,如激光雷达、毫米波雷达和超声波传感器等,以提高对驾驶场景的感知和理解能力。将进一步研究如何将 VLM 与这些多模态传感器数据进行更有效的融合和协同,以实现更全面、准确的驾驶决策。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?