3.5.1节涉及到了KL熵的内容,故现学现卖,把搜到的信息论的知识做一整理。

参考文献:

[1] 信息论基础;周杰,汪小我;清华大学自动化系;2010.3;(ppt)

[2] 信息论初步;(来自百度百科ppt,作者未知)

一、信息的度量

1. 通信、消息、信息与信号的关系

- 【通信】的根本任务是通过【消息】的传播来传递【信息】。

- 【消息】中必定包含有【接收者】所需知道的【信息】,【消息】是【信息】的具体表现形式,而【信息】则是【消息】中所包含的抽象的、本质的内容。

- 【 通信】即【信息】的传输,利用某种能量形式的【信号的不确定性】来实现;确知【信号】往往仅用于输送能量本身。

2. 各种概念之间的关系

- 信息 是消息的内核;

- 信号 是信息的载体;

- 数据 是记录信息的一种形式;

- 情报 是一类专门的信息—— 一个子集;

- 知识 是由信息加工出来的产物,是具有普遍和概括性质的高层次信息—— 一个子集;

3. 信息如何刻画(度量)

- 物质的量——质量。信息的量——信息量?

- 所有事物有一个最普遍的特征:组织程度—结构化—有序性。那么关于信息,是否能找到一个有序性的衡量?

- 找到一个无序性的度量或混乱程度的度量。.

4. 信号的信息量

- 连续信号的信息量:信息量与连续信号的【不确定变化】有关

如上图所示信号,若确知规律,则不包含任何信息;

如上图所示信号,局部“偶然地”变化,这种变化事先不确知,因而包含信息。

不确知的变化越大、越频繁,则信息量越大。

- 离散信号的信息量:信息量与离散信号的【概率】有关

在我国南方,六月冰雹是十分罕见的气象。如果气象台预测明日无冰雹,天气预报一般不会发布这条消息,因为这种情况是司空见惯的;如果天气预报说“明日有冰雹”,则这条消息含有极大的信息量,因为这种情况太少见了。

对于离散信号,信息量与消息的出现概率有关,概率越小,信息量越大。

结论:综上所述,无论对连续信号还是离散信号,信息量大小都取决于消息的不确定程度。

5. 信源

- 直观:消息的来源。

- 确切:信源是产生消息(符号)、消息序列、连续消息的来源。

在通信系统中,收信者在未收到信息以前,对信源发出什么样的消息是不确定的,是随机的,所以可以用【随机变量、随机矢量或随机过程】来描述信源输出的消息,或者说用一个【样本空间及其概率测度】来描述信源。在实际通信中最常见的信源有话音、文字、图像、数据等。

6. 信源分类

-

离散信源:可用离散型R.V.来表示,信源常记作:X={x1,x2,...}

数学模型

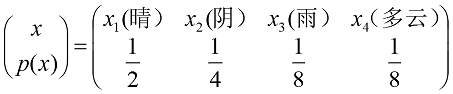

举例:天气预报

-

连续信源:可用连续型R.V.来表示。

数学模型:

举例:每次只输出一个消息,但消息的可能数目是无穷多个。例:电压、温度等。

7. 离散信源的信息度量

- 信息的线性叠加原理:信息具有相加性,组合消息的信息量应为其中每个独立消息信息量的线性叠加。

例:在仅由0,1组成的长序列中,8位长序列10110011,信息量为I8;4位长序列1011,信息量为I4。设各位出现0、1的概率相同,则I8 =2·I4。

证明:设8位序列出现10110011的概率为p8,4位序列出现1011的概率为p4,则:

- 自信息量定义: 一个随机事件发生某一结果后所带来的信息量称为自信息量,简称自信息。

例:设某地二月份天气有四种情况,其构成的信源模型如下,求各相应消息(事件)的自信息。

解:

- 注释:I(xi)的两个含义:

①当事件发生前,表示该事件【发生的不确定性】;②当事件发生后,表示该事件【提供的信息量】;

- 性质:

① 非负性:随机事件发生的概率为p(a),则p(a)∈[0,1],㏒p(a)为负值,由对数性质可知,若㏒ p(a)为负值,则-㏒p(a)恒为非负值.

② 当p(a)=1时,I(a)=0:P(a)=1说明该事件是必然事件,不含有任何不确定性,所以不含有任何信息量。③ 当p(a)=0时,I(a) =∞:P(x)=0说明该事件是不可能事件。不可能事件一旦发生,带来的信息量非常大。称信息爆炸。④ 严格单调性:I(a)是p(a)的单调递减函数⑤ 可加性:如两个独立信源符号一起出现P(a,b)=p(a)p(b)

I(a,b)=I(a)+ I(b)

注:a是一个随机变量,I(a)是a的函数,也是一个随机变量。

- 合理性:用I作为信息量是合理的,它实际反映了信息量与消息出现概率的【反递增关系(消息出现的概率越大,信息量越少)】,又反映了【线性叠加原理】。

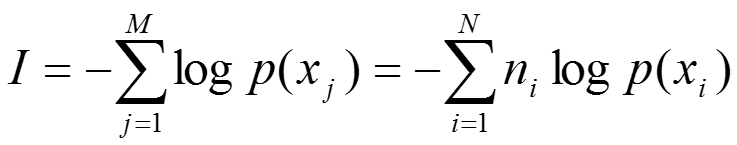

- 组合消息出现时的信息量

根据信息的线性叠加原理有:

其中M——组合信息由M个单个符号组成

N——离散信源的符号种数

ni——离散信源出现第i种符号的次数

P(xi)—离散信源出现第i种符号的概率

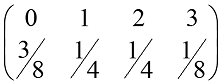

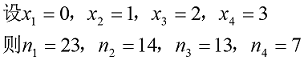

例:离散信源有0、1、2、3四种符号,其概率场如下:

求消息201020130213001203210100321010023102002010312032100120210的信息量。解:消息总长为57个符号。

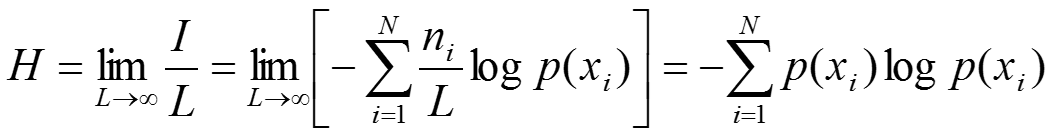

8. 离散信源的平均信息量——熵

- 定义

其中L—信源消息的长度

另一种定义:

例:离散信源有0、1、2、3四种符号,其概率场如下:

求消息201020130213001203210100321010023102002010312032100120210的平均信息量(熵)。

解:

- 绝对熵

由离散信源熵公式变化:

绝对熵是【单位时间】【连续信源】的平均信息量。

由于连续信源的符号种类无穷多,所以绝对熵无穷大。既然连续信源的绝对熵都是无穷大,那么如何比较两个连续信源的信息产生能力呢?

事实上,在计算熵变化或比较不同信源的熵时,由于-logdx项始终出现而相互抵消,故定义更有实用意义的【相对熵】

- 相对熵

实用中都用相对熵来衡量连续信源的信息产生能力。

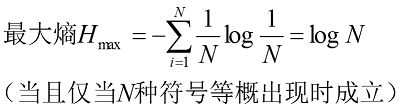

- 最大熵

连续信源的最大熵条件取决于【信源输出取值所受限制】,分为以下两种:

①均方值受限

②峰值受限

结论:

均方值受限情况下的最大熵条件是信源输出值满足均值为0、方差为σ2的正态分布;

峰值受限情况下的最大熵条件是信源输出值满足分布区间上的均匀分布。

对于特定信源,当其输出满足最大熵条件时,输出信息效率最大,即一定时间内的输出消息含有最大信息量,因而最大熵条件也被称为最佳分布。为了使信源输出的信息效率尽可能大,信源编码时往往要对连续信源的概率密度进行变换以求得最佳分布。

2285

2285

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?