自信息

自信息I(ai)是描述随机事件出现的不确定性大小,随机事件发生的概率越大,出现的不确定性越小,所蕴含的信息越少,不确定性的消除等于获得的信息

所以函数I(ai) = f [P(ai)]应满足以下条件:

1.I(ai)应是概率P(ai)的单调递减函数,即:当P(a1)> P(a2)时有I(a1) < I(a2);

2.当P(ai)=1时I(ai)=0;

3.当P(ai)=0时I(ai)→∞;

4.若两个统计独立的随机事件,即:P(ai aj)=P(ai)P(aj),则I(ai aj)=I(ai)+I(aj)

r在信息论中一般取2

当ai发生以前,I(ai)表示ai发生的不确定性

当ai发生以后,I(ai)表示ai所提供的信息量

联合自信息

联合事件集合XY中的事件,x=a y=b的自信息定义为I(a,b)=-logPXY(a,b),简记为I(xy)=-logP(xy)

条件自信息

事件a=x在事件b=y给定条件下的自信息定义为I(a|b)=-logPX|Y(a|b),简记为I(x|y)=-logP(x|y)

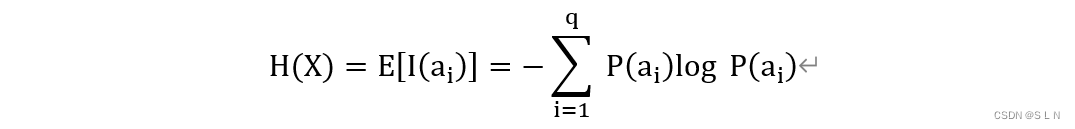

信息熵

信源输出各消息的自信息量I(ai)的数学期望为信源的平均自信息量,称为信源X的信息熵或熵,q是事件数量,信息熵对于给定信源X是固定的,描述信源的平均不确定性,也是平均每个事件的信息量。

联合熵

联合集XY上,联合自信息的平均值定义为联合熵

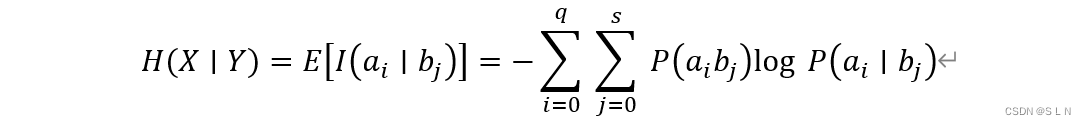

条件熵

联合集XY上,条件自信息的平均值定义为条件熵

一些性质:

H(XY)=H(X)+H(Y|X)= H(Y)+H(X|Y)

当所有事件概率相等为1/q时,信源的熵最大是logq

H(Y|X)≤H(X),当X与Y相互独立时等号成立

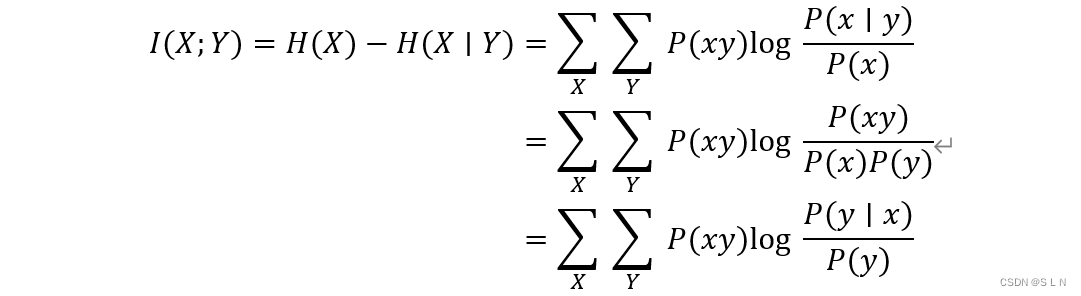

平均互信息

是平均从Y获得的关于X的信息量

I(X;Y)=H(X)-H(X|Y)

接收到的信息量=X的不确定-在收到Y的情况下对X的不确定

平均互信息可以表示X和Y之间的关联性强弱,为0的时候X和Y统计独立,也就是满足p(x,y) = p(x)p(y);协方差也可以表示X和Y的关系,协方差为0,是X和Y不相关,也就是没有线性关系,满足E[XY]=E[X]E[Y]

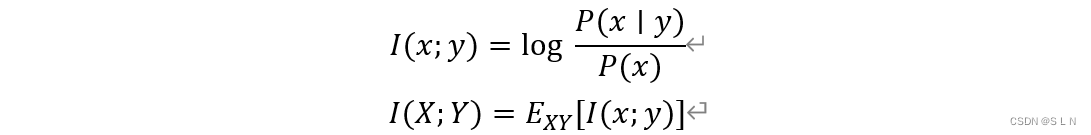

互信息

I(x;y)表示由随机事件y中获得的关于事件x的信息。

1602

1602

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?