1、为什么添加正则项(L1、L2)会防止过拟合?

- 学习问题实际上是求解目标函数最优参数,而加正则项实际上是给待求参数(向量)增加一个约束,然后把约束罚到目标函数上去,实际上就是求解带有不等式约束的最优化问题。当给参数增加约束后,模型复杂度降低,从而可以防止模型过拟合。

2、添加L1正则项为什么会使得解(参数向量)具有稀疏性(很多参数为0)?

-

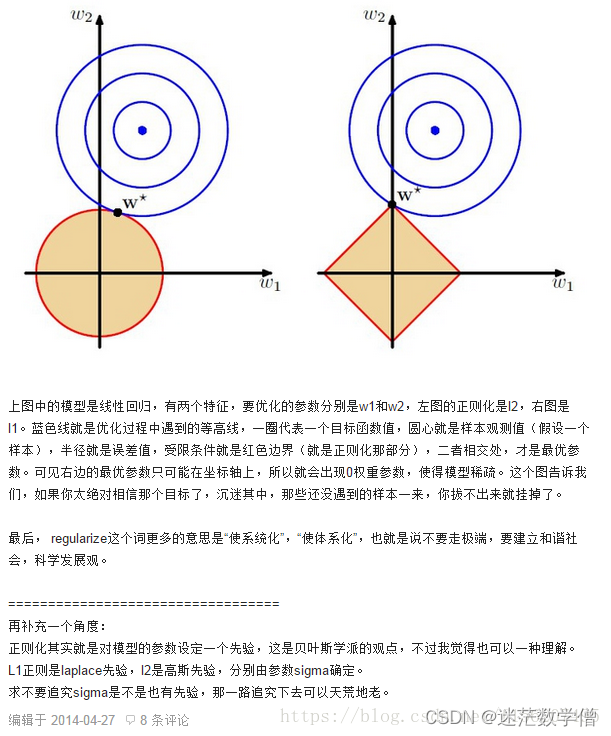

从解空间的形状来看:

对于二维(w1, w2)的情况,假定原始目标函数(没有添加正则项)的解空间位R2平面。添加正则项后给参数空间(w1, w2)添加了约束,使得可行域减小。对于L1正则项,添加后使得解空间为一个菱形区域,此时目标函数的最优(小)值更可能在顶点处取到(不是说一定在顶点处取到,只是在顶点处取到的可能性更大;当原始目标函数的等值线图与边相切时,也可能在边上取到,只是可能性较小),比如(0,1)。此时w1=0,参数解更加稀疏,从而起到降维和特征选择的作用。 -

从贝叶斯最大后验估计来看:

加入L1正则项相当于在做贝叶斯最大后验概率估计时加入了参数(向量)的先验概率分布,使得参数满足位置参数为0的拉普拉斯分布。观察拉普拉斯分布的概率密度函数可知,参数取得0的可能性更大,从而使得解向量的分量很多取到0值,从而具有稀疏性。

3、添加L2正则项使得解更加平滑

- 从解空间形状来看:

添加L2正则项后目标函数的最优值最可能在相切处取到(特殊情况下也能在坐标轴上取到,只是可能性小)此时参数都能取得很小值,当约束边界到原点的距离为1时,参数为接近1的很小值

- 从贝叶斯最大后验估计来看:

加L2正则项相当于在做贝叶斯最大后验概率估计时加入了参数的先验分布,使得参数满足0均值的正太分布。从正太分布的概率密度图可知其参数解分布更平滑。

4、使用L2正则项来压缩权值

在神经网络中,很小的权值就意味着输入数据的改变并不会对网络有很大的影响,这样的网络也会很难受到局部噪音的影响。相反,较大的权值则会对很小的变化有较敏感的改变。因此,非正则化的网络会通过较大的权值去学习更复杂的模型(相对较小的权值来说),从而考虑了训练数据中的噪音成分。而正则化网络因其更小的权值,避免训练数据中噪音的影响,专注于数据现象的学习从而有更好的推广能力。

1200

1200

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?