图像分类与基础视觉模型

学习内容:

本次学习,正课部分由王若晖老师进行讲解,最后的答疑部分由张子豪(B站 同济子豪兄)进行课后答疑讲解。课程链接放在这里的,有需要的可以直接点击,或者打开哔哩哔哩OpenMMLab主页查看。https://www.bilibili.com/video/BV1js4y1W7CN/?spm_id_from=333.337.search-card.all.click

1. 图像分类基础知识

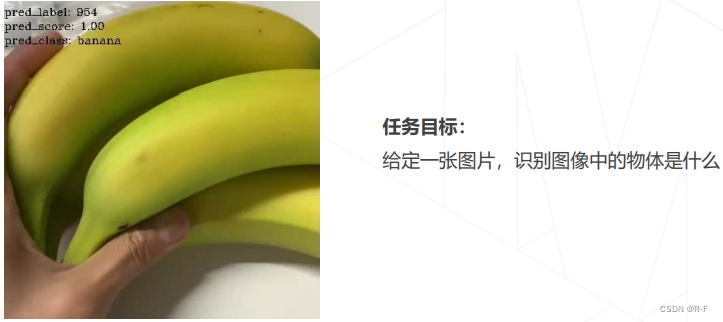

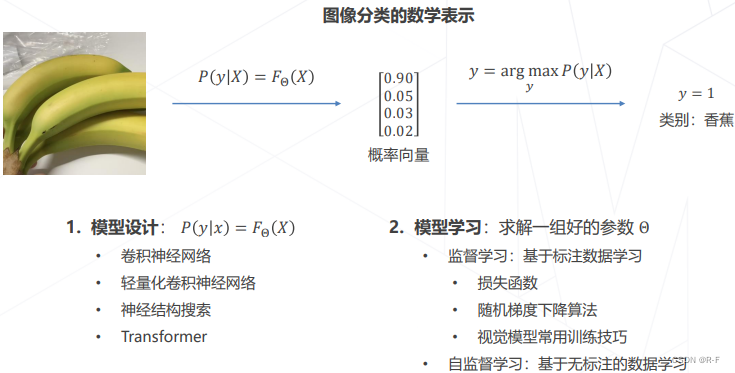

了解了,什么是图像分类。如下图所示:

并且如何用数学进行 表示这个问题

知道了视觉任务的难点是,图像的内容是像素整体呈现出的结果,和个别像素的值没有直接关联,难以遵循具体的规则设计算法。并且讲解了图像处理由传统方法进阶到深度学习的过程,并且详细的讲解了历年再ImageNet图像识别挑战赛中的优秀算法。其中跨时代的是AlexNet的诞生(2012年)也标志着深度学习时代的开始。

2. 卷积神经网络

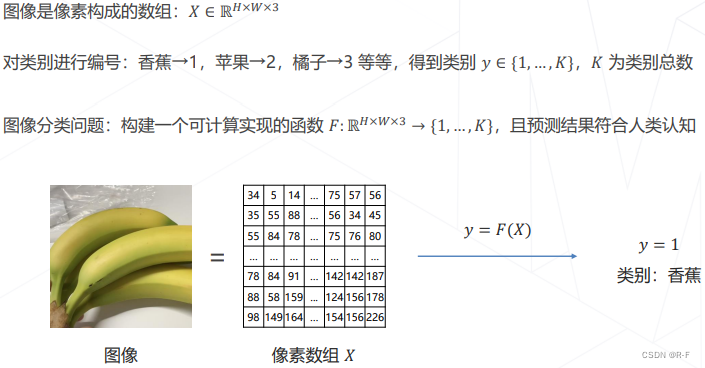

说到深度学习,就不得不提卷积神经网络。上面我们提到的AlexNet(2012),他就是利用卷积神经网络,模型如下

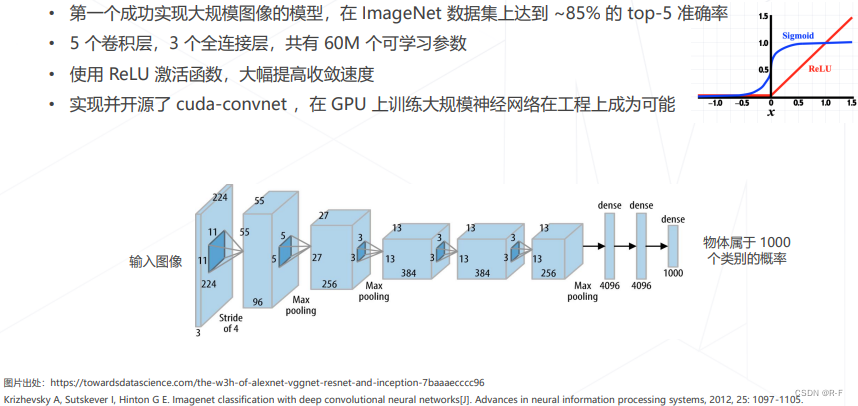

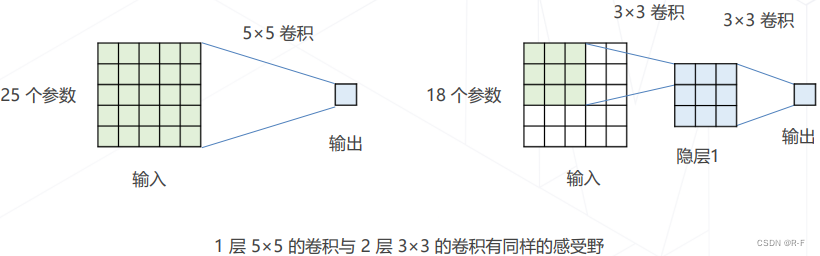

之后还有Going Deeper(2012~2014)增加卷积的层数以获取更高的精度;VGG(2014)将大尺寸的卷积拆解为多层3*3的卷积,相同的感受野、更少的参数量、更多的层数和表达能力。

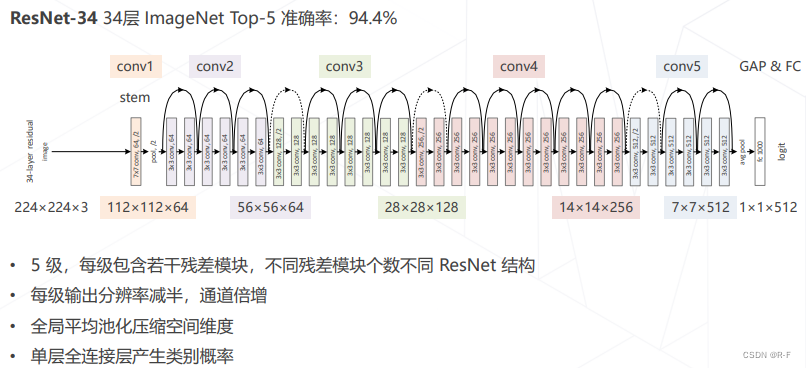

虽然在一定范围内增加模型层数可以增加分类正确率,但是在模型层数达到一定层数后,分类正确率不增反降。我们对其猜想:虽然深层网络有潜力达到更高的精度,但常规的优化算法难以找到这个更优的模型即,让新增加的卷积层拟合一个近似恒等映射,恰好可以让浅层网络变好一点。这个时候就引入了残差网络模型。

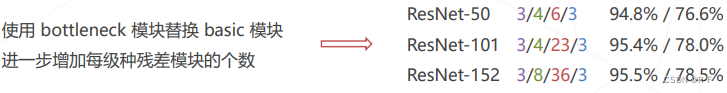

为了减少计算量,残差模块也有不同的方式

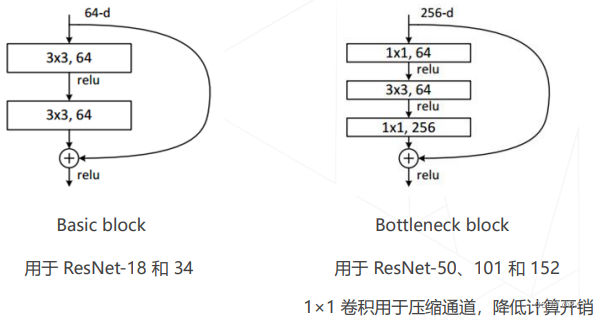

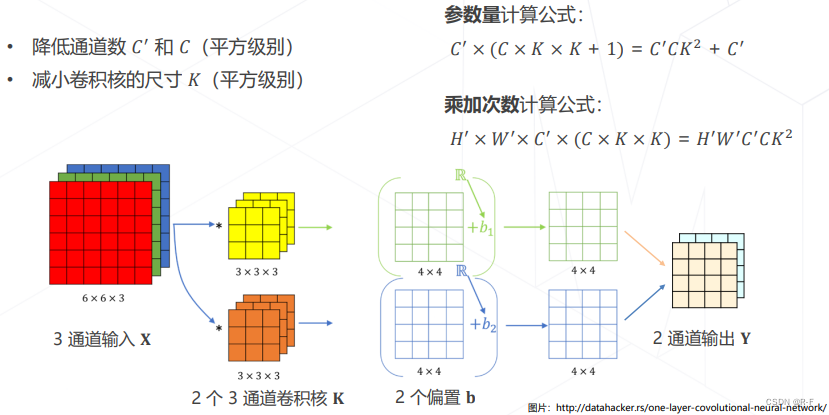

后续课程讲到的都是一些降低模型参数两和计算量的方法

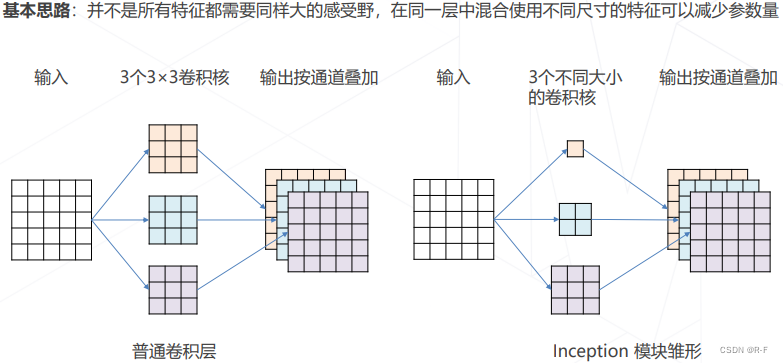

如GoogLeNet 使用不同大小的卷积核,来进行减少运算开销

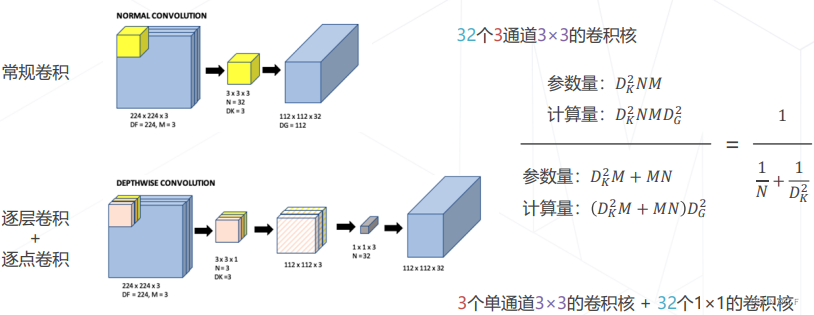

在这之后,还提出了一种减少运行算开销的方式,叫做可分离卷积,即将常规卷积分为逐层卷积和逐点卷积,降低参数量和计算量

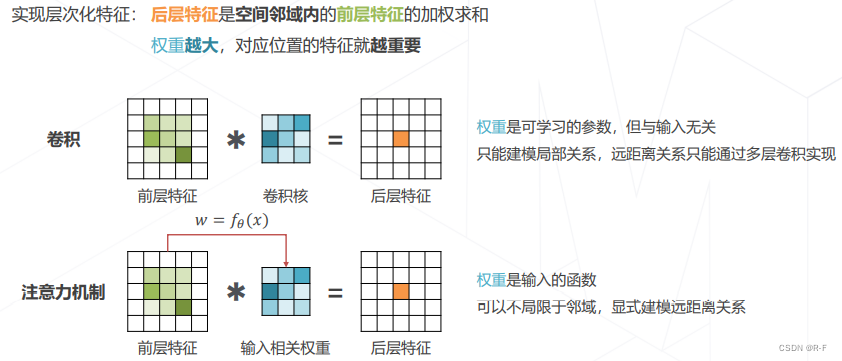

后面介绍了上面是注意力机制–Attention Mechanism,简单来说,就是卷积核并不是一直不变的,而是根据你输入的图片进行调整,从而抓取更重要的信息,这刚开始是运用于语言学方面的。

3.模型学习

讲解了监督学习,并且介绍了其工作是基于损失函数进行评判的。后面还引入了一些最优化算法如随机梯度下降呀什么的,进行优化(寻找初始参数和权重呀什么的),在模型不变的情况下,提高分类精确率。后面还提了自监督学习。总结如下

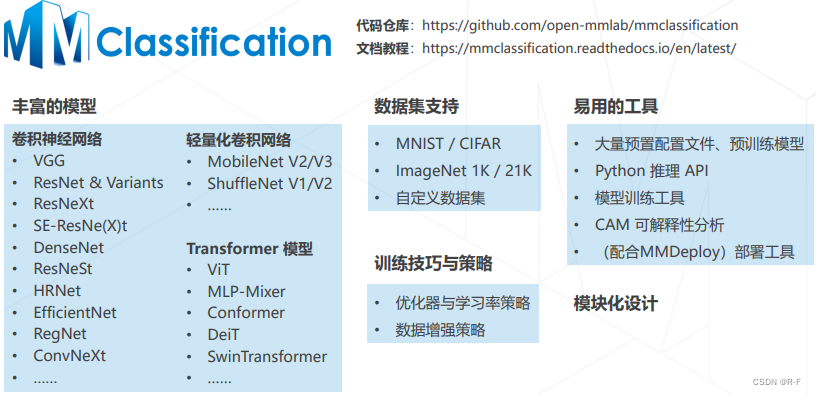

MMClassification:

简单介绍了图像分类工具包MMClassification

以及如何安装配置相关环境和利用python推理API。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?