1 logistic回归与sigmoid函数

考虑如下线性函数:

y=wwTxx+b(1)

输出 y 为连续的实值,如何让输出成为二值来完成二分类任务?即

y=⎧⎩⎨⎪⎪0,z<00.5,z=01,z>0(2)

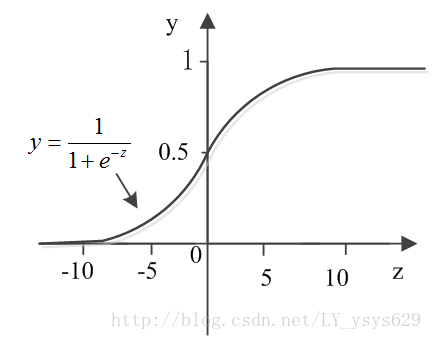

但是,单位阶跃函数不连续,不利于求解权值,构建模型。于是sigmoid函数(对数几率函数,logistic function)出现了,他单调可微,并且形似阶跃函数,其公式描述如下所示:

y=11+e−(wwTxx+b)(3)

sigmoid曲线如下图所示:

令 y 表示当输入为

logy1−y=wwTxx+b(4)

2 二项逻辑斯蒂回归模型与参数估计

由式(3)可得二项逻辑斯蒂回归模型如下所示:

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1915

1915

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?