文章目录

< 数据预处理 >

- 聚集:多个样本或特征进行合并(减少样本规模、转换标度、更稳定)

- 抽样:抽取一部分样本

- 降维:在地位空间中表示样本(PCA、SVD)

- 特征选择:选取重要特征(Lasso)

- 特征创建:重新构建有用特征(Fouter转换)

- 离散化

- 将连续属性转换为离散属性的过程

- 常用于分类

- 二元化

- 将连续或类别属性映射到一个或多个二值变量

- 关联分析

- 将连续属性转换为类别属性,将类别属性转换为一组二值变量

- 变量变换

- 将给定属性的值转换

- 线性变换方法(简单函数)

- 规范化

- 最小-最大规范化(归一化)

- z-score规范化(零均值规范化)

- 小数定标规范化

< sklearn 机器学习平台 >

MLlib学习库:

- 涵盖算法:分类算法、聚类算法、回归算法、降维算法

- Scikit-learn 主要用法:

- 符号标记:训练数据、训练集标签、测试数据、测试集标签、完整数据、标签数据

- 数据划分:

- train_test_split(x,y,random)

- shuffle = True

- 数据预处理

- 监督学习算法(分类、

- 逻辑回归

- 支持向量机

- 朴素贝叶斯

第3章 回归分析

3.1 回归分析的基本概念

- 回归分析

- 按涉及变量个数划分:一元回归、多元回归分析

- 按照因变量的多少划分:简单回归分析、多重回归分析

- 按照自变量和因变量之间的关系类型划分:线性回归分析、非线性回归分析。

- 回归分析解决的问题:

- 变量间的相关关系:确定性关系、非确定性关系

- 预测或控制(一个或多个)变量的值

- 回归分析的步骤

- 确定变量:相关影响因素(自变量),主要的影响因素

- 建立预测模型:自变量和因变量的历史统计资料计算

- 进行相关分析:变量和预测对象的相关程度

- 计算预测误差:是否可用于实际预测

- 确定预测值:对预测值进行综合分析

3.2 一元线性回归

F检验、T检验

- Y = a + bX + ε

- 模型特点:

- Y是X的线性函数加上误差项

- 线性部分反映了由于X的变化引起的Y的变化

- 误差选个ε是随机变量

- 对于一个给定的X值,Y的期望值为E(Y)= a+bX

- 回归方程:

- 回归方程求解及模型检验:

- 最小二乘法(方程求解),残差平方和

- 拟合优度检验(模型检验)

- 线性关系的显著性检验:显著性水平检验回归方程(回归参数的显著性检验),ESS,RSS

- 一元线性回归实例

- 评价标准r2

3.3 多元线性回归

- Y = a + b1X1 + b2X2 + … + bnXn

- 模型特点:

- Y与X1X2X3…X4具有线性关系

- 各个观测值Yi(i=1,2,3,…)之间相互独立

- 随机误差ε~N(0,q2)

- 最小二乘法求解多项式回归方程

- 拟合优度检验

- 回归参数的显著性检验

- 多元线性回归实例

3.4 多项式回归

- 多项式回归方程(非线性→线性)

- 多项式回归方程实例

- 多项式回归方程求解

- 回归方程F检验

- 多项式回归方程t检验

回归的评价标准

- 均方误差(MSE)

- 均方根误差(RMSE)

- 平均绝对误差(MAE)

- 选择MSE还是MAR?

第3-1章 正则化回归预测算法

3.1 岭回归

机器学习算法 - 岭回归算法:机器学习算法系列(四)- 岭回归算法(Ridge Regression Algorithm)

1. 欠拟合和过拟合问题

- 欠拟合问题:原因是特征维度过少

- 增加特征维度解决

- 过拟合问题:特征维度过多

- 解决过拟合的方法:

- 正则化:算法中为防止数据过拟合采取的“惩罚”措施

- L1正则化(L1范数)和L2正则化(L2范数)

- 减少变量的数量

- 正则化:算法中为防止数据过拟合采取的“惩罚”措施

< 岭回归 >

- 例岭回归是一种改良的最小二乘法(最小二乘法+L2正则项)

- 会损失模型的精度和无偏性

- 解决病态回归问题

1. 参数推导(调参)

2. λ的选择

- 岭迹法

- 交叉验证法

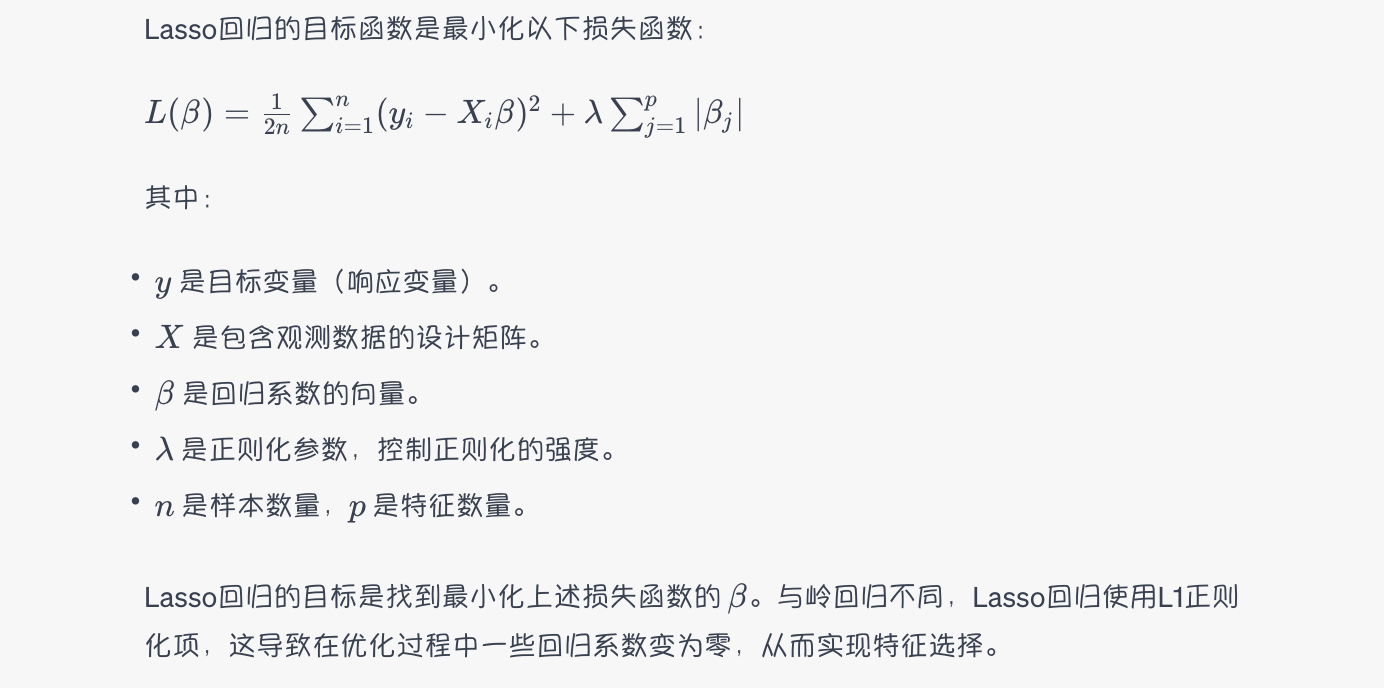

3.2 Lasso回归

机器学习算法 - Lasso回归算法:机器学习算法系列(五)- Lasso回归算法(Lasso Regression Algorithm)

- 最小二乘法 + L1正则项

Lasso回归(套索回归)

- Lasso回归(Least Absolute Shrinkage and Selection Operator Regression)

- 是一种线性回归的正则化方法,类似于岭回归,但使用L1正则化项而不是L2正则化项。

- Lasso回归在处理特征选择和模型稀疏性时特别有用。

Lasso回归的优点和用途:

- 特征选择:

- Lasso回归有助于自动选择最重要的特征,将不重要的特征的系数稀疏化至零。这在高维数据集中非常有用,可以减少模型的复杂性,提高模型的解释性。

- 稀疏性: Lasso回归鼓励模型参数变得稀疏,即许多参数变为零,这有助于简化模型并降低过拟合的风险。

- 解释性: 与复杂模型相比,Lasso回归模型更容易解释。(可以找出哪些特征对目标变量的影响最大,哪些特征对目标变量没有影响)

- 处理多重共线性: 类似于岭回归,Lasso回归也可以用来处理多重共线性问题。

Lasso回归的求解方法:

- Lasso回归通常使用迭代算法,例如坐标下降法或梯度下降法来找到最小化损失函数的回归系数。

- 在实际应用中,您可以通过交叉验证来选择适当的正则化参数 (\lambda) 值,以获得最佳的模型性能。

- 总之,Lasso回归是一种有用的线性回归正则化技术,特别适用于特征选择和处理高维数据。通过调整正则化参数,您可以控制模型的复杂性,并在实际应用中获得良好的回归模型。

Lasso回归数学表达:

1. 参数推导

2. λ的选择

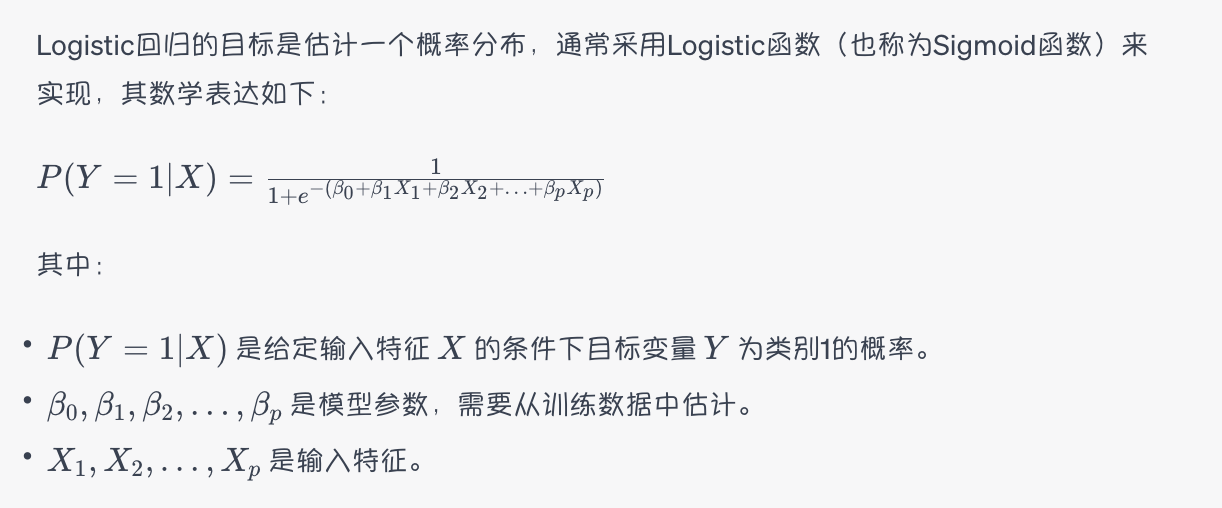

3.3 Logistics回归

- 通常来计算“一个事件成功或者失败”的概率

- 卷积+池化+分类

- Logistic回归,也称为Logit回归,是一种用于解决二分类问题的统计学和机器学习方法。

- 尽管名字中包含"回归"一词,但Logistic回归实际上是一种分类算法,用于估计数据属于某一类别的概率。

Logistic回归的应用场景:

- 二分类问题: Logistic回归通常用于解决二分类问题,其中目标变量可以分为两个类别,如是/否、合格/不合格、患病/健康等。

- 概率估计: Logistic回归可以估计每个类别的概率,而不仅仅是预测类别标签。这对于需要考虑不确定性的任务非常有用,例如广告点击率预测。

- 特征工程: Logistic回归可以用于特征选择和特征工程,帮助识别哪些特征对分类问题最为重要。

- 评估风险: 在金融领域,Logistic回归可以用于评估客户违约的风险,或者在医学领域,用于预测疾病的发病风险。

Logistic回归的数学表达:

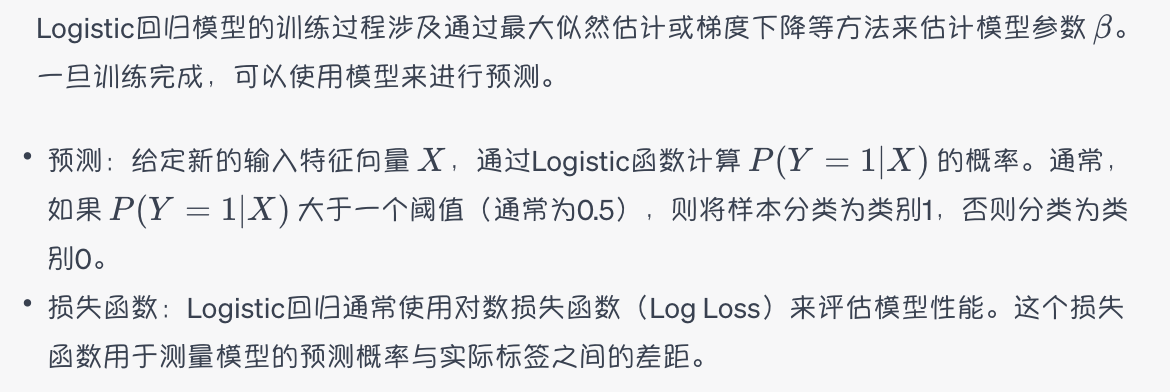

Logistic回归的训练和预测:

总之,Logistic回归是一个常用的分类算法,特别适用于二分类问题。它的输出可以理解为一个概率值,可以用于决策制定和风险评估。此外,Logistic回归的模型参数可解释性较强,有助于理解特征对分类的影响。

LR基础知识

伯努利分布

逻辑函数

线性回归模型

LR原理

LR损失函数

模型训练的基本方法——迭代法

3.4 支持向量回归(SVR)

分类:基本概念与技术

4.1 分类的基本概念

- 分类任务示例

- 分类的定义:测试集、训练集、预测测试集

- 建立分类模型的一般方法

- 第一步:建立模型

- 步骤一:将样本转化为等维的数据特征

- 步骤二:选择与类别相关的特征

- 步骤三:分别得到训练样本集和测试样本集

- 第二步:用模型进行分类

- 第一步:建立模型

4.2 模型过拟合

- 模型过拟合的原因

- 训练数据少

- 模型复杂度高:多重比较过程的影响

4.3 分类模型评估

- 分类模型的评价指标:1234⑤精度⑥召回率

4.4 分类技术

- 基分类器:决策树、基于规则的方法、最近邻、神经网络、深度学习、贝叶斯网络、支持向量机、softmax

- 组合分类器:Boosting、Bagging、随机森林

4.4.1 决策树

- Hunt算法

- 表示属性测试条件的方法

- 基于连续属性的样本划分

- 问题1:如何确定最佳划分

- 不纯性测量:熵

- 连续属性:计算基尼指数

- 增益率:克服信息增益的缺点

4.4.2 最近邻分类器

- 最近邻分类器

- 最近邻分类器的特点、不足

- 提高KNN计算效率

- 减少距离计算次数

- 压缩

- 删除

4.4.4 朴素贝叶斯分类器

- 贝叶斯分类概述

- 朴素贝叶斯分类器算法原理(三个知识点)

- 贝叶斯公式:先验概率 + 条件概率 = 后验概率

- 朴素贝叶斯分类器算法原理

- 朴素贝叶斯分类的工作过程

- 计算类别下特征属性的条件概率(关键)

- 朴素贝叶斯建模流程

- 确定特征属性

- 获取训练样本

- 对每个类别计算P(yi)

- 对每个特征属性计算所有划分的条件概率

- 对每个类别计算P(x|yi)P(yi)

- 以P(x|yi)P(yi)最大项作为x所属类别

其他

- 优化问题

- Lagrangian函数

- 线性不可分问题

- 特征空间中的变换

- 核函数

- 选择核函数

- 使用SVM的步骤

- SVM小结

- 优点:

- 有效处理非线性分类问题

- 不足

- 优点:

3176

3176

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?