全局表

如果你的业务中有些数据类似于数据字典,比如配置文件的配置,常用业务的配置或者数据量不大很少变动的表,这些表往往不是特别大,而且大部分的业务场景都会用到,那么这种表适合于 Mycat 全局表,无须对数据进行切分,只要在所有的分片上保存一份数据即可,Mycat 在 Join 操作中,业务表与全局表进行 Join 聚合会优先选择相同分片内的全局表 join,避免跨库 Join,在进行数据插入操作时,mycat 将把数据分发到全局表对应的所有分片执行,在进行数据读取时候将会随机获取一个节点读取数据

server.xml

<system>

<!-- 1为开启全局表一致性检测、0为关闭 -->

<property name="useGlobleTableCheck">1</property>

</system>

schema.xml

<!--user 是mycat的逻辑库,t_user是逻辑表-->

<schema name="user" checkSQLschema="false" sqlMaxLimit="100">

<table name="t_user" primaryKey="id" dataNode="dn1,dn2,dn3" autoIncrement="true" rule="mod-long" />

<!--t_role是全局表-->

<table name="t_role" primaryKey="id" dataNode="dn1,dn2,dn3" autoIncrement="true" type="global" rule="mod-long" />

</schema>

insert into t_role (id,role) VALUES (next value for MYCATSEQ_GLOBAL,‘admin’)

执行插入语句发现所有库的t_role表都增加了一条数据

ER分片表

有一类业务,例如订单(order)跟订单明细(order_detail),明细表会依赖于订单,也就是说会存在表的主从关系,这类似业务的切分可以抽象出合适的切分规则,比如根据用户 ID 切分,其他相关的表都依赖于用户 ID,再或者根据订单 ID 切分,总之部分业务总会可以抽象出父子关系的表。这类表适用于 ER 分片表,子表的记录与所关联的父表记录存放在同一个数据分片上,避免数据 Join 跨库操作

server.xml

<table name="t_order" primaryKey="id" dataNode="dn1,dn2,dn3" rule="mod-long" >

<childTable name="t_order_item" primaryKey="id" joinKey="order_id" parentKey="id" >

</childTable>

</table>

表结构

先执行插入订单

insert into t_order (id,name) VALUES (next value for MYCATSEQ_GLOBAL,‘order1’) #id此时生成的是10012再执行插入订单item

insert into t_order_item (id,order_id,name) VALUES (next value for MYCATSEQ_GLOBAL,10012,‘order1-item1’)

insert into t_order_item (id,order_id,name) VALUES (next value for MYCATSEQ_GLOBAL,10012,‘order1-item2’)

会发现订单和订单item在同一个库,可以加快join

share join

如果不做任何join处理的话,mycat不支持跨库关联查询,我们可以使用sharejoin支持这点,但是sharejoin只支持两张分片表的join

/*!mycat:catlet=io.mycat.catlets.ShareJoin*/select u.id as user_id,u.name as username,a.id as add_id,a.province from t_user u, t_address a where u.id = a.user_id;

schema.xml

schema.xml

t_address的rule是province_rule这个不用管,这个我下面会按照省份去分片

<!--user 是mycat的逻辑库,t_user是逻辑表-->

<schema name="user" checkSQLschema="false" sqlMaxLimit="100">

<table name="t_user" primaryKey="id" dataNode="dn1,dn2,dn3" autoIncrement="true" rule="mod-long" />

<table name="t_address" primaryKey="id" dataNode="dn1,dn2,dn3" autoIncrement="true" rule="province_rule" />

</schema>

按照省份分片

表是t_address,结构上面图片有

partition-hash-int.txt

partition-hash-int.txt

bj=0

sh=1

gz=2

rule.xml

<tableRule name="province_rule">

<rule>

<columns>name</columns>

<algorithm>hash-int</algorithm>

</rule>

</tableRule>

<function name="hash-int" class="io.mycat.route.function.PartitionByFileMap">

<property name="mapFile">partition-hash-int.txt</property>

<!--0表示partition-hash-int.txt配置的=的左边是Integer,非0表示是string-->

<property name="type">1</property>

<!--默认节点设置为bj,也就是说如果你insert的省份不是bj,sh,gz之一,默认插入到bj库(user1)-->

<property name="defaultNode">0</property>

</function>

schema.xml

<table name="t_address" primaryKey="id" dataNode="dn1,dn2,dn3" autoIncrement="true" rule="province_rule" />

执行sql测试:

insert into t_address (id,province,user_id) VALUES (next value for MYCATSEQ_GLOBAL,'bj',1)

insert into t_address (id,province,user_id) VALUES (next value for MYCATSEQ_GLOBAL,'sh',1)

insert into t_address (id,province,user_id) VALUES (next value for MYCATSEQ_GLOBAL,'gz',1)

insert into t_address (id,province,user_id) VALUES (next value for MYCATSEQ_GLOBAL,'bsj',1)

结果符合预期

固定分片hash

本条规则类似于十进制的求模运算,区别在于是二进制的操作,是取 id 的二进制低 10 位,即 id 二进制&1111111111。此算法的优点在于如果按照 10 进制取模运算,在连续插入 1-10 时候 1-10 会被分到 1-10 个分片,增大了插入的事务控制难度,而此算法根据二进制则可能会分到连续的分片,减少插入事务事务控制难度。

我们先创建一张表用来测试固定分区hash

注意注解里sql不要写select啊,因为如果开启了读写分离的话,那么走的就是从库,那么每次建表都是建到从库里,主库没有

/*!mycat:sql=update t_user set name = 'dsds' */create table fixed_hash(id int,name varchar(32));

rule.xml

<tableRule name="partition-by-fixed-hash">

<rule>

<columns>id</columns>

<algorithm>partition-by-fixed-hash</algorithm>

</rule>

</tableRule>

<function name="partition-by-fixed-hash" class="io.mycat.route.function.PartitionByLong">

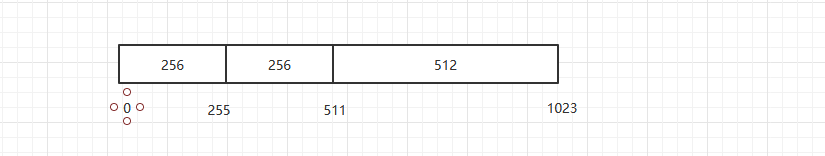

<property name="partitionCount">2,1</property>

<property name="partitionLength">256,512</property>

</function>

如图:mycat最支持最大分区1024:本例即0-255落到dn1,256-511落到dn2,512-1023落到dn3

schema.xml

<table name="fixed_hash" primaryKey="id" dataNode="dn1,dn2,dn3" autoIncrement="true" rule="partition-by-fixed-hash" />

执行insert测试:

insert into fixed_hash (id,name) VALUES (1,database())

insert into fixed_hash (id,name) VALUES (next value for MYCATSEQ_GLOBAL,database())

insert into fixed_hash (id,name) VALUES (next value for MYCATSEQ_GLOBAL,database())

结果如下:

1&(0b1111111111) = 1,落在dn1

1&(0b1111111111) = 1,落在dn1

10026&(0b1111111111)=810,落在dn3

一致性hash

一致性 hash 有效解决了分布式数据的扩容问题。

rule.xml

<tableRule name="sharding-by-murmur">

<rule>

<columns>id</columns>

<algorithm>murmur</algorithm>

</rule>

</tableRule>

<function name="murmur"

class="io.mycat.route.function.PartitionByMurmurHash">

<property name="seed">0</property><!-- 默认是0 -->

<property name="count">3</property><!-- 要分片的数据库节点数量,必须指定,否则没法分片 -->

<property name="virtualBucketTimes">160</property><!-- 一个实际的数据库节点被映射为这么多虚拟节点,默认是160倍,也就是虚拟节点数是物理节点数的160倍 -->

<!-- <property name="weightMapFile">weightMapFile</property> 节点的权重,没有指定权重的节点默认是1。以properties文件的格式填写,以从0开始到count-1的整数值也就是节点索引为key,以节点权重值为值。所有权重值必须是正整数,否则以1代替 -->

<!-- <property name="bucketMapPath">/etc/mycat/bucketMapPath</property>

用于测试时观察各物理节点与虚拟节点的分布情况,如果指定了这个属性,会把虚拟节点的murmur hash值与物理节点的映射按行输出到这个文件,没有默认值,如果不指定,就不会输出任何东西 -->

</function>

shcemea.xml

<table name="t_murmur" primaryKey="id" dataNode="dn1,dn2,dn3" autoIncrement="true" rule="sharding-by-murmur" />

完整schema.xml

<?xml version="1.0"?>

<!DOCTYPE mycat:schema SYSTEM "schema.dtd">

<mycat:schema xmlns:mycat="http://io.mycat/">

<!--user 是mycat的逻辑库,t_user是逻辑表-->

<schema name="user" checkSQLschema="false" sqlMaxLimit="100">

<table name="t_user" primaryKey="id" dataNode="dn1,dn2,dn3" autoIncrement="true" rule="mod-long" />

<table name="t_role" primaryKey="id" dataNode="dn1,dn2,dn3" autoIncrement="true" type="global" rule="mod-long" />

<table name="t_order" primaryKey="id" dataNode="dn1,dn2,dn3" rule="mod-long" >

<childTable name="t_order_item" primaryKey="id" joinKey="order_id" parentKey="id" >

</childTable>

</table>

<table name="t_address" primaryKey="id" dataNode="dn1,dn2,dn3" autoIncrement="true" rule="province_rule" />

<table name="fixed_hash" primaryKey="id" dataNode="dn1,dn2,dn3" autoIncrement="true" rule="partition-by-fixed-hash" />

<table name="t_murmur" primaryKey="id" dataNode="dn1,dn2,dn3" autoIncrement="true" rule="sharding-by-murmur" />

</schema>

<dataNode name="dn1" dataHost="localhost1" database="user1" />

<dataNode name="dn2" dataHost="localhost1" database="user2" />

<dataNode name="dn3" dataHost="localhost1" database="user3" />

<dataHost name="localhost1"

maxCon="1000"

minCon="10"

balance="1"

writeType="0"

dbType="mysql"

dbDriver="native"

switchType="1"

slaveThreshold="100">

<heartbeat>select user()</heartbeat>

<writeHost host="hostMadmin" url="192.168.131.101:3306" user="root" password="root">

<readHost host="hostSadmin" url="192.168.131.102:3306" user="root" password="root" />

</writeHost>

</dataHost>

</mycat:schema>

完整server.xml

<?xml version="1.0" encoding="UTF-8"?>

<!-- - - Licensed under the Apache License, Version 2.0 (the "License");

- you may not use this file except in compliance with the License. - You

may obtain a copy of the License at - - http://www.apache.org/licenses/LICENSE-2.0

- - Unless required by applicable law or agreed to in writing, software -

distributed under the License is distributed on an "AS IS" BASIS, - WITHOUT

WARRANTIES OR CONDITIONS OF ANY KIND, either express or implied. - See the

License for the specific language governing permissions and - limitations

under the License. -->

<!DOCTYPE mycat:server SYSTEM "server.dtd">

<mycat:server xmlns:mycat="http://io.mycat/">

<system>

<property name="nonePasswordLogin">0</property> <!-- 0为需要密码登陆、1为不需要密码登陆 ,默认为0,设置为1则需要指定默认账户-->

<property name="useHandshakeV10">1</property>

<property name="useSqlStat">0</property> <!-- 1为开启实时统计、0为关闭 -->

<property name="useGlobleTableCheck">1</property> <!-- 1为开启全局表一致性检测、0为关闭 -->

<property name="sequnceHandlerType">0</property>

<property name="subqueryRelationshipCheck">false</property> <!-- 子查询中存在关联查询的情况下,检查关联字段中是否有分片字段 .默认 false -->

<!-- <property name="useCompression">1</property>--> <!--1为开启mysql压缩协议-->

<!-- <property name="fakeMySQLVersion">5.6.20</property>--> <!--设置模拟的MySQL版本号-->

<!-- <property name="processorBufferChunk">40960</property> -->

<!--

<property name="processors">1</property>

<property name="processorExecutor">32</property>

-->

<!--默认为type 0: DirectByteBufferPool | type 1 ByteBufferArena | type 2 NettyBufferPool -->

<property name="processorBufferPoolType">0</property>

<!--默认是65535 64K 用于sql解析时最大文本长度 -->

<!--<property name="maxStringLiteralLength">65535</property>-->

<!--<property name="sequnceHandlerType">0</property>-->

<!--<property name="backSocketNoDelay">1</property>-->

<!--<property name="frontSocketNoDelay">1</property>-->

<!--<property name="processorExecutor">16</property>-->

<!--

<property name="serverPort">8066</property> <property name="managerPort">9066</property>

<property name="idleTimeout">300000</property> <property name="bindIp">0.0.0.0</property>

<property name="frontWriteQueueSize">4096</property> <property name="processors">32</property> -->

<!--分布式事务开关,0为不过滤分布式事务,1为过滤分布式事务(如果分布式事务内只涉及全局表,则不过滤),2为不过滤分布式事务,但是记录分布式事务日志-->

<property name="handleDistributedTransactions">0</property>

<!--

off heap for merge/order/group/limit 1开启 0关闭

-->

<property name="useOffHeapForMerge">1</property>

<!--

单位为m

-->

<property name="memoryPageSize">64k</property>

<!--

单位为k

-->

<property name="spillsFileBufferSize">1k</property>

<property name="useStreamOutput">0</property>

<!--

单位为m

-->

<property name="systemReserveMemorySize">384m</property>

<!--是否采用zookeeper协调切换 -->

<property name="useZKSwitch">false</property>

<!-- XA Recovery Log日志路径 -->

<!--<property name="XARecoveryLogBaseDir">./</property>-->

<!-- XA Recovery Log日志名称 -->

<!--<property name="XARecoveryLogBaseName">tmlog</property>-->

<!--如果为 true的话 严格遵守隔离级别,不会在仅仅只有select语句的时候在事务中切换连接-->

<property name="strictTxIsolation">false</property>

<property name="useZKSwitch">true</property>

</system>

<!-- 全局SQL防火墙设置 -->

<!--白名单可以使用通配符%或着*-->

<!--例如<host host="127.0.0.*" user="root"/>-->

<!--例如<host host="127.0.*" user="root"/>-->

<!--例如<host host="127.*" user="root"/>-->

<!--例如<host host="1*7.*" user="root"/>-->

<!--这些配置情况下对于127.0.0.1都能以root账户登录-->

<!--

<firewall>

<whitehost>

<host host="1*7.0.0.*" user="root"/>

</whitehost>

<blacklist check="false">

</blacklist>

</firewall>

-->

<user name="root" defaultAccount="true">

<property name="password">root</property>

<property name="schemas">user</property>

<!-- 表级 DML 权限设置 -->

<!--

<privileges check="false">

<schema name="TESTDB" dml="0110" >

<table name="tb01" dml="0000"></table>

<table name="tb02" dml="1111"></table>

</schema>

</privileges>

-->

</user>

<user name="user">

<property name="password">user</property>

<property name="schemas">user</property>

<property name="readOnly">true</property>

</user>

</mycat:server>

6360

6360

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?