如果你也喜欢C#开发或者.NET开发,可以关注我,我会一直更新相关内容,并且会是超级详细的教程,只要你有耐心,基本上不会有什么问题,如果有不懂的,也可以私信我加我联系方式,我将毫无保留的将我的经验和技术分享给你,不为其他,只为有更多的人进度代码的世界,而进入代码的世界,最快捷和最容易的就是C#.NET,准备好了,就随我加入代码的世界吧!

一、算法简介

梯度下降算法是一种常用的优化算法,用于求解目标函数的最小值。它的基本思想是通过不断迭代调整参数的值,以使目标函数的值趋于最小。

具体来说,梯度下降算法是通过计算目标函数在当前参数值处的梯度(即偏导数),并根据梯度的方向和大小来更新参数的值。更新的过程可以通过以下公式表示:

θ = θ - α * ∇J(θ)

其中,θ表示参数的值,α表示学习率(即每次参数更新的步长),∇J(θ)表示目标函数在当前参数值处的梯度。

梯度下降算法有两种常见的变体:批量梯度下降(Batch Gradient Descent)和随机梯度下降(Stochastic Gradient Descent)。

批量梯度下降算法在每次迭代时,计算所有样本的梯度,然后更新参数的值。这种方法的优点是可以保证每次迭代都能朝着最优方向前进,但缺点是计算速度比较慢,特别是在大规模数据集上。

随机梯度下降算法在每次迭代时,只计算一个样本的梯度,并更新参数的值。这种方法的优点是计算速度快,尤其适用于大规模数据集,但缺点是由于只使用一个样本的梯度,所以每次迭代的方向不一定是最优的。

梯度下降算法的选择与目标函数的具体形式和数据集的大小有关。一般来说,如果目标函数是凸函数且数据集较小,可以使用批量梯度下降算法;如果目标函数是非凸函数或数据集较大,可以使用随机梯度下降算法。同时,还可以使用一种折中的方法,称为小批量梯度下降(Mini-batch Gradient Descent),在每次迭代时计算一部分样本的梯度来更新参数的值。

二、为什么要学习梯度下降算法

2.1 提高模型性能

通过梯度下降算法,可以优化模型的参数,从而提高模型的性能,使其能够更好地拟合训练数据并在未知数据上取得更好的预测性能。

2.2 加快模型训练速度

梯度下降算法可以快速找到使目标函数最小化的参数值,从而加快模型的训练速度。

2.3 理解优化算法原理

学习梯度下降算法可以帮助理解机器学习中的优化原理,掌握优化算法的基本原理和步骤。

2.4 掌握机器学习基础知识

梯度下降算法是机器学习中最基础的算法之一,学习梯度下降算法可以帮助掌握机器学习的基础知识,并为进一步学习更复杂的优化算法奠定基础。

三、 梯度下降算法在项目中有哪些实际应用

3.1 机器学习中的模型训练

梯度下降算法是训练各种机器学习模型的主要方法之一。它通过最小化目标函数(例如损失函数)的梯度来更新模型的参数,以使模型能够更好地拟合训练数据。

3.2 神经网络训练

梯度下降算法在神经网络中的应用非常广泛。通过计算损失函数相对于每个参数的梯度,并根据梯度的方向和大小来更新网络参数,可以实现神经网络的训练。

3.3 特征选择

在特征选择中,梯度下降算法可以用来评估特征的重要性。通过计算特征对目标变量的梯度,并选择梯度绝对值较大的特征,可以找到对预测结果影响较大的特征。

3.4 优化问题求解

梯度下降算法可以用来求解各种优化问题,例如最小化某个目标函数的问题。通过计算目标函数的梯度,并根据梯度的方向和大小来更新优化变量,可以逐步接近最优解。

3.5 图像处理

梯度下降算法可以用于图像处理中的边缘检测、图像增强等任务。通过计算图像的梯度,并根据梯度的方向和大小来提取边缘或改变图像的亮度、对比度等。

3.6 自然语言处理

在自然语言处理中,梯度下降算法可以用于词向量的训练、文本分类、情感分析等任务。通过最小化损失函数的梯度来更新模型的参数,可以使模型更好地理解和处理文本数据。

四、 梯度下降算法的实现与讲解

4.1 梯度下降算法的实现

算法实现

public static void Main(string[] args)

{

// 定义训练数据集

double[] X = { 1, 2, 3, 4, 5 };

double[] Y = { 2, 4, 6, 8, 10 };

// 初始化模型参数

double theta0 = 0; // 截距

double theta1 = 0; // 斜率

// 定义学习率和迭代次数

double learningRate = 0.01;

int numIterations = 1000;

// 执行梯度下降算法

for (int i = 0; i < numIterations; i++)

{

double sum1 = 0; // 梯度1的累加和

double sum2 = 0; // 梯度2的累加和

// 计算每个样本的梯度的累加和

for (int j = 0; j < X.Length; j++)

{

double prediction = theta0 + theta1 * X[j]; // 根据当前参数计算预测值

double error = prediction - Y[j]; // 计算预测值与真实值的误差

sum1 += error; // 计算梯度1的累加和

sum2 += error * X[j]; // 计算梯度2的累加和

}

double gradient1 = (2.0 / X.Length) * sum1; // 计算梯度1

double gradient2 = (2.0 / X.Length) * sum2; // 计算梯度2

// 更新参数

theta0 -= learningRate * gradient1;

theta1 -= learningRate * gradient2;

}

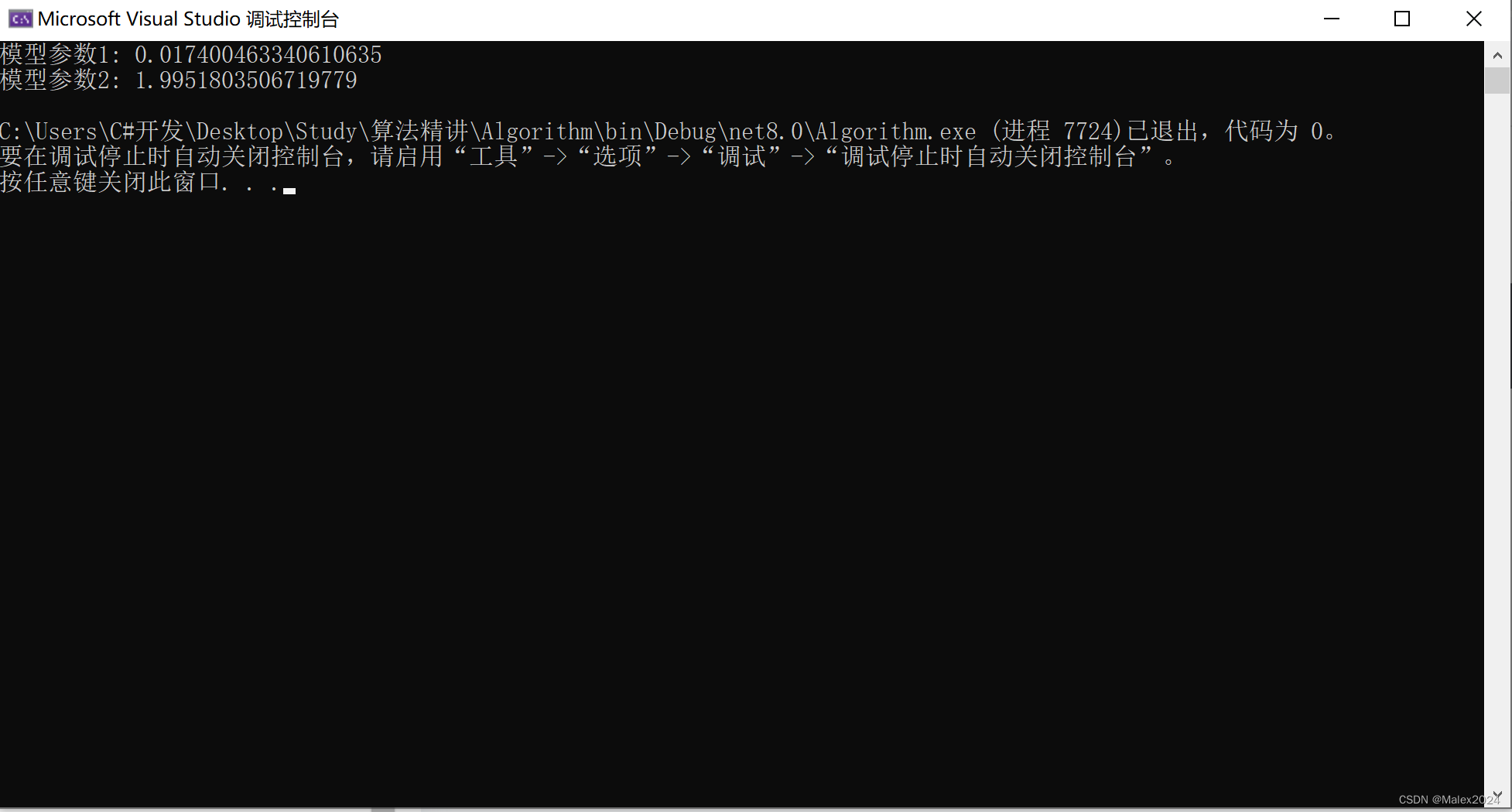

// 打印最终的模型参数

Console.WriteLine("模型参数1: " + theta0);

Console.WriteLine("模型参数2: " + theta1);

}输出结果

4.2 梯度下降算法的讲解

-

首先,定义了训练数据集X和Y,其中X是自变量,Y是因变量。根据这些数据,我们将使用梯度下降算法来拟合一个线性回归模型,以预测Y与X之间的关系。

-

初始化模型参数theta0和theta1,它们分别表示线性回归模型的截距和斜率。在开始训练之前,我们将它们都设置为0。

-

然后,定义了学习率learningRate和迭代次数numIterations。学习率是一个常数,决定了每次参数更新的步长。迭代次数表示梯度下降算法要执行的循环次数。

-

在梯度下降算法的迭代过程中,我们使用两个变量sum1和sum2来存储梯度的累加和。这两个变量将在每次迭代时重置为0,然后在每个样本的误差计算中累加梯度。

-

在每次迭代中,我们使用两个嵌套循环来遍历训练数据集中的每个样本。在内部循环中,我们首先根据当前的参数值计算预测值prediction。然后,计算预测值与真实值的误差error。这个误差用于计算梯度的累加和,sum1和sum2。

-

在内部循环完成后,我们根据sum1和sum2的累加和计算出平均梯度。这是通过将累加和除以样本数,并乘以一个常数(2.0 / X.Length)来实现的。

-

最后,我们使用学习率乘以平均梯度来更新模型参数theta0和theta1。这个更新步骤使用了梯度下降算法的核心思想,即每次迭代中向负梯度的方向移动一小步。

-

在迭代完指定次数后,我们打印出最终的模型参数theta0和theta1。这些参数是拟合训练数据集的线性回归模型的截距和斜率。它们可以用来预测新的X值对应的Y值。

五、 梯度下降算法需要注意的地方

5.1 学习率选择

学习率决定了每一次迭代中参数更新的幅度,过大的学习率会导致震荡和发散,而过小的学习率会导致收敛速度过慢。需要通过实验或调参的方式选择适当的学习率。

5.2 参数初始化

梯度下降算法对参数的初始值非常敏感,不同的初始值可能导致不同的结果。因此,需要通过实验或调参的方式选择适当的参数初始值。

5.3 收敛判断

梯度下降算法迭代的终止条件通常是目标函数值的变化小于某个阈值或达到最大迭代次数。需要注意选择合适的收敛判断条件,以便在合理的时间内得到收敛的结果。

5.4 特征缩放

当特征之间的尺度相差很大时,梯度下降算法可能会受到影响。可以通过特征缩放的方式将特征的尺度统一,以提高梯度下降算法的效果。

5.5 局部最优解

梯度下降算法可能会陷入局部最优解而无法达到全局最优解。为了避免这种情况,可以通过使用不同的初始值、调整学习率或使用其他优化算法来提高算法的效果。

687

687

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?