💥💥💞💞欢迎来到Matlab仿真科研站博客之家💞💞💥💥

✅博主简介:热爱科研的Matlab仿真开发者,修心和技术同步精进,Matlab项目合作可私信。

🍎个人主页:Matlab仿真科研站博客之家

🏆代码获取方式:

💥扫描文章底部QQ二维码💥

⛳️座右铭:行百里者,半于九十;路漫漫其修远兮,吾将上下而求索。

⛄更多Matlab路径规划(仿真科研站版)仿真内容点击👇

Matlab路径规划(仿真科研站版)

⛄一、多无人机协同作业简介

0 引言

多架无人机组成无人机集群可以协同完成任务,是未来无人机的发展方向。组成无人机集群的多架无人机通过机间链路互相通信实现协作,可以迅速准确地执行路径规划、协同侦察、协同感知和协同攻击等复杂任务。

为实现无人机集群协作的诱人前景,国内外都积极开展了相关研究工作。美国方面,美国国防预先研究计划局(DARPA)于2015年推出“小精灵”项目,计划研制具备自组织和智能协同能力的无人机蜂群系统。美国防部战略能力办公室(SCO)2014年启动了“无人机蜂群”项目,旨在通过有人机空射“灰山鹑”微型无人机蜂群执行低空态势感知和干扰任务。美国海军研究局(ONR)于2015年公布了“低成本无人机蜂群”(LOCUST)项目,研发可快速连续发射的无人机蜂群,无人机之间利用近距离射频网络共享态势信息,协同执行掩护、攻击或防御任务。2017年,在 DARPA 会议中心举办“进攻性集群战术”(OFFSET)项目的提案人活动,目标是发展基于游戏的开放架构,为城市作战的无人集群系统生成、评估和集成集群战术。

欧洲方面,2016 年,欧洲防务局启动了“欧洲蜂群”项目,开展了无人机蜂群的自主决策、协同飞行等关键技术研究。2016年,英国国防部发起无人机蜂群竞赛,参赛的多个团队控制无人机蜂群实现了通信中继、协同干扰、目标跟踪定位和区域测绘等任务。2017 年,俄罗斯无线电电子技术集团对外发表研究计划称,在战斗机上装载多架蜂群无人机可实现协同侦察和攻击的新型作战样式。

国内也相继展开相关研究。最近,中国电科(CETC)电子科学研究院发布了陆军协同无人机“蜂群”视频,引起广泛关注。

面对这一重要课题,本文研究总结了无人机协同应用的发展趋势,对其当前研究进展和发展方向进行了探讨,并提出无人机集群任务协作的发展趋势是多智能体协同。

1 无人机协同应用发展趋势

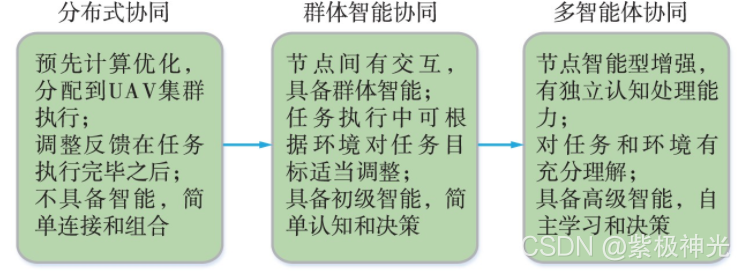

对现有研究工作的分析如图1所示,无人机协同应用大体上可以分为3个阶段,分别是分布式协同,群体智能协同和未来的多智能体协同。

图1 无人机协同技术的发展趋势

无人机集群协同发展的第1个阶段是简单分布式协同。在该阶段,协同任务根据执行条件,预先在简单连接和组合的集群成员之间经过计算处理后分配执行。集群基本没有能力根据环境与目标的变化动态调整任务分配,各无人机分担的任务通常是确定的。

鉴于预分配方式的局限性,受生物集群活动的启发,群体智能被应用于无人机集群,使无人机集群协同发展到第2个阶段——群体智能协同。在该阶段中,各个无人机节点被赋予初级智能,能够进行简单的认知和决策;通过集群个体之间更为紧密的耦合,可以根据执行中的反馈调整优化方式或者优化目标,使整个无人机集群系统有能力构成自组织、高稳定的分布式系统。群体智能协同阶段当前正处于研究和应用迅速发展时期。

随着节点计算能力的进一步提升和人工智能技术的飞速发展,无人机协同即将进入发展的第3个阶段——多智能体协同。在多智能体协同发展阶段,集群中的各个无人机都将是一个独立的综合智能体,具有多维度认知计算和高级智能处理能力,从而实现更高效的自主学习和决策,并在此基础上,完成更复杂、更艰巨的任务。

2 分布式协同

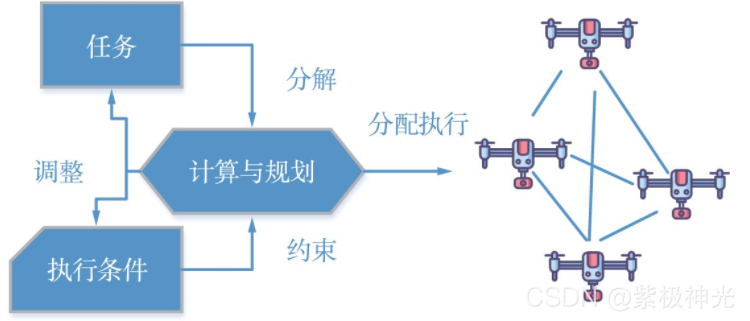

从无人机集群出现开始就被用于解决协同路径规划、协同感知和协同任务规划等分布式协作任务。早期的无人机分布式协同任务通常都是提前进行充分的计算和分配,无人机节点按照既定算法或者方案予以执行。根据计算结果,分布式协同无人机群可组织执行配置好的任务,如图2所示。

图2 分布式协同阶段的任务执行方式

2.1 协同路径规划

协同路径规划中,要求在给定目标或者搜索目标后,无人机节点根据当前的任务状态来确定飞行路径。针对协同搜索和跟踪任务的路线规划,无人机集群可采用最大化目标功能来检测最重要的目标,并在关键时刻对其进行跟踪,从而获得最有价值的信息。而协同搜索的路径规划可以分成无人机工作区间划分和全区域覆盖搜索路径规划2个子问题,将多机协同搜索转化为子区域上的单机搜索,对目标区域快速进行划分并生成飞行路线。基于改进遗传算法的多无人机协同侦察航迹规划算法,可用于解决面向复杂战场环境中高效侦察多种类型目标过程中的路径规划问题,并能够有效地提高航迹规划精度和效率。

2.2 协同感知

协同感知是多无人机集群共同探测感知某一目标区域状态的任务形式。在这类任务中最常见的是协同频谱感知。针对协同频谱感知任务特点,采用最佳融合准则的分布式协同任务执行方案可以优化检测性能,使协作频谱感知总错误率达到最小,并能降低协作感知时间,节省感知过程开销。

2.3 协同任务规划

协同任务规划要求集群系统能够根据目标任务和执行情况,对任务进行系统分配。例如,针对协同打击任务,通过建立无人机毁伤代价指标函数、航程代价指标函数和价值收益指标函数,可以实现多无人机协同打击任务的分配[5];而通过建立多目标优化模型并采用遗传算法,能有效提高任务的完成效率。针对协同搜救任务,使用一种新的基于通信保持的拍卖方法的自适应反馈调节遗传算法,能够改善传统遗传算法存在易陷入局部最优的弱点。

通过以上3种类型协同任务的相关研究工作可以看出,无人机集群的分布式协同方式虽然充分考虑了“分布式”特点,能够根据任务目标和集群特征,设置有效的目标函数和优化方法去寻求最优或者较优的结果,但是其任务执行环境和求解目标需要在任务执行之前进行优化计算,然后分配执行,不能适应实际中动态的任务目标和环境变化,缺乏“智能性”的感知和适应性行为。随着人们对“蜂群”“鸟群”等生物群体智能研究的深入,群体智能协同被进一步引入到无人机的协同中。

3 群体智能协同

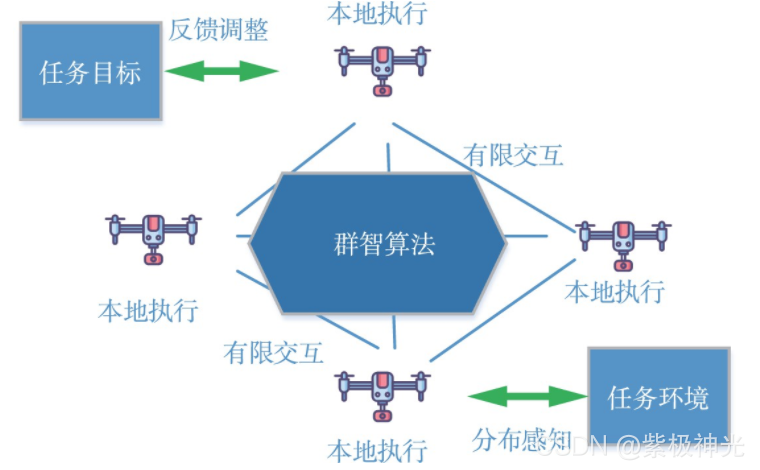

“鸟群”“蚁群”等生物群体,虽然其中的个体智能有限,但是群体却展现出高度的自组织性,这一特点与无人机集群自主协同的需求相符,因而群体智能在无人机协同应用领域也得到了广泛研究,使无人机集群协同具有了初步的智能性。具备群体智能的无人机集群系统在任务拆解和执行过程中引入了群体反馈和适变能力,可执行较复杂的动态任务,其过程如图3所示。

图3 群体智能协同阶段的任务执行方式

3.1 协同路径规划

山区路径规划任务受到地形特征的强烈影响,难以预先确定性分配执行,简单的分布式协同无法胜任。例如,为了执行山区应急物资运输的路径规划任务,一种考虑路径安全度的改进蚁群算法可快速收敛并生成更短路径。蚁群算法也被用于无人机协同飞抵空战场的航迹规划任务中;一种基于改进混沌蚁群算法更能克服传统蚁群智能算法中易出现局部极值、收敛效率低的缺陷,提升算法的全局寻优能力和搜索效率。针对协同攻击移动目标场景的航迹规划,另一种改进的蚁群算法建立了结合任务分配的无人机群协同航迹规划模型,可以快速地对地面多个移动目标规划出有效的航迹。

3.2 协同感知

在协同感知任务中,群体智能也得到应用。针对无人机集群通信场景和需求,出现了考虑结合认知无线电技术指导下的智能通信思想和汇聚有限智慧的群体智能理论方法,构建了群体智能协同通信模型和智能协同感知模型。

3.3 协同任务规划

协同作战是协同任务规划中的典型场景,结合群体智能优化算法的优势,基于粒子群-整数编码狼群算法的集群组网任务分配算法适合解决此类协同问题;由于无人机集群协同决策困难,还可以结合狼群算法的认知与协作能力,实现在复杂环境下迅速对目标进行跟踪和包围。这种协同任务,是第一类简单协同所不能胜任的。

虽然无人机集群和群体智能的结合可以充分发挥无人机集群优势,增强分布式协同智能性,可在任务执行过程中与环境和任务执行中间过程产生一定交互和反馈,使之具备一定的自适应能力,但是,这种智能仍然是非常有限的,其本质仍然是基于特定计算模式和反馈模式下的分布式优化算法。

4 多智能体协同

随着人工智能技术和节点自身算力的不断增强,未来无人机集群中的个体将具备更强的智能性,能够独立对环境和任务进行感知和评估,实现多个智能体之间的交互和协同,从而具备多智能体协同能力。

近年来,人工智能领域研究取得了突破性进展。其中,深度强化学习在诸多领域得到了成功应用。无线通信网络基于多智能体深度强化学习的资源分配技术也得到了深入研究。多智能体深度强化学习模型早已被用于解决车联网中频谱资源分配问题,这种应用已经与无人机集群系统颇为接近。例如一种基于多智能体深度强化学习的分布式动态功率分配方案。基于多智能体深度强化学习的策略还可被用于二者的结合——用无人机辅助车辆网络进行多维资源管理。

虽然基于强化学习的多智能体通信网络资源分配问题已经得到了广泛研究,但是由于网络特性的不同,传统的针对其他通信网络的研究成果不能直接用于无人机集群网络。因而基于强化学习的多智能体自主协同应用逐渐成为未来无人机多智能体自主协同的一个研究热点。针对无人机群的通信网络资源动态分配问题而提出的多智能体深度强化学习方案也陆续出现,例如,一种基于多智能体深度强化学习的分布式干扰协调策略被用于受到干扰的无人机网络中的文件下载业务。智能体在适用于无人机网络特点的独立强化学习中,其行为策略通常只能根据它们对全局环境的局部个体观察来制定。针对这种局限性,联合采用2种不同规模的智能体可解决智能体之间的通信问题。

无人机集群协同,经常会处理动态高维离散和连续动作状态空间的优化求解问题,近来出现的演员-评论家算法是深度强化学习的一个新兴方向,结合了基于值函数和基于策略函数的深度强化学习两大分支的优势,非常适用于无人机集群的智能协同。利用演员-评论家算法,在无线信道和可再生能源再生率都是随机变化,且环境动态变化条件下,可寻求资源分配最佳策略,如用于解决车联网中复杂动态环境下的资源分配问题。应用设备到设备(D2D)网络的异构蜂窝网络环境下,基于演员-评论家算法的策略可用于智能化节能模式选择和资源分配。

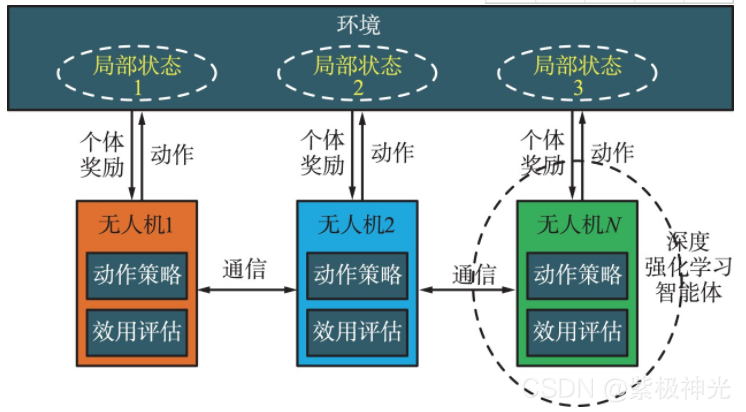

随着节点智能算力的不断增强,无人机集群中的每架无人机可以作为一个具有深度强化学习能力的智能体,而整个集群可通过合作构成多智能体。相邻无人机之间通过通信网络进行信息交换与分发。如图4所示,每架无人机都与局部环境相互作用,根据从周围环境或者同伴无人机得到的信息,针对承载的任务需求,通过深度强化学习,智能地产生动作策略,进行自身资源与行为的分配与调整,进而与环境和同伴互动,并获得个体奖励。

图4 基于多智能体的无人机集群

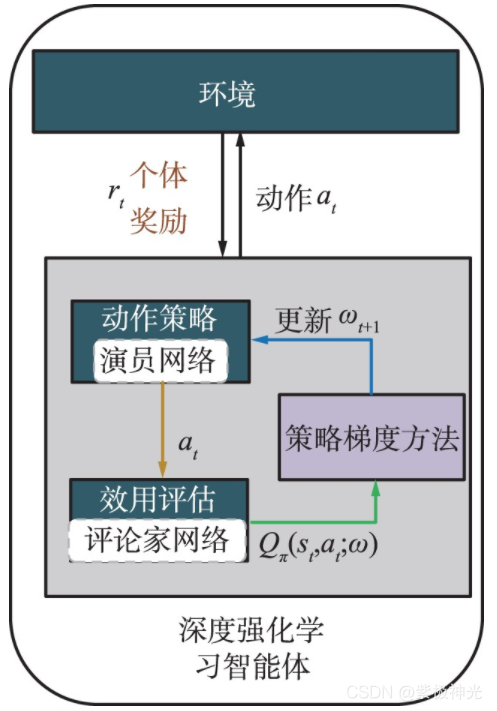

每架无人机的深度强化学习智能体由2个深度神经网络构成,包括演员网络和评论家网络,如图5所示。

图5 基于演员评论家算法的无人机智能体

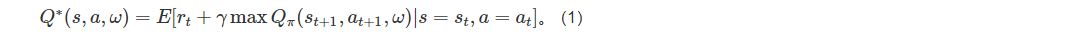

演员网络负责输出动作,评论家网络负责评价演员的动作,以获得相互促进的效果。与传统的深度强化学习方法相比,演员-评论家算法同时吸取了基于值函数方法和基于策略函数方法的优点,从价值和策略两方面来训练提升智能体,训练的更快,效果也更好。通过训练和学习,期望智能体的评论家网络可以获得最佳效用评估函数:

智能体从周围环境中观察得到状态信息St ,例如干扰状态、相邻无人机等。演员网络拟合动作策略函数π(St;ωπ),根据状态信息St,动作策略函数输出当前时隙的动作at,也就是资源分配结果,并应用到环境中得到个体的即时奖励rt。奖励由奖励函数计算得到,负责反馈一个即时的、合理的、具有指导意义的奖励值,从而激励智能体向目标更新策略。评论家网络拟合效用评估函数Q(St,at,ω),负责预测和评估在当前状态St采用动作at所能得到的状态动作价值,即长期性回报Rt为:

式中,γ是折扣因子,γ表示了当前对于未来收益的重视程度,取值在0~1之间,取值0则表示智能体忽视未来收益,只看重当前的收益rt,取值1则表示智能体将未来每个时刻的收益都视为与当前时刻收益一样的重要性。获得最大的长期性回报是智能体的最终目的,这个目标可以根据任务的性质被定义为不同的评判标准。

评论家网络的最佳效用评估函数对应的演员网络动作策略即为最佳动作策略π*。动作策略函数的参数通过策略梯度的方法进行更新,效用评估函数的参数采用最小化损失函数进行更新:

式中,yt为优势函数,用来衡量计算执行动作后的实际效用评估值。通过更新,智能体的演员网络的动作策略输出的动作越来越好,而评论家网络的效用评估也会越来越准确。基于多智能体的无人机群的每架无人机都会朝着收益最大的方向执行动作,从而实现集群的收益最大化。

⛄二、部分源代码

%name:AUV targets searching and avoid obstacles

clc;

clf;

clear all;

global obstacle;

obstacle=[];

global fls;

global auvpos;

fls=cell(1,1);

auvpos=cell(1,1);

insight_point=cell(1,1);

MaximumRange = 150; % 最大探测范围

Vl=zeros(2000,2000);%环境代价矩阵

Time_AllSteps = 50; %额定步数

Y = zeros(Time_AllSteps,6); %状态变量

global subregion;

subregion=[];

sub_obs_coor=[300,900;500,1300;500,1500;700,1300;700,1100;900,700;900,500;

1100,900;1100,700;1100,500;1300,1500;1300,1300;1300,700;

1300,900;1300,500;1500,1300;1500,700;1500,500;1500,1500];%障碍物占据的子区域中心点坐标

n1=1;

n2=1;

sub_area=[];

pp=0;

sub_pp_number=0;

for i=1:5

for j=1:5

p_obs=0;

for n=1:2

for p=1:2

pp=0;

for m=1:size(sub_obs_coor,1)

if((200+(i-1)400+(-1)n*100~=sub_obs_coor(m,1))||(200+(j-1)*400+(-1)p100~=sub_obs_coor(m,2)))

p_obs=1;

else

pp=1;

break;

end

end

if(pp0)

sub_pp_number=sub_pp_number+1;

sub_area=[sub_area,200+(i-1)400+(-1)n*100,200+(j-1)*400+(-1)p100,0];

end

end

end

if(p_obs~=0)

mm=size(sub_area,2);

if(mm>0)

subregion(n1,1:5+mm) = [n1,200+(i-1)*400,200+(j-1)*400,0,0,sub_area];

subregion(n1,18)=sub_pp_number;

sub_pp_number=0;

sub_area=[];

n1=1+n1;

end

end

end

end

global AUV_status;

AUV_status=cell(1,1);

AUV_Angle(:,1)=[0,0,0,0,0,0,0,0,0,0];%AUV的初始艏向角

auv_num(:,1)=[2,2,2,2,2,2,2,2,2,2];

global num_target;

global number_target;

global pos_target;

global pos_tar1;

global sub_auv;

global sublock_area;

global auv_hunt_flag;

global tracking_tar;

global auv_collaborators;

auv_collaborators=zeros(2,3);

[num_target,pos_target,Obstacles]=Make_obstacles4();%障碍物边界

pos_tar1=[pos_target’,zeros(size(pos_target,2),1)];

number_target=num_target;

button = 0;

mouse_click=0;

a_n = 1;

while button ~= 3

[x,y,button]=ginput(1); %十字光标

pin= ~isempty(x);

if (pin1 && button ~= 3)

mouse_click=mouse_click+1;

plot(x,y,‘mo’)

AUV_status{1}{a_n}(:,1)=[20,0,0,x,y,AUV_Angle(a_n,1)];

a_n = a_n+1;

end

end

hold off;

AUV_num=mouse_click;

AUV_AngTemp=AUV_Angle(1:mouse_click,1);

%视线导引的切换点的半径***

R=8;

n=ones(AUV_num,1);

angle_v=zeros(AUV_num,1);

flag_obsfind=zeros(AUV_num,1);

line_ok=zeros(AUV_num,1);

sub_flag = zeros(AUV_num,1);

sub_ok = zeros(AUV_num,1);

task_time = zeros(AUV_num,1);

sub_counter = 0;

flag_a=ones(AUV_num,1);

excute_task=zeros(AUV_num,1);

to_sub=zeros(AUV_num,1);

task_do=zeros(AUV_num,1);

tracking_tar=zeros(AUV_num,2);

task_continue=ones(AUV_num,1);

lock_area=zeros(AUV_num,4);

auv_task_start=zeros(AUV_num,2);

auv_hunt_flag=zeros(AUV_num,1);

allsub_task_over=0;

end_flag=0;

stop_sub=zeros(AUV_num,2);

taskovercomingflag=0;

change_flag=0;

dy_search_over=0;

flag_changesub=zeros(AUV_num,3);

sub_auv=zeros(AUV_num,1);

sublock_area=zeros(AUV_num,3);

obs_auv_PosAngleDis=cell(1,1);

sub_n=8;

sub2overflag=1;

line_color=[0,0,1;0,1,0;1,0,0;1,1,0;0,1,1;1,0,1;1,1,1];

global pid_err;

global pid_errobs;

global dynamic_mess;

global Dynamic_pos;

global hunt_time;

global dy_n;

global auv_group;

global vanish_flag;

vanish_flag=zeros(2,3);

auv_group=zeros(6,4);

dy_n=ones(AUV_num,1);

Dynamic_pos=zeros(2,3);

dy_tar_auv_num=zeros(2,1);

hunt_time=zeros(2,1);

pid_err=cell(1,3);

pid_errobs=cell(1,1);

dynamic_mess=cell(1,1);

dy_tar_num=0;

for i=1:AUV_num

pid_err{1}{i}(1:3,1)=0;

pid_errobs{1}{i}(1:3,1)=0;

obs_auv_PosAngleDis{1}{i}=[];

AUV_PosTemp(:,i)=AUV_status{1}{i}(4:5,1);%AUV位置临时变量

end

%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%

%*****视线导引控制PID参数

%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%

global K_p1;

global K_i1;

global K_d1;

% K_p1 =1.0; K_i1 = 0.525; K_d1 =0; %艏向控制

K_p1 =0.35; K_i1 = 0.85; K_d1 =0; %艏向控制

global K_p1obs;

global K_i1obs;

global K_d1obs;

% K_p1obs =0.5; K_i1obs = 3.5; K_d1obs =0;

K_p1obs =0.1; K_i1obs = 0.225; K_d1obs =0;%1 0.625

%%%%%%%%%%%%%%%%%%%

%随机动目标位置生成

x_rt=800;%随机目标位置初始化

y_rt=1600;

global x_sin;

global x_change_flag;

global tar0_Angle;

x_sin=400;

x_change_flag=0;

tar0_Angle=0;

%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%

Env_handle=environment_buliding4(pos_target);%环境构建

DrawAUV(AUV_PosTemp,AUV_Angle,AUV_num);

for step=1:1:4000%最大执行步数

% step=1;

% while(1)

t_obs = 0.1;

T1(step,1)=0.1step;

[OBS_point,flag_obs]=FLS_obsmeasure(Obstacles,AUV_PosTemp,AUV_AngTemp);

[Dynamic_pos(:,1:2),dynamic_pos,dynamic_angle]=RandTarget(x_rt,y_rt);

for i=1:length(AUV_AngTemp)

[search_tar_over]=target_search(AUV_PosTemp(:,i),AUV_AngTemp(i,1));

if(dy_tar_num<2)

[finddynamic_ok,angle_v(i,1),vanish,dy_tar_n,dynamic_tar_pos,find_tar_auv,hunt_group_done]=DynamicTargetSearchFun(AUV_PosTemp,AUV_AngTemp(i,1),Dynamic_pos,i);

end

if(search_tar_over1)%静态目标和动态目标搜索完毕

if(dy_tar_num2)

break;

else

dy_search_over=1;

subregion(:,4:5)=0;

end

end

if(flag_obs(i,1)==1&&line_ok(i,1)==0) %上一个时间AUV完成了导引避障

flag_a(i,1)=0;

finddynamic_ok=0;

% pid_err{1}{i}(:,1)=0;

flag_obsfind(i,1)=1;%第i个AUV遇到障碍物

AUV_status{1}{i}(1,auv_num(i,1)-1)=20;%有障碍减速

insight_point{1}{i}(:,1)=AUV_status{1}{i}(4:5,auv_num(i,1)-1);%视线导引起点为当前AUV的位置

insight_point{1}{i}(:,2)= OBS_point(i,:)'; %终点为推算的避障点

obs_auv_PosAngleDis{1}{i}(n(i,1),:)=OBS_point(i,:);

n(i,1)= n(i,1)+1;

else if((flag_obs(i,1)==1&&line_ok(i,1)==1)) %当前时刻检测到障碍物但是上一时刻未完成导引避障

flag_a(i,1)=0;

finddynamic_ok=0;

flag_obsfind(i,1)=1;%第i个AUV遇到障碍物

% AUV_status{1}{i}(1,auv_num(i,1)-1)=20;%有障碍减速

else if(flag_obs(i,1)==0&&line_ok(i,1)==1)%当前时刻未检测到障碍物但是上一时刻未完成导引避障

flag_a(i,1) =0;

finddynamic_ok=0;

flag_obsfind(i,1)=1;

else%当前时刻AUV未检测到障碍物,上一时刻的导引已经完成

flag_a(i,1) =1;

% pid_err{1}{i}(:,1)=0;

flag_obsfind(i,1)=0;%第i个AUV未遇到障碍物

% angle_v(i,1)=0; %不需要避障的,角速度为0

AUV_status{1}{i}(1,auv_num(i,1)-1)=40;%无障碍加速

end

end

end

if(flag_obsfind(i,1)==1)%判断第i个AUV需要视线导引避障

line_ok(i,1)=1;

[r,error,dt,emix]=insight_line(AUV_status{1}{i}(:,auv_num(i,1)-1),insight_point{1}{i}(:,1),insight_point{1}{i}(:,2),i);%直线视线导引控制避障

if(dt<=R)%AUV满足线段切换条件

flag_a(i,1)=1;

flag_obsfind(i,1)=0;%重启声呐检测障碍物

angle_v(i,1)=0;

pid_err{1}{i}(:,1)=0;

line_ok(i,1)=0;

else

angle_v(i,1)=r;

end

end

% %%%%%%%%%%AUV走向分配的子区域过程中或执行子区域任务与避障的临时切换机制%%%%%%%%

% %如果在AUV走向分配的子区域过程中或执行子区域任务时需要避障,

% %那么进行避障,结束后继续执行被中断的过程

% %而不是再重新分配子区域,因为被中断的过程还没有完成

% %%%%%%%%%%%%%%%%%%%切换机制代码区%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%

if(flag_a(i,1)==0)

if(task_do(i,1)==1)

excute_task(i,1)=1;%在执行子区域任务时被避障事件中断

else if(sub_ok(i,1)==0)

to_sub(i,1)=1;%在走向分配的子区域是被避障事件中断

end

end

% if(tracking_tar(i,1)1)%目标围捕过程中发生避障事件

% excute_task(i,1)=0;

% to_sub(i,1)=0;%前期执行的走向子区域和子区域搜索都作废,先避障,

% %如果动态目标不在视域内,完事再重新进行子区域分配;如果在视域内继续进行目标围捕

% end

end

if(finddynamic_ok1)%发现动态目标,进行跟踪

tracking_tar(i,1)=1;%当前AUV处于动目标围捕过程

tracking_tar(i,2)=dy_tar_n;%当前AUV围捕的目标编号

flag_a(i,1)=0;%进行动目标围捕不执行子区域分配

if(find_tar_auv~=0)

dy_tar_auv_num(dy_tar_n,1)=find_tar_auv;

organizing_auv( AUV_PosTemp,find_tar_auv,dy_tar_n);%一个AUV发现目标后确定队形的其他AUV编号,组成围捕队形

tracking_tar(auv_collaborators(dy_tar_n,2),1)=1;%当前AUV处于动目标围捕过程

tracking_tar(auv_collaborators(dy_tar_n,2),2)=dy_tar_n;%当前AUV围捕的目标编号

flag_a(auv_collaborators(dy_tar_n,2),1)=0;

tracking_tar(auv_collaborators(dy_tar_n,3),1)=1;%当前AUV处于动目标围捕过程

tracking_tar(auv_collaborators(dy_tar_n,3),2)=dy_tar_n;%当前AUV围捕的目标编号

flag_a(auv_collaborators(dy_tar_n,3),1)=0;

sub_auv(find_tar_auv)=0;%进行目标围捕过程中,以前的子区域锁定没到达的取消,取消AUV锁定子区域的标志

sub_auv(auv_collaborators(dy_tar_n,2))=0;

sub_auv(auv_collaborators(dy_tar_n,3))=0;

if(lock_area(find_tar_auv,1)~=0)

if(subregion(lock_area(find_tar_auv,1),lock_area(find_tar_auv,2))==0.5)

subregion(lock_area(find_tar_auv,1),lock_area(find_tar_auv,2))=0;

end

end

if(lock_area(auv_collaborators(dy_tar_n,2),1))

if(subregion(lock_area(auv_collaborators(dy_tar_n,2),1),lock_area(auv_collaborators(dy_tar_n,2),2))==0.5)

subregion(lock_area(auv_collaborators(dy_tar_n,2),1),lock_area(auv_collaborators(dy_tar_n,2),2))=0;

end

end

if(lock_area(auv_collaborators(dy_tar_n,3),1))

if(subregion(lock_area(auv_collaborators(dy_tar_n,3),1),lock_area(auv_collaborators(dy_tar_n,3),2))==0.5)

subregion(lock_area(auv_collaborators(dy_tar_n,3),1),lock_area(auv_collaborators(dy_tar_n,3),2))=0;

end

end

end

end

⛄三、运行结果

⛄四、matlab版本及参考文献

1 matlab版本

2014a

2 参考文献

[1]赵发,綦秀利,余晓晗,张所娟,李本凌.基于多无人机自主协作任务规划的区域搜索与目标围捕问题研究[J].电子技术与软件工程. 2022,(11)

3 备注

简介此部分摘自互联网,仅供参考,若侵权,联系删除

🍅 仿真咨询

1 各类智能优化算法改进及应用

1.1 PID优化

1.2 VMD优化

1.3 配电网重构

1.4 三维装箱

1.5 微电网优化

1.6 优化布局

1.7 优化参数

1.8 优化成本

1.9 优化充电

1.10 优化调度

1.11 优化电价

1.12 优化发车

1.13 优化分配

1.14 优化覆盖

1.15 优化控制

1.16 优化库存

1.17 优化路由

1.18 优化设计

1.19 优化位置

1.20 优化吸波

1.21 优化选址

1.22 优化运行

1.23 优化指派

1.24 优化组合

1.25 车间调度

1.26 生产调度

1.27 经济调度

1.28 装配线调度

1.29 水库调度

1.30 货位优化

1.31 公交排班优化

1.32 集装箱船配载优化

1.33 水泵组合优化

1.34 医疗资源分配优化

1.35 可视域基站和无人机选址优化

2 机器学习和深度学习分类与预测

2.1 机器学习和深度学习分类

2.1.1 BiLSTM双向长短时记忆神经网络分类

2.1.2 BP神经网络分类

2.1.3 CNN卷积神经网络分类

2.1.4 DBN深度置信网络分类

2.1.5 DELM深度学习极限学习机分类

2.1.6 ELMAN递归神经网络分类

2.1.7 ELM极限学习机分类

2.1.8 GRNN广义回归神经网络分类

2.1.9 GRU门控循环单元分类

2.1.10 KELM混合核极限学习机分类

2.1.11 KNN分类

2.1.12 LSSVM最小二乘法支持向量机分类

2.1.13 LSTM长短时记忆网络分类

2.1.14 MLP全连接神经网络分类

2.1.15 PNN概率神经网络分类

2.1.16 RELM鲁棒极限学习机分类

2.1.17 RF随机森林分类

2.1.18 SCN随机配置网络模型分类

2.1.19 SVM支持向量机分类

2.1.20 XGBOOST分类

2.2 机器学习和深度学习预测

2.2.1 ANFIS自适应模糊神经网络预测

2.2.2 ANN人工神经网络预测

2.2.3 ARMA自回归滑动平均模型预测

2.2.4 BF粒子滤波预测

2.2.5 BiLSTM双向长短时记忆神经网络预测

2.2.6 BLS宽度学习神经网络预测

2.2.7 BP神经网络预测

2.2.8 CNN卷积神经网络预测

2.2.9 DBN深度置信网络预测

2.2.10 DELM深度学习极限学习机预测

2.2.11 DKELM回归预测

2.2.12 ELMAN递归神经网络预测

2.2.13 ELM极限学习机预测

2.2.14 ESN回声状态网络预测

2.2.15 FNN前馈神经网络预测

2.2.16 GMDN预测

2.2.17 GMM高斯混合模型预测

2.2.18 GRNN广义回归神经网络预测

2.2.19 GRU门控循环单元预测

2.2.20 KELM混合核极限学习机预测

2.2.21 LMS最小均方算法预测

2.2.22 LSSVM最小二乘法支持向量机预测

2.2.23 LSTM长短时记忆网络预测

2.2.24 RBF径向基函数神经网络预测

2.2.25 RELM鲁棒极限学习机预测

2.2.26 RF随机森林预测

2.2.27 RNN循环神经网络预测

2.2.28 RVM相关向量机预测

2.2.29 SVM支持向量机预测

2.2.30 TCN时间卷积神经网络预测

2.2.31 XGBoost回归预测

2.2.32 模糊预测

2.2.33 奇异谱分析方法SSA时间序列预测

2.3 机器学习和深度学习实际应用预测

CPI指数预测、PM2.5浓度预测、SOC预测、财务预警预测、产量预测、车位预测、虫情预测、带钢厚度预测、电池健康状态预测、电力负荷预测、房价预测、腐蚀率预测、故障诊断预测、光伏功率预测、轨迹预测、航空发动机寿命预测、汇率预测、混凝土强度预测、加热炉炉温预测、价格预测、交通流预测、居民消费指数预测、空气质量预测、粮食温度预测、气温预测、清水值预测、失业率预测、用电量预测、运输量预测、制造业采购经理指数预测

3 图像处理方面

3.1 图像边缘检测

3.2 图像处理

3.3 图像分割

3.4 图像分类

3.5 图像跟踪

3.6 图像加密解密

3.7 图像检索

3.8 图像配准

3.9 图像拼接

3.10 图像评价

3.11 图像去噪

3.12 图像融合

3.13 图像识别

3.13.1 表盘识别

3.13.2 车道线识别

3.13.3 车辆计数

3.13.4 车辆识别

3.13.5 车牌识别

3.13.6 车位识别

3.13.7 尺寸检测

3.13.8 答题卡识别

3.13.9 电器识别

3.13.10 跌倒检测

3.13.11 动物识别

3.13.12 二维码识别

3.13.13 发票识别

3.13.14 服装识别

3.13.15 汉字识别

3.13.16 红绿灯识别

3.13.17 虹膜识别

3.13.18 火灾检测

3.13.19 疾病分类

3.13.20 交通标志识别

3.13.21 卡号识别

3.13.22 口罩识别

3.13.23 裂缝识别

3.13.24 目标跟踪

3.13.25 疲劳检测

3.13.26 旗帜识别

3.13.27 青草识别

3.13.28 人脸识别

3.13.29 人民币识别

3.13.30 身份证识别

3.13.31 手势识别

3.13.32 数字字母识别

3.13.33 手掌识别

3.13.34 树叶识别

3.13.35 水果识别

3.13.36 条形码识别

3.13.37 温度检测

3.13.38 瑕疵检测

3.13.39 芯片检测

3.13.40 行为识别

3.13.41 验证码识别

3.13.42 药材识别

3.13.43 硬币识别

3.13.44 邮政编码识别

3.13.45 纸牌识别

3.13.46 指纹识别

3.14 图像修复

3.15 图像压缩

3.16 图像隐写

3.17 图像增强

3.18 图像重建

4 路径规划方面

4.1 旅行商问题(TSP)

4.1.1 单旅行商问题(TSP)

4.1.2 多旅行商问题(MTSP)

4.2 车辆路径问题(VRP)

4.2.1 车辆路径问题(VRP)

4.2.2 带容量的车辆路径问题(CVRP)

4.2.3 带容量+时间窗+距离车辆路径问题(DCTWVRP)

4.2.4 带容量+距离车辆路径问题(DCVRP)

4.2.5 带距离的车辆路径问题(DVRP)

4.2.6 带充电站+时间窗车辆路径问题(ETWVRP)

4.2.3 带多种容量的车辆路径问题(MCVRP)

4.2.4 带距离的多车辆路径问题(MDVRP)

4.2.5 同时取送货的车辆路径问题(SDVRP)

4.2.6 带时间窗+容量的车辆路径问题(TWCVRP)

4.2.6 带时间窗的车辆路径问题(TWVRP)

4.3 多式联运运输问题

4.4 机器人路径规划

4.4.1 避障路径规划

4.4.2 迷宫路径规划

4.4.3 栅格地图路径规划

4.5 配送路径规划

4.5.1 冷链配送路径规划

4.5.2 外卖配送路径规划

4.5.3 口罩配送路径规划

4.5.4 药品配送路径规划

4.5.5 含充电站配送路径规划

4.5.6 连锁超市配送路径规划

4.5.7 车辆协同无人机配送路径规划

4.6 无人机路径规划

4.6.1 飞行器仿真

4.6.2 无人机飞行作业

4.6.3 无人机轨迹跟踪

4.6.4 无人机集群仿真

4.6.5 无人机三维路径规划

4.6.6 无人机编队

4.6.7 无人机协同任务

4.6.8 无人机任务分配

5 语音处理

5.1 语音情感识别

5.2 声源定位

5.3 特征提取

5.4 语音编码

5.5 语音处理

5.6 语音分离

5.7 语音分析

5.8 语音合成

5.9 语音加密

5.10 语音去噪

5.11 语音识别

5.12 语音压缩

5.13 语音隐藏

6 元胞自动机方面

6.1 元胞自动机病毒仿真

6.2 元胞自动机城市规划

6.3 元胞自动机交通流

6.4 元胞自动机气体

6.5 元胞自动机人员疏散

6.6 元胞自动机森林火灾

6.7 元胞自动机生命游戏

7 信号处理方面

7.1 故障信号诊断分析

7.1.1 齿轮损伤识别

7.1.2 异步电机转子断条故障诊断

7.1.3 滚动体内外圈故障诊断分析

7.1.4 电机故障诊断分析

7.1.5 轴承故障诊断分析

7.1.6 齿轮箱故障诊断分析

7.1.7 三相逆变器故障诊断分析

7.1.8 柴油机故障诊断

7.2 雷达通信

7.2.1 FMCW仿真

7.2.2 GPS抗干扰

7.2.3 雷达LFM

7.2.4 雷达MIMO

7.2.5 雷达测角

7.2.6 雷达成像

7.2.7 雷达定位

7.2.8 雷达回波

7.2.9 雷达检测

7.2.10 雷达数字信号处理

7.2.11 雷达通信

7.2.12 雷达相控阵

7.2.13 雷达信号分析

7.2.14 雷达预警

7.2.15 雷达脉冲压缩

7.2.16 天线方向图

7.2.17 雷达杂波仿真

7.3 生物电信号

7.3.1 肌电信号EMG

7.3.2 脑电信号EEG

7.3.3 心电信号ECG

7.3.4 心脏仿真

7.4 通信系统

7.4.1 DOA估计

7.4.2 LEACH协议

7.4.3 编码译码

7.4.4 变分模态分解

7.4.5 超宽带仿真

7.4.6 多径衰落仿真

7.4.7 蜂窝网络

7.4.8 管道泄漏

7.4.9 经验模态分解

7.4.10 滤波器设计

7.4.11 模拟信号传输

7.4.12 模拟信号调制

7.4.13 数字基带信号

7.4.14 数字信道

7.4.15 数字信号处理

7.4.16 数字信号传输

7.4.17 数字信号去噪

7.4.18 水声通信

7.4.19 通信仿真

7.4.20 无线传输

7.4.21 误码率仿真

7.4.22 现代通信

7.4.23 信道估计

7.4.24 信号检测

7.4.25 信号融合

7.4.26 信号识别

7.4.27 压缩感知

7.4.28 噪声仿真

7.4.29 噪声干扰

7.5 无人机通信

7.6 无线传感器定位及布局方面

7.6.1 WSN定位

7.6.2 高度预估

7.6.3 滤波跟踪

7.6.4 目标定位

7.6.4.1 Dv-Hop定位

7.6.4.2 RSSI定位

7.6.4.3 智能算法优化定位

7.6.5 组合导航

8 电力系统方面

微电网优化、无功优化、配电网重构、储能配置

1710

1710

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?