目录

2.4数据的合并---concat方法、join方法、append方法

2.4.1 任务一:将data文件夹里面的所有数据都载入,与之前的原始数据相比,观察他们的之间的关系

2.4.2:任务二:使用concat方法:将数据train-left-up.csv和train-right-up.csv横向合并为一张表,并保存这张表为result_up

2.4.4 任务四:使用DataFrame对象自带的方法join方法和append:完成任务二和任务三的任务

2.4.5 任务五:使用Panads的merge方法和DataFrame的append方法:完成任务二和任务三的任务

数据重构依旧属于数据理解(准备)的范围,其主要目的是为了满足分析、挖掘和建模要求,往往处理效率不是优先考虑的。事实上,数据结构复杂或者不满足模型要求的数据比特大量级的数据更可怕。

# 导入基本库,数据处理的基本操作

import numpy as np

import pandas as pd# 载入data文件中的:train-left-up.csv

text = pd.read_csv('/Users/chenandong/Documents/datawhale数据分析每个人题目设计/招募阶段/第二章项目集合/data/train-left-up.csv')

text.head()第二章Part2:数据重构

2.4数据的合并---concat方法、join方法、append方法

2.4.1 任务一:将data文件夹里面的所有数据都载入,与之前的原始数据相比,观察他们的之间的关系

#加载对应文件

text_left_up = pd.read_csv(r'C:\Users\maxqu\Desktop\动手学数据分析\hands-on-data-analysis-master\第二章项目集合\data\train-left-up.csv')

text_left_down = pd.read_csv(r'C:\Users\maxqu\Desktop\动手学数据分析\hands-on-data-analysis-master\第二章项目集合\data\train-left-down.csv')

text_right_up = pd.read_csv(r'C:\Users\maxqu\Desktop\动手学数据分析\hands-on-data-analysis-master\第二章项目集合\data\train-right-up.csv')

text_right_down = pd.read_csv(r'C:\Users\maxqu\Desktop\动手学数据分析\hands-on-data-analysis-master\第二章项目集合\data\train-right-down.csv')text_left_up.head()

text_left_down.head()

text_right_down.head()

text_right_up.head()2.4.2:任务二:使用concat方法:将数据train-left-up.csv和train-right-up.csv横向合并为一张表,并保存这张表为result_up

concat函数是在pandas底下的方法,可以将数据根据不同的轴作简单的融合

pd.concat(objs, axis=0, join='outer', join_axes=None, ignore_index=False,

keys=None, levels=None, names=None, verify_integrity=False)

参数说明

objs: series,dataframe或者是panel构成的序列lsit

axis: 需要合并链接的轴,0是行,1是列

join:连接的方式 inner是取交集,或者outer取并集其他一些参数不常用,用的时候再补上说明。

list_up = [text_left_up,text_right_up]# 先将表构成list,

result_up = pd.concat(list_up,axis=1)#然后在作为concat方法的参数输入

result_up.head()2.4.3 任务三:使用concat方法:将train-left-down和train-right-down横向合并为一张表,并保存这张表为result_down。然后将上边的result_up和result_down纵向合并为result。

list_down=[text_left_down,text_right_down]

result_down = pd.concat(list_down,axis=1)

#前两行代码相当于:result_down = pd.concat([text_left_down,text_right_down],axis=1)

result = pd.concat([result_up,result_down])

#上一行代码相当于:result_1=[result_up,result_down];result=pd.concat(result_1,axis=0)

result.head()2.4.4 任务四:使用DataFrame对象自带的方法join方法和append:完成任务二和任务三的任务

append是series和dataframe的方法,使用它就是默认沿着(axis = 0)列进行拼接

DataFrame的join默认为左连接

resul_up = text_left_up.join(text_right_up)#将text_right_up左连接至text_left_up

result_down = text_left_down.join(text_right_down)将text_right_down左连接至text_left_down

result = result_up.append(result_down)#append方法默认按列上下连接,可修改参数

result.head()2.4.5 任务五:使用Panads的merge方法和DataFrame的append方法:完成任务二和任务三的任务

result_up = pd.merge(text_left_up,text_right_up,left_index=True,right_index=True)#merge函数index默认为False

result_down = pd.merge(text_left_down,text_right_down,left_index=True,right_index=True)

result = resul_up.append(result_down)

result.head()【思考】对比merge、join以及concat的方法的不同以及相同。思考一下在任务四和任务五的情况下,为什么都要求使用DataFrame的append方法,如何只要求使用merge或者join可不可以完成任务四和任务五呢?--- 尝试调整各方法的参数应该可以做到。

2.4.6 任务六:完成的数据保存为result.csv

result.to_csv('result.csv')

#此处为保存绝对路径,未调试好绝对路径环境可能会报错2.5 换一种角度看数据

2.5.1 任务一:将我们的数据变为Series类型的数据

# 将完整的数据加载出来

text = pd.read_csv(r'C:\Users\maxqu\Desktop\动手学数据分析\hands-on-data-analysis-master\第二章项目集合\result.csv')

text.head()

# 代码写在这里

unit_result=text.stack().head(20)

unit_result.head()表格在行列方向上均有索引(类似于DataFrame),花括号结构只有“列方向”上的索引(类似于层次化的Series),结构更加偏向于堆叠(Series-stack,方便记忆)。stack函数会将数据从”表格结构“变成”花括号结构“,即将其行索引变成列索引,反之,unstack函数将数据从”花括号结构“变成”表格结构“,即要将其中一层的列索引变成行索引。

#将代码保存为unit_result,csv

unit_result.to_csv('unit_result.csv')test = pd.read_csv('unit_result.csv')

test.head()第二章Part2:数据重构-----数据聚合与运算

#载入基本库

import numpy as np

import pandas as pd

# 载入data文件中的:result.csv

text = pd.read_csv('result.csv')

text.head()2.6 数据运用

2.6.1 任务一:通过《Python for Data Analysis》P303、Google or Baidu来学习了解GroupBy机制

GroupBy机制的详细举例

2.6.2:任务二:计算泰坦尼克号男性与女性的平均票价

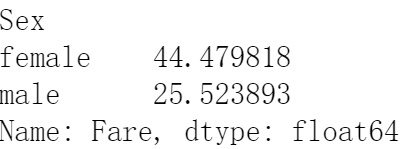

df = text['Fare'].groupby(text['Sex'])#按照列表中sex进行分组,先抽取Fare这列,然后按Sex分组

means = df.mean()

means#上两行代码可以改写为df.mean(),不需要加中间变量也可以,但加入中间变量后面方便调用,2.6.3:任务三:统计泰坦尼克号中男女的存活人数

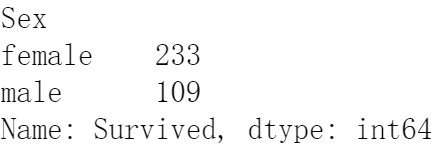

survived_sex = text['Survived'].groupby(text['Sex']).sum()#Survived列为0-1变量

#抽取Survived列,然后按照Sex分组,然后进行求和

survived_sex.head()2.6.4:任务四:计算客舱不同等级的存活人数

survived_pclass = text['Survived'].groupby(text['Pclass'])

#先抽取Survived列再按照Pclass进行分组

survived_pclass.sum()【思考】从任务二到任务三中,这些运算可以通过agg()函数来同时计算。并且可以使用rename函数修改列名。你可以按照提示写出这个过程吗?

#例子:

text.groupby('Sex').agg({'Fare': 'mean', 'Pclass': 'count'}).rename(columns=

{'Fare': 'mean_fare', 'Pclass': 'count_pclass'})

#先按照sex进行分组2.6.5:任务五:统计在不同等级的票中的不同年龄的船票花费的平均值

text.groupby(['Pclass','Age'])['Fare'].mean().head()

#先按Pclass和Age分组,再抽取Fare列信息,接着对抽取的数据求均值,最后显示2.6.6:任务六:将任务二和任务三的数据合并,并保存到sex_fare_survived.csv

result = pd.merge(means,survived_sex,on='Sex')

#合并任务二,任务三的数据,on表示按什么进行合并,任务二和三都是按Sex展开的数据,Sex此处发挥关键字的作用,删除on=’Sex'会报错

result2.6.7:任务七:得出不同年龄的总的存活人数,然后找出存活人数的最高的年龄,最后计算存活人数最高的存活率(存活人数/总人数)

#不同年龄的存活人数

survived_age = text['Survived'].groupby(text['Age']).sum()

#先抽取Survived那一列,然后对抽取的数据按照Age进行分组,

#最后加和确定不同年龄的存货人数,此处操作数据为0-1变量

survived_age.head()#找出最大值的年龄段

survived_age[survived_age.values==survived_age.max()]

#先使用max方法求最大值,再判断是否相等,相等就把值赋给values

#但为什么不用for循环就能做到遍历列表??#计算总的幸存人数

_sum = text['Survived'].sum()

#sum是方法,不能用作中间变量

print(_sum)#首先计算总人数

_sum = text['Survived'].sum()

print("sum of person:"+str(_sum))

precetn =survived_age.max()/_sum

print("最大存活率:"+str(precetn))

77

77

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?