这节课好像吸收的东西有点少

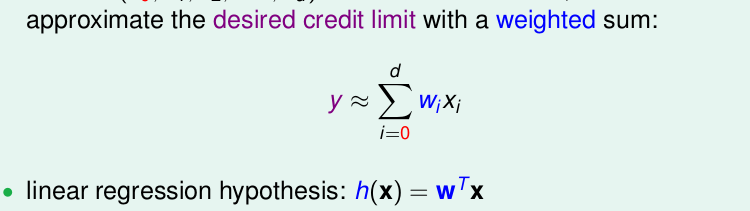

总体来说,线性回归就是形如

其实就是对我们的特征x进行加权w再求和罢了。

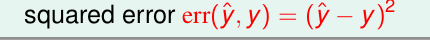

他的误差计算公式为

那么就是想最小化

err(y⏞,y)

.

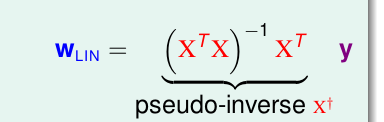

我们用矩阵的计算方法,其实可以直接求得

觉得这个推导,吴恩达老师的cs229讲的比林轩田老师讲的好,吴恩达来说用的是 矩阵迹的方法trace()。

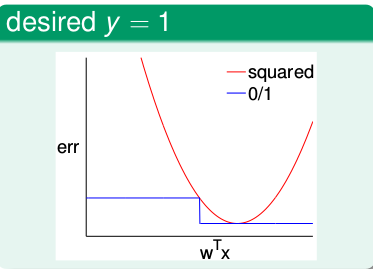

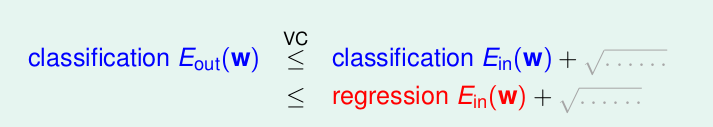

linear regression 能否用在 linear classification 上

答案是可以的。

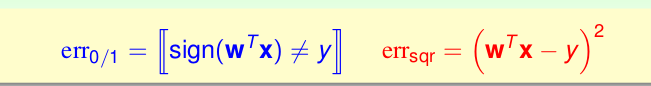

我们比较他们的误差函数

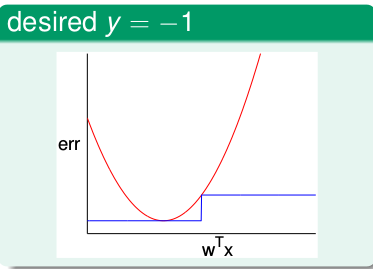

以

wTX

作为横坐标,误差err作为纵坐标.

当y=1时

当y=-1时

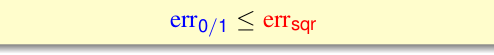

发现,不管怎样,始终有

所以

regression的

Ein(w)

可以作为classification

Eout(w)

的上限

所以,只要我们让regression的

Ein(w)

尽可能的小,那么就可以让classification

Eout(w)

尽可能的小。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?