程序员接单不是啥新鲜事儿,不少程序员在工作之余会找一点单子来做,进而在二三线城市就拿到对标一线城市的薪资。

有的程序员会上论坛和一些接单群去找单子做,但是一般来说这种的工资会比较低,而且由于没有第三方的保障,有的无良甲方会想着办法压你价格,出了问题也可能直接撕破脸皮,对双方来说都不是好的选择;当然,如过有算比较稳定的客户,长期合作的那种还是不错的。

所以说走平台还是不错的,虽然会交一点服务费,起码不用担心遇上无良甲方的问题;但现在市场上充斥着大量良莠不齐的接单平台,想要找到好一点的是比较有难度的,今天就给大家推荐六个相对不错的平台,希望能帮到大家:

干货满满,链接会放在评论区,希望大家点点赞和收藏哦~

一、程序员客栈

这是一个比较老牌的平台了,上面开发者数目相当多,无论是Java、C++这些热门语言,还是go、php这些比较小众的语言,都可以在上面接到单。

收入还是不错的,而且有不少企业会在上面发包,想接单的程序员可以注册一个账号每天ping一ping。

二、开源众包

开源中国的众包平台,顾名思义平台多以外包为主,上面的协助开发工具是比较多的,可以试一试。

但是平台是通过竞价招标的方式来发包的,这种方式比较适合工作三到五年的程序员,权当练手,如果是工作的比较久的程序员就没必要用这种方式,沉没成本会比较大

三、英选

这个平台的特色是项目管理,具体来说就是项目进度和交付的流程比较多,对甲方比较友好

四、解放号

这也是一个接外包的网站,而且接包方以那种小工作室为主;另外这个平台上有很多政府采购的单子,收入也是不错的。

5、upwork

upwork是面向全球的一个自由工作网站,上面各种职业的远程工作都找的到,自然也少不了面向程序员的单子;

但是要注意一个问题,语言门槛比较高,建议英语比较好的去接单,否则会在沟通和交流上投入大量时间。

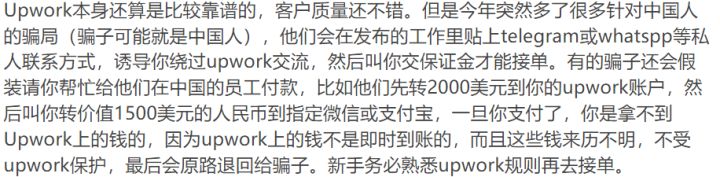

另外,这段时间有在upwork上接单的同学反映,平台上有骗子,务必熟悉规则、保持警惕:

6、freelancer

这也是个国外的网站,但是相比upwork对我们可能会更友好:它有中文站点,语言门槛相对会低一点。

但这个平台上东南亚和印度那边的程序员会更多一点,他们比较喜欢玩价格战,用低于市场的价格抢单子来做。

整理不易,希望大家点点赞和收藏哦~

本文推荐了六个适合程序员接单的平台,包括程序员客栈、开源众包等,涵盖了国内外市场,帮助程序员寻找合适的兼职机会。

本文推荐了六个适合程序员接单的平台,包括程序员客栈、开源众包等,涵盖了国内外市场,帮助程序员寻找合适的兼职机会。

1233

1233

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?