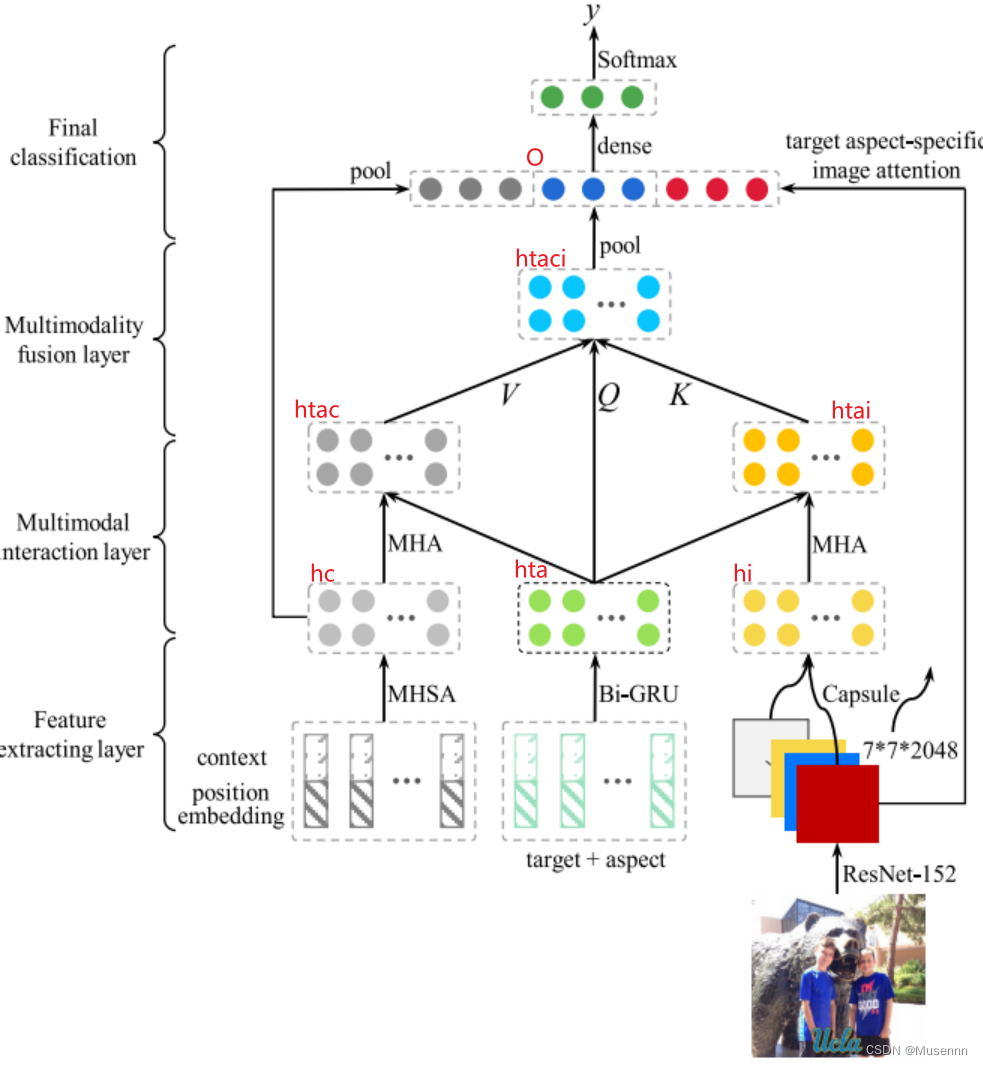

模型整体运行架构

1. 特征提取层

- 图像特征:使用预训练的ResNet-152模型从输入图像中提取特征。这些特征经过Capsule网络进一步处理,提供图像的高级表示。

- 文本特征:文本数据(目标和方面)通过位置嵌入和Bi-GRU(双向门控循环单元)网络处理。Bi-GRU有助于捕捉文本数据中的前后文关系,输出文本的上下文敏感表示。

2. 多模态交互层

- 多头自注意力(MHSA):这一层使用多头自注意力机制,能够从不同的表示子空间并行地提取信息,增强模型对不同特征的聚焦能力。

- 多头注意力(MHA):结合了图像和文本特征的多头注意力单元,处理来自不同模态的交互,使模型能够关联和强化相关的模态特征。

3. 多模态融合层

- Pooling and Dense Layers:特征通过池化层进行下采样,随后通过密集连接层整合各个注意力头的输出,形成一个统一的特征表示,为分类任务提供全面的特征支持。

4. 最终分类层

- 线性变换和Softmax激活经过多模态融合层的特征被送入一个线性变换层

( x = W 0 T O + b 0 ) (x = W_0^T O+b_0) (x=W0TO+b0),这里的 W 0 W_0 W0和 b 0 b_0 b0 是可训练的参数。变换后的输出x通过Softmax函数转换为最终的概率分布 ( y ^ = softmax ( x ) ) ( \hat{y} = \text{softmax}(x) ) (y^=softmax(x)),其中每个类的概率表示输入属于该类的可能性。

总结

图中标红的字符是对原文中公式的示例化标注,目的是为了更好的理解原文中的公式,原文Doi如下:10.1109/ACCESS.2021.3126782

全文概括

创新点

- 多模态整合: 首次尝试将图像和文本数据结合在一起,针对特定方面进行情感分析,以提高情感分类的准确性和深度。

- 注意力胶囊网络: 引入胶囊网络来提取图像中的特征,并结合多头注意力机制,更好地捕捉文本和图像之间的相互作用。

- 多头融合策略: 利用多头注意力(Multi-Head Attention, MHA)策略来加强模态间信息的交互,使模型能够更全面地理解和融合来自不同源的信息。

主要方法

- 特征提取层: 使用ResNet-152和词嵌入技术从图像和文本中提取特征。

- 多模态交互层: 通过双向GRU处理文本数据,结合多头自注意力机制来加强文本语义的编码。

- 多模态融合层: 使用多头注意力基于胶囊网络的输出和文本特征进行融合,形成综合的多模态表示。

- 最终分类层: 结合所有融合后的特征进行情感分类,使用softmax函数来预测不同情感极性的概率。

取得的效果

实验结果表明,这种结合了文本和图像信息的多模态情感分析模型(EF-Net)在多个手动标注的数据集上表现优异,显著优于传统的单模态方法和其他多模态基线模型。这验证了将多种模态信息整合进情感分析任务中的有效性和优越性。

可能的改进方法

- 模型简化: 考虑减少模型复杂度,简化某些网络层的设计,以提高模型的运行效率和易用性。

- 更广泛的数据应用: 扩展模型应用到更多类型的多模态数据和不同领域的情感分析任务中。

- 改进训练策略: 优化模型的训练过程,例如引入更先进的正则化技术或调整学习率策略,以提高模型对不同数据分布的适应性和鲁棒性。

- 深度学习优化: 探索更多的深度学习技术,如变换器网络(Transformers)和预训练模型(如BERT),以进一步提升模型性能。

总结

虽然在2024年的今天,大规模预训练方法已经屡见不鲜甚至说已经霸榜,但是这个模型在一定程度上仍能提供一些启发,如双单峰网络对于模态间信息交互的处理仍然存在一定问题,本文所提出的方法在解决该问题上仍有一定的可借鉴性。可惜的是本文并未提供开源代码。

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?