DAAM: 揭秘Stable Diffusion的内部运作

在人工智能快速发展的今天,各种强大的AI模型层出不穷。其中,Stable Diffusion作为一款优秀的文本到图像生成模型,凭借其出色的效果受到了广泛关注。然而,对于大多数用户来说,Stable Diffusion的内部运作机制仍然是一个黑盒。为了揭开这个神秘面纱,研究人员开发了一种名为DAAM (Diffusion Attentive Attribution Maps)的新方法,旨在解释和可视化Stable Diffusion的生成过程。

DAAM: 跨注意力归因图

DAAM全称为"Diffusion Attentive Attribution Maps",即扩散注意力归因图。它是一种基于跨注意力(cross-attention)的方法,用于解释Stable Diffusion模型的内部机制。通过分析模型在生成过程中的注意力分布,DAAM可以为我们展示输入文本中的每个词对最终生成图像的影响程度。

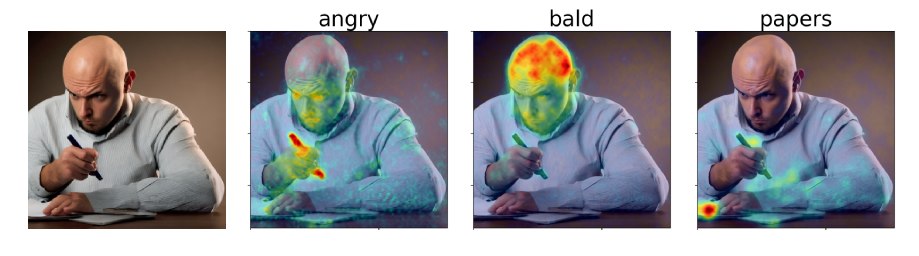

如上图所示,DAAM可以生成热力图来直观地展示文本中各个词对应的图像区域。这种可视化方法让我们能够一目了然地看到模型是如何"理解"和"执行"我们的文本提示的。

DAAM的工作原理

DAAM的核心思想是利用Stable Diffusion模型中的跨注意力机制。在生成过程中,模型会计算文本tokens和图像特征之间的注意力权重。DAAM通过汇总这些注意力权重,生成一个全局的热力图,展示了文本中每个词对最终图像的贡献程度。

具体来说,DAAM的工作流程如下:

- 对输入的文本提示进行tokenization。

- 在Stable Diffusion的生成过程中,记录每一步的跨注意力权重。

- 对所有时间步骤的注意力权重进行汇总,得到一个全局的注意力分布。

- 根据全局注意力分布,为每个文本token生成对应的热力图。

- 将热力图叠加在生成的图像上,直观地展示每个词的影响区域。

DAAM的应用与意义

DAAM的出现为我们理解和解释Stable Diffusion模型提供了一个强大的工具。它的应用价值主要体现在以下几个方面:

-

模型解释性: DAAM帮助我们窥探AI模型的决策过程,增强了模型的可解释性。这对于构建可信赖的AI系统至关重要。

-

提示词优化: 通过观察不同词语对生成结果的影响,用户可以更好地优化他们的提示词,以获得更理想的生成效果。

-

模型调试与改进: 对于AI研究者和开发者来说,DAAM提供的可视化信息可以帮助他们发现模型的潜在问题,从而进行针对性的改进。

-

教育价值: DAAM为非专业人士提供了一个直观理解AI图像生成过程的窗口,有助于普及AI知识。

-

创意探索: 艺术家和设计师可以利用DAAM的可视化结果,探索新的创作方式和灵感来源。

如何使用DAAM

DAAM已经被开源,任何人都可以轻松使用这个工具来探索Stable Diffusion的内部机制。以下是使用DAAM的基本步骤:

- 安装DAAM:

pip install daam

- 导入必要的库:

from daam import trace, set_seed

from diffusers import DiffusionPipeline

import torch

- 加载Stable Diffusion模型:

model_id = 'stabilityai/stable-diffusion-xl-base-1.0'

pipe = DiffusionPipeline.from_pretrained(model_id, use_auth_token=True, torch_dtype=torch.float16)

pipe = pipe.to('cuda')

- 使用DAAM生成热力图:

prompt = '一只狗在草地上奔跑'

with torch.no_grad():

with trace(pipe) as tc:

out = pipe(prompt, num_inference_steps=50)

heat_map = tc.compute_global_heat_map()

heat_map = heat_map.compute_word_heat_map('狗')

heat_map.plot_overlay(out.images[0])

通过以上步骤,你就可以生成一张展示"狗"这个词对应图像区域的热力图了。

结语

DAAM的出现无疑是AI可解释性研究的一大进步。它不仅帮助我们更好地理解Stable Diffusion这样的复杂AI模型,也为未来开发更透明、更可控的AI系统指明了方向。随着这类解释工具的不断发展,我们有理由相信,AI技术将变得越来越透明、可信,最终更好地服务于人类社会。

作为AI爱好者或研究者,不妨亲自尝试使用DAAM,探索Stable Diffusion的奇妙世界。相信这个过程不仅能增进你对AI技术的理解,还能激发你对未来AI发展的更多思考。

项目链接:www.dongaigc.com/a/daam-explaining-stable-diffusion-cross-attention-map

https://www.dongaigc.com/a/daam-explaining-stable-diffusion-cross-attention-map

1227

1227

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?