Ollama GUI:为本地大型语言模型打造的优秀Web交互界面

在人工智能和自然语言处理技术快速发展的今天,大型语言模型(LLM)的应用越来越广泛。然而,如何方便地在本地部署和使用这些强大的模型一直是一个挑战。Ollama GUI应运而生,为用户提供了一个简单易用的Web界面,让与本地LLM的交互变得轻而易举。

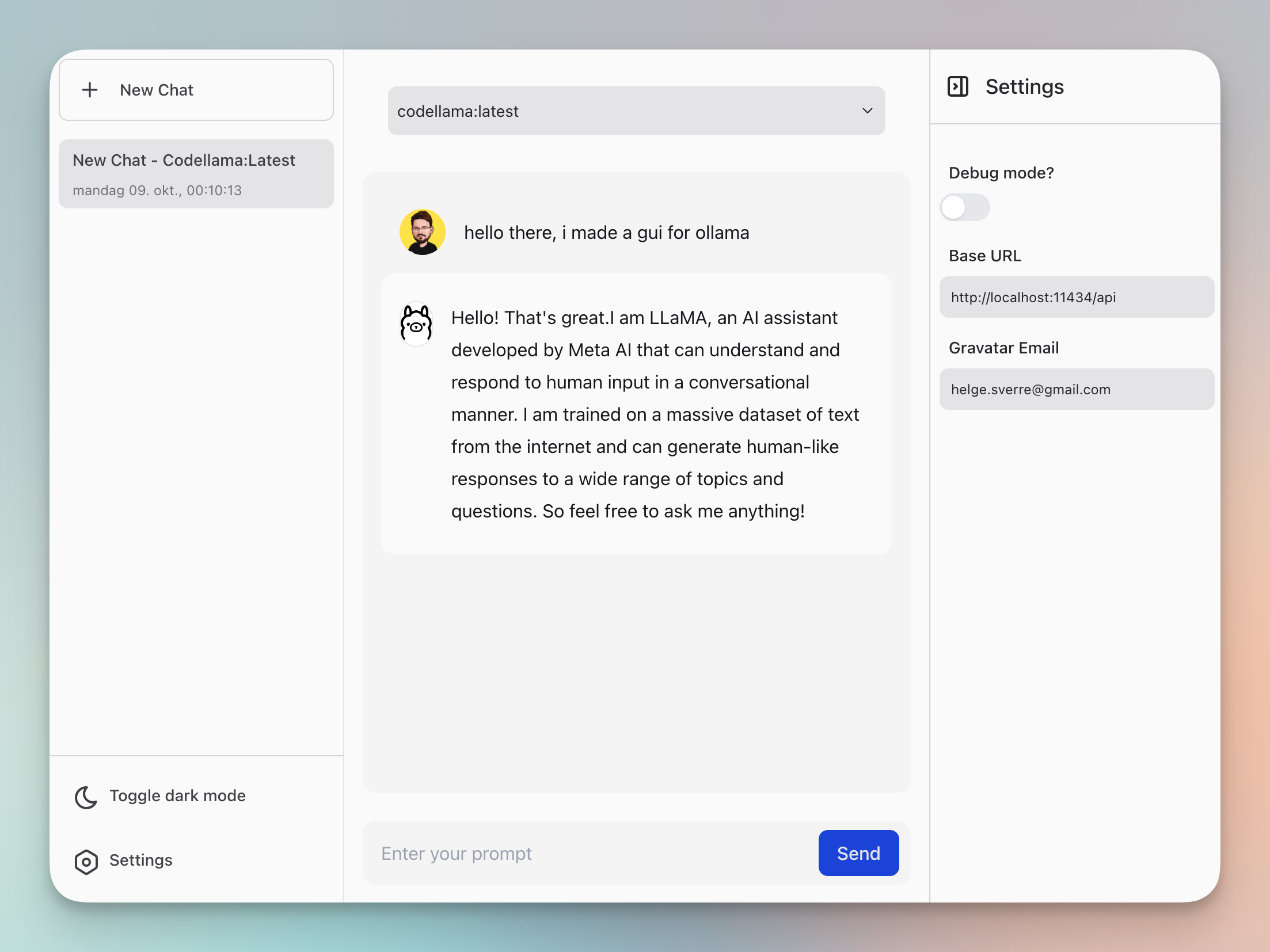

Ollama GUI简介

Ollama GUI是一个开源的Web界面,专门为ollama.ai设计。Ollama是一个强大的工具,能够让用户在本地机器上运行大型语言模型。Ollama GUI则在此基础上,通过Ollama API提供了一个友好的用户界面,大大简化了与这些模型交互的过程。

主要特性

-

简洁直观的界面: Ollama GUI提供了一个清晰、易用的Web界面,让用户可以轻松地与本地部署的LLM进行对话。

-

多模型支持: 用户可以通过Ollama GUI与多种不同的语言模型进行交互,包括Mistral、Llama 2、CodeLlama等热门模型。

-

本地运行: 所有的对话和数据处理都在本地进行,保证了用户数据的隐私和安全。

-

Docker支持: 提供了Docker部署方案,方便用户快速搭建和使用。

-

开源免费: Ollama GUI采用MIT许可证,完全开源免费,用户可以自由使用和定制。

安装使用

前提条件

在开始使用Ollama GUI之前,您需要:

- 安装Ollama CLI

- 安装yarn和node

快速开始

- 克隆仓库并启动开发服务器:

git clone https://github.com/HelgeSverre/ollama-gui.git

cd ollama-gui

yarn install

yarn dev

- 或者使用托管的Web版本,通过以下命令运行Ollama:

OLLAMA_ORIGINS=https://ollama-gui.vercel.app ollama serve

Docker部署

Ollama GUI也支持使用Docker进行部署:

git clone https://github.com/HelgeSverre/ollama-gui.git

cd ollama-gui

- 构建Docker镜像:

docker build -t ollama-gui .

- 运行Docker容器:

docker run -p 8080:8080 ollama-gui

- 在浏览器中访问

http://localhost:8080即可使用Ollama GUI

支持的模型

Ollama GUI支持多种流行的大型语言模型,以下是部分可用模型列表:

- Mixtral-8x7B Large (7B参数, 26GB)

- Phi (2.7B参数, 1.6GB)

- Solar (10.7B参数, 6.1GB)

- Dolphin Mixtral (7B参数, 4.1GB)

- Mistral (7B参数, 4.1GB)

- Llama 2 (7B参数, 3.8GB)

- CodeLlama (7B参数, 3.8GB)

- Vicuna (7B参数, 3.8GB)

用户可以通过简单的命令如ollama pull mistral来下载和使用这些模型。

未来规划

Ollama GUI的开发团队有着雄心勃勃的计划,以下是一些待实现的功能:

- 改进聊天消息中的换行格式

- 使用IndexedDB在本地存储聊天历史

- 代码优化和重构

- 添加Markdown解析功能

- 支持浏览和安装可用模型

- 提升移动端响应式设计

- 添加文件上传和OCR功能

技术栈

Ollama GUI采用了现代化的Web开发技术栈:

- Ollama.ai - 模型CLI工具

- LangUI - UI组件库

- Vue.js - 前端框架

- Vite - 构建工具

- Tailwind CSS - CSS框架

- VueUse - Vue Composition API工具集

- @tabler/icons-vue - 图标库

结语

Ollama GUI为本地大型语言模型的使用提供了一个简单而强大的解决方案。它不仅让普通用户能够轻松与先进的AI模型进行交互,也为开发者和研究人员提供了一个便捷的测试和实验平台。随着项目的不断发展和完善,我们可以期待Ollama GUI在未来带来更多令人兴奋的功能和改进。

无论您是AI爱好者、研究人员还是开发者,Ollama GUI都值得一试。它不仅能帮助您探索大型语言模型的潜力,还能激发您对AI应用的更多想象。现在就开始使用Ollama GUI,体验本地AI的无限可能吧!

参与贡献

Ollama GUI是一个开源项目,欢迎社区成员参与贡献。无论是提交bug报告、功能建议,还是直接提交代码,您的每一份贡献都将帮助Ollama GUI变得更好。如果您对项目感兴趣,可以前往GitHub仓库了解更多信息。

让我们共同努力,为本地大型语言模型的应用开辟新的可能性!

项目链接:www.dongaigc.com/a/ollama-gui-local-language-model

https://www.dongaigc.com/a/ollama-gui-local-language-model

575

575

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?