我们在日常生活中,经常需要将视频声音转换为文字。这可能包括听取会议记录、完成听写任务或翻译视频内容等工作。但是,对于大多数人来说,这些任务并不容易完成。手动录入文字可能需要花费数小时甚至数天的时间,同时还存在一些误差和不准确性。为了解决这个问题,我们可以使用一些视频转文字工具,帮助我们快速将视频声音转换为文字格式。不过大家是否知道视频声音转文字的软件有哪些呢?不懂的话跟着我一起往下看吧!

视频声音转文字的软件一:网易见外工作台

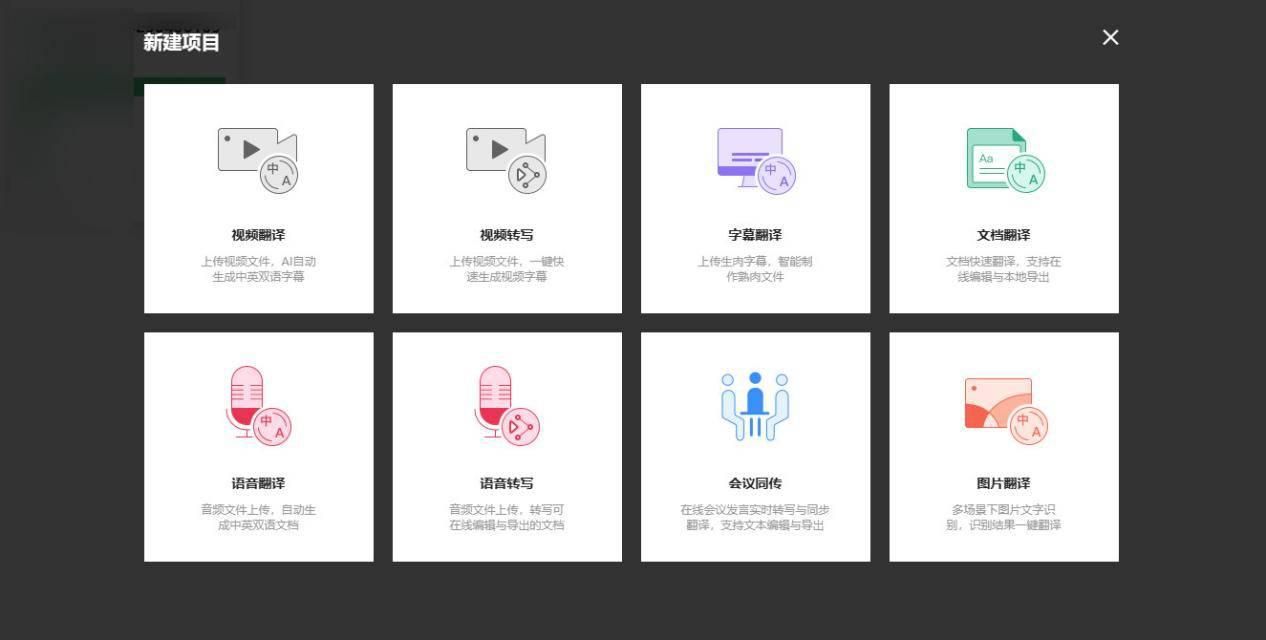

它就像是一把神奇钥匙,可以打开许多门,解决许多问题。也可以比喻为一间大型书房,里面有丰富的资料和工具,可以帮助我们快速地查找信息并进行各种创意思考和撰写工作。此外,它还像是一位随时待命的私人秘书,可以协助我们管理日程、安排会议、和同事进行即时沟通。网易见外工作台是一款功能齐全、实用便捷的工作平台,能够有效提升工作效率,让我们更加轻松地应对各种工作挑战。

视频声音转文字的软件二:

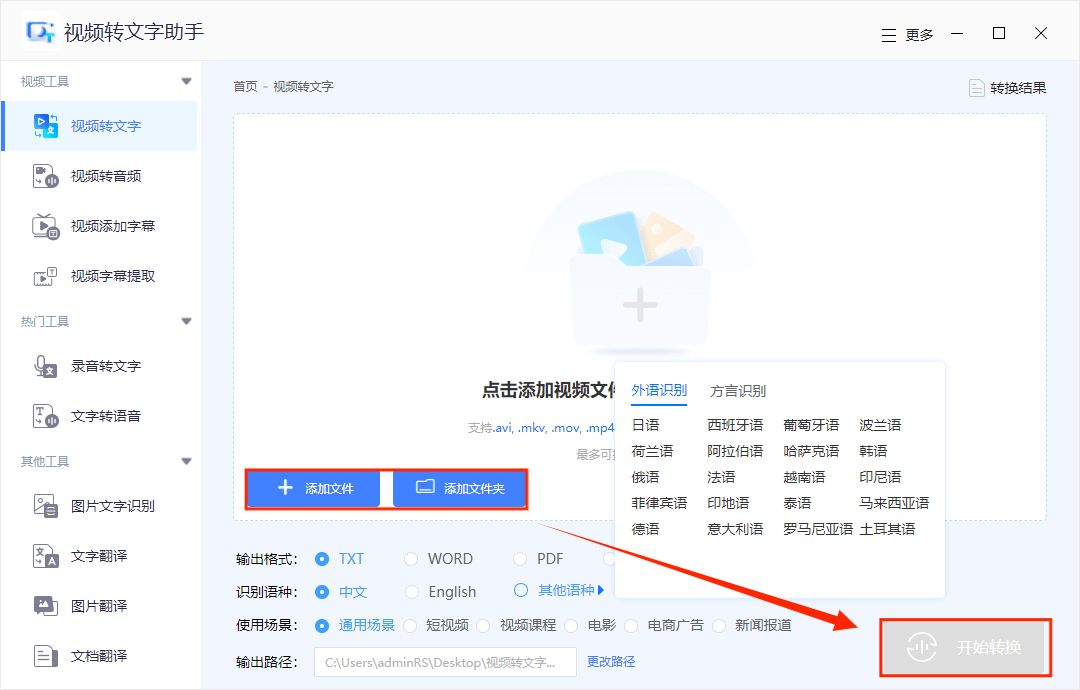

想象一下,当你需要将一段视频中的对话内容转换为文字时,就像是在海边捡拾贝壳,需要费尽功夫,耗费很长时间而且还可能出现错误。但是,如果你有一个“视频转文字助手”,就好比是拥有了一个能准确收集并分类的助手。这个助手可以快速地将视频中的语音转换为文字格式,省去了手动录入文字的麻烦,让你能够更好地处理任务。

这个软件内置了智能语音识别技术,可以自动分离出视频中的音频部分,并将其转换为可编辑的文本格式。同时,该助手还支持多种语言和自定义设置,让你可以根据实际需求来选择合适的配置选项。此外,该工具还提供了文件导出功能,让你可以方便地保存、编辑和分享转换后的文本内容。

视频声音转文字的软件三:搜狗输入法

搜狗输入法好比是一位聪明绝顶的学霸,可以帮助我们快速、准确地处理各种语言输入问题。这个软件能够迅速分析和识别我们所需输入的文字,并为我们提供多种选项和建议。它也像一位语言专家,掌握了多种语言的规则和特点,能够对我们输入的内容进行智能纠错和优化。同时还为我们提供了许多实用的功能,如表情包、斗图等,让我们在输入过程中感受到更多的乐趣。

读完文章的你想必已经知道视频声音转文字的软件有哪些了,如果觉得以上的软件适合你,那就赶紧行动起来试试看吧!

221

221

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?