-

FusionGAN

-

一种用于红外和可见光图像融合的生成对抗性网络

-

出版社:ELSEVIER

-

期刊名:Information Fusion(一区TOP)

-

影响因子:18.6

-

论文网址:https://www.sciencedirect.com/science/article/abs/pii/S1566253518301143

-

-

-

-

-

摘 要

-

红外图像可以根据热辐射的差异将目标与其背景区分开来,这在所有白天/晚上和所有天气条件下都能很好地工作。相比之下,可见图像可以以与人类视觉系统一致的方式提供具有高空间分辨率和清晰度的纹理细节。本文提出了一种新的方法,使用生成对抗性网络融合这两种类型的信息,称为FusionGAN。我们的方法在生成器和判别器之间建立了对抗性游戏,其中生成器旨在生成具有主要红外强度和额外可见梯度的融合图像,判别器旨在迫使融合图像具有可见图像中存在的更多细节。这使得最终融合的图像能够同时保持红外图像中的热辐射和可见图像中的纹理。此外,我们的FusionGAN是一个端到端模型,避免了像传统方法那样手动设计复杂的活动水平测量和融合规则。在公共数据集上的实验证明了我们的策略优于现有技术,在现有技术中,我们的结果看起来像锐化的红外图像,目标清晰突出,细节丰富。此外,我们还将FusionGAN推广到融合不同分辨率的图像,例如低分辨率红外图像和高分辨率可见光图像。大量的结果表明,我们的策略可以生成清晰干净的融合图像,而不会受到红外信息上采样引起的噪声的影响。

-

简单来说,就是马佳义大佬将GAN融入进图像融合的首创大作!第一次用GAN做端到端的融合,融合了红外图像中的热辐射信息和可见光图像中的纹理信息。

-

-

-

引 言

-

红外和可见光图像等多传感器数据已被用于增强人类视觉感知、物体检测和目标识别领域。 红外图像捕获热辐射,而可见光图像捕获反射光。 两种图像可以提供来自不同方面的具有互补性质的场景信息,并且它们也是几乎所有对象所固有的。

-

目前不同的方案的图像融合问题,包括多尺度变换、稀疏表示、神经网络、子空间和基于显著性的方法、混合模型和其他方法。

-

融合框架涉及三个关键组件,包括图像转换、活动水平测量(activity level measurement,这里说一下这个单词不知道翻译的准不准确,但好像很多论文出现的频率很高并很多论文都写它比较重要,暂时先这样翻译,虽然听起来很怪)和融合规则设计。

-

论文提出了一种基于生成对抗性网络(FusionGAN)的红外和可见光图像融合方法,该方法将融合表述为保留红外热辐射信息和保留可见光外观纹理信息之间的对抗性博弈。更具体地说,它可以被视为生成器和判别器之间的极大极小问题。生成器试图生成具有主要红外强度和附加可见梯度的融合图像,而判别器旨在强制融合图像以具有更多纹理细节。这使得我们的融合图像能够同时保持红外图像中的热辐射和可见图像中的纹理细节。此外,生成对抗性网络的端到端特性可以避免手动设计复杂的活动水平测量和融合规则。(在这里,由于论文在判别器的地方只对比了可见光梯度信息,所以在对抗博弈的过程中只能不断地增强细节纹理信息,对于红外的辐射信息只能由生成器在输入的时候输入一次,这里后期可以考虑改进。但大概率已经被改进了哈哈哈。)

-

图1 图像融合示意图。从左到右:红外图像、可见光图像、经典方法融合以及FusionGAN融合

图1 图像融合示意图。从左到右:红外图像、可见光图像、经典方法融合以及FusionGAN融合-

论文工作的主要贡献在于以下四个方面。1.提出了一种生成对抗性架构,并设计了一个专门用于红外和可见光图像融合的损失函数。首次采用GAN来处理图像融合任务。2.FusionGAN是一个端到端模型,无需手动设计活动水平测量或融合规则。3.在红外和可见光图像融合公共数据集上进行实验,并与最先进的方法进行定性和定量比较。4.FusionGAN推广到融合不同分辨率的源图像。

-

-

-

-

-

-

-

相关工作

-

相关工作主要讲了传统的红外与可见光融合方法、基于深度学习的融合方法以及GAN的原理和发展史。

-

传统的红外与可见光融合方法

-

简单地分为七类,包括多尺度变换、稀疏表示、神经网络、子空间和基于显著性的方法、混合模型和其他方法。

-

-

基于深度学习的图像融合

-

通常依赖于CNN模型(听起来很有道理,毕竟你是第一个提出用GAN融合的。哈哈哈。)

-

现有的红外和可见光图像融合技术并不是学习需要真实融合图像的端到端模型,而是学习一个深度模型来确定源图像中每个patch的模糊程度,然后相应地计算权重图来生成最终的融合图像。(别的大家自己看看就行了。主要是这里有一句听起来很高深还很有道理的样子的话,但我没想明白是什么意思哈哈哈,没发出来让大家来讨论一下,顺便指导一下我)

-

-

-

生成对抗性网络及其变体

-

GAN是一种通过对抗性过程估计生成模型的流行框架,深度卷积GAN(DCGAN)成功地将一类CNN引入到GAN中,而最小二乘生成对抗性网络(LSGAN)克服了规则GAN中的消失梯度问题,在学习过程中更稳定。接下来,我们将简要介绍上述三种相关技术。(由于博主本人倾向于后面可能会用GAN的框架,所以这里想详细的看一下,采用CNN的同学们就可以略过2.3这一段了.)

-

GAN

-

GAN框架由两个对抗性模型组成:生成模型G和判别模型D。生成模型G可以捕获数据分布,判别模型D可以估计样本来自训练数据而不是G的概率。更具体地说,GAN在判别器和生成器之间建立对抗性游戏,生成器将先验分布为Pz的噪声作为输入,并试图生成不同的样本来欺骗判别器,判别器旨在确定样本是来自模型分布还是来自数据分布,最后,生成器生成判别器不能区分的样本。

-

在数学上,生成模型G旨在生成样本,其分布(P G)试图近似于真实的训练数据的分布(P数据),G和D玩极小极大两人游戏如下:公式(1)。然而,PG不能被明确地表示,并且在训练过程中D必须与G很好地同步。因此,常规GANs是不稳定的,并且很难通过常规GANs来训练好的模型。(问题来了,说实话,第一次看这个公式的我是一头雾水哈哈哈。但是怎么能放弃呢,我去查一下哈哈哈。)

-

来一起看一下gpt是这么说的。基本上就是x为真实值,z是生成器的输入,G(z)是生成器的输出,D(G(z))是判别器对G(z)的输出,D(x)是判别器对真实值的输出,按照网络框架的逻辑,应该是对比D(x)和D(G(z))的误差,然后送回生成器重新一轮的训练。直到判别器不能区分D(x)和D(G(z)),然后输出D(G(z))。

来一起看一下gpt是这么说的。基本上就是x为真实值,z是生成器的输入,G(z)是生成器的输出,D(G(z))是判别器对G(z)的输出,D(x)是判别器对真实值的输出,按照网络框架的逻辑,应该是对比D(x)和D(G(z))的误差,然后送回生成器重新一轮的训练。直到判别器不能区分D(x)和D(G(z)),然后输出D(G(z))。

-

-

-

-

DCGAN

-

深度卷积GANs(DCGANs)技术最早由Radrord等人提出。DCGANs首先成功引入了CNNs,它可以弥合用于监督学习的CNNs和用于无监督学习的GANs之间的差距。由于传统的GANs是不稳定的,无法训练出一个好的模型,因此应该适当地设计CNNs的架构,使传统的Gan更稳定,与传统的CNNs相比主要有五个区别。首先,在生成器和判别器中都不使用池化层。相反,跨步卷积被应用于判别器中以学习其自身的空间下采样,而分数跨步卷积则被用于生成器中以实现上采样。其次,在生成器和判别器中都引入了批归一化层。由于糟糕的初始化总是会产生很多训练问题,因此批归一化层能够解决这些问题,并避免在更深的模型中消失梯度。第三,在更深的模型中删除了全连接层。第四,生成器中除最后一个激活层外的所有激活层都是整流线性单元(ReLU),最后一层是tanh激活。最后但并非最不重要的是,判别器中的所有激活层都是leaky ReLU激活。因此,训练过程变得更加稳定,并且可以提高生成结果的质量。(叽里呱啦一大堆,一句话也没听懂,没关系哈哈哈,不会的词我去gpt查一下)

-

跨步卷积

-

跨步卷积(strided convolution)是卷积神经网络中的一种操作,它与常规卷积的区别在于,在进行卷积操作时,卷积核(filter)的步长(stride)大于1。

-

-

分数跨步卷积

-

分数跨步卷积(Fractionally-Strided Convolution),也称为转置卷积(Transposed Convolution)或反卷积(Deconvolution),是一种常用于上采样或反卷积操作的技术。与常规的跨步卷积相反,分数跨步卷积将输入扩大到更大的尺寸,通常用于生成模型中的上采样过程。

-

分数步幅(Fractional Stride): 在分数跨步卷积中,步幅被设置为小于1的分数值,通常为小数。这意味着在卷积核的滑动过程中,会在输入特征图之间插入一些间隔,以实现输出特征图的尺寸扩大。

-

上采样: 分数跨步卷积常用于上采样操作,通过在输入特征图之间插入一些零值或插值操作,将输入特征图的尺寸扩大到更大的尺寸。这样可以恢复原始图像或特征图的尺寸,从而实现图像的放大或特征的上采样。

-

分数跨步卷积也可以被看作是常规卷积的逆操作,因此有时也称为反卷积。它可以用于解码器(Decoder)中,将编码器(Encoder)中的低维特征映射恢复到原始输入的高维空间。

-

-

-

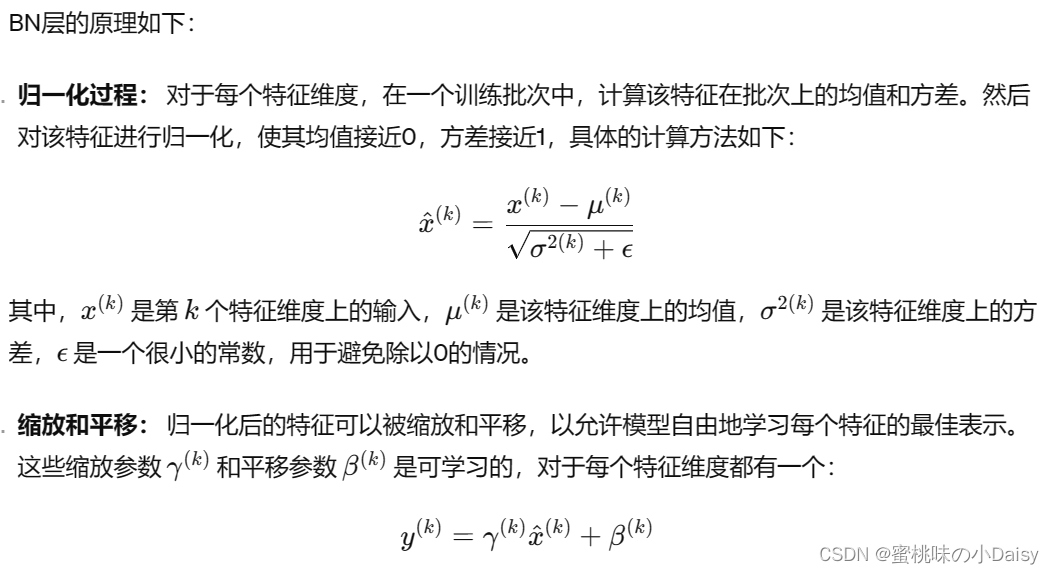

批归一化层(BN层) 亦或是批处理规范化层

-

它在每个训练批次中,对每个特征维度进行归一化处理,使得每个特征的均值接近0,方差接近1。这样可以避免梯度消失或梯度爆炸问题,并且加速了网络的训练过程。

-

-

训练和推理时的不同: 在训练过程中,BN层会根据每个批次的数据计算均值和方差,并用于归一化。但在推理(预测)阶段,由于没有批次数据,通常使用之前训练过程中得到的整个数据集的均值和方差来进行归一化,或者使用移动平均来估计。 BN层通过减少内部协变量转移(Internal Covariate Shift)来稳定网络的训练过程,加速了模型的收敛速度,并提高了模型的泛化能力。因此,它被广泛应用于深度学习模型中的卷积神经网络、循环神经网络等架构中。

-

-

-

-

全连接层

-

全连接层的每一个结点都与上一层的所有结点相连,用来把前边提取到的特征综合起来。由于其全相连的特性,一般全连接层的参数也是最多的。在卷积神经网络的最后,往往会出现一两层全连接层,全连接一般会把卷积输出的二维特征图转化成一维的一个向量。

-

-

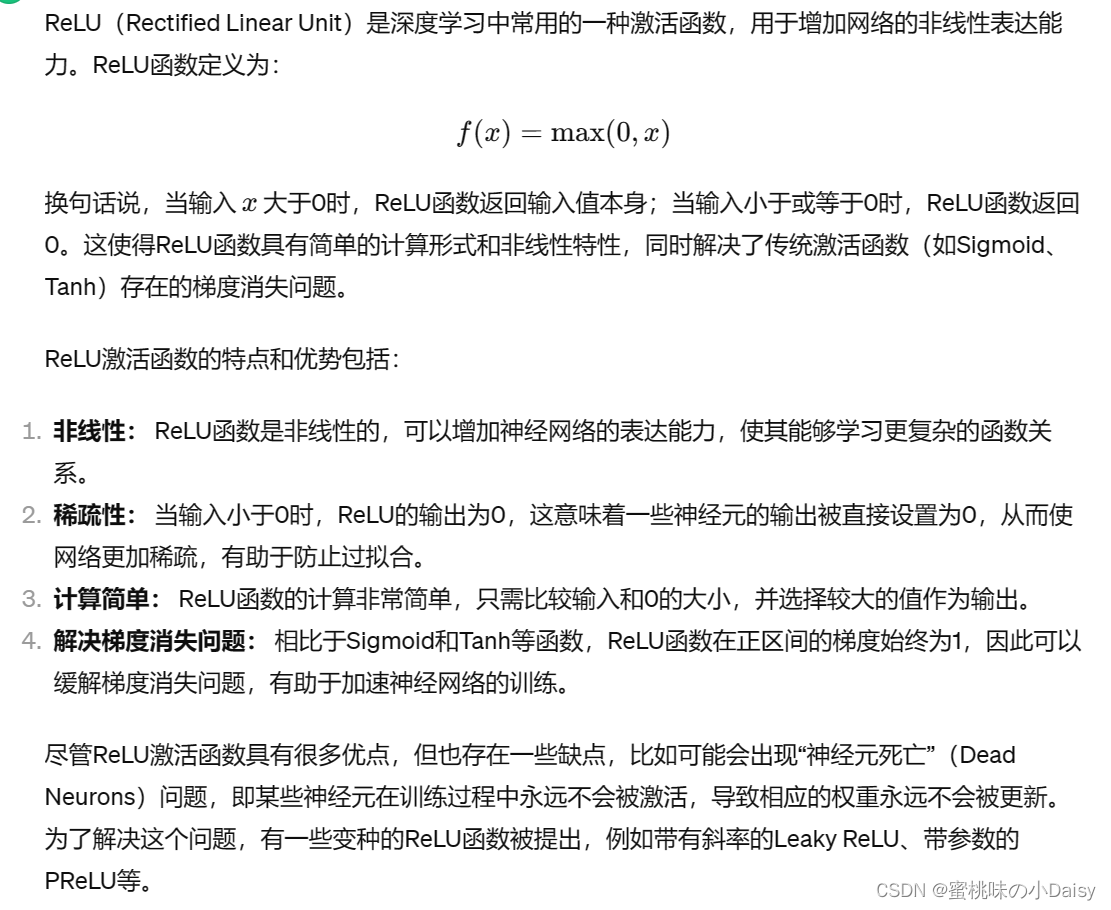

ReLU激活函数

-

-

自己跑了个relu示意图

自己跑了个relu示意图

-

-

-

tanh激活函数

-

-

tanh激活函数示意图

tanh激活函数示意图

-

-

-

leaky ReLU 激活函数

-

-

leaky relu激活函数示意图(这里的α我设置的是0.1,我看一般都用0.01。但是因为0.01出的图左边的斜率不是很明显,我设置0.1只是给大家看一下示意图。博主这个活真不好干,还得写代码跑函数曲线图哈哈哈)

leaky relu激活函数示意图(这里的α我设置的是0.1,我看一般都用0.01。但是因为0.01出的图左边的斜率不是很明显,我设置0.1只是给大家看一下示意图。博主这个活真不好干,还得写代码跑函数曲线图哈哈哈)

-

-

-

-

-

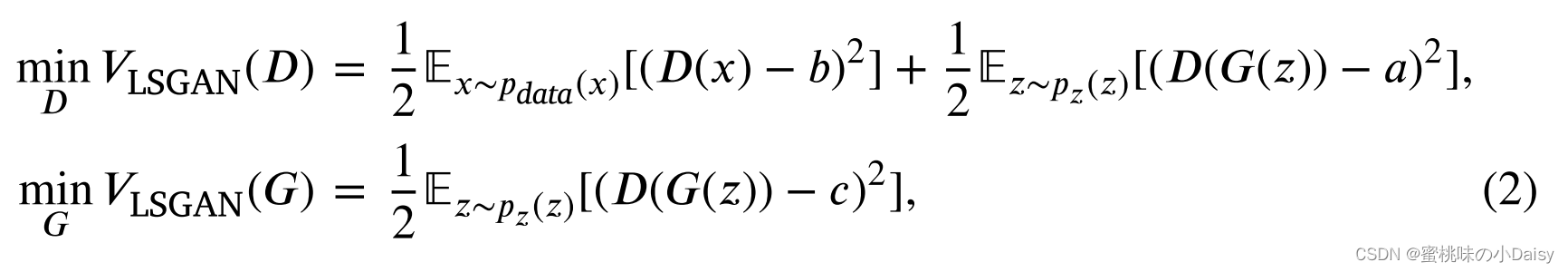

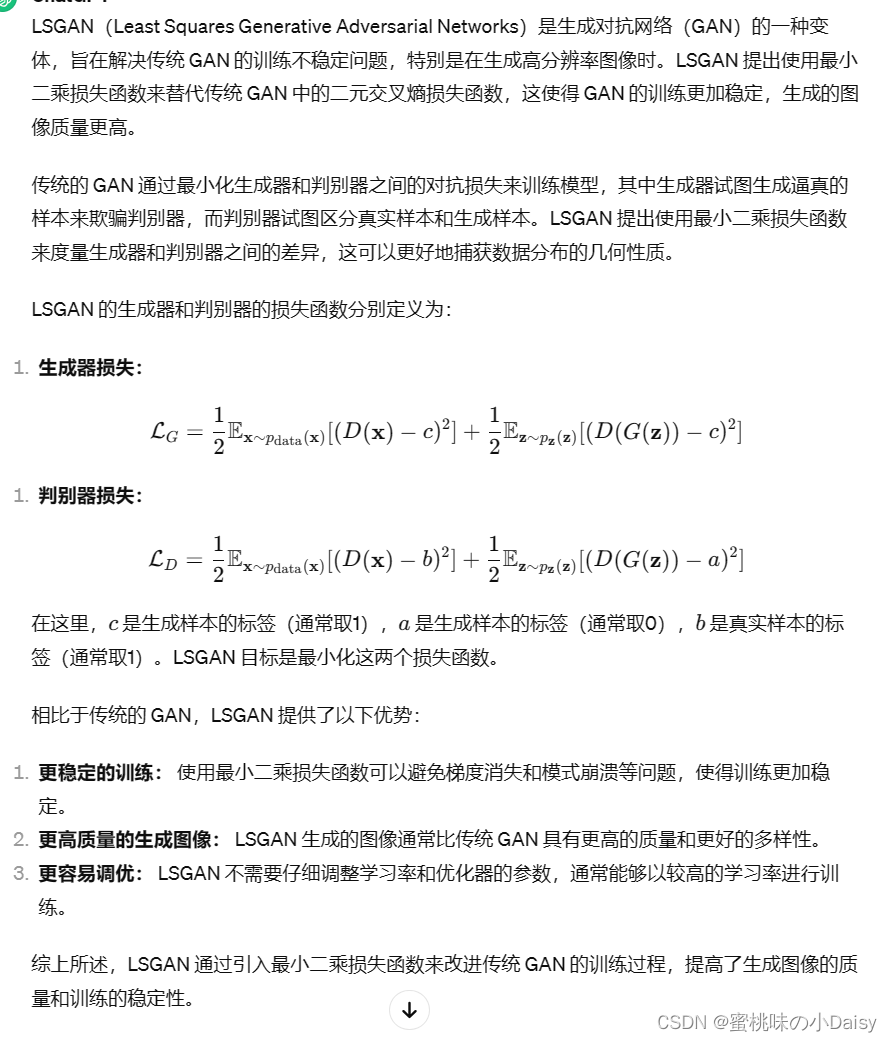

LSGAN

-

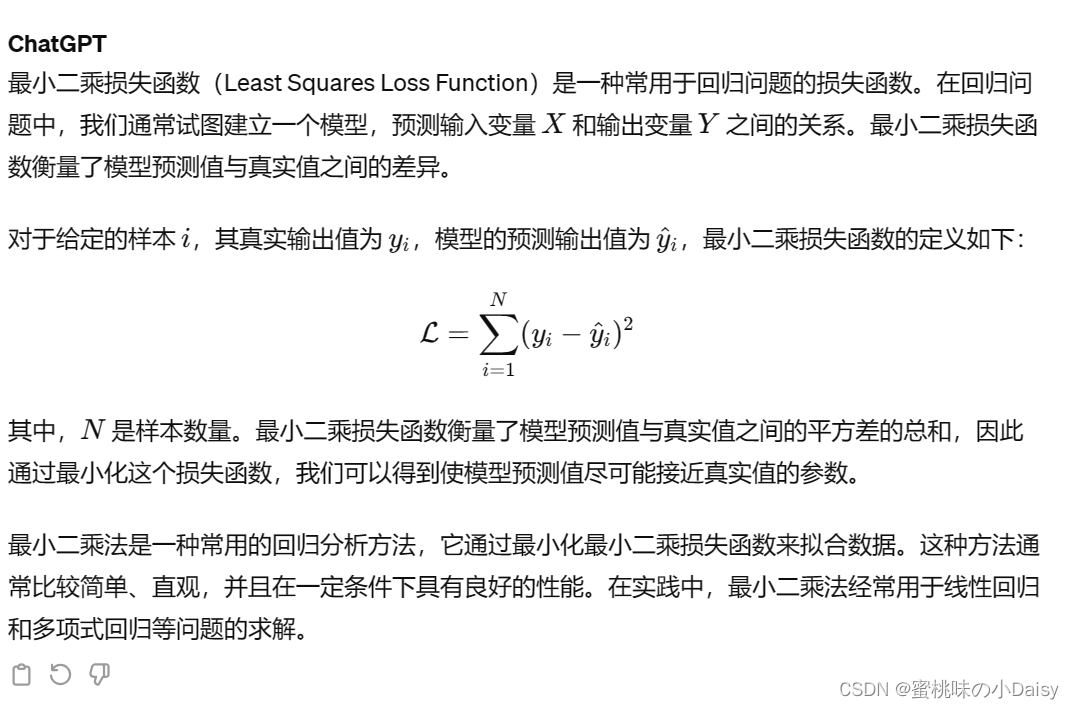

尽管GANs已经取得了巨大的成功,但仍有两个关键问题需要解决。首先是如何提高生成图像的质量。近年来,已经提出了许多工作来解决这个问题,例如DCGAN。二是如何提高训练过程的稳定性。已经提出了许多工作来通过探索GANs的目标函数来处理这个问题,例如Wasserstein GANs(WGANs),其收敛速度比常规GANs慢得多。此外,正则GANs采用S形交叉熵损失函数作为判别器,这可能导致学习过程中的梯度消失问题。为了克服上述两个问题,Mao等人提出了最小二乘生成对抗性网络(LSGAN),该网络采用最小二乘损失函数作为判别器,LSGAN的目标函数定义如公式(2),其中编码方案用于判别器和生成器,a和b分别表示伪数据和真实数据的标签,c表示生成器希望判别器相信的伪数据的值。 有两种方法可以确定公式2中方程的a、b和c的值。第一个是设置b−c=1和b−a=2,从而公式(2)产生的最小皮尔逊系数介于Pdata+Pg和Pg之间。第二个是设置c=b,这可以使生成器生成的样本尽可能真实。上面提到的两种方法通常获得相似的性能。 在LSGAN中,对距离决策边界很远的样本进行惩罚,使生成器生成的样本接近决策边界,并生成更多的梯度。因此,LSGAN与常规GAN相比具有两个优势。一方面,LSGANs可以生成比常规GANs更高质量的图像。另一方面,LSGANs在训练过程中比常规GANs表现得更稳定。

-

-

-

WGAN

-

WGAN(Wasserstein Generative Adversarial Networks)是生成对抗网络(GAN)的一种变体,其主要目标是解决传统 GAN 中的训练不稳定问题,并提供更加稳定的梯度更新和更高质量的生成图像。 WGAN 最重要的特点之一是使用了 Wasserstein 距离(Wasserstein distance)作为生成器和判别器之间的损失函数,而不是传统 GAN 中的 Jenson-Shannon 散度或 Kullback-Leibler 散度。Wasserstein 距离衡量了两个概率分布之间的差异,通常用来衡量生成器生成的图像分布与真实数据分布之间的距离。

-

-

RGAN(正则化GAN)

-

这里还有好多名词看不懂,博主表示知识延伸只能到这了,再往下没头了。哈哈哈以后再慢慢学习。

这里还有好多名词看不懂,博主表示知识延伸只能到这了,再往下没头了。哈哈哈以后再慢慢学习。

-

-

-

-

-

-

-

-

-

方 法

-

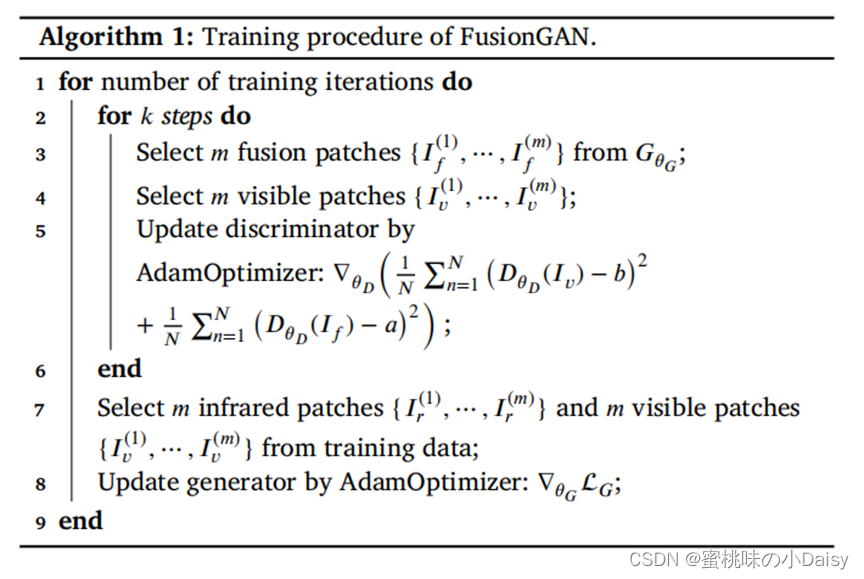

我们将红外和可见光图像融合问题表述为对抗性问题,如图2(a)所示。一开始,我们在通道维度上连接红外图像IR和可见图像IV。然后,将连接的图像馈送到生成器中GθG ,并且输出的GθG是融合图像If。由于本文中设计的生成器的损失函数(稍后解释),没有判别器DθD ,IF倾向于保持红外图像IR的热辐射信息,并保持可见图像IV的梯度信息。之后,我们将融合的图像If和可见图像Iv输入到判别器DθD中 ,其目的在于区分If和Iv。提出的FusionGAN在生成器之间建立了一个对抗性游戏生成器GθG和判别器DθD,,并且If将逐渐在可见图像Iv中包含越来越多的细节信息。在训练阶段,一旦生成器GθG生成判别器DθD,无法区分的样本(即If) ,我们便获得了期望的融合图像If。测试过程如图2(b)所示,我们只将If和Iv的级联图像输入到经过训练的生成器GθG中 ,并且输出GθG是我们的最终融合结果。

-

(好的,现在我们来中翻中一下哈哈哈。)就是使用GAN进行红外与可见光融合时,先将Ir和Iv进行通道拼接,然后送入生成器得到初始If,将If送入判别器与Iv对比,得到的损失函数指导生成器重新生成If,不断强化细节纹理,直到区分不出来得到最后的If。

-

-

-

网络框架

-

图2 提出的用于红外和可见光图像融合的FusionGAN的框架(这个图可太经典了哈哈哈)

图2 提出的用于红外和可见光图像融合的FusionGAN的框架(这个图可太经典了哈哈哈)-

生成器框架

-

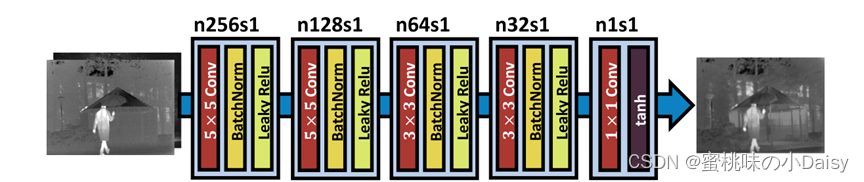

图3 生成器网络架构GθG,GθG是一个简单的五层卷积神经网络,具有5个卷积层、4个批量归一化层、4层leaky ReLU激活层和1个tanh激活层。

图3 生成器网络架构GθG,GθG是一个简单的五层卷积神经网络,具有5个卷积层、4个批量归一化层、4层leaky ReLU激活层和1个tanh激活层。-

生成器网络架构GθG是一个简单的五层卷积神经网络,其中在第一层和第二层使用5×5卷积核,在第三层和第四层使用3×3卷积核,在最后一层使用1×1卷积核。每层中的步幅都设置为1,并且卷积中没有填充操作。我们的生成器的输入是一个没有噪声的级联图像。为了提高生成图像的多样性,许多工作通常通过卷积层提取输入图像的特征图,然后通过转置卷积层将图像重建到与输入图像相同的大小。对于红外和可见光图像融合,每个下采样过程都会丢失源图像中的一些细节信息,这对融合很重要。因此,我们只引入卷积层,而不进行下采样。这也可以保持输入和输出的大小相同,因此,在我们的网络中不需要转置卷积层。此外,为了避免梯度消失的问题,我们遵循深度卷积GAN的规则进行批量归一化和激活函数。为了克服对数据初始化的敏感性,我们在前四层采用了批量归一化,批量归一化层可以使我们的模型更加稳定,也可以帮助梯度有效地反向传播到每一层。对于激活函数,我们在前四层使用leaky ReLU激活函数,在最后一层使用tanh激活函数。

-

-

-

判别器框架

-

图4 判别器的网络架构DθD, DθD是一个简单的五层卷积神经网络,具有4个卷积层来提取输入的特征图,1个线性层来进行分类,4个批量归一化层和4个leaky ReLU激活层。

图4 判别器的网络架构DθD, DθD是一个简单的五层卷积神经网络,具有4个卷积层来提取输入的特征图,1个线性层来进行分类,4个批量归一化层和4个leaky ReLU激活层。-

判别器网络架构DθD是一个简单的五层卷积神经网络,如图4所示。从第一层到第四层,我们在卷积层中使用3×3卷积核,并在没有填充的情况下将步幅设置为2。这与生成器网络不同。根本原因是判别器是一个分类器,它首先从输入图像中提取特征图,然后对其进行分类。因此,它的工作方式与池化层相同,将步幅设置为2。为了不在我们的模型中引入噪声,我们只对第一层的输入图像进行填充操作,其余三个卷积层不进行填充。从第二层到第四层,我们使用批归一化层。此外,我们在前四层中使用leaky ReLU激活函数。最后一层是线性层,主要用于分类。

-

-

-

-

-

损失函数

-

生成器损失函数

-

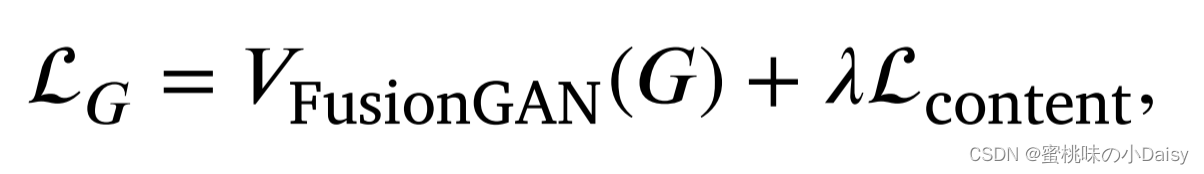

LG表示总损失,第一项V FusionGAN(G)表示生成器GθG和判别器之间的对抗性损失。λ控制V FusionGAN(G)和Lcontent的平衡。Lcontent表示内容损失,红外图像的热辐射信息由其像素强度表征,可见图像的纹理细节信息可以部分由其梯度表征。我们强制融合图像If具有与Ir相似的强度和与Iv相似的梯度。

LG表示总损失,第一项V FusionGAN(G)表示生成器GθG和判别器之间的对抗性损失。λ控制V FusionGAN(G)和Lcontent的平衡。Lcontent表示内容损失,红外图像的热辐射信息由其像素强度表征,可见图像的纹理细节信息可以部分由其梯度表征。我们强制融合图像If具有与Ir相似的强度和与Iv相似的梯度。-

Ifn表示融合图像n∈ NN(N为自然数集合,即表示从0到N的整数),并且N表示融合图像的数量,c是生成器希望判别器相信的伪数据的值。

Ifn表示融合图像n∈ NN(N为自然数集合,即表示从0到N的整数),并且N表示融合图像的数量,c是生成器希望判别器相信的伪数据的值。 -

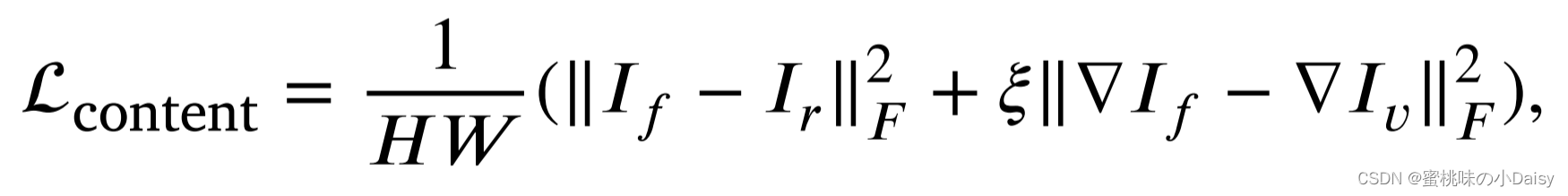

其中,H和W分别表示输入图像的高度和宽度,其中,‖ ∙ ‖F表示矩阵弗罗贝尼乌斯范数 ,而▽表示梯度算子。Lcontent的第一部分,内容旨在保持融合图像If中红外图像Ir的热辐射信息,第二部分旨在保留可见图像Iv中包含的梯度信息,以及ξ是一个控制两项之间权衡的正参数。

其中,H和W分别表示输入图像的高度和宽度,其中,‖ ∙ ‖F表示矩阵弗罗贝尼乌斯范数 ,而▽表示梯度算子。Lcontent的第一部分,内容旨在保持融合图像If中红外图像Ir的热辐射信息,第二部分旨在保留可见图像Iv中包含的梯度信息,以及ξ是一个控制两项之间权衡的正参数。-

这里又查了一下弗罗贝尼乌斯范数 ,好家伙原来就是欧几里得范数。

-

-

-

-

判别器损失函数

-

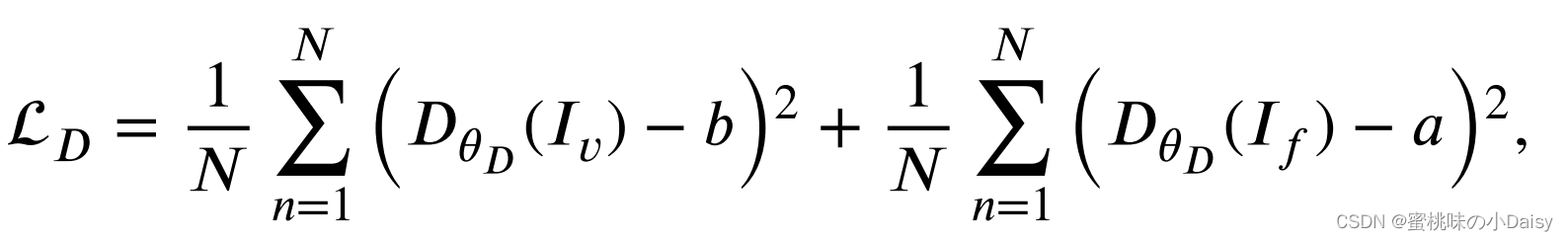

目前的IF已经具有红外的热辐射信息和可见光梯度信息,但仅使用梯度信息无法完全表示可见图像中的纹理细节(后面在实验中验证这一问题)。因此,在生成器之间建立了一个对抗性游戏GθG 和判别器DθD以基于可见图像Iv来调整融合图像If。这使If包含更多纹理细节。判别器DθD的损失函数定义如下:

-

其中a和b分别表示融合图像If和可见图像Iv的标签,DθD (Iv)和DθD (If )分别表示可见图像和融合图像的分类结果。判别器被设计为基于从融合图像中提取的特征来将融合图像与可见图像区分开来。我们使用最小二乘损失函数,它服从最小化皮尔逊卡方散度。它使训练过程更加稳定,使判别器的损失函数快速收敛。(这里又查了一下最小二乘损失和皮尔逊卡方散度,大家简单看看。)

-

-

-

-

-

实验

-

具体的实验内容和结果大家可以一步到论文看看啦,感谢陪伴!

-

论文对比了自己和8种传统融合方法: 1.自适应稀疏表示(ASR)、 2.曲线变换(CVT)、 3.双树复小波变换(DTCWT)、 4.四阶偏微分方程(FPDE)、 5.基于引导滤波的融合(GFF)、 6.低通金字塔比(LPP)、 7.基于视觉显著性的两尺度图像融合(TSIFVS)、 8.梯度转移融合(GTF)

-

用了六个指标来定量评估融合方法的性能

-

熵(EN)

-

-

标准差(SD)

-

-

结构相似性指数测度(SSIM)

-

-

相关系数(CC)

-

-

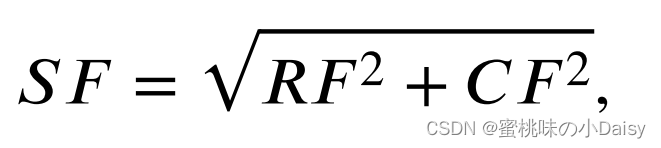

空间频率(SF)

-

-

RF =

-

-

-

-

视觉信息保真度(VIF)

-

-

使用数据集

-

TNO

-

INO

-

-

-

-

结论

-

在本文中,我们提出了一种新的基于生成对抗性网络的红外和可见光图像融合方法。它可以同时保持红外图像中的热辐射信息和可见光图像中的纹理细节信息。所提出的FusionGAN是一个端到端的模型,可以避免像传统的融合策略那样手动设计复杂的活动水平测量和融合规则。在公共数据集上的实验表明,我们的融合结果看起来像锐化的红外图像,具有清晰突出的目标和丰富的细节信息,这有利于基于图像融合的目标检测和识别系统。在四个评估指标上与八种现有技术进行的定量比较表明,我们的FusionGAN不仅可以产生更好的视觉效果,而且可以在源图像中保持最大或近似最大的信息量。

-

我们的FusionGAN是一个处理融合任务的通用框架,旨在将一个源图像中的像素强度与另一个源图中的纹理细节融合在一起。我们还推广了FusionGAN,以融合具有不同分辨率的源图像。在我们未来的工作中,我们将进一步应用我们的FusionGAN来解决遥感界众所周知的泛锐化问题,目标是融合低分辨率多光谱图像和高分辨率全色图像,以生成具有高空间分辨率的多光谱图像。

-

又是一篇论文解析完稿啦,完成每一项工作时都会有无比的成就感。

-

-

-

FusionGAN【读论文】

于 2024-03-06 21:44:22 首次发布

448

448

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?