最近在看关于Scene Text Erasing的论文,先在这挖一个坑,论文细节以后慢慢整理。

1 介绍

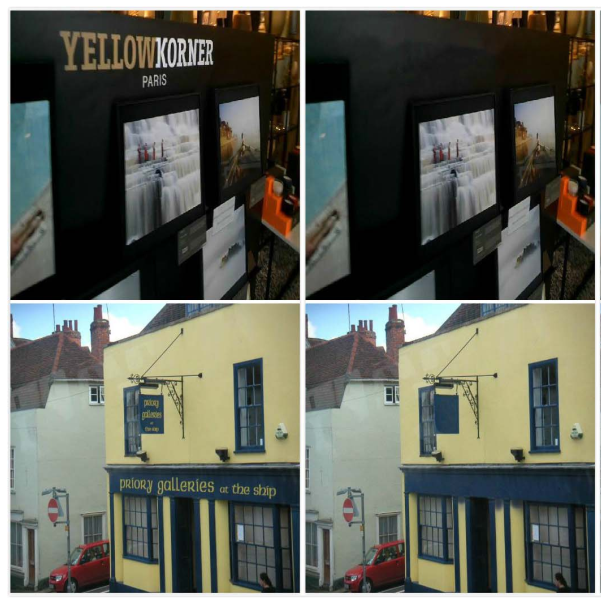

场景文字消除(Scene Text Erasing),顾名思义为消除自然场景的文字,输入是一张完整的带有文字的任意场景的图片,输出是一张抹除文字的图片。如下图。左列为输入,右列为输出。

不难想到,此问题可以分解为两个子任务:

-

找出对应的文字的位置(Text Detection)

-

对文字位置做擦除(Image Inpainting)

针对此问题,目前有两种解决方案:

-

构建一个End-to-End网络,将文字定位和文字擦除当成一个整体来做

-

分两步来做,将文字定位和文字擦除当成上下游任务。先解决文字定位,再将得到的文字位置信息作为先验知识和原图片一起输入到图像修复网络中

容易想到的是第二种方法,因为人们更容易想到的是把问题分成一个一个的小问题再逐个击破。而且在文字识别和图像修复两个领域,各自的方法众多,解决方案已经比较成熟。我个人认为第二种解决方案要比第一种效果更好且更容易优化。下面是两种方案的简单介绍。在介绍前,想一想我们的训练数据要包括什么?首先,带有文字的原图片和不带文字的ground truth是一定要有的。如果有标注文字位置的mask作为额外的监督信息是不是会更好的帮助网络知道哪里是文字。所以现在数据集分为两类,一种是有原图,有GT,有mask的数据集,比如SynthText, SCUT-EnsText;另一类为只有原图和GT,没有mask数据集,比如EnsNetset。

2 End-to-End

End-to-End翻译成端到端的,这么翻译可能不好理解。我举个简单的例子,在商场里包装好的食物,从生产加工运输销售,往往需要多个企业来共同协作,中间哪一个环节出现问题,都可能出现产品滞销。而一个End-to-End网络就好像一个全能的企业,从原料的生产加工到最后的销售都由这一个企业完成。所以往往意味着更高的执行效率。

[1],[2],[5],[6]是构建的End-to-End网络。

优点:

-

网络参数较少,执行效率高

-

训练集可以没有Text的mask

缺点:

-

会出现文字消除不全,因为网络没有很好学到文字的位置,如下图

-

网络的可解释性差,将文字检测和图像修复模块整合成一个网络缺少可解释性

-

无法指定修复区域,比如我想就消除一部分文字,End-to-End网络是做不到的

3 Two-stage

Two-stage的方法就很好理解了,把文字检测和图像修复当成上下游任务。先将原图输入到文字检测模块中,得到mask(mask是指文字位置的像素值为255,非文字区域的像素值为0),再将得到的文字位置信息的mask作为先验知识和原图片一起输入到图像修复网络中,得到消除后的图片。

[3],[4],[7],[8],[9]运用的是Two-stage方法。

优点:

-

可以利用现有的文字检测和图像修复数据集做预训练,即不需要原图和对应的无文字的图片成对出现

-

可解释性强,通过中间输出的mask,可以知道问题出在哪

缺点:

-

受限于文字检测模块,如果不能分割出好的mask,修复效果变差

-

模型更臃肿,效率较低

思考

其实这个任务的解决方案,不管是E2E还是2stage,现在的论文的模型都有缝合怪的感觉,把目前最新的,效果最好的文字检测模型和图像修复模型揉到一起。[5]是E2E目前最好的模型,[9]是2stage目前最好的模型,且[9]指标(目前的指标分为两种,一种是图像修复的指标(MSE,PSNR,SSMI),一种文字检测的指标(用EAST和CRAFT去做文字检测,看看能不能检测到文字,如果还能检测到文字,证明消除效果不好))超过了[5]。所以我之前也有提到,我认为2stage的方法在两种指标上会胜过E2E。因为现在有一个共识是说让单独做一件事A的CNN比做多件事(A,B,C)的CNN在A上效果好。我个人认为还能改进的方向有如下几点:

-

想办法提取更精确的MASK,目前修复网络消除效果不好的症结在于在上游文字检测任务中没有分割出精确地mask。但想解决这个任务,根本在于提高文字检测精度

-

选用更好的Inpainting网络来应用到此场景中

References

[1].T. Nakamura, A. Zhu, K. Yanai, and S. Uchida, “Scene text eraser,”in Proc. 14th IAPR Int. Conf. Document Anal. Recognit. (ICDAR), Nov. 2017, pp. 832–837.

[2].S. Zhang, Y. Liu, L. Jin, Y. Huang, and S. Lai, “Ensnet: Ensconce text in the wild,” in Proc. AAAI, vol. 33, 2019, pp. 801–808. (arXiv preprint arXiv:1812.00723, 2018)

[3].O. Tursun, R. Zeng, S. Denman, S. Sivapalan, S. Sridharan, and C. Fookes, “MTRNet: A generic scene text eraser,” in Proc. Int. Conf. Document Anal. Recognit. (ICDAR), Sep. 2019, pp. 39–44.

[4].Jan Zdenek, Hideki Nakayama, “Erasing Scene Text with Weak Supervision”, Proceedings of the IEEE/CVF Winter Conference on Applications of Computer Vision (WACV), 2020, pp. 2238-2246

[5].Liu C , Y Liu, Jin L , et al. EraseNet: End-to-End Text Removal in the Wild[J]. IEEE Transactions on Image ProcessingO. Tursun, S. Denman, R. Zeng, S. Sivapalan, S. Sridharan, and

[6].C. Fookes, “MTRNet++: One-stage mask-based scene text eraser,” Comput. Vis. Image Understand., vol. 201, Dec. 2020, Art. no. 103066., 2020, PP(99):1-1.

[7].Conrad B, Chen P I. Two-Stage Seamless Text Erasing On Real-World Scene Images[C]//2021 IEEE International Conference on Image Processing (ICIP). IEEE, 2021: 1309-1313.

[8].Tang Z, Miyazaki T, Sugaya Y, et al. Stroke-Based Scene Text Erasing Using Synthetic Data for Training[J]. IEEE Transactions on Image Processing, 2021, 30: 9306-9320.

[9].Cho J, Yun S, Han D, et al. Detecting and Removing Text in the Wild[J]. IEEE Access, 2021, 9: 123313-123323.

728

728

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?