一. tanh函数介绍

1. 函数表达式

tanh(双曲正切)函数是一种常用的激活函数,它是Sigmoid函数的变种。tanh函数将输入值映射到范围在-1到1之间的连续值。其数学表达式为:

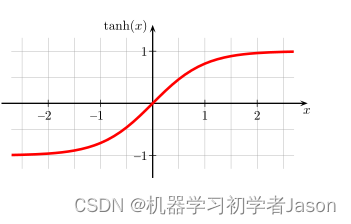

2. 函数图像

tanh函数的图像呈S形曲线,类似于Sigmoid函数,但tanh函数的输出范围是在-1到1之间。以下是tanh函数的图像示例:

二. tanh函数使用

tanh函数在神经网络中有许多应用场景,主要是作为隐藏层的激活函数。以下是一些常见的应用场景:

-

神经网络隐藏层的激活函数:在深度神经网络中,tanh函数通常被用作隐藏层的激活函数。它的输出范围在-1到1之间,相比于Sigmoid函数,在表示能力上更加强大,因为它的输出有零中心性质,有助于减少梯度消失问题。

-

特征缩放:tanh函数将输入数据映射到范围在-1到1之间,可以用于对输入数据进行标准化和特征缩放。这有助于加速神经网络的训练过程,提高模型的性能。

-

序列数据建模:在处理序列数据(如时间序列、自然语言文本等)时,tanh函数常被用于循环神经网络(RNN)的隐藏层,以捕捉序列数据之间的复杂关系。

-

图像处理:在某些图像处理任务中,tanh函数可以作为一种激活函数来帮助提取图像的特征和进行图像分类。

-

生成模型:在一些生成模型中,如生成对抗网络(GAN)中的生成器部分,tanh函数可以用于生成网络的输出层,将生成的图像像素值映射到合适的范围内。

tanh函数具有如下的优缺点:

优点:

-

零中心性质:tanh函数的输出范围在-1到1之间,具有零中心性质,即均值为0,这有助于减少梯度消失问题,使得神经网络的训练更加稳定和快速。

-

非线性特性:tanh函数是一种非线性函数,引入了非线性变换,使得神经网络能够学习和表示更复杂的非线性函数关系。

-

平滑性:tanh函数是光滑且连续的,在整个定义域上都具有可导性,这对于基于梯度的优化方法(如梯度下降)非常重要。

-

特征缩放:tanh函数可以将输入数据映射到范围在-1到1之间,有助于对输入数据进行标准化和特征缩放,加速神经网络的训练过程。

缺点:

-

梯度饱和:当输入值较大或较小时,tanh函数的梯度会接近于零,可能会导致梯度消失问题,使得训练过程变得缓慢或停滞。

-

指数运算开销大:计算tanh函数需要进行指数运算,计算量较大,特别是在大规模数据集和深层网络中,可能会导致计算效率较低。

-

输出范围有限:虽然tanh函数的输出范围在-1到1之间,但与ReLU等激活函数相比,它的输出范围相对较小,可能会限制神经网络的表达能力。

在实际应用中,人们通常会根据具体的任务需求和性能要求选择合适的激活函数。

9681

9681

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?