1. 环境配置

1.1 cuda镜像问题

选择镜像为 Cuda11.7-conda

1.2 面向GPU的环境安装

step1: studio-conda -o internlm-base -t opencompass

step2: source activate opencompass

step3: git clone -b 0.2.4 https://github.com/open-compass/opencompass

step4: cd opencompass

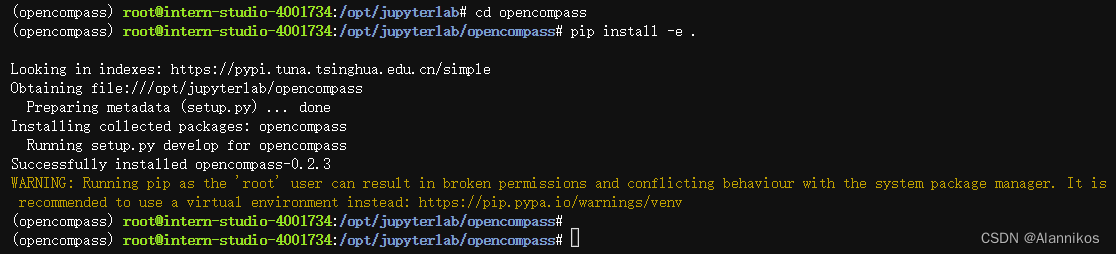

step5: pip install -e .

注意:如果pip install -e .安装未成功(ps:运行成功也建议执行一遍),请运行:

step_extra: pip install -r requirements.txt

这里需要注意一个问题,就是有部分第三方功能,如代码能力基准测试 HumanEval 以及 Llama 格式的模型评测,可能需要额外步骤才能正常运行。

2. 数据准备与评测demo

2.1 解压评测数据集

step1: cp /share/temp/datasets/OpenCompassData-core-20231110.zip /root/opencompass/

step2: unzip OpenCompassData-core-20231110.zip

2.2 查看支持的数据集和模型

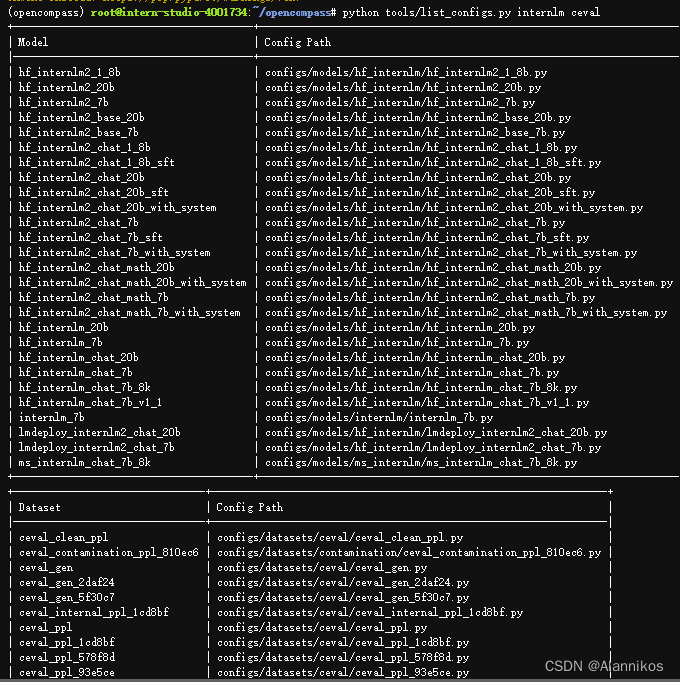

列出所有跟 InternLM 及 C-Eval 相关的配置可以使用下面的命令:

python tools/list_configs.py internlm ceval

下面是展示的结果:

2.3 启动评测(8GB显存即可)

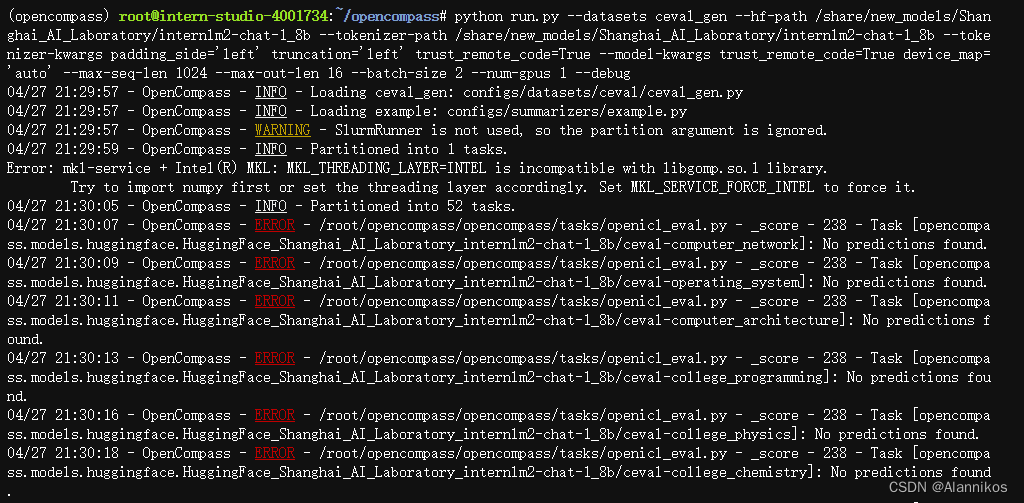

确保按照上述步骤正确安装 OpenCompass 并准备好数据集后,可以通过以下命令评测 InternLM2-Chat-1.8B 模型在 C-Eval 数据集上的性能。由于 OpenCompass 默认并行启动评估过程,可以在第一次运行时以 --debug 模式启动评估,并检查是否存在问题。在 --debug 模式下,任务将按顺序执行,并实时打印输出。

python run.py --datasets ceval_gen --hf-path /share/new_models/Shanghai_AI_Laboratory/internlm2-chat-1_8b --tokenizer-path /share/new_models/Shanghai_AI_Laboratory/internlm2-chat-1_8b --tokenizer-kwargs padding_side='left' truncation='left' trust_remote_code=True --model-kwargs trust_remote_code=True device_map='auto' --max-seq-len 1024 --max-out-len 16 --batch-size 2 --num-gpus 1 --debug

然后会遇到错误:

可以采取这个解决方案:

pip install protobuf

再次运行:

python run.py

--datasets ceval_gen \

--hf-path /share/new_models/Shanghai_AI_Laboratory/internlm2-chat-1_8b \ # HuggingFace 模型路径

--tokenizer-path /share/new_models/Shanghai_AI_Laboratory/internlm2-chat-1_8b \ # HuggingFace tokenizer 路径(如果与模型路径相同,可以省略)

--tokenizer-kwargs padding_side='left' truncation='left' trust_remote_code=True \ # 构建 tokenizer 的参数

--model-kwargs device_map='auto' trust_remote_code=True \ # 构建模型的参数

--max-seq-len 1024 \ # 模型可以接受的最大序列长度

--max-out-len 16 \ # 生成的最大 token 数

--batch-size 2 \ # 批量大小

--num-gpus 1 # 运行模型所需的 GPU 数量

--debug

遇到错误mkl-service + Intel® MKL MKL_THREADING_LAYER=INTEL is incompatible with libgomp.so.1 …

解决方案:

export MKL_SERVICE_FORCE_INTEL=1

#或

export MKL_THREADING_LAYER=GNU

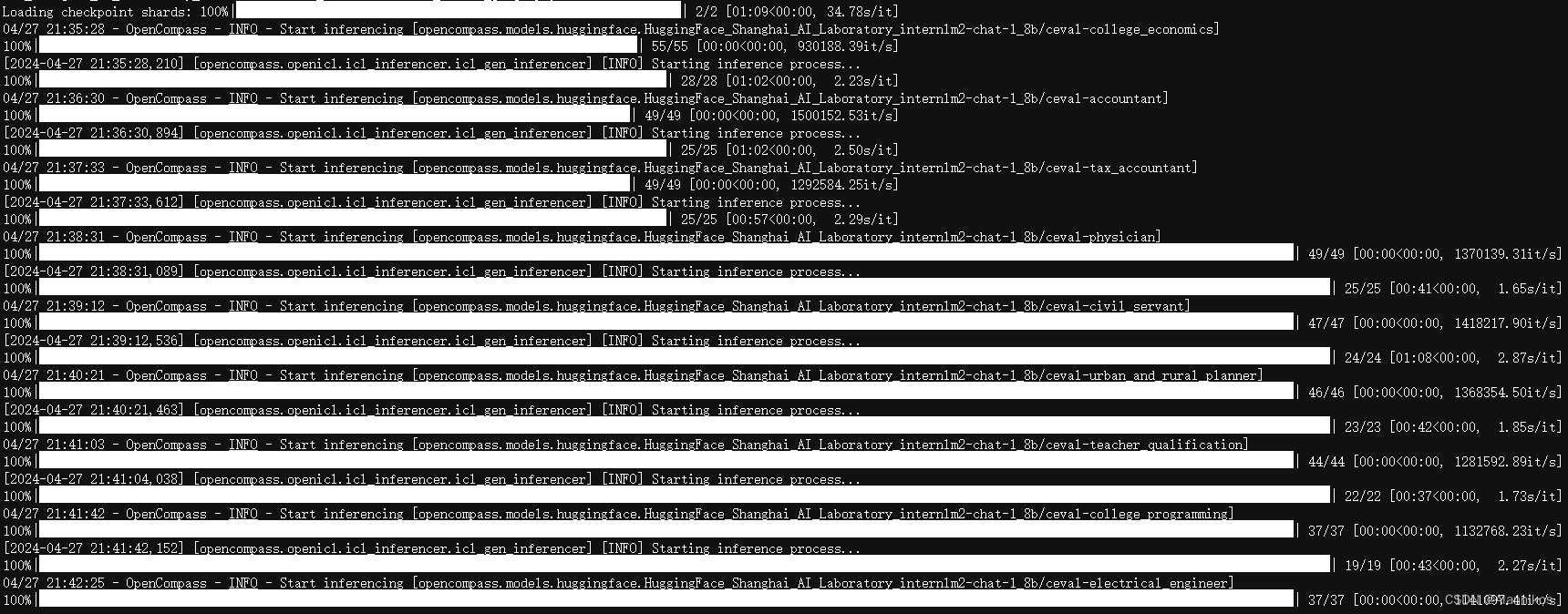

如果一切正常,您应该看到屏幕上显示 “Starting inference process”:

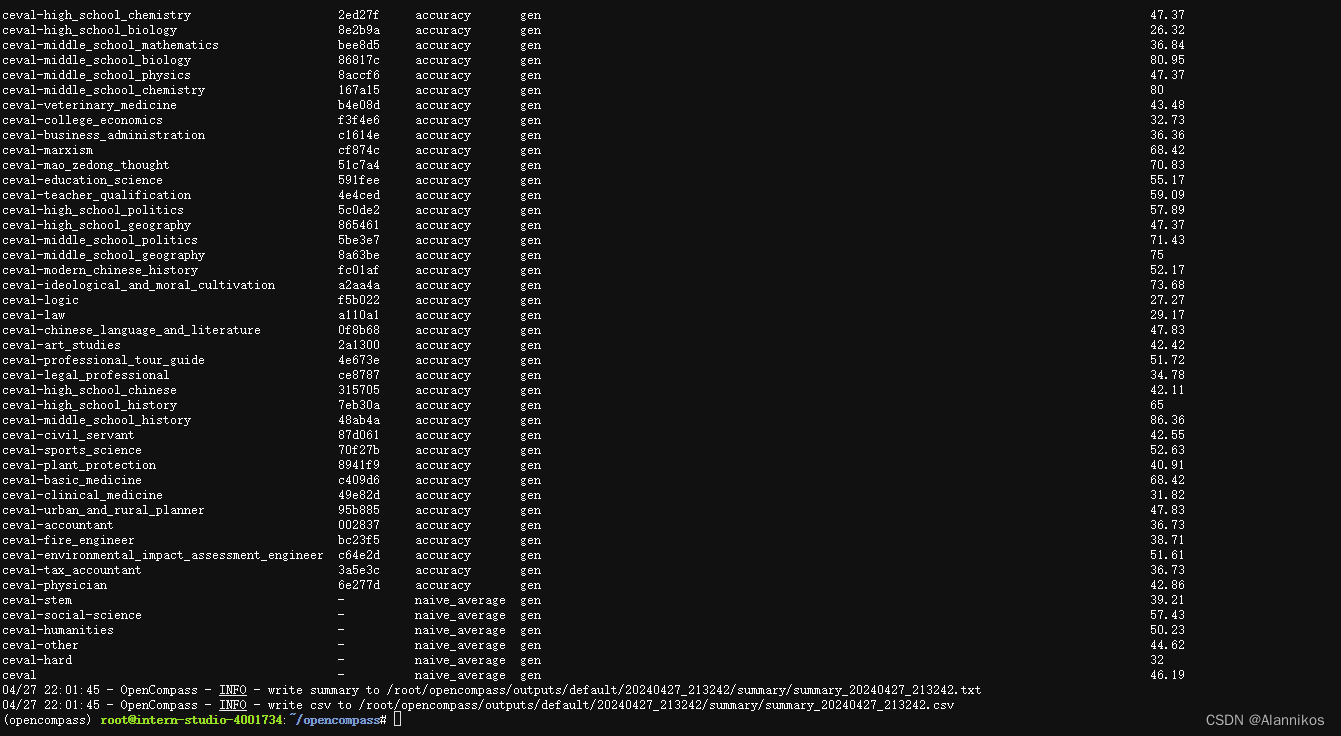

评测完成后,将会看到:

3. 自定义数据集客主观评测[TODO]

3.1 自建客观数据集步骤

详细的客观评测指引参见 https://opencompass.readthedocs.io/zh-cn/latest/advanced_guides/new_dataset.html

3.2 主观评测简介

由于客观评测只能反映模型在一些性能数据上的指标,没法完全真实地反映模型在与人类对话时的表现,因此需要在真实的对话场景下通过主观评测的方式翻译模型的真实性能。 而由于完全靠人力来进行主观评测是费时费力的,因此有很多利用模型来进行主观评测的方式。 这些方式主要可以分为以下几类:打分,对战,多模型评测等。

3.3 自建主观数据集步骤

详细的主观评测指引参见 https://opencompass.readthedocs.io/zh-cn/latest/advanced_guides/subjective_evaluation.html

3.4 实验评估步骤

详情可见https://opencompass-cn.readthedocs.io/zh-cn/latest/advanced_guides/contamination_eval.html

4. 大海捞针(NEEDLE IN A HAYSTACK)实验评估

4.1 大海捞针测试简介

大海捞针测试(灵感来自 NeedleInAHaystack)是指通过将关键信息随机插入一段长文本的不同位置,形成大语言模型 (LLM) 的Prompt,通过测试大模型是否能从长文本中提取出关键信息,从而测试大模型的长文本信息提取能力的一种方法,可反映LLM长文本理解的基本能力。

4.2 数据集介绍

Skywork/ChineseDomainModelingEval 数据集收录了 2023 年 9 月至 10 月期间发布的高质量中文文章,涵盖了多个领域。这些文章确保了公平且具有挑战性的基准测试。

4.3 文件介绍

该数据集包括特定领域的文件:

zh_finance.jsonl - 金融

zh_game.jsonl - 游戏

zh_government.jsonl - 政务

zh_movie.jsonl - 电影

zh_tech.jsonl - 技术

zh_general.jsonl - 综合

这些文件用于评估LLM对不同特定领域的理解能力。

4.4 评估步骤

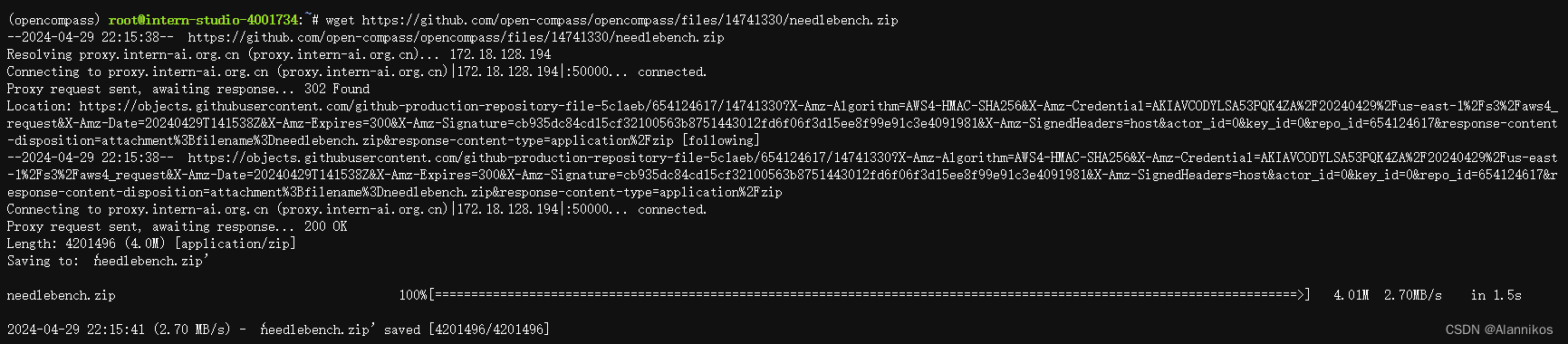

step1: 从 Skywork/ChineseDomainModelingEval 下载数据集。

step2: 将下载的文件放置在 opencompass/data/CDME/ 下

CDME 目录中的预期文件结构如下:

opencompass/

├── configs

├── docs

├── data

│ └── CDME

│ ├── processed

│ ├── README.md

│ ├── zh_finance.jsonl

│ ├── zh_game.jsonl

│ ├── zh_general.jsonl

│ ├── zh_government.jsonl

│ ├── zh_movie.jsonl

│ └── zh_tech.jsonl

├── LICENSE

├── opencompass

├── outputs

├── run.py

├── more...

4.4.1 环境配置

step1: conda create --name opencompass python=3.10 pytorch torchvision pytorch-cuda -c nvidia -c pytorch -y

step2: conda activate opencompass

step3: git clone https://github.com/open-compass/opencompass opencompass

step4: cd opencompass

step5: pip install -e .

这部分前面做过了现在就可以不用做了

4.4.2 评估示例

注意需要安装lmdeploy

使用LMDeploy部署的 InternLM2-7B 模型进行评估

例如,使用LMDeploy部署的 InternLM2-7B 模型进行评估NeedleBench-4K的所有任务,可以在命令行中直接使用以下命令,该命令会调用预定义好的模型、数据集配置文件,而无需额外书写配置文件:

python run.py --dataset needlebench_4k --models lmdeploy_internlm2_chat_7b --summarizer needlebench/needlebench_4k_summarizer --slurm -p partition_name -q reserved --max-num-workers 32 --max-partition-size 8000

如果只想测试原始的大海捞针任务设定,可以更换数据集的参数为needlebench_single_4k,如:

python run.py --dataset needlebench_single_4k --models lmdeploy_internlm2_chat_7b --summarizer needlebench/needlebench_4k_summarizer --slurm -p partition_name -q reserved --max-num-workers 32 --max-partition-size 8000

4.4.3 参数解释

-p partition_name -q auto : 指定 Slurm 分区名称

--max-num-workers 32 : 最大工作进程数

REFERENCE:

- https://opencompass.readthedocs.io/zh-cn/latest/advanced_guides/needleinahaystack_eval.html

- https://github.com/InternLM/Tutorial/blob/camp2/opencompass/readme.md

- https://www.bilibili.com/video/BV1Pm41127jU/

- https://opencompass.readthedocs.io/zh-cn/latest/advanced_guides/new_dataset.html

- https://opencompass.readthedocs.io/zh-cn/latest/advanced_guides/subjective_evaluation.html

本文详细介绍了如何在OpenCompass环境中配置CUDA、安装GPU依赖,以及数据集的准备、模型评测(包括C-Eval和大海捞针实验)和主观评测的方法。特别关注了模型部署、数据集结构和常见问题解决步骤。

本文详细介绍了如何在OpenCompass环境中配置CUDA、安装GPU依赖,以及数据集的准备、模型评测(包括C-Eval和大海捞针实验)和主观评测的方法。特别关注了模型部署、数据集结构和常见问题解决步骤。

1127

1127

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?