ERNIE 4.5 是百度团队推出的一系列大规模多模态模型,具有以下核心研究内容和技术创新:

1. 模型架构

-

异构混合专家模型(Heterogeneous MoE):结合了模态共享参数和模态专用参数的设计,支持文本、图像和视频输入,生成文本输出。视觉专家参数仅为文本专家的三分之一,提升了计算效率。

-

视觉编码器:采用自适应分辨率的ViT编码器和2D/3D旋转位置嵌入(RoPE),支持可变分辨率输入和视频帧的动态采样。

-

适配器(Adapter):对齐视觉与文本表征,通过空间和时间压缩减少序列长度。

2. 训练方法

-

三阶段预训练:

-

文本阶段:短上下文(8k)和长上下文(128k)训练,逐步扩展位置编码。

-

视觉阶段:视觉编码器预训练、预对齐和联合优化。

-

多模态联合训练:短上下文和长上下文(128k)的文本与视觉数据联合训练。

-

-

优化技术:

-

路由器正交化损失:防止专家同质化,提升模型泛化能力。

-

令牌平衡损失:解决多模态训练中的梯度不平衡问题。

-

指数移动平均(EMA):通过动态调整衰减系数稳定训练。

-

3. 训练框架

-

异构并行训练:针对多模态和MoE架构,设计混合并行策略(数据并行、专家并行、流水线并行)。

-

内存优化:采用FP8混合精度训练、细粒度重计算和内存高效的流水线调度。

-

容错系统:支持快速故障检测和恢复,减少大规模训练中的中断时间。

4. 推理与部署

-

量化技术:支持W4A8、2-bit无损量化,降低显存占用和计算开销。

-

推理加速:优化注意力机制和KV缓存,支持高吞吐量解码。

-

部署方案:支持单节点(4x GPU)到多节点分布式部署,适应不同硬件平台。

5. 后训练优化

-

语言模型(LLM):通过监督微调(SFT)和强化学习(RL)优化指令跟随和知识记忆能力。

-

视觉语言模型(VLM):结合思维模式和非思维模式,增强视觉理解和多模态推理能力。

6. 开源工具

-

ERNIEKit:提供预训练、微调、量化等工具,支持低资源训练和工业级部署。

-

FastDeploy:支持多硬件平台的高效推理,优化KV缓存传输和负载均衡。

7. 性能评估

-

语言模型:在MMLU、C-Eval等基准测试中达到SOTA,尤其在数学、代码和推理任务中表现优异。

-

多模态模型:在OCR、图表理解、视频分析等任务中领先,支持复杂视觉推理。

8. 贡献

-

开源模型权重和工具链(Apache 2.0),推动多模态研究和应用发展。

ERNIE 4.5 通过创新的架构设计和高效的训练部署技术,在文本和多模态任务中实现了高性能与可扩展性的平衡。这里是自己的论文阅读记录,感兴趣的话可以参考一下,如果需要阅读原文的话可以看这里,如下所示:

项目地址在这里,如下所示:

预训练模型发布地址在这里,如下所示:

摘要

在本报告中,我们介绍了 ERNIE 4.5,这是一个包含 10 种不同变体的新型大规模多模态模型家族。该模型家族包括混合专家(MoE)模型,其中最大的模型拥有 4240 亿总参数,激活参数为 470 亿,此外还包含一个 3 亿参数的密集模型。对于 MoE 架构,我们提出了一个新颖的异构模态结构,支持跨模态的参数共享,同时也允许每个单独模态拥有专用参数。这种 MoE 架构的优势在于能够在不损害文本相关任务性能的情况下,增强多模态理解能力,甚至还能提升性能。我们的所有模型都使用 PaddlePaddle 深度学习框架进行了最优效率的训练,同时也实现了高性能推理和简化部署。在 ERNIE 4.5 最大的语言模型预训练中,我们实现了 47% 的模型 FLOPs 利用率(MFU)。实验结果表明,我们的模型在多个文本和多模态基准测试中达到了最先进的性能,特别是在指令遵循、世界知识记忆、视觉理解和多模态推理方面。所有模型均在 Apache 2.0 许可下公开,以支持该领域的未来研究和开发。此外,我们还开源了 ERNIE 4.5 的开发工具包,具备工业级能力、资源高效的训练和推理工作流程以及多硬件兼容性。

目录

-

引言

-

架构2.1 异构 MoE 2.2 视觉编码器 2.3 适配器 2.4 多模态位置嵌入

-

预训练 3.1 预训练数据 3.2 REEAO:位对齐确定性预训练数据管理器 3.3 预训练配方 3.3.1 第一阶段:纯文本训练 3.3.2 第二阶段:纯视觉训练 3.3.3 第三阶段:联合多模态训练 3.4 模型优化 3.4.1 路由正交化损失 3.4.2 令牌平衡损失 3.5 指数移动平均

-

后训练 4.1 语言模型的后训练 4.1.1 监督式微调 4.1.2 统一奖励系统 4.1.3 强化学习 4.2 视觉语言模型的后训练 4.2.1 监督式微调 4.2.2 具有可验证奖励的强化学习

-

训练框架 5.1 多模态模型训练的异构并行性 5.1.1 异构并行架构 5.1.2 分层负载平衡策略 5.2 MoE 主干的混合并行性 5.2.1 节点内专家并行性 5.2.2 内存高效的流水线调度 5.3 FP8 混合精度训练 5.4 计算优化 5.4.1 重计算与最佳计算-内存权衡 5.4.2 FlashMask 用于灵活注意力掩码和长上下文训练 5.5 框架原生容错系统

-

推理与部署 6.1 量化 6.1.1 W4A8 量化 6.1.2 2 位量化 6.1.3 注意力和 KV 缓存量化 6.2 推理加速 6.2.1 W4A8 内核加速 6.2.2 高效注意力内核 6.2.3 预测解码 6.3 部署

-

开源开发工具 7.1 ERNIEKit 7.2 FastDeploy

-

评估与结果 8.1 语言模型评估 8.1.1 预训练语言模型的结果 8.1.2 后训练语言模型的结果 8.2 多模态模型评估

-

结论 附录 B 定性示例

1 引言

近年来,人工智能领域取得了显著进展,主要得益于大规模基础模型的发展。这些模型凭借海量数据集和先进的训练技术,展现了前所未有的能力,涵盖了广泛的领域。在文本理解和推理领域,像 GPT-4.1(OpenAI, 2025a)、GPT-4.5(OpenAI, 2025b)、o3(OpenAI, 2025d)、Qwen-3(Yang et al., 2025a)、DeepSeek-V3(DeepSeek-AI et al., 2024b)、DeepSeek-R1(DeepSeek-AI, 2025)、Claude 4(Anthropic, 2025)、Gemini 2.5(DeepMind, 2025)和 Llama-4(Meta-AI, 2025)等模型设定了新的最先进水平,展现出令人印象深刻的理解、推理和问题解决能力。在多模态理解方面,像 GPT-4 系列(OpenAI, 2024; 2025a;b)、Gemini 2.5(DeepMind, 2025)、Gemma 3(Gemma-Team, 2025)和 Qwen2.5-VL(Bai et al., 2025)等模型将这些能力扩展到了视觉数据,实现了强大的视觉推理和解释能力。这些最先进的系统不仅在自然语言处理、图像和视频理解领域设定了新的基准,还促进了推理、对话和创意生成等强大应用的出现。

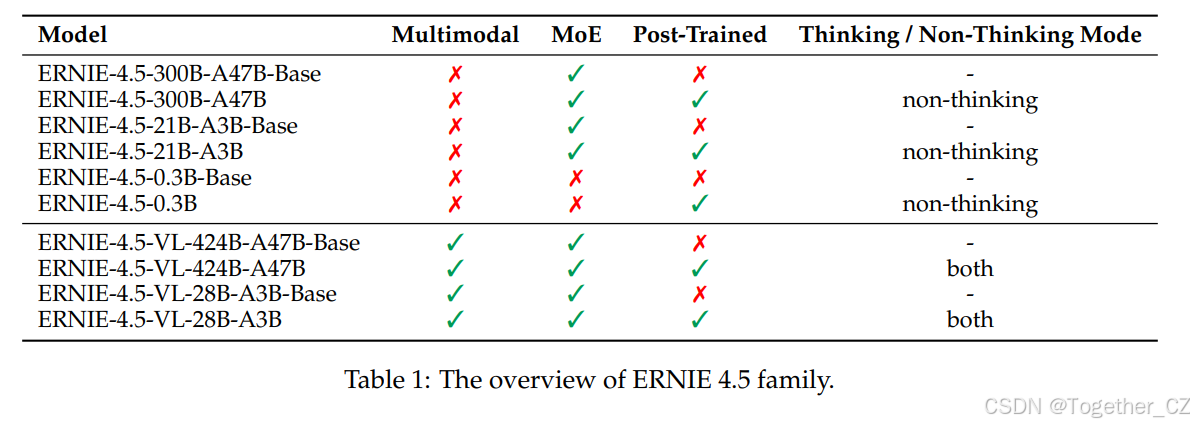

ERNIE 4.5 模型如表 1 所示,包括 MoE 模型和密集模型。除了 0.3B 参数的密集语言模型外,其他都是基于 MoE 的。MoE 模型分为大型语言模型(LLM)和视觉语言模型(VLM)。由于我们为每个模态分配了独立的参数,LLM 的总参数比 VLM 少。这些模型的构建目标是实现高效且有效的多模态预训练和推理,同时解决模型扩展带来的工程和性能挑战。

表 1:ERNIE 4.5 家族概览。

与传统的单模态 MoE 模型不同,ERNIE 4.5 使用了一种新颖的异构模态结构,支持跨模态的参数共享,包括自注意力参数共享和专家参数共享,同时也允许每个单独模态拥有专用参数。通过我们提出的模态隔离 MoE 路由技术和多模态联合预训练,ERNIE 4.5 不仅能够通过专用视觉专家高效学习视觉信息,还能在训练过程中增强语言模型原有的知识和推理能力。此外,在后训练阶段,我们的模型能够在思考和非思考模式之间实现有效的平衡。

我们的所有模型都使用 PaddlePaddle 框架进行训练。我们通过提出异构混合并行方法和针对多模态大模型的分层负载平衡解决方案,高效地预训练 ERNIE 4.5。通过我们的极端优化,包括高效的节点内专家并行性、FP8 混合精度训练和精细的重计算方法,我们在 2016 个 NVIDIA H800 GPU 上预训练我们最大的 ERNIE 4.5 语言模型,实现了 47% 的模型 FLOPs 利用率(MFU)。基于我们的训练方法,我们的最大 ERNIE 4.5 语言模型能够在有限的计算资源下实现最佳训练性能,例如 96 个 GPU。

ERNIE 4.5 系列包含不同参数大小的 MoE 和密集模型,适用于各种部署场景。所有模型都能够直接使用 BF16 和 FP8 精度进行推理。为了提高推理效率,我们提出了一个无损且推理友好的低比特量化解决方案,采用硬件优化操作符实现增强的内存减少和计算加速。整体参数大小和无损压缩技术使得我们的最大 ERNIE 4.5 模型能够方便地部署,最小计算资源需求为 4 个 80GB GPU(4 位)或 1 个 141GB GPU(2 位)。通过进一步采用 Prefill-Decode(PD)解耦与专家并行性,我们的最大 ERNIE 4.5 语言模型实现了每 H800 节点 56k 输入 TPS(每秒令牌数)和 18k 输出 TPS 的推理吞吐量。

我们的模型家族具有以下三个关键创新:

-

多模态异构 MoE 预训练:我们的模型在文本和视觉模态上进行联合训练,以更好地捕捉多模态信息的细微差别,并提高涉及文本理解和生成、图像理解和跨模态推理等任务的性能。为了在一种模态不阻碍另一种模态学习的情况下实现这一点,我们设计了异构 MoE 结构,引入了模态隔离路由,并采用了路由正交化损失和多模态令牌平衡损失。这些架构选择确保了两种模态的有效表示,允许在训练过程中相互加强。

-

扩展高效的基础设施:我们提出了针对 ERNIE 4.5 模型高效训练的新型异构混合并行和分层负载平衡策略。通过使用节点内专家并行性、内存高效的流水线调度、FP8 混合精度训练和精细的重计算方法,我们实现了显著的预训练吞吐量。对于推理,我们提出了多专家并行协作方法和卷积码量化算法,以实现 4 位/2 位无损量化。此外,我们引入了带有动态角色切换的 PD 解耦,以提高 ERNIE 4.5 MoE 模型的资源利用率,从而增强推理性能。基于 PaddlePaddle 构建的 ERNIE 4.5 在多种硬件平台上实现了高性能推理。

-

模态特定的后训练:为了满足现实世界应用的多样化需求,我们对预训练模型的特定模态进行了微调。我们的 LLM 针对通用语言理解和生成进行了优化。VLM 则专注于视觉语言理解和同时支持思考和非思考模式。每个模型都采用了监督式微调(SFT)、直接偏好优化(DPO)或一种修改后的强化学习方法,即统一偏好优化(UPO)进行后训练。

我们在广泛的基准测试中对模型进行了广泛的评估,涵盖了语言理解和生成、推理和多模态任务。我们的模型在性能上始终表现出色,特别是在指令遵循、世界知识记忆、视觉理解和多模态推理方面。

我们发布的所有模型,包括模型权重和开发工具包,均已完全开源,以鼓励广泛的采用和协作研究。在报告的后续部分,我们将详细介绍模型架构、训练程序和全面的评估结果。我们希望我们的努力能对该研究社区产生有意义的贡献,并有助于加速大规模多模态模型领域的发展。

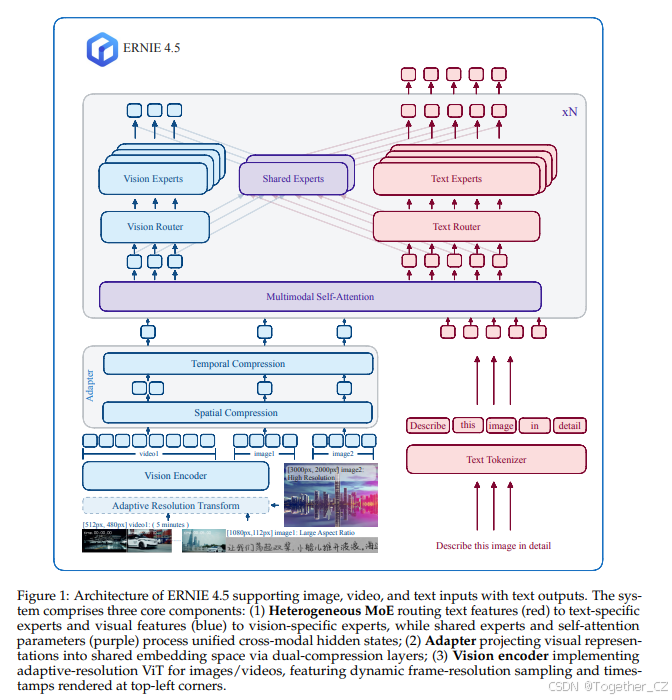

2 架构

图 1 展示了 ERNIE 4.5 采用的 Transformer 架构。它支持图像、视频和文本作为输入,并输出文本。对于视觉模态(图像和视频),使用了可变分辨率的 ViT 编码器,随后通过适配器将表示投影到与文本共享的嵌入空间。ERNIE 4.5 然后应用了细粒度的混合专家(MoE)架构,使用多模态位置嵌入对统一的隐藏状态进行建模。架构的关键组成部分包括以下内容:

-

异构 MoE:文本和视觉特征被路由到针对其各自特征定制的独立专家组,同时它们也都经过一组共享专家以及所有自注意力参数的处理,以促进跨模态知识整合。视觉专家的参数量是文本专家的三分之一。

-

视觉编码器:我们采用了一个视觉编码器,配备了自适应分辨率变换和二维旋转位置嵌入(RoPE)。

-

适配器:适配器对齐了视觉和文本模态的表示,并结合了空间和时间压缩。

-

多模态位置嵌入:我们在视觉语言模型的输入层采用了统一的三维 RoPE 位置嵌入方案,分别对视觉输入的时序、宽度和高度位置进行独立编码,而对文本令牌则默认使用标准的一维 RoPE。

2.1 异构 MoE

ERNIE 4.5 基于细粒度的 MoE 主干。文本和视觉输入被路由到针对其各自特征定制的专家组,以减轻跨模态干扰。通过引入模态感知的专家分配策略,视觉专家的参数量仅为文本专家的三分之一,从而提高了视觉信息处理的效率。

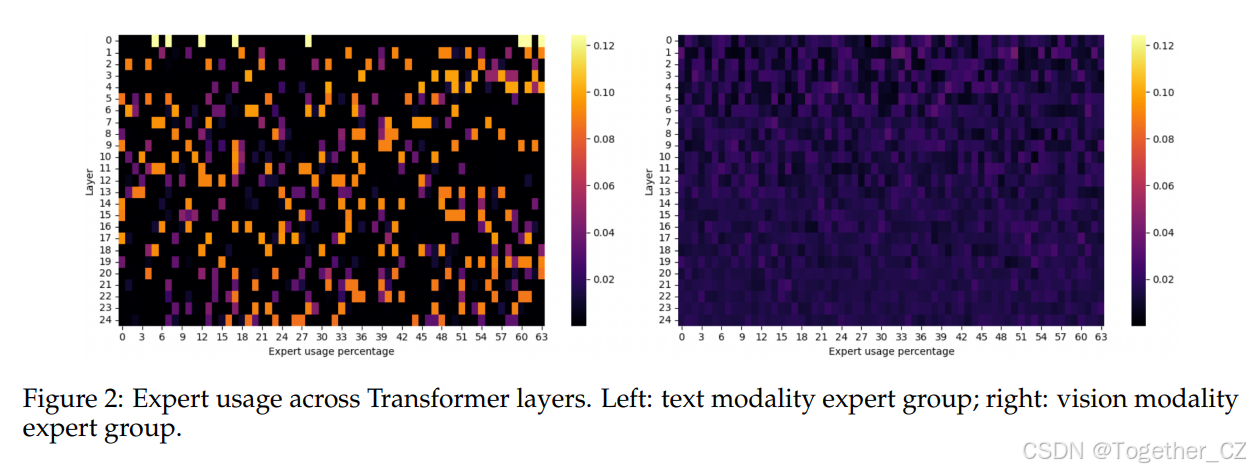

在多模态建模中,MoE 路由器容易出现不稳定,尤其是在数据分布突然变化时。例如,将纯文本的 MoE 模型扩展为处理多模态输入可能会导致路由器崩溃,从而导致文本能力的退化(Liang et al., 2024)。为了缓解这一问题,我们提出了模态隔离路由策略。图 2 展示了在保留数据集上专家激活比例的热图。它表明,文本专家表现出集中激活,而视觉专家则显示出更分散的激活模式。这些发现证实了模态分离 MoE 设计的必要性,以确保有效的多模态联合训练。

具体来说,MoE 中的 FFN 专家分为三种类型:文本专家、视觉专家和共享专家。文本和视觉令牌都以非路由方式处理共享专家,而每种都独立路由到其对应的模态特定专家。具体而言,文本专家仅处理文本令牌,视觉专家仅处理视觉令牌,共享专家则对两种模态进行操作。MoE 层的最终输出是通过将共享和模态特定专家的输出相加获得的。

我们还引入了几项工程决策,以进一步增强方法的可扩展性和效率。鉴于视觉令牌的冗余性,视觉专家组的中间维度大小仅为文本专家所用的三分之一。由于 FFN 层的 FLOPs 与输入和中间维度的乘积成比例,这种调整实现了视觉令牌的 FFN 计算大约 66% 的减少。我们进一步在最后一个 Transformer 层中排除了视觉专家,因为它们的权重对交叉熵损失没有贡献。为了解决由模态隔离专家引起的设备级负载不平衡问题,我们设计了自定义的负载感知专家并行性策略,详细内容见第 5.2.1 节。

异构 MoE 设计带来了几个关键优势:

-

统一多模态建模:它使得构建一个统一的多模态模型成为可能,其中所有参数——文本和视觉——都联合优化。与部分微调方法相比,这种设计更数据高效且更具可扩展性,支持模型增长到数百亿参数。

-

路由稳定性:可以在训练的后期阶段引入视觉专家,避免路由崩溃。这种分阶段训练减少了计算量,同时保留了性能,因为视觉理解主要基于先前的文本知识。

-

计算效率:文本和视觉专家可以独立部署。在纯文本推理场景中,可以跳过视觉专家以减少内存开销。对于多模态推理,我们支持模态感知的推理管道分区。具体来说,为每个模态分配不同的推理预算,独立部署 Prefill-Text、Prefill-Vision 和 Decode-Text 模块,可以显著减少跨设备通信。

与以往方法相比,我们的模态隔离细粒度 MoE 策略引入了几个重要创新。与 Wang et al.(2023)和 Wang et al.(2022)使用的密集 FFN 不同,我们采用了细粒度 MoE 主干,提高了可扩展性。与 Liang et al.(2024)不同,我们保留了密集注意力层以保持跨模态交互,同时将 MoE 路由限制在 FFN 层。与 Lin et al.(2024d)不同,我们采用了细粒度 top-k 路由(DeepSeek-AI et al., 2024a;b),保持了与自回归解码的兼容性,并能够扩展到长上下文训练。

2.2 视觉编码器

视觉 Transformer(ViT)被广泛用作视觉语言模型中的视觉编码器(Radford et al., 2021b; Zhai et al., 2023; Fang et al., 2024; Sun et al., 2023)。然而,现有的 ViT 通常在固定分辨率的输入上进行预训练,需要在处理前将图像调整为正方形。在本工作中,我们使用了一个自适应分辨率的视觉编码器。而不是强制输入图像的宽高比为正方形,我们将每个输入图像的高和宽分别调整为 ViT 补丁大小的最近倍数。这种方法大致保留了原始宽高比,避免了固定大小调整带来的失真。

调整分辨率后的图像随后被划分为补丁,形成一个可变长度的 1D 序列令牌。为了对每个补丁的二维空间起源进行编码,我们采用了二维旋转位置嵌入(RoPE)(Su et al., 2024b),分别对高度和宽度维度进行空间信息编码。此外,我们采用了 Dehghani et al.(2023b)提出的图像打包技术,该技术可以高效地将多个图像打包到一个批次中,同时保持补丁之间的位置一致性。这使得在不需要修改模型架构的情况下,更有效地利用计算资源。

对于视频处理,我们将视频视为采样帧序列,但这很快就会耗尽模型有限的序列长度预算,使得全面的时间覆盖变得具有挑战性。我们提出了一个自适应视频采样策略,该策略根据视频的持续时间和可用序列长度动态调整帧的数量及其空间分辨率。具体来说,以预定义的帧率对帧进行采样;如果这超过了上下界限制的帧数,则应用均匀采样到相应的界限。如果视觉令牌总数超过了限制,我们首先减少分辨率,直到达到下限,如果需要,进一步减少帧数。对于多视频输入,帧分配与每个视频的长度成比例。这种方法最大化了序列长度的使用,为短视频提供了更高的细节,为长视频提供了足够的帧覆盖。

为了进一步增强时间建模,我们引入了一种时间戳渲染技术,将绝对时间戳叠加到每个帧上。与位置嵌入(Bai et al., 2025)或基于文本令牌的时间编码(Guo et al., 2025; Hong et al., 2024)不同,我们的方法对任何帧率都具有灵活性,不消耗额外的令牌,并直接在视觉流中为模型提供明确的时间线索。这种直接的监督减少了学习难度,使得模型能够更准确地进行时间理解。

2.3 适配器

为了将视觉和文本表示对齐到一个统一的嵌入空间,我们设计了一个适配器,作为视觉编码器和语言模型之间的模态桥接模块。适配器结合了空间和时间令牌压缩,以执行特征融合并减少序列长度。具体来说,空间压缩在 2×2 的非重叠补丁上进行,沿空间维度将令牌数量减少了 4 倍,而时间压缩将序列长度减少了 2 倍。这两种压缩操作都利用像素洗牌(Shi et al., 2016),它重新排列空间上或时间上相邻的令牌特征,形成更紧凑的形式。重新排列的特征随后通过 MLP 层进行处理。为了在不同模态之间统一处理图像和视频,我们将每个静态图像视为一个合成的两帧视频,通过复制图像特征来实现,从而在后续的 Transformer 层中实现一致的时间建模。总的来说,适配器不仅通过时空融合有效地压缩了令牌,更重要的是,它通过训练将多模态特征空间对齐到文本嵌入空间,促进了后续 Transformer 层中更深入的跨模态交互。

2.4 多模态位置嵌入

为了有效处理文本、图像和视频的多模态序列,我们在视觉语言 Transformer 的输入层采用了统一的三维 RoPE 位置嵌入方案。三维 RoPE 对视觉输入的时序和空间位置分别进行编码,为每个轴分配不同的频率带,而对文本令牌则默认使用标准的一维 RoPE(Wang et al., 2024a)。具体来说,较低的频率分配给变化最慢的时间轴,而剩余的频率在空间轴(高度和宽度)之间交错分配,从而实现了对称的空间建模和强大的长期时间建模(Wei et al., 2025)。与用于图像的二维 RoPE 和用于文本的一维 RoPE 不同,我们的方法适应了视频中的额外时间维度,使得在单一嵌入空间内能够灵活且一致地对所有模态的位置进行编码。实验证明,三维 RoPE 一致地增强了多模态理解,尤其是在需要序列长度外推的长视频理解任务中。

3 预训练

在本节中,我们首先描述了我们用于大规模文本和多模态数据集的构建(第 3.1 节)。接下来,我们介绍了 REEAO(随时随地记录一切)——一个支持位对齐确定性数据处理的数据管理器,它使得跨训练运行的可重复性和非冗余数据访问成为可能。随后,我们介绍了文本预训练和多模态预训练阶段的训练配方(第 3.3 节)。我们还详细介绍了我们在训练目标上的创新(第 3.4 节),并以指数移动平均过程的发现结束(第 3.5 节)。

3.1 预训练数据

ERNIE 4.5 模型在网页、学术论文、文档、图像、视频和合成模态转换数据等来源的数据上进行训练。鉴于原始数据集中存在大量噪声,我们实施了全面的数据质量过滤管道,分别针对文本、图像、视频和音频进行数据质量过滤,主要包括去重、去除噪声和无关内容。随后,我们对数据进行标注和聚类,以提取模式并发现数据集中的知识。这一过程有助于知识发现,并为数据管理、分析和最佳数据混合提供信息。最后,我们通过分析模型在数据集上的性能来识别数据弱点并指导优化,建立了一个人-模型-在-循环的迭代数据改进方法。以下是这一过程的关键步骤:

-

数据去噪与合成:我们的数据过滤管道结合了启发式规则和基于模型的方法。启发式过滤执行去重和低质量数据去除,而基于模型的过滤采用质量评估模型自动过滤低质量样本,确保数据质量。噪声过滤不可避免地会导致数据规模减少,从而产生质量与数量之间的困境。为了缓解这一问题,我们引入了数据合成解决方案来补充高价值数据。例如,我们采用自蒸馏和多模态转换方法来丰富高价值领域的数据来源,显著缓解了高价值数据稀缺的问题。

-

数据分析:为了更好地理解和管理数据,我们精心构建了一个预训练数据地图,以支持数据挖掘和数据分析。为了构建数据地图,我们从多个方面对数据进行分类,包括语言、知识、应用和质量。通过对数据进行多视角分析,我们可以优化训练数据混合配置、阶段性选择和模型性能跟踪分析。

-

人-模型-在-循环数据改进:为了持续改进数据质量,我们设计了一个人-模型-在-循环管道。该管道包括选择核心数据集、选择候选模型进行数据评估以及手动结果分析等阶段。通过这一数据迭代循环,我们可以确保每种过滤和数据挖掘策略的有效性,从而提高文本、图像和视频数据的整体质量。

在下一节中,我们将描述各种数据源的构建,包括知识中心数据、多模态对齐数据和特定领域数据。

知识基础数据

通过对大规模数据的分析,我们观察到自然语言语料库中所含知识的量是不均匀的,可以系统地划分为多个层次。受 DIKW 框架(Wikipedia, 2025)的启发,我们定义了五个不同的知识层次,并开发了一个知识层次分类模型,以自动标注预训练数据到这些层次。这个分类框架使得我们能够更深入地分析预训练数据集中知识价值的分布。

基于这个框架,我们的分析揭示了高价值数据稀缺,仅占可用语料库的一小部分。为了应对这种稀缺性,我们采用数据合成来增强有限的高价值训练数据。具体来说,我们提出了一种基于关键点的数据合成方法,能够在不同领域(如数学(Wei et al., 2024b; Yang et al., 2025b; Li et al., 2024b; Yu et al., 2024)、事实知识(Gunasekar et al., 2023; Wettig et al., 2024)和编程代码(Chang et al., 2024; Wei et al., 2024b))生成多样化且高质量的样本。为了确保广泛的知识覆盖,我们使用教科书和教育网站作为种子来源,提取结构化的关键点以指导数据生成过程。

此外,为了提高模型在推理任务上的性能,我们对推理相关语料库进行了有针对性的处理步骤。这些步骤包括选择代表性样本、按推理类型组织、分级难度水平和过滤低质量项目,以保留有价值的实例(Sun et al., 2021; Xie et al., 2023; Su et al., 2024a; Yang et al., 2025b)。实验证明,这种处理显著有助于提高模型的推理能力。

交错文本-图像数据

交错文本-图像数据在推进多模态学习能力方面发挥着关键作用(Alayrac et al., 2022; Lin et al., 2024c),但现有的数据集存在规模有限和视觉与文本组件对齐弱的问题。为了应对这些挑战,我们开发了一种全面的数据策划策略。我们首先系统地收集了大量网页数据,识别出具有良好集成视觉元素的高质量网页和文档。然后,我们通过从视频源中提取大量交错内容来扩展这一数据集,利用在线视频中丰富的解释性知识,通过关键帧提取和自动语音识别(ASR)(Miech et al., 2019; Xu et al., 2023; Zellers et al., 2021)来实现。最后,我们实施了严格的质量增强程序,包括页面内图像-文本去重、过滤低分辨率图像和无关内容、去除乱码文本和广告以及检测无序内容。通过这种多方面的方法,我们显著丰富了交错数据集,并观察到这种增强的交错数据显著提高了模型的知识容量和多模态理解能力。

图像-文本对

图像-文本对对于学习视觉语言模型中的可转移表示至关重要(Radford et al., 2021a)。尽管互联网上这种数据丰富(Schuhmann et al., 2022),但存在大量噪声,如不相关的描述、琐碎或通用的标题、冗余图像以及数据质量不均匀等问题。为了应对这些挑战,我们采用了过滤技术,包括图像-文本相似性评分(例如,CLIP 分数阈值)以过滤低相关性对,随后对图像和文本进行去重(Zauner, 2010; Abbas et al., 2023)。然后,我们对图像进行分类和标记,将图像分为自然场景、表格、截图、图表、文档等类型。最后,我们对数据的一个子集进行重新描述,以提高图像-文本对齐的质量。为了进一步提高网格式图像理解能力,我们通过将多个图像拼接成网格布局并将相应的标题拼接成匹配结构来合成训练样本。这种策略有助于模型更好地定位和解释复合视觉输入中的信息。

领域特定数据

为了增强模型在特定领域的任务能力,我们构建了涵盖垂直领域的大型数据集,如工业、金融、医疗保健和消费娱乐。鉴于高质量领域数据的稀缺性和专业化,我们开发了一种多样化的数据来源策略来解决这些限制。我们的方法包括两个主要的数据来源:

-

进阶挖掘与条件训练:受 Shao et al.(2024)的启发,我们采用进阶挖掘方法,系统地提取大量特定领域的数据。在预训练过程中,我们发现条件预训练方案(Korbak et al., 2023)显著提高了这种领域数据的学习效率,尤其是在创意写作任务中。

-

音频转录与增强:我们利用自动语音识别(ASR)模型从音频源中转录有价值的特定领域内容,包括视频音轨和播客,开发了一个全面的重写和过滤管道,以减轻转录噪声,同时用口语和对话式文本数据丰富我们的数据集。

3.2 REEAO:位对齐确定性预训练数据管理器

在大规模训练现代自回归语言模型时,需要处理来自异构数据源的万亿级令牌,并利用动态变化的计算基础设施。大规模训练通常涉及频繁的波动,例如从检查点恢复、从节点故障中恢复、调整计算资源、处理可变序列长度以及更新数据集。这些变化通常会破坏底层数据管道,可能导致诸如意外的数据重复或遗漏等重大问题。

为了解决这些挑战,我们引入了 REEAO(随时随地记录一切)——一个基于五个核心原则构建的数据流管理器:可重复性、效率、弹性、适应性和可观察性。REEAO 将多模态数据源划分为固定长度的记录,并从根本上保证训练过程产生一个位对齐确定性令牌序列,该序列在预训练数据配置完成后、实际训练开始之前就完全确定。即使在训练节点数量、分布策略、全局批量大小或上下文长度发生变化等复杂场景下,这一保证仍然有效。此外,REEAO 维护了一个与分布式无关的数据源消费记录,以确保不会重复数据——即使在动态扩展资源或动态更新训练数据时也是如此。

3.3 预训练配方

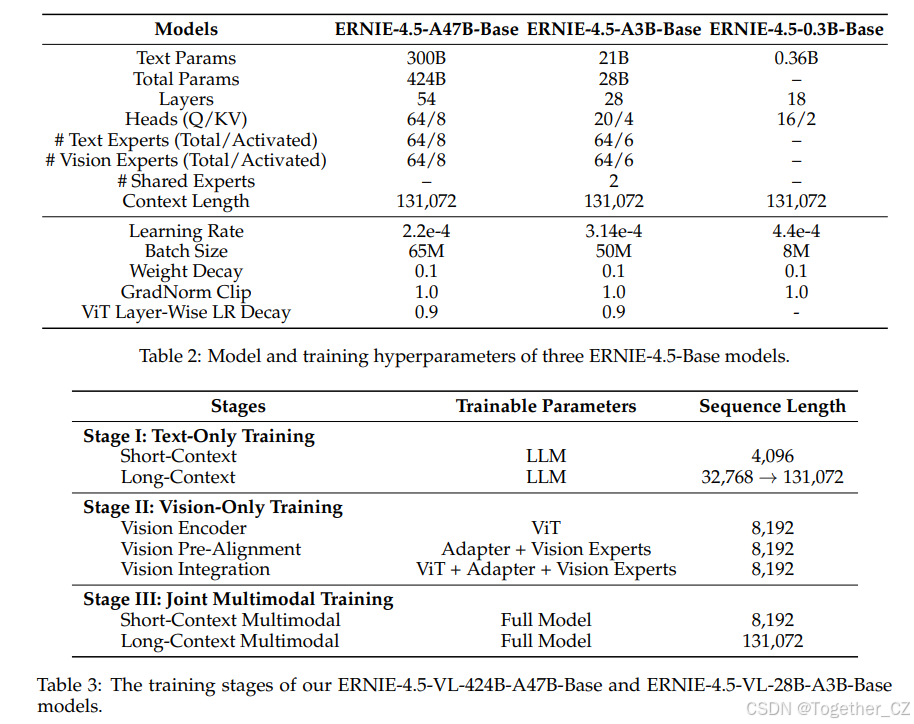

我们开发了一系列基于 Transformer 的模型,具有不同的规模、注意力配置和可选的 MoE 模块,并根据每个模型的参数预算量身定制了架构选择。表 2 总结了 ERNIE 4.5 家族在大规模和轻量级配置下的架构超参数和规模感知训练设置。具体来说,我们报告了关键架构选择以及训练超参数,如批量大小、学习率和优化策略。对于所有模型,我们在预训练过程中采用了 Warmup-Stable-Decay 学习率调度(Hu et al., 2024),并为每个模型配置了特定的学习率。

表 3:ERNIE-4.5-Base 模型及其训练超参数。

为了确保多模态联合训练的稳定性,我们为 ERNIE 4.5 设计了一个分阶段的预训练策略,如表 3 所示。

3.3.1 第一阶段:纯文本训练

该阶段致力于建立一个强大的语言骨干,确保模型具备强大的语言理解能力和高效的长距离依赖建模能力。通过逐步增加上下文长度并调整位置编码,语言模型具备了处理传统和长上下文任务的能力——为后续的多模态预训练提供了稳定的基石。

-

短上下文:我们首先在来自不同领域的海量纯文本令牌上进行大规模预训练。这一子阶段主要发展核心语言能力、事实知识库以及在标准短上下文(8k 序列长度)配置下的文本生成能力。

-

长上下文:为了将模型的上下文长度扩展到 128k 令牌,在这一子阶段中,我们首先将最大序列长度提高到 32k,通过将旋转位置嵌入(RoPE)(Su et al., 2024b)的频率基 θ 从 10k 提高到 160k,并继续训练以适应更长的序列。接下来,我们将序列长度进一步扩展到 128k 令牌,并将 RoPE 频率基 θ 的上限从 160k 提高到 500k,使用长上下文数据对模型进行训练。在此过程中,我们对序列长度超过 16k 令牌的文档进行上采样,以确保模型充分暴露于长距离依赖关系中。基准测试结果表明,这一阶段使模型能够支持长达 128k 令牌的输入序列,同时保持其在标准任务上的原始能力。

3.3.2 第二阶段:纯视觉训练

这一阶段专注于将视觉理解能力整合到预训练的语言模型中。通过精心设计对齐策略,我们确保视觉知识能够高效地融入,而不会削弱模型现有的语言能力,从而为未来的多模态学习奠定坚实的基础。

-

视觉编码器:我们首先对视觉编码器与一个较小的语言模型进行联合预训练,使用大规模的图像-文本对数据集。这一过程促使视觉编码器捕捉全面的视觉知识。

-

视觉预对齐:冻结所有 LLM 参数,同时对视觉适配器、视觉专家和视觉路由器进行训练。适配器从头开始初始化,视觉专家则是通过结构化剪枝从文本专家派生而来。这一阶段确保视觉模块能够顺利地与 LLM 骨干整合,而不会降低其性能。

-

视觉整合:解冻视觉编码器,允许对整个视觉通路进行联合优化。训练重点放在高质量的图像-文本对上,例如标题和替代文本,以对齐视觉和语言表示。

3.3.3 第三阶段:联合多模态训练

在最后阶段,我们解冻整个模型,并在标准和扩展上下文长度的多模态数据上进行联合训练。这一训练阶段使模型能够处理复杂的多模态任务,具有长上下文。

-

短上下文多模态:我们解冻整个模型,并在标准上下文长度的文本、图像和视频数据混合上进行联合训练。这一阶段作为融合阶段,巩固了模态特定的对齐。

-

长上下文多模态:最后,将联合训练扩展到 128k 上下文长度。这使得模型能够有效地泛化到长上下文的多模态任务中。

3.4 模型优化

训练多模态 MoE 模型面临着专家负载不平衡和由于输入长度变化导致的梯度不稳定的挑战。为了解决这些问题,除了标准的辅助损失和 z 损失(Lepikhin et al., 2021; Zoph et al., 2022)之外,我们引入了两种新的损失函数:路由正交化损失和令牌平衡损失。这些提出的损失函数专门设计用于促进平衡的专家利用率和稳定梯度,从而实现更稳健的优化和更有效的多模态预训练。

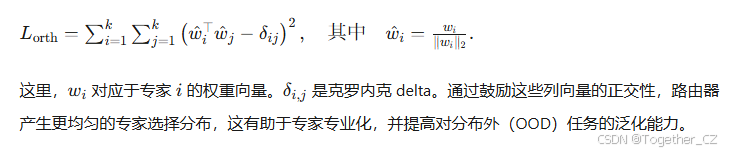

3.4.1 路由正交化损失

混合专家(MoE)模型常常面临专家同质化问题,不同的专家学习高度重叠或冗余的表示(DeepSeek-AI et al., 2024b)。为了解决这一问题,我们提出了路由正交化损失,它鼓励路由器的专家权重正交化,从而实现更平衡的路由和更好的专家专业化。

正交化损失定义如下:

与权重衰减类似,这种正交化损失仅依赖于路由器权重。直接将这一项纳入总损失会破坏 Adam 优化器(Kingma, 2014)的梯度估计,导致次优的训练动态。为了解决这一问题,我们以类似于 AdamW(Loshchilov & Hutter, 2019)的方式修改了 Adam 优化器,使得正交化损失能够直接更新路由器权重,而不会干扰 Adam 的梯度估计。在 ERNIE 4.5 中,正交化损失的系数设置为 1×10−3,与权重衰减不同,它不按学习率进行缩放。

在我们的消融实验中,加入路由正交化损失在文本基准测试中带来了 +1.44 的提升,详细内容见附录 A.1。

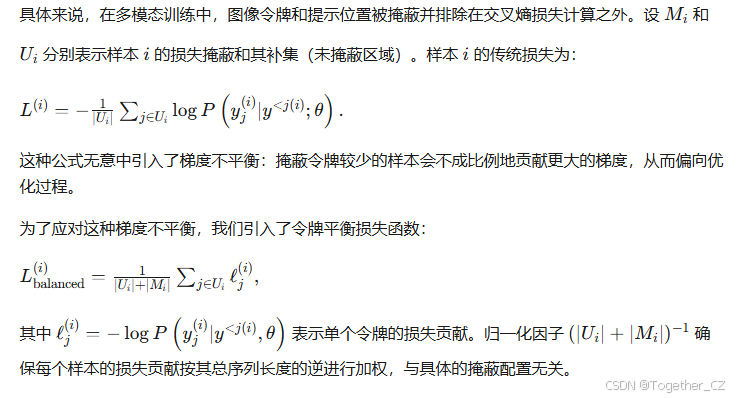

3.4.2 令牌平衡损失

传统的交叉熵损失通过对样本中所有有效令牌的平均值来计算损失。然而,在多模态训练中,只有文本令牌对损失有贡献,而它们的比例在样本之间差异显著。这种差异可能导致梯度方差大幅增加,削弱优化的稳定性和效率。为了应对这一挑战,我们提出了令牌平衡损失,它通过总序列长度对损失进行归一化,从而减少梯度方差,并在多模态设置中促进更稳定和一致的优化。

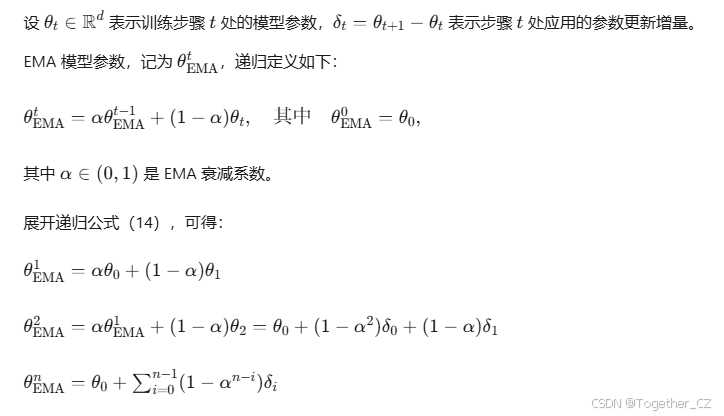

3.5 指数移动平均

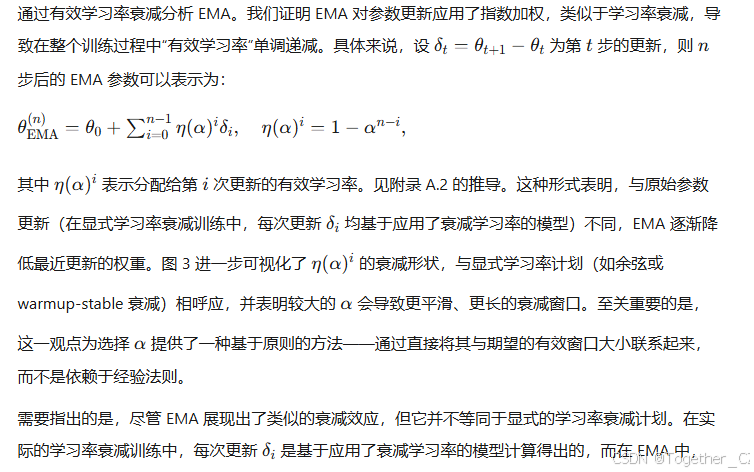

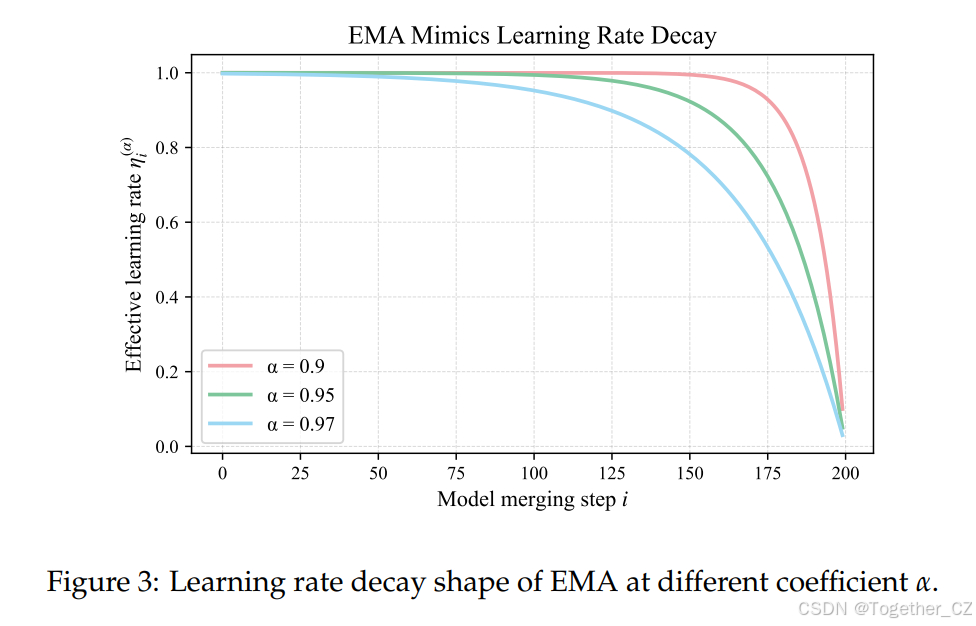

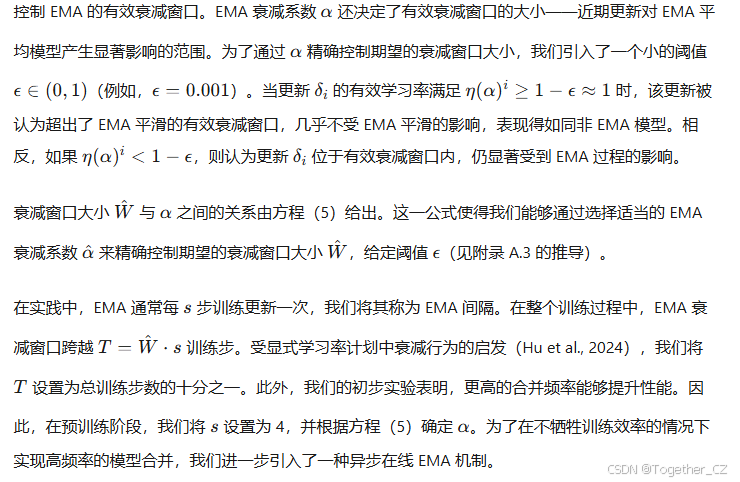

除了损失函数设计外,另一个影响训练稳定性和最终性能的关键因素是参数平滑技术的使用。指数移动平均(EMA)在大规模预训练中被广泛采用,以稳定训练动态并提高泛化能力。尽管其经验成功,但 EMA 衰减系数 α 的选择往往基于启发式方法,缺乏理论指导——特别是在大规模预训练的背景下。为了更好地理解其作用,我们进行了理论分析,并证明 EMA 可以被视为类似于学习率衰减。这一观点为通常观察到的现象提供了合理的解释:EMA 模型通常与采用显式学习率衰减计划训练的最终模型检查点相匹配(DeepSeek-AI et al., 2024b; Li et al., 2025)。基于这一见解,我们探讨了衰减系数 α 与 EMA 的有效衰减窗口之间的关系,该窗口决定了最近参数更新对 EMA 平均模型的影响程度。具体来说,我们引入了一个框架,用于控制衰减窗口的大小,以优化模型性能,这将在下一节中解释。

更新是在使用原始优化器学习率计算后才进行聚合的。然而,通过我们的实证研究,我们发现,在预训练阶段持续应用 EMA 能够实现与显式学习率衰减相当的性能。基于这一观察,我们提出了“不再衰减”的方法:与其使用重复的学习率衰减来捕捉模型的早期阶段性能,我们建议简单地使用 EMA。

我们实现了一种异步在线 EMA 机制,它能够通过将 GPU 参数直接卸载到主机内存中,而不会中断训练循环,从而实现极高频率的 EMA。一个独立的基于 CPU 的工作线程异步执行 EMA 累积操作,并定期将生成的检查点写入磁盘。相关的代码已在 PaddleNLP 中开源,以促进进一步的研究。

4 后训练

我们的模型设计允许在多模态预训练后干净地分离纯文本和视觉相关组件。具体来说,通过移除多模态专家、视觉编码器和适配器层,模型可以简化为一个纯语言模型,能够更高效地应用于纯文本场景。利用这种模块化设计,我们对文本特定参数进行了后训练,以获得针对纯文本任务优化的 ERNIE-4.5。完整的多模态模型参数,包括文本和视觉组件,则进一步微调以获得多模态模型 ERNIE-4.5-VL。

4.1 语言模型的后训练

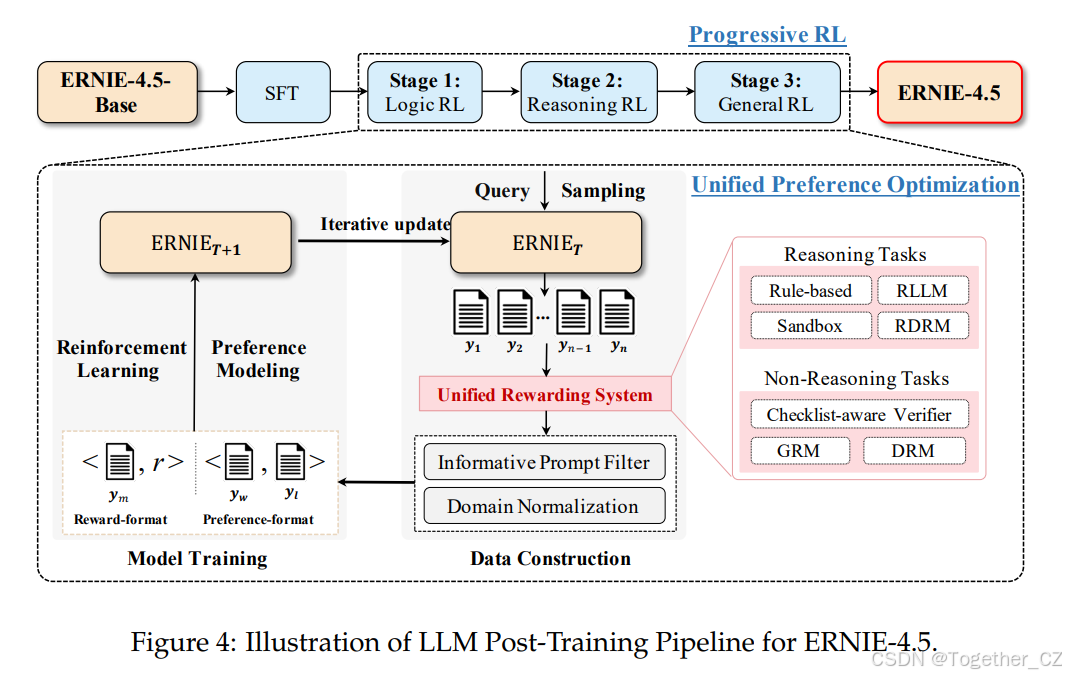

整个语言模型(LLM)的后训练流程如图 4 所示。后训练的第一步是监督式微调(SFT),如第 4.1.1 节所述。然后,利用从统一奖励系统中获得的见解进行强化学习,以进一步提升和微调模型性能。在第 4.1.2 节和第 4.1.3 节中,我们分别阐述了我们的统一奖励系统和强化学习方法。

4.1.1 监督式微调

本节详细描述了 ERNIE-4.5 的监督式微调(SFT)过程。为了最大化模型的效能,我们开发了一个系统性的分类体系,将监督式微调(SFT)数据划分为十个不同的主题领域。具体而言,我们构建了一个涵盖科学与数学、编程、逻辑、信息处理、创意写作、多语言、知识问答、多轮对话与角色扮演以及安全性的全面主题领域套件。

此外,SFT 数据还被系统地划分为推理和非推理任务。推理数据包含复杂的任务,需要扩展的推理链(CoT),以确保这些任务的复杂性和多样性得到充分捕捉。相比之下,非推理数据包含不需要深入推理的任务,但确保这些数据的准确性和简洁性对于提升模型的整体性能和多功能性至关重要。

此外,SFT 数据质量与多样性的重视构成了后续强化学习(RL)阶段的基础。为了进一步增强 SFT 数据的多样性,我们在推理任务的某些查询下引入了具有不同推理内容的多个响应。这一举措对于提升模型的基础能力至关重要,并为模型在强化学习(RL)训练过程中进行探索提供了必要的弹性。基于上述方法,我们构建了一个包含 230 万样本的 SFT 数据集,并在该数据集上平均进行了两次训练周期,以优化模型性能。

4.1.2 统一奖励系统

本节展示了用于后续强化学习的统一奖励系统。该系统精心设计,以适应推理和非推理任务,采用不同的奖励组合。它提供精确且全面的反馈信号,便于偏好学习,为后续的偏好优化(如第 4.1.3 节所述)奠定基础。

对于需要精确性和严格遵循预定义标准的推理任务,我们优先部署基于规则的验证器。然而,基于规则的验证器固有地存在泛化能力有限的问题。为了缓解这一限制并提高推理任务中反馈的准确性,我们引入了额外的补充机制。

-

参考引导的 LLM 作为法官(RLLM):参考引导的 LLM 作为法官组件利用大型语言模型(LLM)的先进能力,作为公正的评估者,严格将模型生成的输出与定义良好的参考答案语料库进行基准测试。

-

沙盒:沙盒是一个安全且隔离的测试环境,旨在支持与编程相关的计算任务的执行和系统评估。通过在受控且隔离的环境中运行,模型生成的响应经过严格的测试,直接评估其功能性、正确性、可靠性和对指定要求的遵循性。

-

参考引导的判别奖励模型(RDRM):受到参考引导的 LLM 作为法官成功的启发,我们引入了一种新颖的参考引导的判别奖励模型(RDRM)。与传统模型独立工作不同,我们的 RDRM 在评分过程中明确地以参考答案为指导。与传统的闭卷考试要求模型仅依赖内部知识不同,我们的 RDRM 转变为开卷考试,确保模型的输出与参考答案的内容和结构特征紧密对齐,从而保证全面覆盖。

在非推理任务的背景下,这些任务本质上是开放式的,并且依赖于个人的解释性判断,我们实施了一种专门针对这些特定认识论特征的方法论范式:

-

检查表感知验证器:我们引入了一种新颖的方法,称为检查表感知验证器,它受到 RLVR(Lambert et al., 2024; DeepSeek-AI, 2025)的启发。我们的方法首先精心定义了一组明确的标准。这些标准被精心设计为清晰可定义且客观可评估的,以确保模型输出能够达到既定的规范标准。

-

生成性奖励模型(GRM):通过进一步推进评估过程,GRM 引入了多维度评估标准和动态反馈机制,为每个查询提供定制化评估,从而实施更系统、更细致的评估,增强评估结果的准确性和稳健性。

-

判别性奖励模型(DRM):判别性奖励模型(DRM)构成了经典强化学习框架的一个基本组成部分,其中奖励函数通过判别任务学习得出,有效地引导模型产生更准确地与既定目标对齐的输出。

通过系统地针对推理和非推理任务的不同要求定制我们的奖励系统,ERNIE-4.5 能够在多样化应用中展现出增强的熟练度。统一的奖励系统不仅显著提升了模型的整体性能,而且有助于更细致地阐明人类判断中固有的偏好和评估标准,从而促进更细致、更复杂且与人类更一致的互动。

4.1.3 强化学习

我们在 PPO(Schulman et al., 2017; Ouyang et al., 2022)框架内进行 ERNIE-4.5 的强化学习训练过程。为了增强训练的稳定性并优化模型的最终性能,我们引入了我们强化学习训练配方的关键技术:

-

进阶强化学习(PRL):PRL 实施了一个三阶段的强化学习(RL)算法,如图 4 所示,采用了逐步推进的方式:(1)在初始阶段,模型仅在逻辑语料库上进行训练,这系统地构建了逻辑分析和抽象推理的坚实基础能力,为后续的所有学习阶段奠定了基石。(2)进入第二阶段,训练语料库主要涵盖数学和编程代码。这一阶段促使模型将抽象推理技能转移到对结构表达性和可执行精度要求更高的任务中。(3)在第三阶段,模型在包含非推理和推理任务的一般数据集上进行训练,通过系统地利用早期阶段所获得的知识,增强了模型在广泛任务上的泛化能力。

-

统一偏好优化(UPO):在传统的强化学习算法如 PPO 中,训练旨在最大化与每个给定查询生成的单个响应相关的预期奖励,缺乏明确的成对比较信号来指导学习过程。我们引入了一种新颖的 UPO 策略。具体来说,UPO 将成对偏好建模损失,即直接偏好优化(DPO)损失,整合到 PPO 框架中。基于构建成对偏好数据的不同方式,UPO 算法可以分为在线和离线版本。在线-UPO 通过在每个强化训练迭代中对每个查询生成的多个响应应用拒绝采样策略来构建偏好对,而离线-UPO 则在 RL 训练过程之前预先生成所有查询的偏好数据。通过整合能够捕捉行为实质性差异的偏好对进行学习,UPO 算法不仅增强了强化学习训练的稳定性,而且有效降低了奖励信号不可靠的风险。

与传统强化学习不同,我们针对第 4.1.2 节中提到的推理和非推理任务,系统地开发了专用数据,以利用第 4.1.1 节中介绍的验证器和奖励模型。这些任务导致了奖励分数范围和分布的显著差异。为了进一步增强训练稳定性并优化模型的最终性能,我们实施了一系列改进。具体来说,我们排除了准确率为 1 或 0 的提示相关数据集,其奖励信号具有明确的可验证性。对于剩余的提示,我们根据每个样本组内奖励信号的组内方差进行过滤。换句话说,与组内方差微不足道的样本组对应的提示(表明缺乏区分性信息)被排除在训练过程之外。此外,在每个训练迭代中,来自验证器和奖励模型的奖励首先被分离,并根据特定的主题领域进行分层,形成多个主题领域特定的子集。每个子集独立地应用奖励归一化。经验评估表明,这些改进有效地减少了不同来源和领域之间奖励信号的异质性,从而在强化学习过程中增强了稳定性和收敛性。

4.2 视觉语言模型的后训练

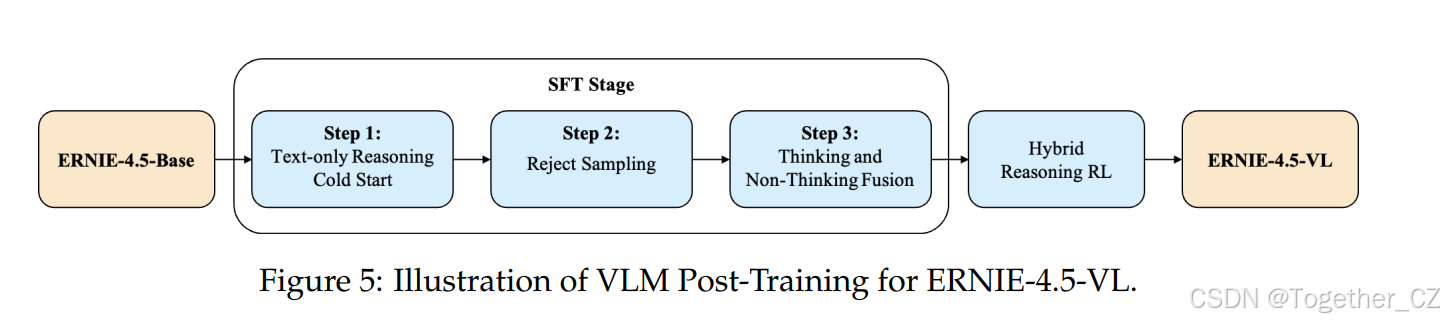

整个视觉语言模型(VLM)的后训练过程如图 5 所示,包括三个监督式微调(SFT)阶段和一个强化学习阶段。值得注意的是,第三个 SFT 阶段旨在结合思考和非思考数据,目标是促进一般视觉理解和复杂的视觉推理能力。

4.2.1 监督式微调

我们设计了一个监督式微调框架,以增强多模态模型的两个关键方面:图像理解和推理能力。因此,我们专注于通过目标数据构建来增强视觉感知能力,并通过渐进式训练策略统一思考和非思考行为。

数据。在训练过程中,我们观察到某些具有挑战性的任务——如拼图测试、几何问题、函数分析和图表解释——需要强大的推理能力,然而视觉语言模型(VLMs)常常在基础感知理解方面存在困难(Rahmanzadehgervi et al., 2024; Chen et al., 2024)。尽管增强这种感知能力至关重要,但一个主要障碍是自然语料库中缺乏密集的图像-标题对。

为了克服这一问题,我们合成了大量的感知数据,包括程序生成的拼图(Ghosal et al., 2024)、几何图形和数学函数。这些合成数据集允许对空间布局和结构属性进行精细控制,从而生成高质量的视觉-文本对,最大限度地减少歧义。然而,合成数据虽然干净且可扩展,但缺乏真实世界图像的视觉多样性、噪声和上下文丰富性——限制了其泛化能力,并促使我们转向对真实 STEM 图像进行重新描述。

因此,我们在大规模的真实 STEM 图像集合上进行了精细的标题合成。与合成数据不同,真实图像需要既信息丰富又具有抗幻觉性的标题。为此,我们的流程将从策划的数据集中提取问题-答案对。标题由 VLM 生成并经过验证,通过重复推理由文本模型进行验证。只有能够产生一致正确答案的样本才被保留。此外,我们过滤掉了可以通过可见文本(例如 OCR)解决的样本,确保需要视觉理解。

通过在后训练中整合这种合成的感知数据,我们在模型理解视觉复杂 STEM 任务(包括拼图测试、数学问题解决等)方面取得了显著进展,从而为模型的图像理解能力奠定了坚实的基础。附录 B.1、B.2 和 B.3 中提供了更多示例。

思考和非思考联合训练。在冷启动阶段为高质量多模态推理模型获取数据面临重大挑战。尽管手动注释样本可以确保高准确性,但往往在多样性和覆盖范围上不足。为了克服这些挑战,降低广泛手动注释的高昂成本,我们提出了一个三阶段渐进式训练框架,利用跨模态迁移能力和专家合并技术。

-

第一步:纯文本推理冷启动。我们收集了一个涵盖数学、科学、代码生成、指令遵循和对话的多样化纯文本推理数据集。为了确保高质量的推理监督,我们应用了基于代理和基于规则的过滤器组合,以去除存在逻辑缺陷的样本,包括循环推理、矛盾和概念错误。值得注意的是,尽管该模型仅在策划的纯文本数据上进行训练,且从未接触过视觉输入,但它在推理时表现出新兴的多模态推理行为,例如产生诸如“让我再看看图像”之类的反思提示。

-

第二步:拒绝采样用于多模态增强。在此第一步模型的基础上,我们采用拒绝采样为视觉相关能力生成推理数据,涵盖 STEM、理解任务、图表和文档分析以及创意写作。这一过程系统地扩展了推理能力的覆盖范围,同时通过可验证的奖励机制确保数据质量。此外,在 RL 训练阶段,我们通过验证系统持续跟踪更高质量的响应轨迹。这些优越的轨迹被持久记录,并在每个强化学习训练迭代中逐步纳入,以更新和丰富我们的监督式微调(SFT)多模态推理数据集。

-

第三步:思考和非思考融合。在第二步通过目标数据生成增强了多模态推理能力之后,我们通过两种方法将推理和非推理能力统一到一个模型中:

-

思考和非思考数据的混合训练:我们使用推理(在第二步中生成)和非推理数据集进行联合训练。对于所有非推理数据,我们在响应中前置空的思考标签

<think>\n\n</think>,并将这些标签掩蔽并排除在梯度更新之外。这种方法使模型能够在保留推理能力的同时保持非推理能力。 -

专家合并:遵循 DeepSeek-R1T-Chimera(GmbH, 2025)的思路,我们通过将非推理模型的多模态专家转移到推理模型中来合并思考和非思考模型的专家。这种融合策略创建了一个统一的模型,该模型同时具备推理和非推理能力,其中非推理性能超过了原始基线。这种方法使我们能够有效地将具有不同推理和视觉感知优势的模型结合起来。

-

这种渐进式训练方法成功地解决了多模态推理模型的冷启动挑战,同时在推理和非推理任务中均实现了卓越的性能。

4.2.2 具有可验证奖励的强化学习

强化学习与可验证奖励(RLVR)(DeepSeek-AI, 2025; Lambert et al., 2024)已成为提高多模态语言模型在可验证性领域对齐和性能方面的一个关键范式。在本节中,我们介绍了我们在多模态 RL 训练中采用的可验证奖励机制的几种任务类型。这些任务包括视觉 STEM、视觉拼图和 UI2Code(Chen et al., 2018)。

视觉 STEM。视觉 STEM(科学、技术、工程和数学)问题由图像基础问题及其对应的答案组成,这使得它们特别适合用于 RLVR。我们从开源资源和专有的 K-12 教育资源中策划了一系列视觉 STEM 问题。与 Guo et al.(2025)类似,我们将多项选择题重新构造成开放式格式,以防止模型随机猜测。此外,我们过滤掉了模型始终正确或错误回答的问题,因为这些问题对学习进展贡献甚微,降低了训练效率。这一策划流程确保了一个高质量、具有挑战性的数据集,有利于有效的策略学习。

视觉拼图。视觉拼图是基于图像的推理任务,需要视觉感知和认知推理才能得出正确答案,包括模式识别和图形推理。我们合成了一组包含 10k 个视觉拼图及其经过验证的解决方案的数据集,用于 RLVR 训练。视觉拼图数据的预处理遵循了与视觉 STEM 任务类似的方法。与传统的验证方法不同,该方法要求模型在最终答案中使用 \boxed{} 格式进行输出,并通过字符串匹配来评估正确性(DeepSeek-AI, 2025),我们采用两个大型语言模型(LLMs)来评估策略模型响应的正确性。一个 LLM 用于评估响应中是否存在任何内部不一致或冲突答案,而另一个 LLM 验证最终答案的正确性。只有当两个 LLM 都返回肯定评估时,响应才被视为正确。这种评估策略不对策略模型的输出格式施加约束,从而允许更灵活、更具泛化性的输出。

UI2Code。为了增强模型在实际多模态应用中的能力,我们收集了 UI2Code(Chen et al., 2018)和 Image2Struct(Roberts et al., 2024)数据集,这些数据集侧重于从 UI 设计图像生成 HTML 代码。我们部署了一个 UI2Code 验证环境,该环境评估从用户提供的参考图像(通常是 UI 设计草图)渲染的 HTML 与用户提供的参考图像之间的视觉保真度。这确保了 VLM 能够产生在语法上正确且在视觉上忠实的 HTML 表示。

混合强化学习。为了使模型在推理和一般能力方面表现出色,我们设计了一个统一的强化学习框架,整合了 RLVR 和人类反馈强化学习(RLHF)(Ouyang et al., 2022)。因此,我们开发了一个基于 Bradley-Terry 奖励建模目标的多模态奖励模型。奖励模型从 ERNIE-4.5-Base 初始化,以有效处理包含视觉输入的查询。我们采用 GRPO(Shao et al., 2024)作为我们的强化学习算法,并引入了 DAPO(Yu et al., 2025)的改进,包括动态采样、过度采样过滤等。这些策略共同确保了稳定的训练动态,并增强了探索能力。

5 训练框架

ERNIE 4.5 的训练得到了 PaddlePaddle(Ma et al., 2019)的支持。多模态模型的固有异构性与大规模 MoE 架构相结合,为分布式训练带来了显著的系统挑战。我们引入了一个优化的训练框架,具有以下关键创新:

-

多模态模型训练的异构并行性:ERNIE 4.5 结合了一个 ViT 编码器和一个大规模 MoE 主干。这些组件在参数规模、计算复杂性和内存需求方面的根本差异,为同构并行策略带来了挑战。为了缓解这一问题,我们引入了异构并行策略,以实现高效的联合训练。此外,我们提出了分层负载平衡方法,以增强可变分辨率训练的扩展效率。

-

MoE 主干的混合并行性:通过与 ERNIE 4.5 架构的精心共设计,我们实现了节点内专家并行性,以消除跨节点全连接通信的开销。此外,我们提出了一种内存高效的流水线调度方法,以减少大规模训练中的激活内存。

此外,我们还引入了其他显著的优化,以进一步提高训练性能和稳定性。

-

FP8 混合精度训练:我们引入了一个 FP8 混合精度训练框架,具有精细的内存优化、精心设计的操作融合和通信优化。每个操作和通信的精度都经过精心设计,以同时最大化训练吞吐量,同时保持收敛性。

-

计算优化:为了最小化重计算开销,我们提出了一种优化的重计算策略,以实现最佳的计算-内存权衡。我们还整合了 FlashMask(Wang et al., 2025),以加速注意力操作。

-

框架原生容错系统:我们引入了一个与训练框架深度集成的容错系统,以克服大规模训练中频繁故障的挑战。特别是,我们提出了零成本检查点技术,这是一种卓越的检查点方法,以最小化中断成本。

我们的最大 ERNIE 4.5 语言模型采用了 8 路专家并行性(EP)(Lepikhin et al., 2021)、12 路流水线并行性(PP)(Huang et al., 2019)和 ZeRO-1 数据并行性(DP)(Rajbhandari et al., 2020)配置。通过上述全面的优化,我们在 2016 个 NVIDIA H800 GPU 上,使用 4096 序列长度和 15120 全局批量大小,实现了 47% 的模型 FLOPs 利用率(MFU)。

5.1 多模态模型训练的异构并行性

5.1.1 异构并行架构

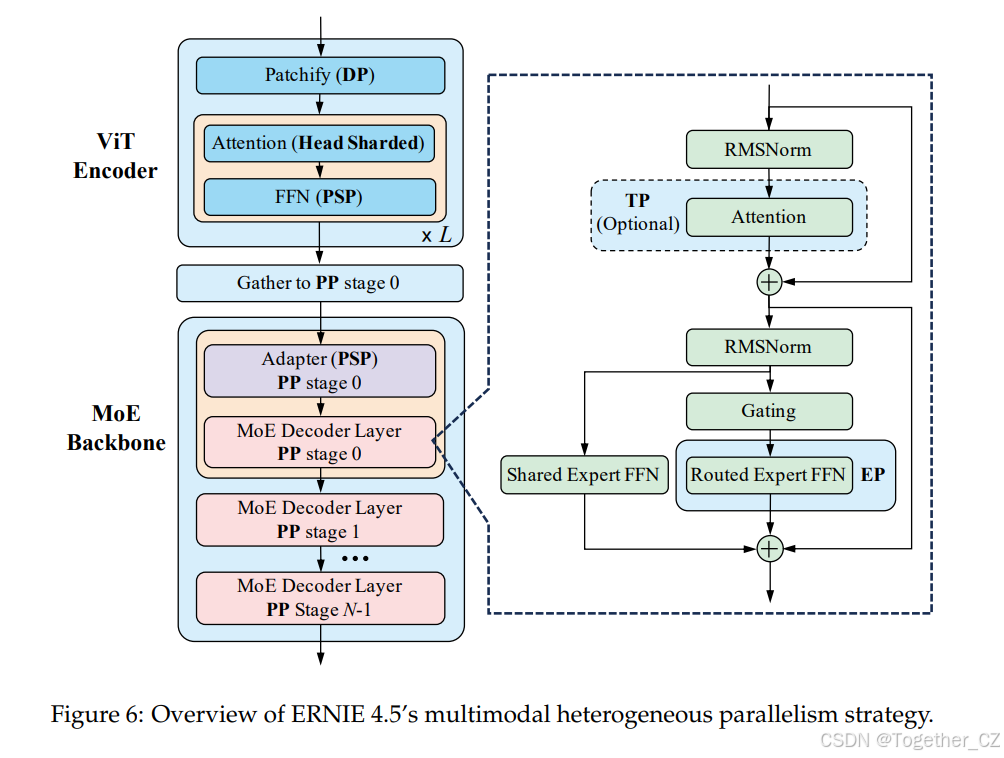

如图 1 所示,ERNIE 4.5 支持混合文本、图像和视频输入的统一训练。对于 ERNIE-4.5-VL-424B-A47B-Base,视觉输入(图像和视频)由一个统一的 ViT 编码器处理,该编码器包含 6.3 亿参数。这个编码器与一个大规模 MoE 主干网络联合训练,总参数量为 4240 亿,其中 470 亿参数在计算中被激活。

大规模 MoE 主干需要混合并行训练,结合专家并行性(EP)、流水线并行性(PP)和可选的张量并行性(TP)(Shoeybi et al., 2019),并集成 ZeRO-1 数据并行性(DP)。然而,如果将 ViT 编码器仅放置在 MoE 主干的第一流水线阶段,这将导致流水线阶段之间出现严重的负载不平衡,显著降低训练效率。鉴于其相对较小的参数量,ViT 编码器更适合采用数据并行性。为了实现 ViT 编码器和 MoE 主干的高效联合训练,我们提出了图 6 所示的异构并行策略。ViT 编码器的参数在所有设备上进行复制,并且 ViT 编码器的数据并行维度嵌套在 MoE 主干的混合并行拓扑结构中。图 6 中 ViT 编码器和适配器的内部并行架构将在第 5.1.2 节中详细介绍。

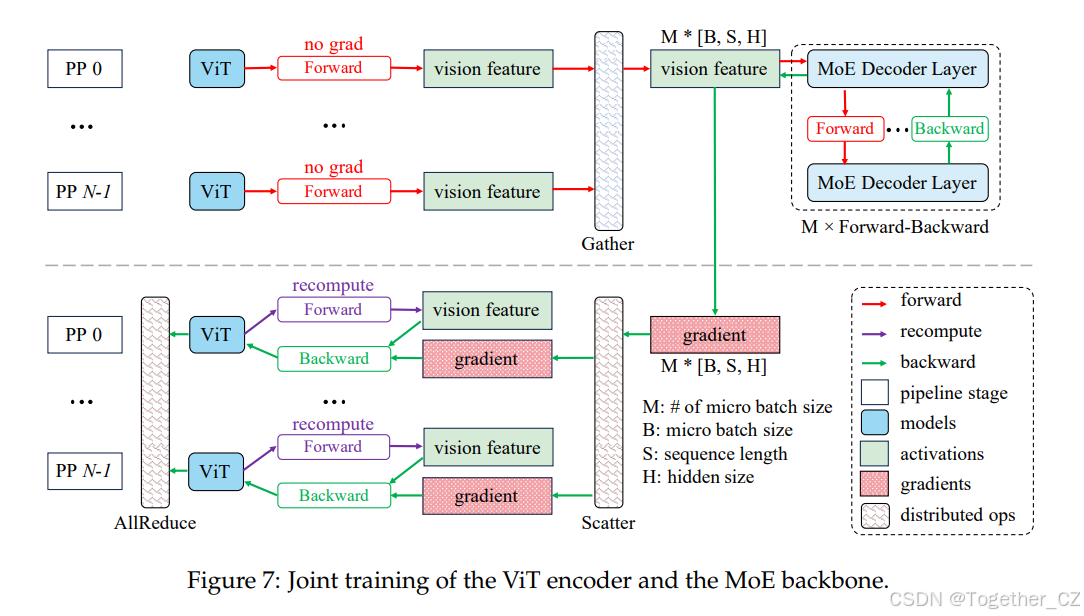

在前向传播过程中,每个设备上的 ViT 编码器独立计算视觉特征。这些特征随后被聚集到 MoE 主干的第一流水线阶段。随后的前向传播通过 MoE 主干的流水线并行阶段进行。然而,在反向传播过程中,ViT 编码器参数的梯度无法直接计算。这是因为流水线并行的自动微分反向传播自然地在 MoE 主干的第一模块结束,而不是 ViT 编码器。

为了解决这一挑战,我们在图 7 中实现了一个定制的反向传播机制,以训练 ViT 编码器。在 MoE 主干完成反向传播后,所有视觉特征梯度在第一流水线阶段可用。这些梯度随后被分散到 MoE 主干的每个流水线阶段,使得每个具有不同数据并行等级的 ViT 编码器能够接收其本地视觉特征的特定梯度。通过这种方式,我们可以在 ViT 编码器上执行标准的自动微分反向传播。最后,由于 ViT 采用数据并行模式,其参数梯度应通过跨所有设备的全归约通信进行同步,以确保一致的参数更新。值得注意的是,ViT 编码器的重新计算在图 7 中是可选的,它有助于减少 ViT 编码器的激活内存。

5.1.2 分层负载平衡策略

ERNIE 4.5 支持输入图像和视频具有任意且连续变化的分辨率,增强了其适应性。为了支持可变分辨率的 ViT 编码器训练,我们将不同分辨率的图像或视频帧的补丁组合成打包序列(Dehghani et al., 2023a)。然而,多模态数据存在显著的不平衡挑战:图像和视频数据不仅在空间分辨率上存在差异,而且视频数据由于时间长度变化而表现出更严重的不平衡。因此,每个训练样本的打包序列数量以及每个打包序列的令牌数量都存在显著差异。这种差异导致不同数据并行等级的 ViT 编码器之间在计算和内存使用上出现极端不平衡。

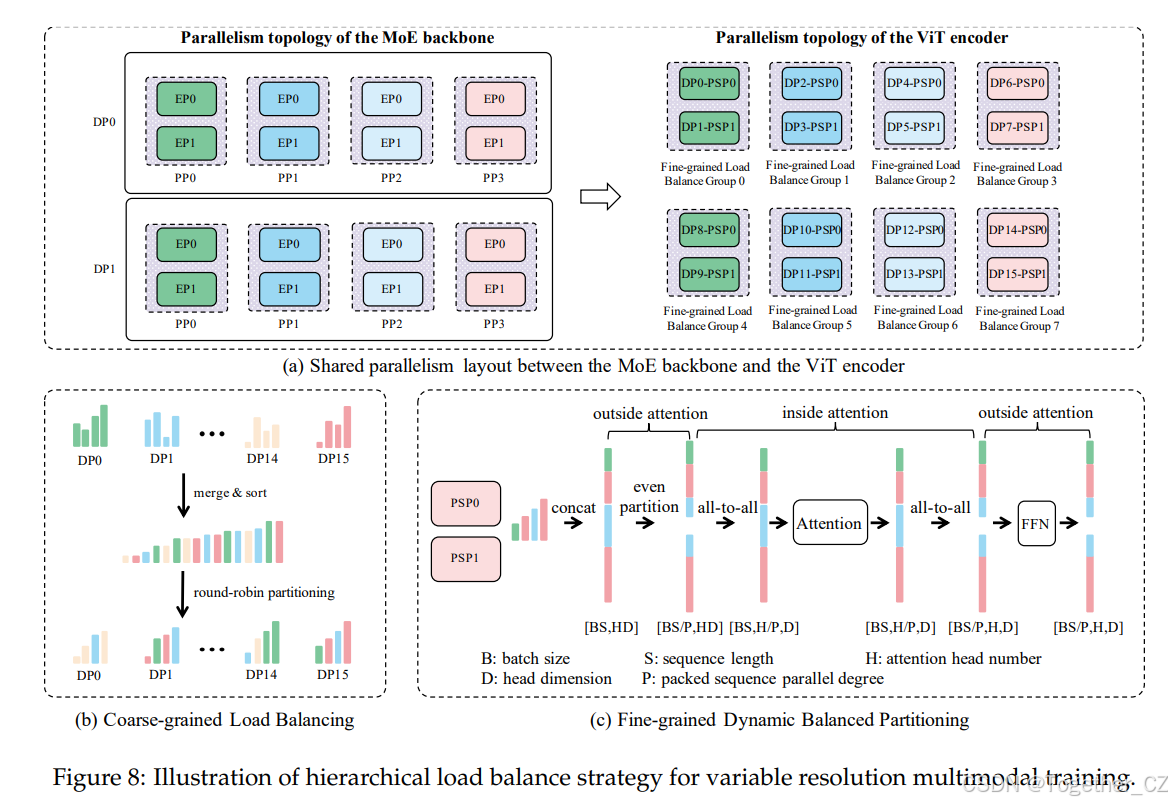

为了解决这些挑战,我们提出了一个分层多模态负载平衡策略,如图 8 所示。我们的负载平衡方法总结如下:

第一层:粗粒度负载平衡。首先,我们收集并按令牌数量对所有打包序列进行排序,然后使用轮询分区算法将它们分配给每个设备,以确保每个设备的总令牌数量大致平衡。这种打包序列的重新分配实现了粗粒度的计算和内存负载平衡,如图 8(b) 所示。

第二层:细粒度动态平衡分区。由于每个打包序列中的令牌数量自然存在差异,即使在粗粒度负载平衡之后,每个设备上的总令牌数量也可能相差很大。具体来说,我们在注意力操作之外和内部进行动态分区方法,以进一步实现负载平衡,如图 8(c) 所示:

-

注意力操作之外:我们提出了一种打包序列并行(PSP)策略,用于注意力操作之外的算子。与 MegatronLM(Korthikanti et al., 2023)中基于张量并行的序列并行不同,我们的打包序列并行方法通过连接打包序列并沿序列长度维度均匀分割来实现。这种打包序列并行策略也应用于图 6 中的适配器模块。

-

注意力操作内部:由于注意力操作需要完整的序列长度维度,我们在注意力计算之前执行一次全连接通信,以交换序列长度和注意力头维度。在注意力计算完成后,这些维度再次交换,以恢复打包序列并行。

通过我们的分层负载平衡策略,计算、内存和通信资源的利用效率显著提高。实验结果表明,与没有负载平衡的基线方法相比,ERNIE-4.5-VL-424B-A47B-Base 在端到端多模态训练中实现了高达 32% 的整体性能提升。

5.2 MoE 主干的混合并行性

为了有效扩展我们最大 ERNIE 4.5 语言模型的训练,我们在文本预训练中采用了三维并行性,具体为专家并行性、流水线并行性以及 ZeRO-1 数据并行性。对于多模态模型预训练,我们引入了张量并行性,以适应增加的序列长度和额外的视觉专家参数。

此外,我们引入了几种技术来优化内存占用并减少通信开销,最终提高大规模 MoE 模型训练的效率。这些创新确保了我们的方法在大规模 MoE 模型训练中具有卓越的可扩展性和性能。

5.2.1 节点内专家并行性

我们设计模型架构和配置,以避免昂贵的跨节点专家并行通信。通过将专家并行通信限制在节点内,我们基于 NCCL 兼容的集体原语实现 MoE 全连接通信。这种方法在 ERNIE 4.5 上实现了与 DeepEP 基于 MoE 的实现(Zhao et al., 2025)相当的端到端吞吐量,并且可以轻松部署在没有 NVIDIA GPU 和 InfiniBand(IB)网络的 AI 集群上。

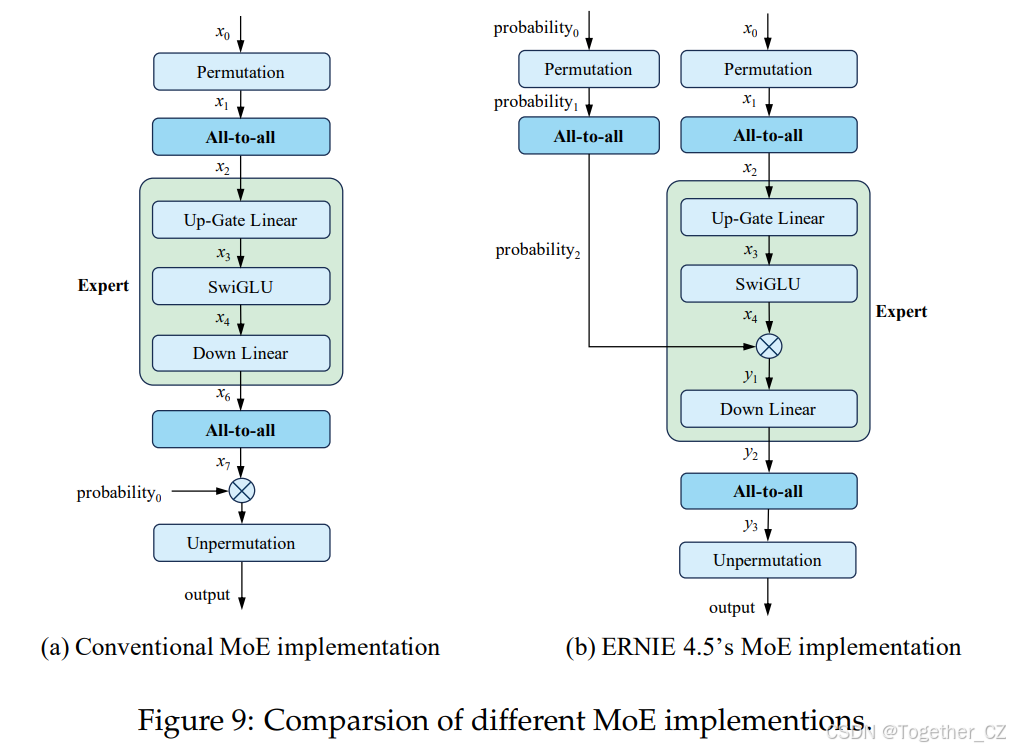

如图 9(a) 所示,传统的 MoE 实现将门控概率乘法运算符应用于第二次全连接通信之后。这种方法需要保留第二次全连接通信的输出张量以用于反向传播,从而对内存造成显著压力。我们的解决方案如图 9(b) 所示,将门控概率乘法运算符重新定位到专家计算块内。这种架构修改允许在使用后立即释放第二次全连接通信的输出张量。尽管引入了轻微的额外开销,包括概率置换和一个额外的轻量级全连接操作,但这种优化显著减少了峰值内存使用量,并消除了反向传播中的许多重计算。

5.2.2 内存高效的流水线调度

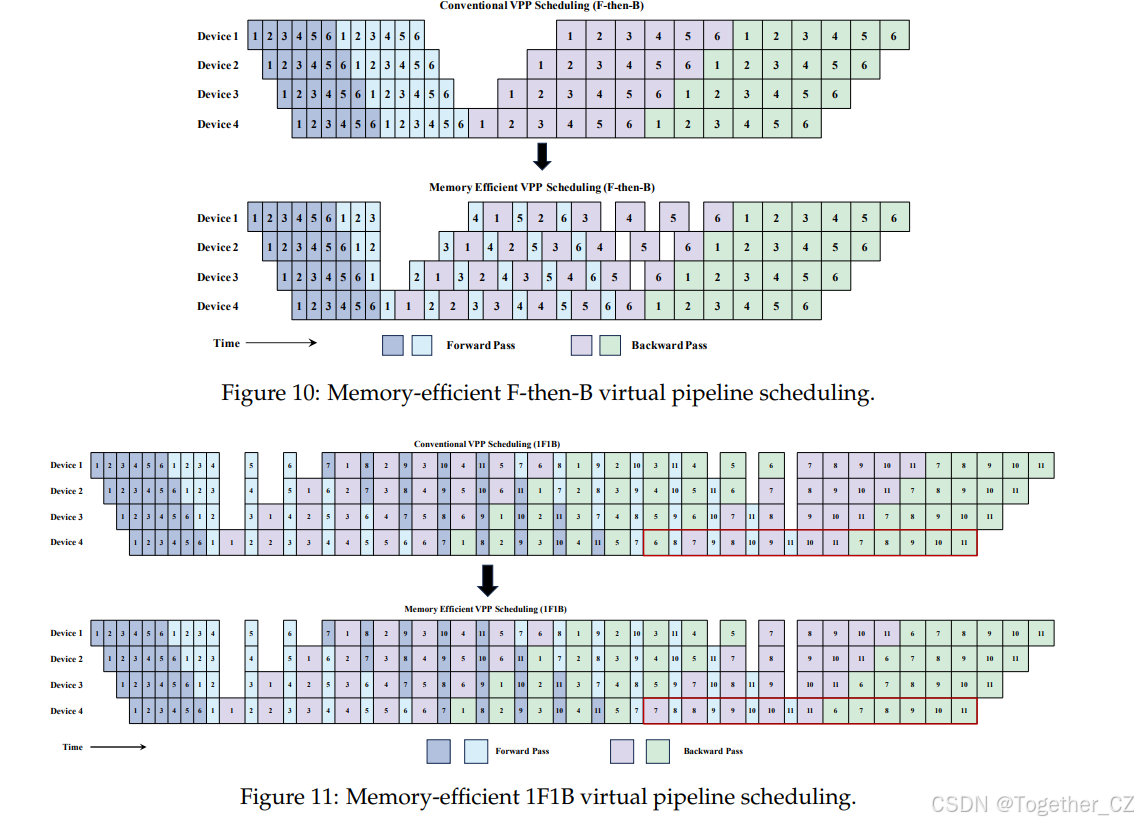

在扩展到更大集群训练时,保持固定全局批量大小需要减少梯度累积步数,这反过来又增加了流水线气泡时间分数,显著降低了训练吞吐量。虚拟流水线并行(VPP)(Narayanan et al., 2021)通常用于减少流水线气泡时间分数。

一般来说,VPP 的第一流水线阶段预计会消耗最多的激活内存。然而,最后一个流水线阶段涉及损失函数的计算,这可能成为内存瓶颈。为了解决这个问题,我们提出了一种内存高效的虚拟流水线调度策略。一旦最后一个流水线阶段完成损失函数的前向计算,它立即开始其反向计算,并释放损失函数的激活内存。通过这种方式,最后一个流水线阶段最多只保留一个 VPP 分块的激活内存。图 10 和 11 分别展示了我们在前向-然后-反向(F-then-B)和一次前向一次反向(1F1B)情况下的内存高效流水线调度。

当梯度累积步数少于流水线并行度的两倍时,我们只能使用 F-then-B 调度方法。在这些情况下,我们提出了一种参数梯度释放技术,以减少内存使用。在每个训练步骤结束时,我们释放分配给参数梯度的内存。参数梯度释放方法显著减少了 F-then-B 调度中的峰值内存使用,特别是在使用 BF16 或 FP8 混合精度训练时保持 FP32 梯度的情况下。

为了在保持高频率模型合并的同时不牺牲训练效率,我们进一步引入了一种异步在线 EMA 机制。该机制通过将 GPU 参数直接卸载到主机内存中,而不会中断训练循环,从而实现极高频率的 EMA。一个独立的基于 CPU 的工作线程异步执行 EMA 累积操作,并定期将生成的检查点写入磁盘。相关的代码已在 PaddleNLP 中开源,以促进进一步的研究。

5.3 FP8 混合精度训练

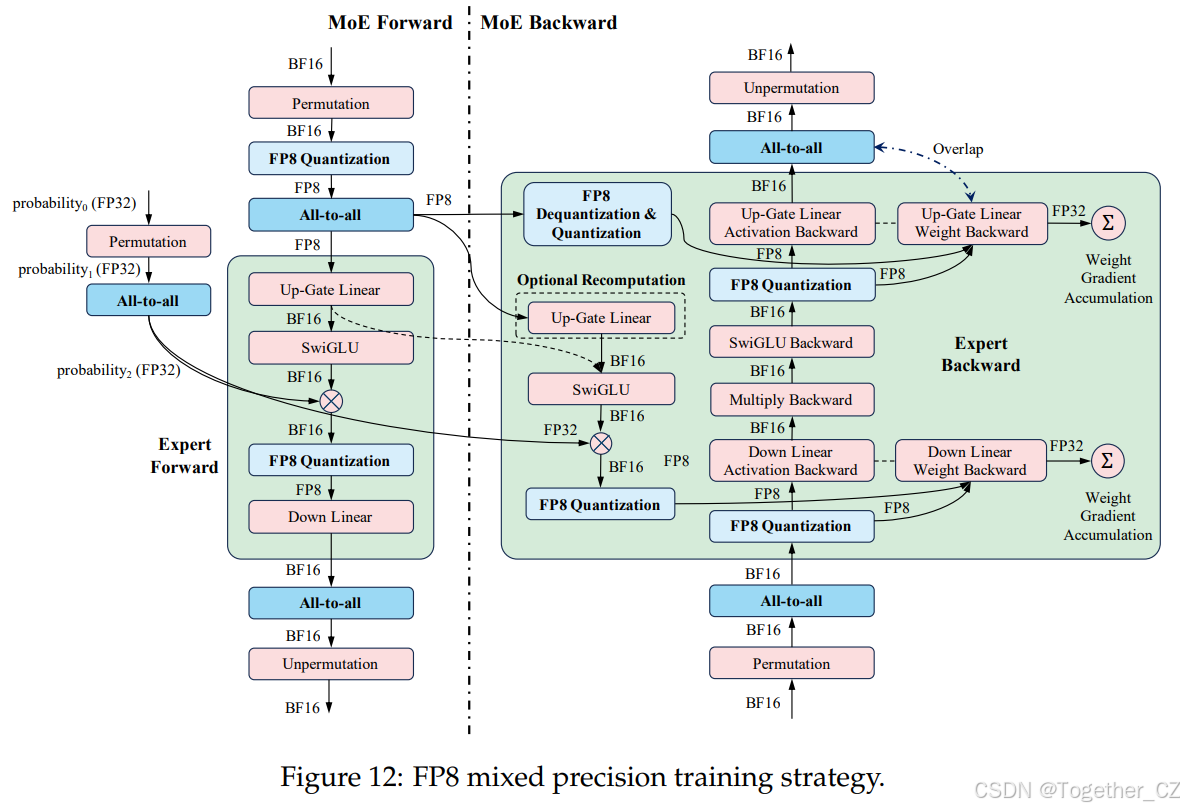

FP8 格式(Micikevicius et al., 2022)将比特宽度减半,与 BF16 相比,提供了显著的优势,包括在大规模模型训练中的计算吞吐量提高、内存消耗减少和通信开销降低(NVIDIA, 2024; Peng et al., 2023; torchao, 2024)。ERNIE 4.5 采用了与 DeepSeek-V3(DeepSeek-AI et al., 2024b)类似的量化策略,在 MoE FFN 模块中使用 E4M3 FP8 数值格式,并采用在线量化策略,该策略采用块量化用于权重和瓦片量化用于激活。ERNIE 4.5 的 FP8 混合精度训练策略如图 12 所示。我们强调从高效端到端 FP8 训练的工程见解,以造福社区。

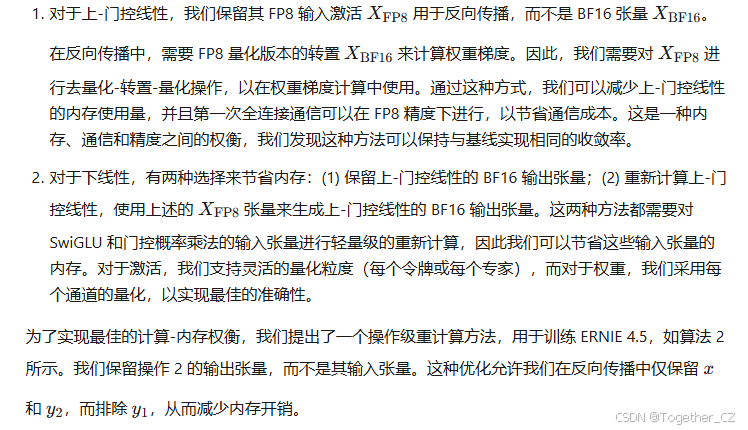

在 FP8 训练中,主要的内存节省优势使得我们能够减少最昂贵的重计算,以提高吞吐量。在 MoE FFN 模块中,主要的激活内存来自上-门控线性、下线性、SwiGLU 和门控概率乘法的输入激活。

为了开发最佳的重计算策略,我们对模型中的每个操作进行了详细分析,评估其内存使用量与计算时间。通过选择性地将操作级重计算应用于最具成本效益的操作——那些在内存节省方面显著且运行时惩罚最小的操作——我们开发了一个最佳的检查点方案,以最大化训练效率。

5.4 计算优化

5.4.1 重计算与最佳计算-内存权衡

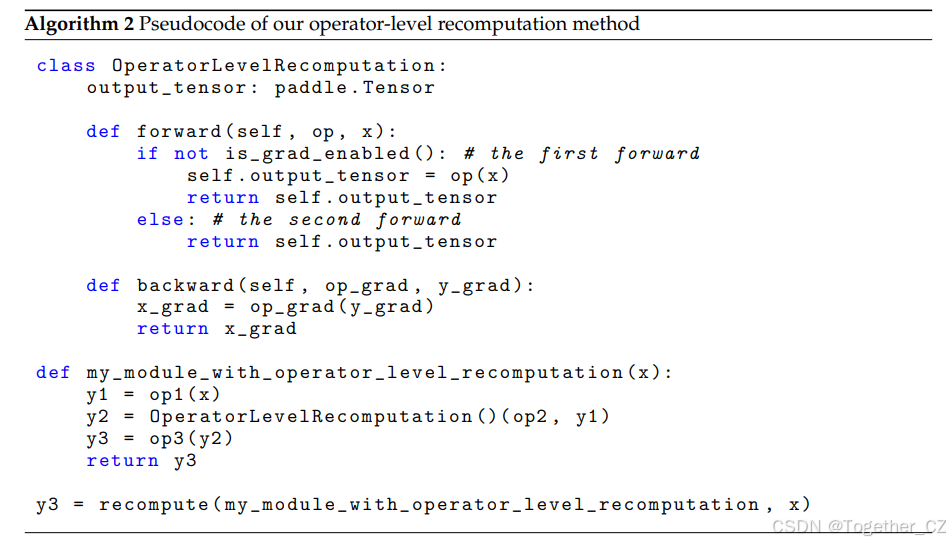

传统的重计算策略在模块级别进行,以最小化计算开销,专注于成本效益的模块。相比之下,ERNIE 4.5 采用操作级重计算策略,提供更精细的内存与计算权衡,从而进一步优化训练性能。

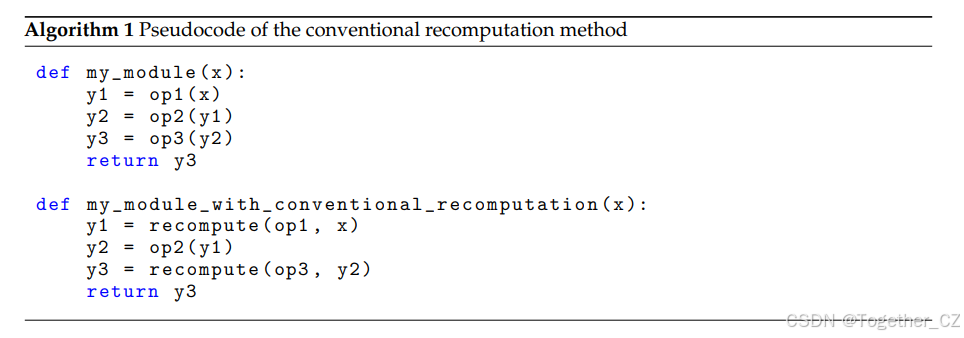

考虑算法 1 中的三个操作:op1、op2 和 op3,每个操作都需要保留输入张量以用于反向传播。如果选择不对 op2 进行重计算,传统的重计算方法将保留 x、y1 和 y2 以用于反向计算。然而,由于在反向传播中将重新计算 op1(x),保留 y1 是不必要的且效率低下。这表明传统的模块级重计算方法在操作级别上是次优的。

我们为 ERNIE 4.5 提出了一种操作级重计算方法,如算法 2 所示。在该方法中,我们保留操作 op2 的输出张量,而不是其输入张量。这种优化允许我们在反向传播中仅保留 x 和 y2,而排除 y1,从而减少了内存开销。

为了开发最佳的重计算策略,我们对模型中的每个操作进行了详细分析,评估其内存使用量与计算时间。通过选择性地将操作级重计算应用于最具成本效益的操作——那些在内存节省方面显著且运行时惩罚最小的操作——我们开发了一个最佳的检查点方案,以最大化训练效率。

5.4.2 FlashMask 用于灵活注意力掩码和长上下文训练

为了在 ERNIE 4.5 多模态预训练中适应文本和多模态训练中所需的多样化注意力掩码,我们提出了 FlashMask(Wang et al., 2025)。FlashMask 为各种任务中的注意力掩码引入了一种内存高效的表示方法,将掩码的内存复杂度从 O(N2) 降低到 O(N)。我们还在监督式微调(SFT)、直接策略优化(DPO)和强化学习训练中应用了 FlashMask,特别是在长上下文训练中,以减少内存使用并提高吞吐量。

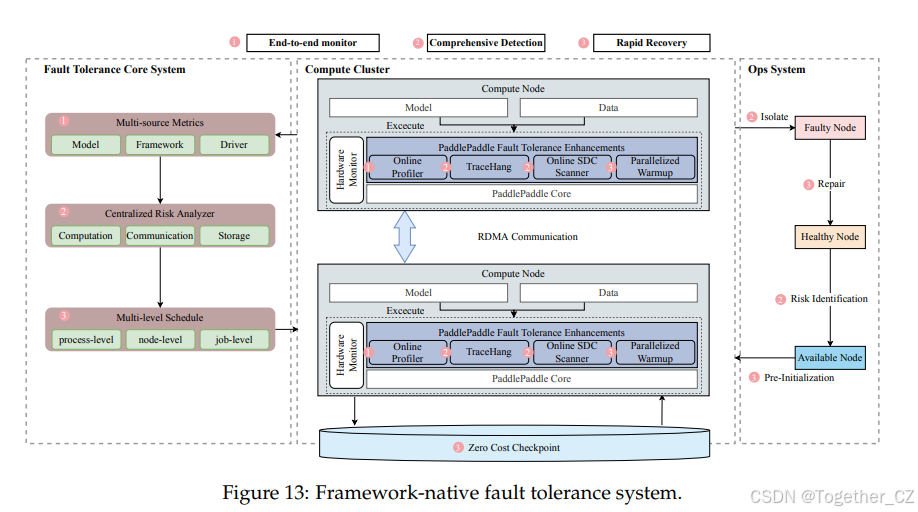

5.5 框架原生容错系统

在大规模 GPU 集群中使用时,频繁的故障中断会显著降低训练效率。为了减少中断频率并最小化恢复成本,我们提出了一个框架原生的容错系统,该系统涵盖了整个模型、框架和底层硬件,如图 13 所示。与传统的容错系统不同,我们的系统利用训练过程中的详细计算和通信工作负载信息,实现强大的故障检测和快速恢复。为了展示与训练框架深度集成的好处,我们介绍了 TraceHang、在线 SDC 扫描器和并行化预热、零成本检查点(ZCC)等技术。

TraceHang。在大规模集群上训练时,挂起而没有明确失败的情况可能特别令人困扰。为了解决这一问题,我们提出了 TraceHang 技术,它利用并行信息和通信记录,自动诊断挂起的发起者。通过系统地分析这些数据,TraceHang 可以识别挂起的根源,从而加快解决速度并减少停机时间。

在线 SDC 扫描器。静默数据损坏(SDC)由于其难以捉摸的性质,对模型收敛构成显著威胁(Dixit et al., 2021),传统上需要昂贵的离线诊断程序来进行检测。我们观察到流水线并行自然引入了设备上的空闲期,称为流水线气泡时间。在每个流水线阶段的气泡时间内,我们执行具有固定输入的计算和通信,并将结果与基线进行对比。这种方法成功地在线识别了多个 SDC 节点,而不会对训练吞吐量产生负面影响。

并行化预热。众所周知,训练过程的初始步骤通常由于资源初始化(如 cuBLAS 句柄和 NCCL 通信句柄)的临时性能下降而表现出性能退化。然而,当训练具有较大流水线度的模型时,这种性能退化会因流水线预热阶段的数据依赖性而加剧 p 倍。为了解决这一问题,我们在所有流水线阶段同时进行了模拟流水线块操作,有效地在训练开始时预热了所有设备。这种方法将第一步的延迟减少到基线的 1/p。

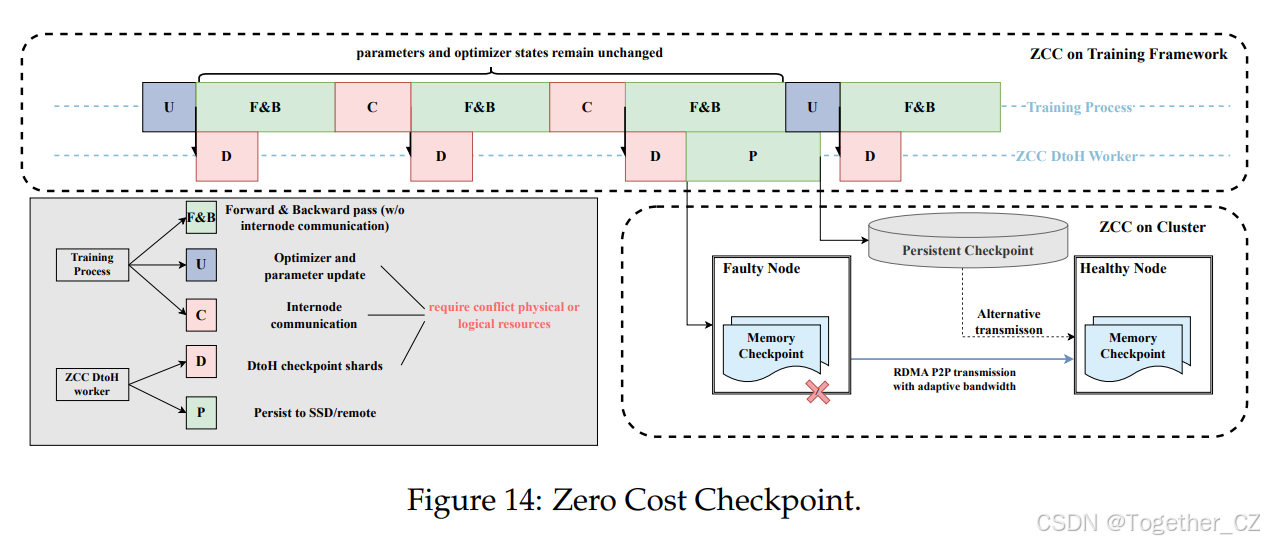

零成本检查点(ZCC)。当节点故障发生时,通常需要移除故障节点,用新节点替换,并从最近的检查点恢复训练。检查点的频率是影响中断后恢复时间的关键因素;然而,过度检查点会严重影响训练效率。为了克服这一挑战,我们引入了零成本检查点(ZCC)技术。这种创新方法允许在每个训练步骤中保存检查点,而不会对训练吞吐量产生任何开销,从而确保在中断期间不丢失任何训练进度。如图 14 所示,ZCC 在训练框架侧和集群侧运行。

在训练框架侧,我们引入了一种零成本保存技术,基于一个关键观察:除了优化器执行期间,参数和优化器状态保持不变。这一观察结果为在训练例程(典型的计算和通信任务)之间重叠检查点例程(例如 DtoH 复制和刷新到持久存储)提供了充足的机会。然而,检查点期间的 DtoH 复制和训练期间的跨节点通信会争夺 PCIe 总线上的相同物理资源。为了确保异步检查点不会降低训练吞吐量,我们将训练例程分为两类:冲突例程(涉及跨节点通信,如流水线并行的发送/接收和 ViT 视觉特征的聚集/分散)和非冲突例程(如注意力操作、密集前馈网络和节点内通信)。DtoH 复制被精细地分解并分配给这些非冲突例程,以避免影响训练过程。

在集群侧,我们提出了一种零成本传输技术。在检测到故障节点后,我们利用所有可用的健康网络接口卡(NICs)来最大化可用带宽,随后通过快速 RDMA 点对点传输将内存中的最新检查点传输到新的健康节点。此外,这个传输过程完全与随后的恢复操作重叠,例如初始化新节点的执行环境。在故障节点的内存无法访问的情况下,从持久存储中的检查点恢复作为替代方法。

总体而言,我们提出了一个框架原生的容错系统,它与 PaddlePaddle 深度集成。这种集成使系统能够充分理解训练过程中的复杂并行性,从而为大规模训练集群提供卓越的稳定性解决方案。具体来说,我们已将端到端自动恢复时间减少到不到 8 分钟,从最新步骤之前的中断时间戳到恢复完全相同步骤的时间戳。此外,假设中断频率与集群大小成线性关系,使用我们的容错框架在 10,000-GPU 集群上训练模型可以保持超过 98% 的有效训练时间。

6 推理与部署

ERNIE 4.5 系列包含不同参数大小的 MoE 和密集模型,适用于各种部署场景。由于 ERNIE 4.5 的紧凑参数量,即使是其最大模型,也可以高效部署。为了适应多样化的应用场景和硬件平台,我们提供了多种量化方案,包括 FP8、INT8、INT4 以及甚至 2 位权重量化。具体来说,ERNIE-4.5-A47B 模型可以在 8 个 GPU 上以 8 位参数运行,或者在 4 个 GPU 上以 4 位参数运行。此外,我们还提供了 Prefill-Decode(PD)解耦部署,结合大规模专家并行性。首先,我们将深入探讨我们的混合精度量化解决方案,旨在减少 GPU 内存使用量并加速矩阵计算。接下来,我们将介绍我们在推理引擎中的高性能优化,例如硬件级加速和预测解码。最后,我们将介绍系统级优化策略,用于生产部署。

6.1 量化

为了进一步提高推理效率并支持更广泛的硬件平台,我们不仅提供了 BF16 和 FP8 推理能力,还提供了多种低精度推理选项。我们开发了多种量化策略,以确保低精度模型能够实现与 BF16 模型相当的性能。对于低成本场景,我们采用 W4A8(INT4 权重和 INT8 激活)量化,以提高推理吞吐量。对于资源受限的场景,我们采用 2 位权重量化,以降低部署门槛。对于长上下文场景,我们通过应用 KV 缓存量化和注意力量化,分别优化内存和计算。

6.1.1 W4A8 量化

在 ERNIE-4.5-300B-A47B 模型中,专家权重占总参数的 90% 以上,消耗了大约 40% 的预填充阶段推理时间以及大约 60% 的解码阶段推理时间。为了实现快速且成本效益高的推理,我们在与专家组件相关的通用矩阵乘法(GEMMs)中采用了 W4A8(INT4 权重和 INT8 激活)量化。通过创新的推理友好型 W4A8 量化算法设计,我们实现了速度提升,且没有准确度下降,同时将推理时间开销降至最低。

为了在准确度和推理成本之间取得最佳平衡,我们对专家权重采用通道级静态 INT4 量化,对激活采用张量级静态 INT8 量化。

在 ERNIE 4.5 的 MoE 压缩过程中,出现了几个挑战:

-

慢速 GPTQ 在 MoE 中:GPTQ 是一种广泛使用的权重量化方法(Frantar et al., 2022)。然而,对于 MoE 模块的 GPTQ,需要一个大型数据集,不仅用于激活所有专家,还要优化数千个线性层。这一过程会导致显著的校准成本,尤其是当 ERNIE-4.5-300B-A47B 中有 64 个专家时。

-

跨节点异常值:当使用张量并行(TP)部署时,权重、激活及其异常值被分割到所有 GPU 节点上,导致全局分布的量化误差。

-

节点内异常值:对于 MoE 模块中的每个 GEMM 操作,权重和激活中都存在异常值。SmoothQuant(Xiao et al., 2023)和自适应权重量化(AWQ)(Lin et al., 2024b)等方法的有效性有限,因为它们倾向于在激活和权重之间转移异常值,而不是从根本上减轻底层问题。

我们设计了一个量化框架,以增强和确保无损量化精度,同时将推理时间开销降至最低,如图 15 所示。具体来说,我们引入了多专家并行协作(MEPC)算法,以简化校准过程。此外,我们设计了一个框架,包括异常值转移和层自适应置换旋转技术,以减轻异常值的影响,显著减少量化误差。我们在六个核心任务类别上评估了我们的量化模型与 W8A16 基线的对比。评估结果表明,我们的方法有效地保持了模型性能:在通用任务(-0.49%)、指令遵循(-0.06%)、推理任务(+0.11%)、数学任务(-0.02%)和代码任务(-1.10%)中,性能与基线水平相当,证实了量化的有效性。

MEPC:多专家并行协作量化。为了解决上述 MoE-LLMs 激活校准和 GPTQ 的瓶颈问题,我们在校准过程中采用了仅预填充方法,以确保激活足够数量的专家。对于未激活的专家,我们采用共享量化参数策略。具体来说,未激活专家的量化参数设置为同一层中所有激活专家的量化参数的平均值。这一方法受到我们实证观察的启发:同一层中的专家在量化过程中往往具有高度相似的量化参数。

受 QMoE(Frantar & Alistarh, 2024)的启发,我们在 GPTQ 中并行处理所有专家,通过连接它们的权重,从而充分利用 GPU 的并行计算能力,实现高效的 GPTQ 量化。此外,我们通过热点专家并行 GPTQ 更新策略进一步增强了这一过程。这里,热点专家——基于其令牌激活频率被认为是更重要的专家——在量化过程中被优先优化。具体来说,由于并行 GPTQ 量化可能会因 Up-Gate Linear 中的大型 Hessian 矩阵而带来显著的计算负担,我们采用针对性的 GPTQ 更新策略对热点专家进行优化。相比之下,Down Linear 中的 Hessian 矩阵较小,允许我们对这一层的所有专家进行高效的全 GPTQ 更新,而不会带来过多的计算成本。

异常值转移算法跨 GPU 节点。如前所述,当以张量并行(TP)部署时,激活异常值分布在所有 GPU 节点上,导致全局量化误差分布。受 RPTQ(Yuan et al., 2023)的启发,我们实现了一种异常值转移算法,将所有异常值聚集到一个节点上,同时将常规(非异常值)激活分配到其他节点。具体来说,我们首先从所有 N 个 GPU 中收集通道级绝对最大激活值。使用这些统计数据,我们对 Up-Gate Linear 的列和 Down Linear 的行进行全局排序,将权重通道与具有相似激活范围的激活共置到同一 GPU 上。这种重新排序调整了局部权重和激活布局,而不会影响最终模型输出,因为随后的 AllReduce 操作通过元素级求和恢复一致性。值得注意的是,我们的方法在离线进行重新排序,从而在不牺牲推理效率的情况下生成了对量化友好的模型。

层自适应置换旋转量化。INT8 静态量化因其卓越的推理效率和广泛的硬件兼容性而被广泛采用。然而,它在存在节点内异常值时会遭受显著的性能下降。替代方法如动态量化或 FP8 虽然在处理异常值方面有效,但往往受到计算开销或硬件支持的限制。为了应对这一挑战,我们提出了一种层自适应置换旋转量化框架,该框架在保持硬件友好性的同时,有效减轻了异常值的影响。

受 Quarot(Ashkboos et al., 2024)的启发,我们首先采用块旋转策略来平滑权重或激活中的异常值。为了进一步增强这一方法的鲁棒性,我们整合了置换机制(Lin et al., 2024a),允许在每个块内更灵活地重新分配异常值。我们的方法从预分析每层激活中的异常值分布开始,以确定是否优先对权重或激活进行异常值平滑。对于具有聚集异常值的层,我们应用置换-旋转程序,在旋转块内重新分配这些异常值,从而减少量化噪声并保持模型准确性。这一设计在量化粒度、计算效率和硬件兼容性之间实现了平衡。

6.1.2 2 位量化

为了进一步降低 ERNIE 4.5 的入门门槛,我们实现了近乎无损的 2 位量化算法,从而将模型大小从 BF16 基线减少了 80%。2 位 ERNIE-4.5-300B-A47B 可以部署在单个 141GB H20 GPU 上。

对于标量方法,将模型压缩到 2 位会导致模型效果显著下降。目前,最先进的权重量化算法主要集中在采用向量量化(Gray, 1984; Liu et al., 2024a)和非相干处理(Tseng et al., 2024a)来优化在极低比特量化下的模型性能。然而,这两种方法都会引入推理期间的计算开销。

-

量化去量化中的指数成本:向量量化需要一个额外的码本来存储质心向量,去量化过程涉及在庞大的码本空间中进行索引操作以重建权重,这是一个耗时的过程。

-

非相干处理中的计算开销:尽管在权重量化中非相干处理可以减轻量化误差,但它需要在推理阶段实时处理权重。

为了解决上述问题,我们提出了卷积码量化(CCQ),这是一种基于卷积码的标量量化算法。该方法不仅保留了向量量化对高精度数据量化的强大能力,还保持了标量量化的低计算复杂度。结合尺度量化和优化,我们在实现最高压缩比的同时,最小化了推理开销。

卷积码本。受 QTIP(Tseng et al., 2024b)的启发,我们通过一系列精心设计的编码结构,创新性地将卷积码与标量量化相结合。基于卷积码,我们构建了一个查找表,该表在码本和权重向量之间实现了线性映射,从而优化了推理性能。同时,我们借鉴了向量量化中数据映射的概念,最小化了模型在极低比特条件下的性能下降。

混合编码。我们采用不同编码配置的卷积码,以适应 INT8 和 INT16 格式中编码值的存储。因此,我们将 4 位标量量化压缩到等效的 2.75 位,3 位标量量化压缩到 2.5 位。

码本聚类。此外,通过分析每个通道中编码值的分布,我们观察到它们符合正态分布,从而可以沿着编码维度进行更深入的压缩。通过聚类卷积码,我们可以将任何编码配置压缩到等效的 2 位,从而进一步提高模型压缩率。

6.1.3 注意力和 KV 缓存量化

支持更大的批量大小和更长的上下文长度对于降低每次请求的成本和适应多样化的应用场景至关重要。GPU 内存开销的 KV 缓存和注意力机制的计算成本呈线性甚至二次方增长,为推理计算带来了新的瓶颈。

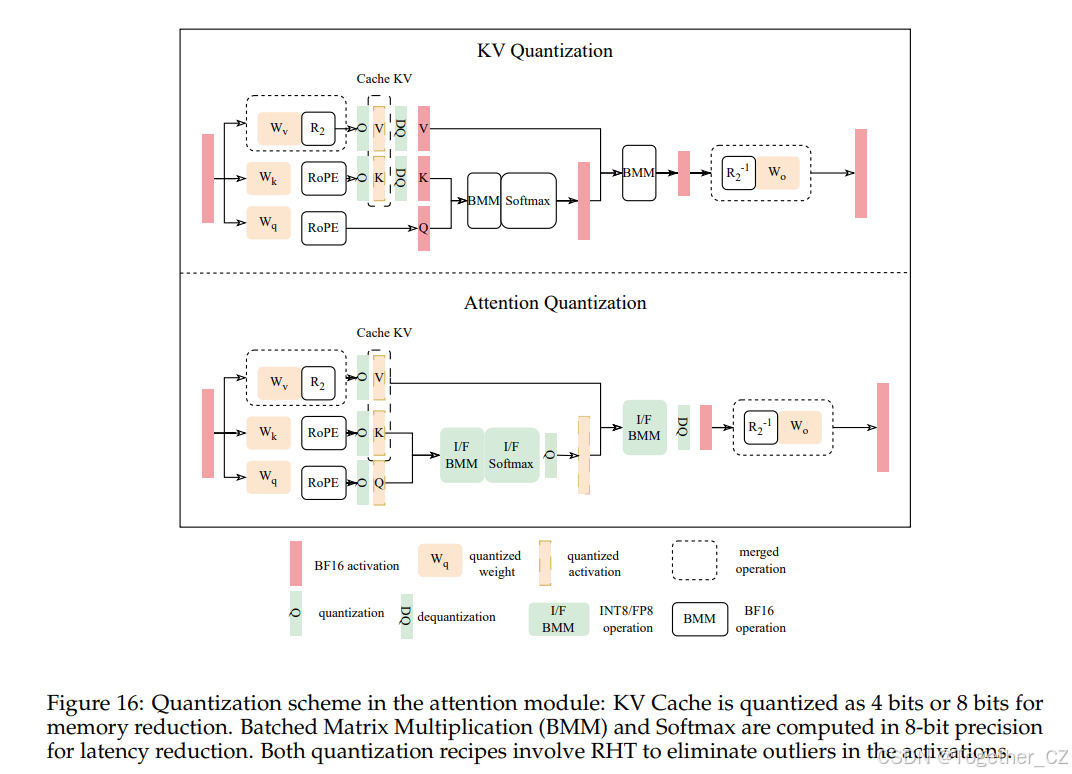

主流方法如 KIVI(Zirui Liu et al., 2023)和 KVQuant(Hooper et al., 2024)通过在推理期间采用动态令牌级量化和异常值隔离来保持 KV 缓存量化期间的准确性。然而,这种动态处理会引入推理延迟。为了缓解这一问题,我们提出了静态量化解决方案,如图 16 所示。为了在模型准确性与推理性能之间实现最佳权衡,我们引入了几种关键策略。

-

灵活的量化配置:我们提出的方法支持两种不同的量化粒度,即按头和按通道。我们提供了多种精度水平,如 FP8、INT8 和 INT4,以满足不同的推理需求和硬件约束。

-

静态量化:我们采用静态量化,使用从 SFT 阶段派生的专用采样数据集,从而避免了在推理过程中收集尺度的需求。

-

轻量级 RHT:我们利用阻塞随机 Hadamard 变换(RHT)(如 Liu et al., 2024d 和 Lin et al., 2024a 所提议的)。这种技术被应用于 INT8 格式和 FP8 格式的指数函数的多项式近似,用于不同 GPU 架构上的 softmax 计算,与 FlashAttention-2 相比,速度提高了 1.68 倍,与 FlashAttention-3 相比,速度提高了 1.48 倍。

为了进一步提高 FP8 量化的精度,我们采用了减少 FP8 值可表示范围的策略,从而显著提高了量化性能。实验结果表明,这种方法在推理任务上实现了大约 2% 的准确性提升。我们将这种改进归因于 E4M3 FP8 格式的特性,该格式表现出显著的稀疏性,并且在极值(±448)附近存在较大的量化误差。为了解决这一问题,我们在校准过程中积极裁剪或排除某些异常值。具体来说,我们设置了一个定制的 fp8 max 值(与默认值 448 不同),如公式(6)所示:

6.2 推理加速

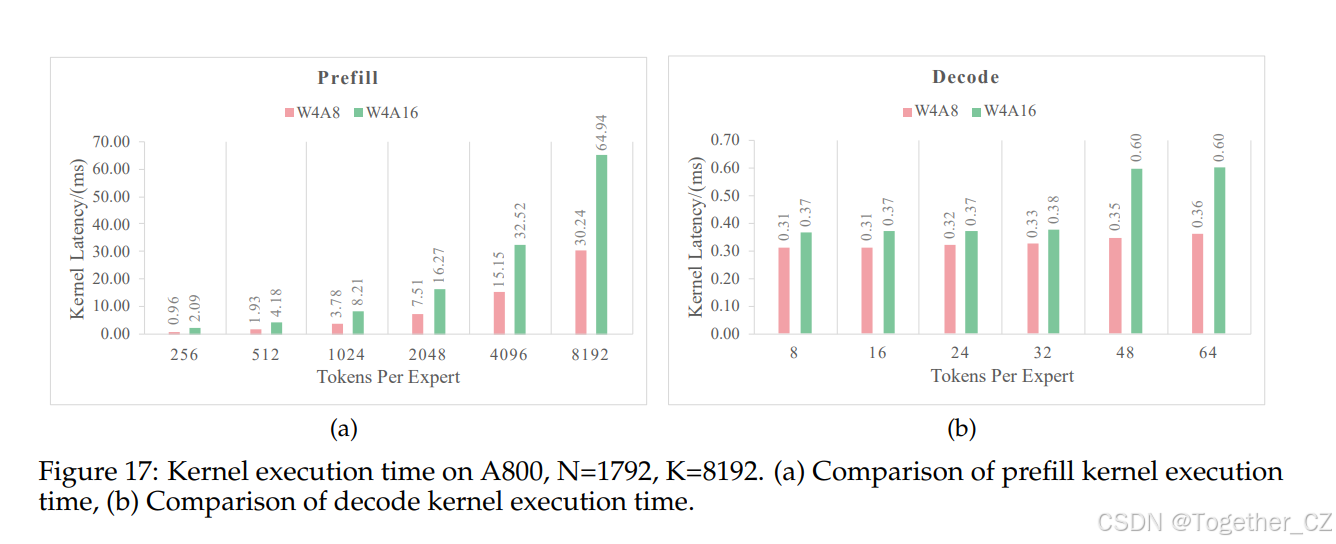

在充分考虑与量化算法和硬件架构的协作后,我们开发了一系列高效优化的推理内核。对于 MoE W4A8 量化,高效的 CUTLASS 内核,具有快速位移去量化功能,显著提高了内存吞吐量和推理速度。对于注意力和 KV 量化,我们为不同 GPU 架构上的 INT8 格式和 FP8 格式的 softmax 计算设计了不同多项式近似的指数函数,与 FlashAttention-2 相比,速度提高了 1.68 倍,与 FlashAttention-3 相比,速度提高了 1.48 倍。

6.2.1 W4A8 内核加速

在 LLM 推理中,4 位权重仅和 INT8/FP8 量化是常见的加速技术,但 W4A8 基于 MoE 模块的 GEMM 在两个关键方面优于它们:(1)与 FP8/INT8 量化相比,4 位权重表示减少了 50% 的内存;(2)与 FP16 或 BF16 基线相比,利用 INT8 Tensor Core 实现了理论计算吞吐量的两倍提升。

为了优化计算效率,我们简化了从 INT4 到 INT8 权重的快速转换过程,这与量化算法共同设计。技术细节如下:

-

范围映射:INT4 的可表示范围是 [-8, 7]。我们将映射范围限制在 [-7, 7]。

-

位移转换:通过 4 位左移操作将 INT4 权重转换为 INT8,从而将 INT8 权重的有效映射范围扩大到 [-112, 112]。

-

权重布局优化:为了最小化实现 Tensor Core 兼容 INT8 权重布局所需的运算量,我们采用了权重预打包策略,将权重排列成交错格式。这种设计使得每 8 个 INT8 数据元素可以使用 3 条指令(通过高效利用 LOP3 和位移操作)进行转换。

我们利用 Tensor Core 单元进行乘积累加运算,并通过 CUTLASS 实现高效内核,在尾声阶段进行去量化,以最大化流水线吞吐量。问题访问者模块动态平衡专家工作负载,而系统超参数预调优功能使得在推理期间能够实时选择最佳配置。

上述优化为 W4A8 MoE GEMM 内核带来了以下性能提升:

-

在解码器形状工作负载上实现了 70% 到 80% 的内存带宽。

-

与 W4A16 相比,在编码器形状工作负载上实现了超过 100% 的速度提升,在解码器形状工作负载上实现了超过 20% 的速度提升。

为了在中间计算中减少精度损失,我们在 MAC 阶段保持了 INT32 累加精度。对于激活,我们支持灵活的量化粒度(按令牌或按专家),而权重则采用按通道量化,以实现最佳准确性。

6.2.2 高效注意力内核

为了在硬件能力与准确性之间实现平衡,我们在注意力量化中利用了 Hopper 架构 GPU 上的 FP8 计算和 Ampere 架构 GPU 上的 INT8。当批量 GEMM 运算利用基于 Tensor Core 的 INT8 或 FP8 时,其执行时间显著减少。因此,计算 softmax 和去量化的 CUDA 核心上的操作成为性能瓶颈。为了解决这一问题,我们采用了新颖的指数函数实现和去量化方法,以最小化 CUDA 核心上的计算开销。

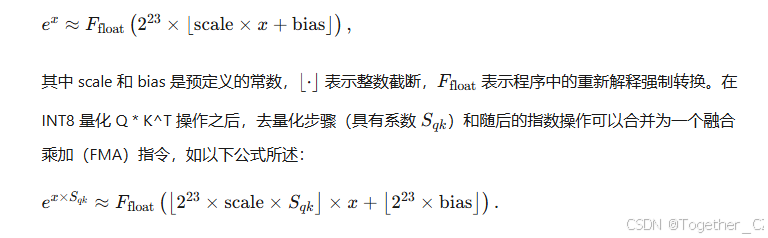

INT8 格式的注意力。我们采用了 Schraudolph(1999)提出的快速指数函数计算方法。浮点数据 x 的指数函数可以表示为:

实验结果表明,这种方法在 A800 GPU 上,输入序列长度为 128K 时,与 FlashAttention-2 相比,实现了 68% 的性能提升。

FP8 格式的注意力。对于使用 C4(不对称通道式 4 位量化用于 KV 缓存)的注意力模块,我们将两个 GEMM 操作量化为 FP8E4M3 格式,并实施了以下优化。

-

快速转换:通过将 4 位 KV 数据放置在 FP8E4M3 数据的较低 4 位,建立 UINT4 到 FP8E4M3 的转换:

-

矩阵转置:Hopper 架构 GPU 要求矩阵 B 在 A * B 中从共享内存加载。因此,我们重构了 4 位量化 K 和 V 的计算流程,以避免将量化后的 K 和 V 从寄存器移动到共享内存。转换公式如下:

这些优化通常使输入长度为 128k 的 C4 解码注意力达到超过 80% 的理论带宽利用率。在 FP8 注意力中,指数函数通过其极限进行近似。最终,与 FlashAttention-3 的 FP8 实现相比,这种方法在输入序列长度为 128K 时,预填充阶段平均速度提升了 50%。

6.2.3 预测解码

ERNIE 4.5 配备了多令牌预测(MTP)模块,因此在推理阶段采用了统一的预测解码框架,该框架支持并发提议架构,能够无缝集成 MTP 方案。通过并行采样和验证,以及深度定制的注意力内核,MTP 实现了 60% 的输出吞吐量提升,同时保持了与自回归解码相当的每个输出令牌时间(TPOT)。

6.3 部署

对于 ERNIE-4.5-300B-A47B 模型,我们通过结合专家并行性(EP)的 Prefill-Decode 解耦部署来优化系统吞吐量和延迟。具体来说,在预填充阶段,采用 8 路专家并行性(EP8),而无需张量并行用于注意力模块。在解码阶段,系统支持从 EP8 到 EP64 的灵活并行化配置。鉴于预填充和解码阶段各自独特的计算特性,我们为每个阶段的需求量身定制了不同的量化方案。预填充阶段采用块状 FP8 量化,而解码阶段采用 W4A8 量化,以优化内存带宽并减少延迟。

PD 解耦系统的有效性关键取决于三个关键因素:(1) KV 缓存的跨节点传输效率,(2) 专家路由的全连接通信效率,以及 (3) 分布式计算资源的负载平衡。这些组件共同决定了解耦架构的整体系统性能和可扩展性。

KV 缓存传输。我们开发了一个基于远程直接内存访问(RDMA)的跨节点 KV 缓存传输模块,该模块具有最小的依赖性。它只需要基本的 RDMA 运行时环境,如 OFED,使其轻量级且易于部署。此外,为了实现更好的性能,我们的实现与现有解决方案存在一些细节差异,包括减少完成队列条目(CQE)数量和启用 PCIe 放松排序。此外,基于统一的 KV 缓存传输设计,我们的系统智能地通过最优通道路由 KV 缓存流量,利用 NVLink 进行节点内通信和 RDMA 进行节点间通信。

全连接通信。对于全连接通信,我们利用 NVLink P2P 复制进行低延迟场景下的节点内数据传输。这一增强功能提高了 EP8 部署效率,在小规模解码实例中,效率提升了 70%。

多级负载平衡。在大规模 PD 解耦系统中,数据并行性和专家并行性的负载平衡至关重要。我们系统地实现了多级负载平衡。

-

数据并行性负载平衡:全局负载感知调度器根据 KV 缓存命中率和令牌数量调度查询,确保每个 DP 等级在预填充和解码阶段处理的令牌数量相对平衡。

-

专家并行性负载平衡:我们的系统结合了动态专家冗余策略(DeepSeek-AI et al., 2024b)并强制执行全局专家重新调度,以优化 MoE 计算中的负载平衡。为了减少专家重新排列对在线服务的影响,我们采用了权重预取和异步加载方案,以实现极低延迟的服务停滞。采用灰度级重新排列策略,避免出现“雷暴”问题,确保整体服务的稳定性。

-

PD 解耦负载平衡:在 PD 解耦系统中,PD 比例不匹配会使满足服务级别目标(SLO)变得困难,并可能导致低 GPU 利用率。在在线服务中,动态变化的输入和输出长度会导致预填充和解码阶段之间的不平衡。为了解决这一问题,我们持续监控所有实例的工作负载,并动态调整预填充和解码之间的比例,以实现相对平衡。然而,我们观察到系统吞吐量经常受到预填充阶段资源限制的瓶颈。为了解决这一限制,我们的系统支持动态角色切换,允许解码实例根据实时负载条件智能地处理短输入请求的预填充。至关重要的是,这种方法几乎不对 TPOT 产生影响,同时在解码阶段提高了资源利用率。

借助上述优化策略,ERNIE-4.5-300B-A47B 实现了每 H800 节点 56k 输入 TPS 和 18k 输出 TPS 的推理性能,用于输入长度为 2K、输出长度为 400 的场景,同时在 50ms 每输出令牌延迟(TPOT)延迟约束下,不使用提示缓存。

值得注意的是,在我们的最大 ERNIE 4.5 语言模型的 PD 解耦部署解决方案中,预填充和解码都要求最低部署单元是一个包含 8 个 GPU 的节点,这显著提高了运营效率并减少了生产环境中集群管理的复杂性。

尽管在大规模 GPU 集群上的 PD 解耦提供了卓越的性能,但简化单节点部署对于快速应用于多样化场景至关重要。即使对于最大的模型 ERNIE-4.5-A47B,也可以在单个节点上进行部署,例如 4x80GB A800 或 H800,使用 4 位精度,以及 1x141G H20 使用 2 位精度,如上所述。ERNIE 4.5 不仅可以在 NVIDIA GPU 上高效部署,还可以基于 PaddlePaddle 支持多种硬件平台,包括 Kunlunxin XPU、Hygon DCU 和 Ascend NPU。

7 开源开发工具

为了简化 ERNIE 4.5 的模型训练和部署,我们开源了基于 PaddlePaddle 框架的 ERNIEKit 和 FastDeploy 工具包。这些工具包具备工业级能力,支持资源高效的训练和推理工作流程以及多硬件兼容性。

7.1 ERNIEKit

ERNIEKit 是一个用于 ERNIE 4.5 的工业级开发工具包。它提供了模型训练和压缩能力,包括预训练、监督式微调(SFT)、低秩适应(LoRA)、直接偏好优化(DPO)、量化感知训练(QAT)和后训练量化(PTQ)技术。为了使开发人员能够充分体验 ERNIE 4.5 的能力,我们引入了以下技术创新:

-

工业级高性能预训练:该工具包提供了我们最大 ERNIE 4.5 语言模型预训练的高性能实现,包括混合并行训练策略和 FP8 混合精度优化。

-

低比特量化感知微调:为了显著减少 ERNIE 4.5 的微调和部署资源,我们引入了一种新颖的 FP8-QAT 解决方案,将低精度训练与优化器卸载相结合。由此产生的模型在质量上与 BF16 微调(SFT)模型相匹配,同时将我们最大 ERNIE 4.5 语言模型所需的最小 GPU 数量从 96 个减少到 16 个。至关重要的是,与预训练 FP8 方案不同,这些需要动态(块/瓦片式)量化的模型支持高效的离线张量级 FP8 量化用于推理,消除了运行时量化开销。

-

可视化训练和推理界面:集成的基于 Gradio 的 WebUI 支持零代码微调、对齐和推理操作,开箱即用。

7.2 FastDeploy

FastDeploy 是一个用于大型语言模型和视觉语言模型的推理和部署工具包。它旨在易于使用,提供与 vLLM 接口开箱即用的兼容性。为了满足企业和个人开发人员的需求,我们引入了以下技术特性:

-

PD 解耦与多级负载平衡:我们开源了一个基于 ERNIE 4.5 架构特性的工业级 Prefill-Decode 解耦部署,带有上下文缓存。它为 NVIDIA GPU 提供了最优的分布式推理配置。得益于统一的 KV 缓存传输设计,我们的系统自动选择 NVLink 和 RDMA 之间的最高效通信链路。在多机部署中,实例根据负载条件动态在预填充和解码角色之间切换,以提高吞吐量。

-

全面的低比特量化推理支持:FastDeploy 支持多种量化精度,包括 W8A8、W8A16、W4A8、W4A16 和 W2A16,以及 INT4、INT8、FP8 和 BF16 等数据类型。特别是,我们提供了内置的 2 位权重量化模型,以降低 ERNIE 4.5 的部署资源要求。与 FP8 精度相比,该模型在多个基准测试中实现了几乎无损的性能,同时允许在单个 NVIDIA H20 GPU 上进行单卡推理。

-

多硬件支持:得益于 PaddlePaddle 的多硬件适应能力,除了 NVIDIA GPU 之外,ERNIE 4.5 还支持在多种芯片上进行推理部署,包括 Kunlunxin XPU、Hygon DCU 和 Ascend NPU。

8 评估与结果

为了全面展示 ERNIE 4.5 的能力,我们在各种文本和视觉基准测试中进行了广泛的评估。第 8.1 节和第 8.2 节分别展示了 ERNIE 4.5 的语言模型和多模态模型与领先的模型的比较结果。

8.1 语言模型评估

8.1.1 预训练语言模型的结果

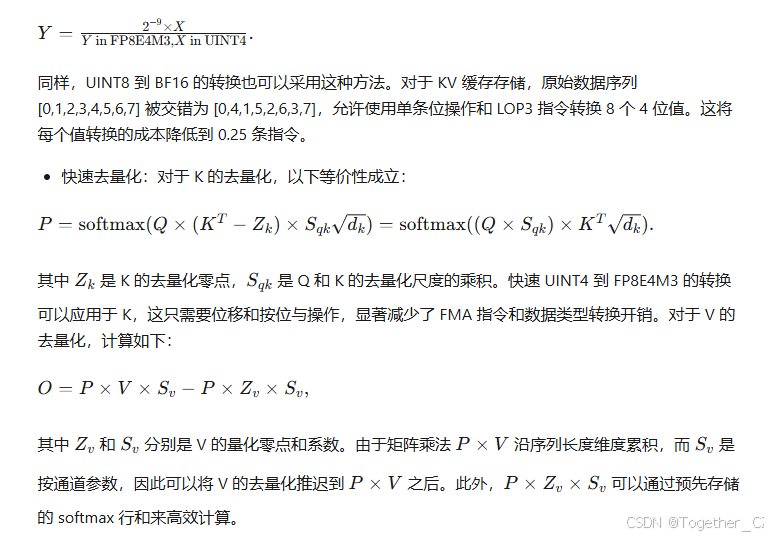

在本节中,我们对 ERNIE-4.5-Base 与最先进的模型进行了全面评估,包括 DeepSeek-V3-Base(Wang et al., 2024b)和 Qwen3-30B-A3B-Base(Yang et al., 2025a)。我们在涵盖五个基本能力的多样化基准测试中进行了系统评估。评估基准及其方法描述如下:

-

通用任务:C-Eval(5-shot)(Huang et al., 2023)、CMMLU(5-shot)(Li et al., 2024a)、MMCU(5-shot)(Zeng, 2023)、AGIEval(5-shot)(Zhong et al., 2024)、MMLU(5-shot)(Hendrycks et al., 2021a)、MMLU-Redux(5-shot)(Gema et al., 2025)和 MMLU-Pro(5-shot)(Wang et al., 2024c),评估跨不同学术和专业领域的综合知识和理解能力。

-

事实知识:SimpleQA(10-shot)(Wei et al., 2024a)和 ChineseSimpleQA(10-shot)(He et al., 2024a),测试不同语言和领域的世界知识能力。

-

推理:BBH(3-shot)(Sanh & Raffel, 2023)、DROP(3-shot)(Dua et al., 2019)、ARC-Easy & Challenge(5-shot)(Clark et al., 2018)、HellaSwag(5-shot)(Zellers et al., 2019)、PIQA(5-shot)(Bisk et al., 2020)、WinoGrande(5-shot)(Sakaguchi et al., 2021)和 CLUEWSC(5-shot)(Xu et al., 2020),评估逻辑推理、阅读理解和常识推理能力。

-

代码生成与理解:Evalplus(0-shot,包括 HumanEval+ 和 MBPP+)(Liu et al., 2023)和 MultiPL-E(0-shot)(Cassano et al., 2023),评估编程能力,包括多语言代码理解。

-

数学推理:GSM8K(5-shot,我们移除了计算器标签以确保模型性能稳定)(Cobbe et al., 2021)、MATH(8-shot,链式思考和直接答案)(Hendrycks et al., 2021b)和 CM17K(5-shot)(Qin et al., 2021),评估不同数学领域的数学问题解决能力。

结果总结在表 4 中。根据总体评估,我们对 ERNIE-4.5-Base 模型的关键发现如下。

ERNIE-4.5-300B-A47B-Base。ERNIE-4.5-300B-A47B-Base 在 28 个基准测试中的 22 个上超过了 DeepSeek-V3-671B-A37B-Base,显示出在所有主要能力类别中的显著改进。这突出了相对于其他最先进的大型模型,通过扩展 ERNIE-4.5-Base 模型带来的泛化、推理和知识密集型任务的显著改进。该模型特别擅长中文通用和知识任务,包括 CMMLU 和 ChineseSimpleQA。这种对中文的卓越性能可归因于迭代细化预训练数据,以提高数据质量和学习效率。此外,模型在问答任务中的出色表现得益于优化的常识数据格式和高质量合成数据的纳入,进一步增强了其处理事实问答和复杂中文语言环境的能力。

ERNIE-4.5-21B-A3B-Base。尽管其总参数量仅为 Qwen3-30B 的大约 70%,但 ERNIE-4.5-21B-A3B-Base 在一些数学和推理基准测试中,如 BBH 和 CMATH,超过了 Qwen3-30B-A3B-Base。鉴于其显著较小的模型大小,ERNIE-4.5-21B-A3B-Base 仍然具有很高的竞争力,显示出显著的参数效率和有利的性能权衡。

ERNIE-4.5-21B-A3B-Base 和 ERNIE-4.5-300B-A47B-Base 在知识密集型任务中都取得了令人印象深刻的结果,在 SimpleQA 和 ChineseSimpleQA 上获得了高分。这些结果反映了有效的知识记忆和语言理解,主要得益于在大规模高质量文本数据上的大规模预训练。这种全面的预训练为后续的微调奠定了坚实的基础,从而在事实知识获取方面表现出强大的能力。

表 4:ERNIE-4.5-Base 预训练模型的性能。这里,我们报告了我们对 Qwen3-30B-A3B-Base 和 DeepSeek-V3-671B-A37B-Base 模型自己的评估结果,而不是它们原始论文中报告的分数。粗体值表示在可比参数大小组中的最佳分数。

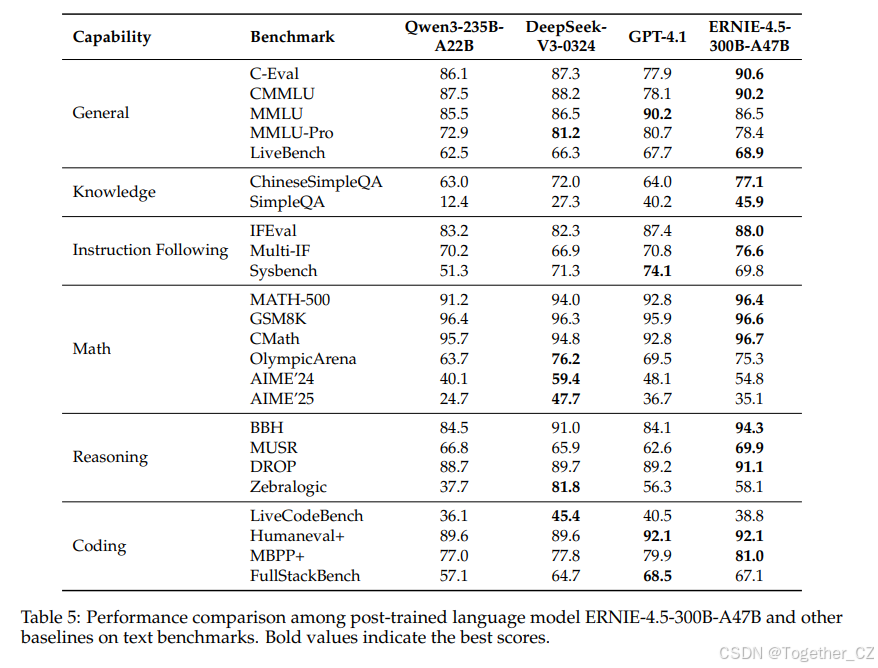

8.1.2 后训练语言模型的结果

在本节中,我们对 ERNIE-4.5 与最先进的模型进行了全面评估,包括 DeepSeek-V3-0324(DeepSeek-AI et al., 2024b)、GPT-4.1(OpenAI, 2025a)和 Qwen3-235BA22B(Yang et al., 2025a),在非思考模式下。我们在涵盖六个基本能力的多样化基准测试中进行了系统评估,如表 5 所示。评估基准及其方法描述如下:

-

通用任务:MMLU(Hendrycks et al., 2021a)、MMLU-Pro(Wang et al., 2024c)、C-Eval(Huang et al., 2023)和 CMMLU(Li et al., 2024a)、LiveBench(2024-11-25)(White et al., 2025),评估跨多领域问答的广泛知识和理解。

-

知识任务:ChineseSimpleQA(Li et al., 2022)和 SimpleQA(Wei et al., 2024a),测试事实检索和多语言知识准确性。

-

指令遵循:IFEval(Zhou et al., 2023)、Multi-IF(He et al., 2024b)、Sysbench(Kim et al., 2023)评估复杂指令遵循能力。

-

数学任务:MATH-500(Zhou & Li, 2023)、GSM8K(Cobbe et al., 2021)、CMATH(Wei et al., 2023)、OlympicArena(Huang et al., 2024)、AIME’24 和 AIME’25(AIME, 2025),评估复杂的数学推理和问题解决能力。

-

推理任务:BBH(Sanh & Raffel, 2023)、MUSR(Gao & Chen, 2023)、DROP(Dua et al., 2019)、Zebralogic(Tan et al., 2023),评估逻辑推理、常识推理和推理能力。

-

代码任务:HumanEval+(Liu et al., 2023)、MBPP+(Liu et al., 2023)、Fullstackbench(Cheng et al., 2024),衡量代码生成正确性和多语言代码理解。

表 5:在文本基准测试中,ERNIE-4.5-300B-A47B 后训练语言模型与其他基线的性能比较。粗体值表示最佳分数。

表 5 揭示了 ERNIE-4.5-300B-A47B 与其他领先的开源模型在各种基准测试中的比较性能。值得注意的是,该模型在指令遵循和知识任务中表现出色,如 IFEval、Multi-IF、SimpleQA 和 ChineseSimpleQA 的基准测试中获得了最先进的分数。该模型在单轮、多轮和多语言场景中对指令的解释和遵循以及知识的有效利用的能力可归因于我们的统一奖励系统,该系统结合了精心设计的奖励机制,指导模型更好地解释和遵循多样化的用户指令和内部知识。

在数学和代码任务中,ERNIE-4.5-300B-A47B 在大多数基准测试中显著优于 Qwen3-235B-A22B。这些结果表明该模型在数学推理、准确计算和代码生成方面具有高级能力,使其特别适合于数学计算和编程相关任务。然而,在某些具有挑战性的数学和代码任务中,仍有改进空间。

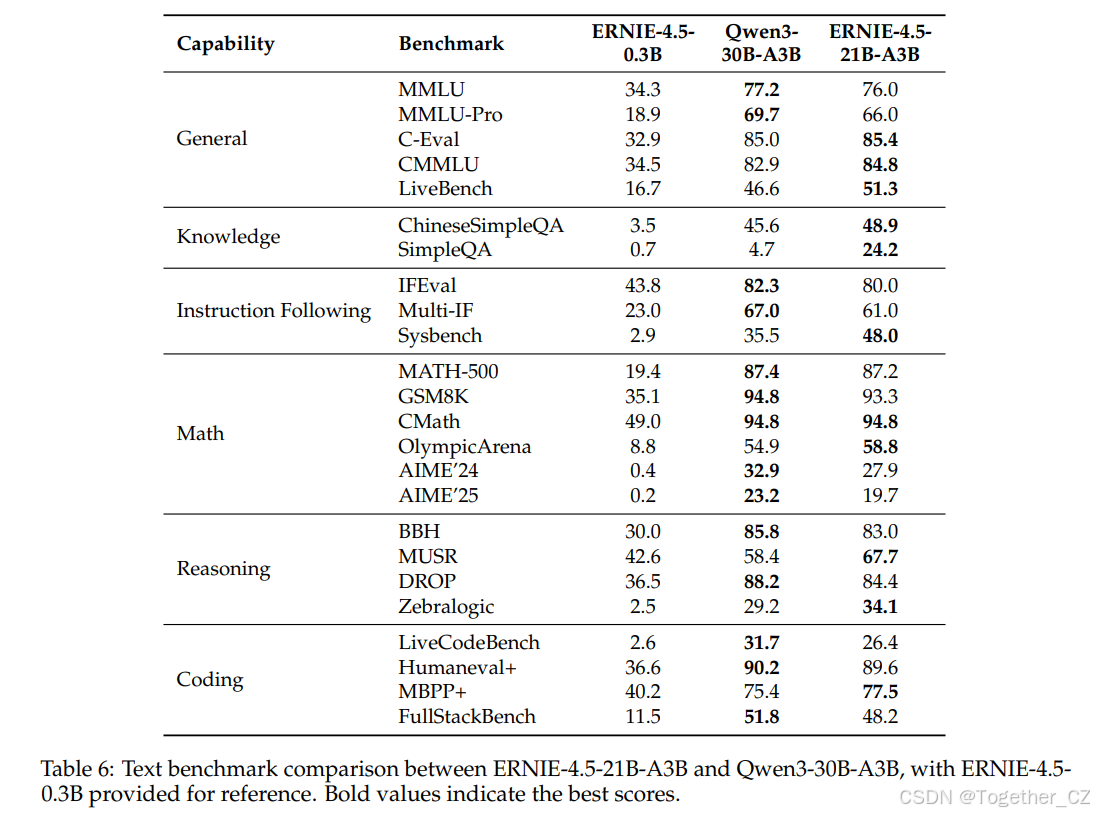

轻量级语言模型。表 6 总结了轻量级语言模型的基准测试结果。实验结果表明,轻量级模型 ERNIE-4.5-21B-A3B 与 Qwen3-30B-A3B 相比,在总参数量大约少 30% 的情况下,仍具有竞争力。此外,超轻量级 ERNIE-4.5-0.3B 在其极其紧凑的尺寸下表现出合理的性能,使其能够在标准笔记本电脑上高效推理。

表 6:文本基准测试中 ERNIE-4.5-21B-A3B 与 Qwen3-30B-A3B 的性能比较,ERNIE-4.5-0.3B 作为参考。粗体值表示最佳分数。

8.2 多模态模型评估

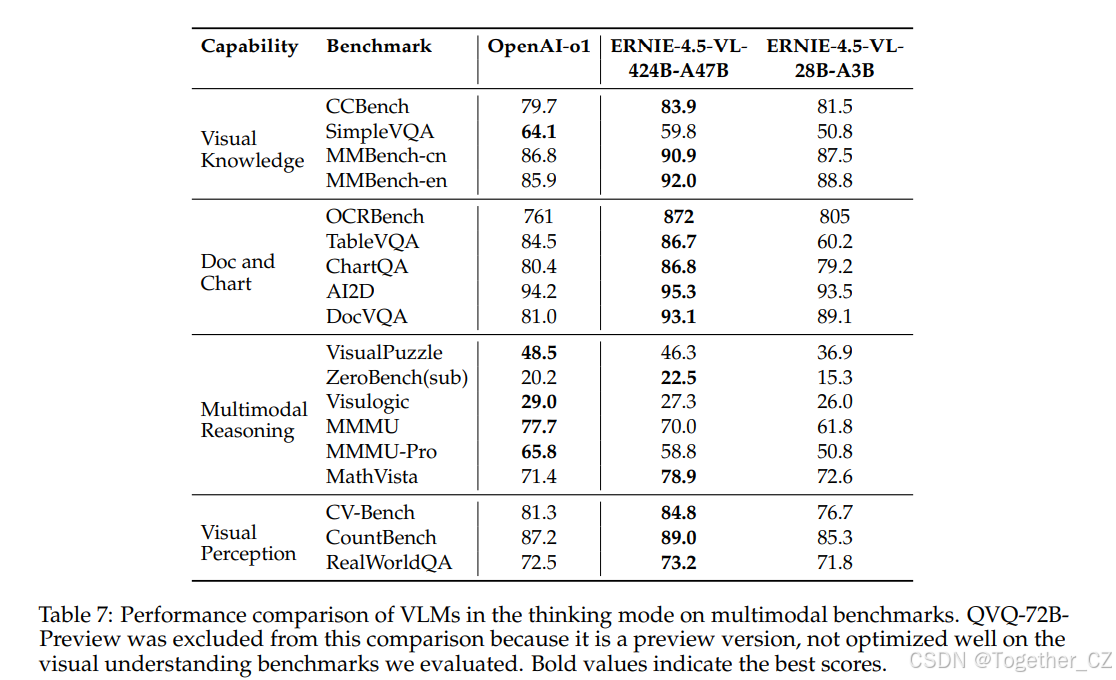

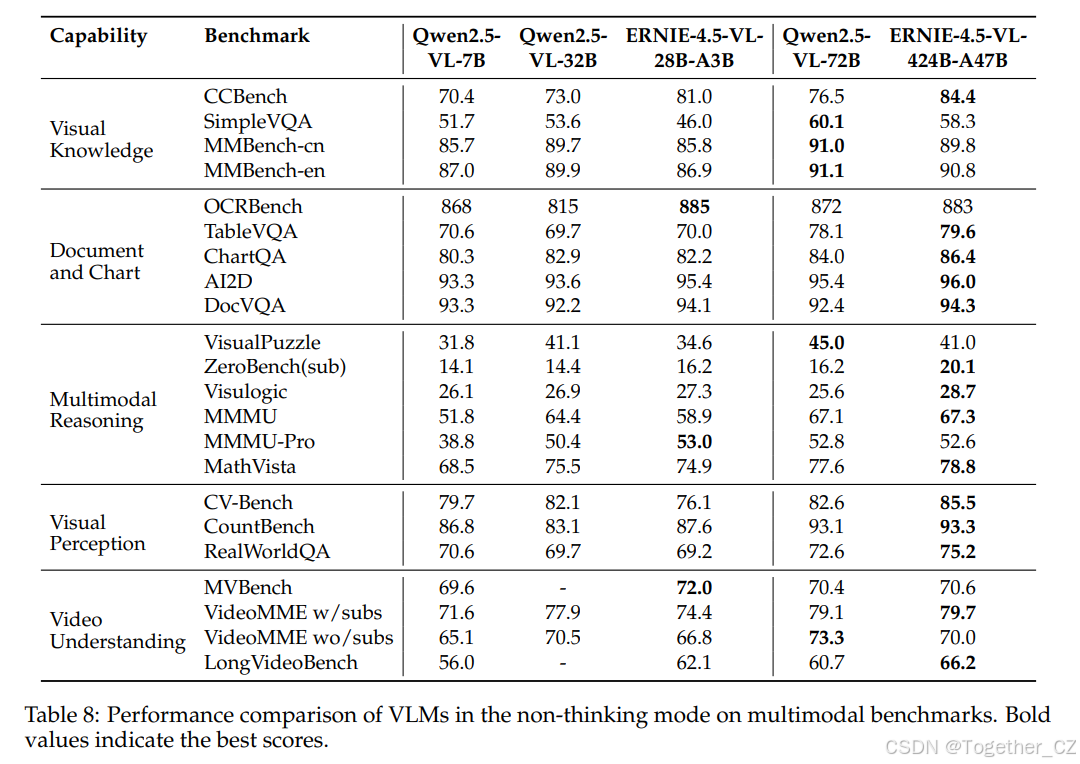

在本节中,我们在思考模式下对 ERNIE-4.5-VL 与领先的基线模型进行了全面的多模态评估,包括 OpenAI-o1(OpenAI, 2025c)和 QWen2.5-VL(Bai et al., 2025)。我们在旨在评估五个基本能力的多模态基准测试中进行了评估:通用视觉知识理解、文档和图表理解、多模态推理、视觉感知和视频理解。所有模型都使用标准的零样本协议在所有多模态任务中进行了评估。评估基准详细描述如下:

-

视觉知识:CCBench(Liu et al., 2024b)、SimpleVQA(Wei et al., 2024a)和 MMBenchv1.1(Liu et al., 2024b),评估通用视觉知识。

-

文档和图表:OCRBench(Liu et al., 2024c)、TableVQA(Kim et al., 2024)、ChartQA(Masry et al., 2022)、AI2D(Kembhavi et al., 2016)和 DocVQA(验证集)(Mathew et al., 2021),评估文本识别、文档和图表解释以及结构化信息。

-

多模态推理:VisualPuzzle(Song et al., 2025)、Zerobench(Roberts et al., 2025)、MMMU(Yue et al., 2024a)、MMMU-Pro(Yue et al., 2024b)和 MathVista(Lu et al., 2023),通过复杂的视觉场景测试逻辑推理和视觉相关问题解决能力。

-

视觉感知:CV-Bench(Tong et al., 2024)、CountBench(Paiss et al., 2023)和 RealWorldQA(xAI, 2024),评估模型的空间推理、计数和其他基本视觉感知能力。

-

视频理解:MVBench(Li et al., 2024c)、VideoMME 带/不带字幕(Fu et al., 2024)和 LongVideoBench(Wu et al., 2024),评估时间理解、视频理解和长视频分析能力。

所有图像基准测试结果都使用我们自己的评估基础设施进行了重新评估。Qwen2.5-VL 的结果基于开源模型权重的评估。OpenAI-o1 的结果是使用其官方 API 在 2025 年 6 月收集的。对于 OCRBench、RealWorldQA 和 DocVQA(Mathew et al., 2021),我们仅使用其官方实现提供的评估指标。对于其他基准测试,我们遵循官方实现指南,并进一步引入了一个 LLM-as-judge 流程,以确保评估的准确性和可靠性。特别是对于 CCBench(Liu et al., 2024b)基准测试,我们采用了“先描述后回答”的提示策略来提高模型性能。对于 AI2D,我们采用了透明设置,并仔细对齐了我们的实现与 Molmo(Deitke et al., 2024)。

我们在表 7 和表 8 中分别报告了 ERNIE-4.5-VL 在思考模式和非思考模式下的性能。不同基准测试的详细表现如下所述。

非思考模式:在非思考模式下,ERNIE-4.5-VL 展示了强大的视觉感知能力和知识事实性。它在多个视觉理解任务中表现出色。例如,ERNIE-4.5-VL-424B-A47B 在视觉感知基准测试如 CountBench、CVBench 和 RealWorldQA 中取得了高分。ERNIE-4.5-VL 还在 OCR 和图表理解任务中表现出色,展示了有效的科学图表理解能力,并在文档理解任务中表现出色,更多示例见附录 B.1、B.2 和 B.3。此外,ERNIE-4.5-VL 在视频理解基准测试中表现出色,反映了其对短视频和长视频的连贯理解能力。附录 B.4 展示了其时间定位能力,这得益于采用的时间戳渲染方法。

除了感知能力外,ERNIE-4.5-VL 还在视觉知识方面表现出色,如在 CCBench 中的高分所示,突出了其对中文知识和文化的全面掌握。这种能力可归因于视觉编码器在视觉概念上的广泛预训练以及通过多模态联合训练进一步增强的能力。模型的性能还受益于高质量中文文本和视觉数据的纳入,进一步强化了其文化理解。附录 B.5 提供了一个关于中文古字识别的说明性案例。

总体而言,ERNIE-4.5-VL 在视觉感知、文档和图表理解以及视觉知识方面表现出色,在一系列既定基准测试中表现出色。

思考模式:在思考模式下,ERNIE-4.5-VL 不仅与非思考模式相比表现出增强的推理能力,还保留了后者的强大感知能力。ERNIE-4.5-VL-424B-A47B 在各种多模态评估基准测试中持续表现出色。其思考模式在具有挑战性的基准测试如 MathVista、MMMU 和 VisualPuzzle 上提供了明显优势,同时在感知导向的数据集如 CV-Bench 和 RealWorldQA 上保持了竞争力。附录 B.6 包含了一些说明性示例,突出了模型在解决视觉谜题时的反思推理能力。

思考模式在多模态推理任务上的强大表现不仅源于其先进的推理能力,还源于其在 SFT 阶段获得的对 STEM 相关图像的改进理解。同时,非思考模式也通过两种模式的联合训练得到改善,这反映在模型在思考和非思考场景中的强大数学问题解决能力以及多模态理解能力上。附录 B.7 和 B.8 提供了思考模式下的更多推理示例。

轻量级 VLM。实验结果表明,轻量级视觉语言模型 ERNIE-4.5-28B-A3B 在大多数基准测试中实现了与 Qwen2.5-VL-7B 和 Qwen2.5-VL-32B 相比具有竞争力甚至更优的性能,尽管其激活参数显著较少。值得注意的是,我们的轻量级模型还支持思考和非思考模式,提供与 ERNIE-4.5-VL-424B-A47B 一致的功能。

9 结论

在本工作中,我们介绍了 ERNIE 4.5,这是一个大规模多模态模型家族。我们的模型采用了新颖的异构 MoE 结构,支持跨模态的参数共享以及每个单独模态的专家专业化,允许更灵活、更有效的多模态联合训练和知识融合。广泛的评估表明,我们的模型在多个文本和多模态基准测试中达到了最先进的性能,特别是在文本和视觉知识事实性、指令遵循、视觉理解和多模态推理方面。

ERNIE 4.5 的开发极大地受益于研究社区的集体智慧,吸取了大规模模型训练的最佳实践和最新进展。为了促进未来的研发,我们发布了分布式训练和量化技术的创新细节,并开源了 ERNIEKit 和 FastDeploy 开发工具包。通过分享这些见解和工具,我们希望为高效大规模模型训练和部署的创新做出有意义的贡献。在未来,我们期待与研发社区合作,进一步推进这一快速发展的领域的发展。

A 附录

A.1 路由正交化损失的消融研究

为了验证路由正交化损失的效率,我们在一个总参数为 28B、激活参数为 3B 的 MoE 模型上进行了消融实验。基线模型和实验模型使用相同数量的令牌进行训练,使用相同的数据、超参数和指数移动平均(EMA)参数累积。路由正交化损失的系数设置为 1×10−2,与权重衰减不同,它不按学习率进行缩放。表 9 展示了在多个基准测试上的少样本评估结果。尽管训练损失保持相似,但使用路由正交化损失训练的 MoE 模型在 OOD 性能上优于基线。

表 9:在多个基准测试上,基线和使用路由正交化损失训练的模型的性能比较。

| 模型 | 平均 | MMLU | C-Eval | CMMLU | MMCU | HumanEval | AGIEval | BBH | MBPP | GSM8K | Math |

|---|---|---|---|---|---|---|---|---|---|---|---|

| 基线 | 50.2 | 46.1 | 55.4 | 51.7 | 66.8 | 50.6 | 47.1 | 37.7 | 38.9 | 65.6 | 63.3 |

| + 路由正交化损失 | 53.1 | 51.6 | 63.5 | 63.4 | 68.4 | 58.5 | 47.3 | 38.9 | 66.1 | 60.7 | 21.3 |

A.2 以更新增量表示的 EMA

A.3 EMA 的有效衰减窗口

B 定性示例

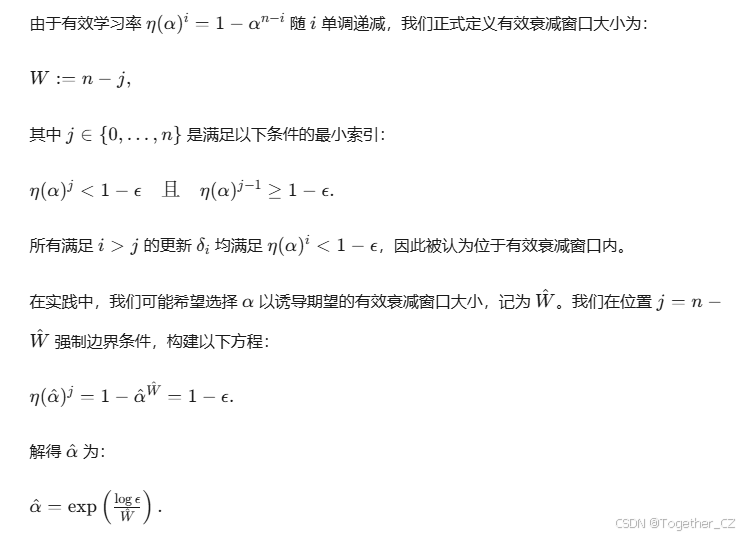

本节通过从各种提示生成的响应示例,展示了 ERNIE-4.5-VL 模型的能力。重点展示了文档理解和 OCR 能力,如图 18、19 和 20 所示。此外,图 21 展示了基于用户指令生成视频字幕和定位特定事件的能力。图 22 展示了模型识别古代中文字符的能力。图 23、24、25 和 26 展示了模型在不同学科中的推理能力。图 27、28、29 和 30 展示了模型解决视觉推理问题的能力。图 31 提供了模型进行常识推理的示例。图 32 展示了模型进行代码合成的能力。图 33 展示了模型基于图像条件的创意写作能力。

B.1 OCR 解析与文档理解 I

提示:使用图像中描绘的罗马历史,创建一个关于罗马发展的思维导图。要求:用英语,结构清晰且逻辑连贯。

模型响应:<think>...</think> 根据提供的文本,以下是关于罗马发展的清晰且逻辑连贯的思维导图:

中央主题:罗马发展

-

地理与奠基:

-

位于意大利(南欧,四面环海)。

-

占据亚平宁半岛,海岸线较为规整。

-

富含火山灰的肥沃土壤,良好的气候和雨水,有利于农业发展。

-

早期居民:可能是利古里亚人;后来有欧洲人(公元前 1000 年进入亚平宁半岛)、伊利里亚人/伊特鲁里亚人(公元前 1200 年进入西北方)、希腊人(公元前 800 年进入南部和西西里岛)、高卢人(公元前 5 世纪进入北部)。

-

因入侵、殖民和移民,成为多民族的土地。

-

-

历史时间线:

-

早期定居(约公元前 1000 年):起源于意大利中部靠近台伯河的小村庄。

-

伊特鲁里亚影响:被七位国王统治(最后三位可能是伊特鲁里亚人),包括塔克文·苏佩布。

-

罗马共和国(公元前 509 年):驱逐最后一位国王后建立。由执政官(执政长官)和元老院治理。

-

扩张:从一个被省略的城市国家发展为地中海的主导力量。

-

向帝国的转变(共和国末期):奥古斯都/屋大维建立独裁统治,取代了共和国(从其建立起 500 多年后)。

-

-

社会冲突(贵族与平民):

-

第一阶段(政治权利):平民联合起来,拒绝参战。迫使贵族让步,获得了权利(例如,平民被任命为执政官)。

-

第二阶段(债务与土地):允许因债务而陷入困境的平民用财产偿还债务,废除了债务奴隶制。结果:缓解了阶级差异,扩大了社会基础,保障了平民的利益和权力。

-

-

主要冲突:与迦太基的布匿战争:

-

原因:展示了罗马的野心;冲突持续了 100 年,以暴力和残酷为标志。

-

迦太基:由腓尼基移民在北非建立;与罗马和平共处了 3 个世纪,直到发生冲突。

-

第一次布匿战争:罗马军队越过墨西拿海峡。没有决定性的胜利;迦太基在第二次布匿战争中遭受了重大损失。

-

最终战役(公元前 146 年):罗马夷平了迦太基,奴役了居民,将遗址犁平。象征着罗马对迦太基的毁灭性结局。

-

这个思维导图捕捉了罗马发展的关键地理、时间线、社会和冲突元素,如文本中所述。

图 18:该案例展示了 ERNIE-4.5-VL 的文档理解能力。

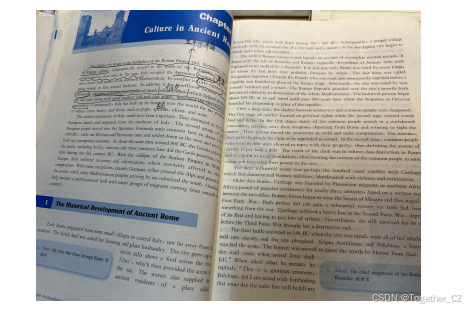

B.2 OCR 解析与文档理解 II

提示:这种药物的用途是什么?我应该如何服用?

模型响应:<think>...</think> 根据补充剂事实标签,以下是您需要的信息:

-

目的:这种补充剂旨在支持关节健康。

-

主要成分及其作用:

-

葡萄糖胺盐酸盐和软骨素硫酸钠:这些是主要成分。它们是软骨的构成成分,通常用于支持关节的舒适性、灵活性和活动性,主要针对骨关节炎(尤其是膝关节骨关节炎)。

-

透明质酸:有助于润滑关节,可能支持关节的缓冲作用。

-

枸橼酸钙:一种形式的硼,可能支持骨骼健康和关节功能。

-

-

总体目标:这种组合旨在支持关节的结构和功能,可能有助于减少不适并改善活动性。

-

-

如何服用(用法):

-

成年人每天两次,每次两片,随餐服用。

-

关键要点:

-

一致性:按照说明定期服用。

-

随餐服用:始终随餐服用,以帮助吸收并尽量减少可能的胃部不适。

-

用量:遵循标签说明(每天总共 2 片,要么一次性服用,要么分两次服用)。不要超过推荐用量,除非医疗保健专业人士另有指示。

-

适用人群:标签上注明“成人”,因此不适用于儿童。

-

-

重要注意事项:

-

未获 FDA 批准:请记住,这是一种膳食补充剂,不是药物。它不是用于诊断、治疗、治愈或预防任何疾病的。其有效性可能因个体而异。

-

咨询医生:

-

在开始任何新的补充剂之前:始终与医生或合格的医疗保健提供者交谈,特别是如果您有潜在的健康状况(如糖尿病、贝类过敏——见下文)、怀孕或哺乳,或正在服用其他药物。

-

贝类过敏:该产品含有贝类(虾、蟹、龙虾、小龙虾)。如果您对贝类过敏,请勿服用。

-

药物相互作用:补充剂可能与药物(例如,像华法林这样的血液稀释剂)相互作用。您的医生可以就潜在的相互作用提供建议。

-

基础健康状况:如果您有严重的关节疼痛或已确诊的疾病,您的医生可以确定最佳的治疗计划,该计划可能包括也可能不包括这种补充剂。

-

-

钠含量:尽管含量较低(<1% DV),如果您正在严格限制钠摄入的饮食中,注意每份的钠含量(2 克)。

-

其他成分:标签中列出了其他成分,如微晶纤维素、包衣和填充剂。如果您对这些成分中的任何一种过敏,请仔细检查“其他成分”列表。

-

-

总之:这种补充剂旨在支持关节健康。每天服用 2 片,要么一次性服用,要么分两次服用,每次随餐服用。在开始服用之前,至关重要的是咨询您的医生,特别是如果您有健康状况、服用药物或对贝类过敏。

图 19:展示了 ERNIE-4.5-VL 准确提取图像中的文本、理解用户的查询并从文档中检索答案的能力。来源:百度 ERNIE 团队成员拍摄的照片。

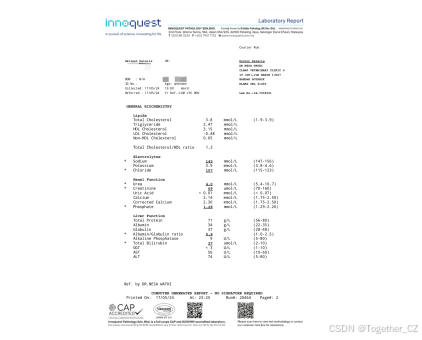

B.3 多语言 OCR 解析

提示:从医疗测试指南中提取信息并创建一个 Excel 表格(包括项目和参考值,完整的条件范围和单位)。

模型响应:<think>...</think> 以下是提取的医疗测试数据,以 Excel 样式表格的形式呈现:

说明:

-

“-” 表示该报告中未提供参考范围。

-

单位保持原样列出(例如,µmol/L、mmol/L、g/L)。

-

不等式(如 <0.01)保留自原始报告。

-

比率(如总胆固醇/高密度脂蛋白)缺乏单位,但在表中注明为“(比值)”,以便清晰。

图 20:该示例展示了 ERNIE-4.5-VL 的 OCR 解析和指令遵循能力。

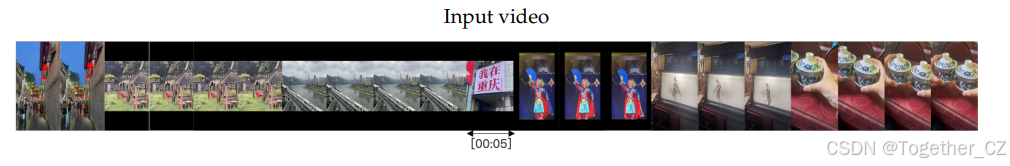

B.4 视频时间定位

提示:根据视频,你能帮我为它创建一些吸引人的字幕吗?

模型响应:

图 21:第一个问题测试了模型分解视频并为其重要事件提供简洁描述的能力(例如,为视频的不同部分创建详细的字幕)。第二个问题考察了模型在视频中准确定位和识别特定事件的能力(例如,在视频中找到特定场景)。来源:百度 ERNIE 团队成员拍摄的视频。

提示:视频中“CHONGQING”一词出现在哪一秒?

模型响应:在 5 秒时,屏幕上出现红色的“CHONGQING”字样。

-

探索重庆在黄昏时分的繁华街道,感受传统与现代的交融。

-

偷窥可爱熊猫在其自然栖息地中的模样,这是中国的真正象征。

-

看着单轨列车在河上滑行,提供对城市景观的壮观视野。

-

“我在重庆”——城市建筑上的一句大胆宣言,拥抱当地精神。

-

古老的艺术皮影戏重获新生,一场迷人的文化体验。

-

欣赏传统中式茶具的优雅,片刻宁静。

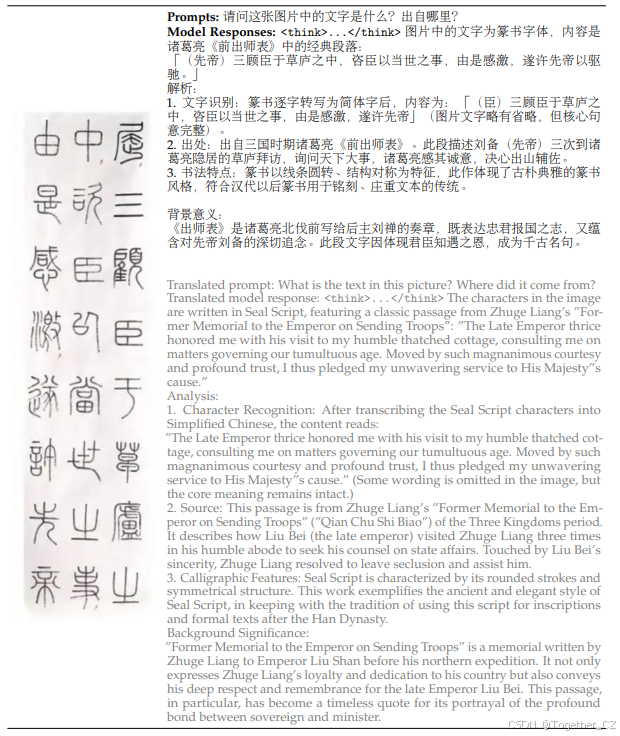

B.5 OCR 古代中文字符识别

提示:这张图片中的文字是什么?出自哪里?

模型响应:<think>...</think> 图片中的文字为篆书字体,内容是诸葛亮《前出师表》中的经典段落:

“(先帝)三顾臣于草庐之中,咨臣以当世之事,由是感激,遂许先帝以驱驰。”

解析:

-

文字识别:篆书逐字转写为简体字后,内容为:“(臣)三顾臣于草庐之中,咨臣以当世之事,由是感激,遂许先帝以驱驰。”(图片文字略有省略,但核心句意完整)

-

出处:出自三国时期诸葛亮《前出师表》。此段描述刘备(先帝)三次到诸葛亮隐居的草庐拜访,询问天下大事,诸葛亮感其诚意,决心出山辅佐。

-

书法特点:篆书以线条圆转、结构对称为特征,此作体现了古朴典雅的篆书风格,符合汉代以后篆书用于铭刻、庄重文本的传统。

背景意义:《出师表》是诸葛亮北伐前写给后主刘禅的奏章,既表达忠君报国之志,又蕴含对先帝刘备的深切追念。此段文字因体现君臣知遇之恩,成为千古名句。

翻译提示:What is the text in this picture? Where did it come from?

翻译模型响应:<think>...</think> The characters in the image are written in Seal Script, featuring a classic passage from Zhuge Liang’s “Former Memorial to the Emperor on Sending Troops”: “The Late Emperor thrice honored me with his visit to my humble thatched cottage, consulting me on matters governing our tumultuous age. Moved by such magnanimous courtesy and profound trust, I thus pledged my unwavering service to His Majesty’s cause.”

Analysis:

-

Character Recognition: After transcribing the Seal Script characters into Simplified Chinese, the content reads: “The Late Emperor thrice honored me with his visit to my humble thatched cottage, consulting me on matters governing our tumultuous age. Moved by such magnanimous courtesy and profound trust, I thus pledged my unwavering service to His Majesty’s cause.” (Some wording is omitted in the image, but the core meaning remains intact.)

-

Source: This passage is from Zhuge Liang’s “Former Memorial to the Emperor on Sending Troops” (”Qian Chu Shi Biao”) of the Three Kingdoms period. It describes how Liu Bei (the late emperor) visited Zhuge Liang three times in his humble abode to seek his counsel on state affairs. Touched by Liu Bei’s sincerity, Zhuge Liang resolved to leave seclusion and assist him.

-

Calligraphic Features: Seal Script is characterized by its rounded strokes and symmetrical structure. This work exemplifies the ancient and elegant style of Seal Script, in keeping with the tradition of using this script for inscriptions and formal texts after the Han Dynasty.

Background Significance: “Former Memorial to the Emperor on Sending Troops” is a memorial written by Zhuge Liang to Emperor Liu Shan before his northern expedition. It not only expresses Zhuge Liang’s loyalty and dedication to his country but also conveys his deep respect and remembrance for the late Emperor Liu Bei. This passage, in particular, has become a timeless quote for its portrayal of the profound bond between sovereign and minister.

图 22:该示例突出显示了模型识别古代中文字符的能力。我们的模型能够准确识别小篆,并理解字符背后的典故。为简洁起见,省略了思考令牌。

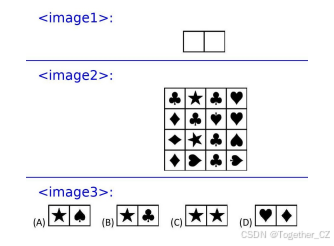

B.6 推理案例:演绎视觉谜题

提示:Karina 从图中剪出了一个形状。她能从图 2 中剪出以下哪个形状?解决多项选择题,然后以给定的选项字母回答。最后的回答应该以以下格式结束:“最终答案:$LETTER'”(不带引号),其中 LETTER 是给定选项中的一个。在回答之前,逐步思考。

模型响应:

<think> 我需要弄清楚 Karina 能从图 2 中使用图 1 中的形状剪出什么。让我先理解一下涉及的形状。

首先,图 1 显示了一个简单的矩形,分为两个并排的正方形。所以,这个形状是一个 1×2 的矩形。这意味着 Karina 从图 2 中剪出的任何形状都必须是一个 1×2 的矩形,对吧?但等等,图 2 是一个 4×4 的网格,每个符号(俱乐部、星星、菱形、心形)都在一个正方形中,所以网格是 4 行 4 列。Karina 要剪出一个宽为两个正方形、高为一个正方形的形状,或者可能是宽为一个正方形、高为两个正方形?等等,图 1 中的形状是水平相邻的两个正方形。所以,她从图 2 中剪出的形状必须是两个水平相邻的正方形。但看看图 3,选项都是成对的符号。让我检查一下选项:……等等,也许我数错了。等等,每行有四个符号。让我把它们列出来。第一行:♣, ★, ♣, ♥;第二行:♦, ♣, ♥, ♥;第三行:♦, ★, ♣, ♥;第四行:♦, ♥, ♣, ♥……所以,正确答案是选项 B。</think>

Karina 需要从图 2 中的 4×4 网格中剪出一个 1×2 的水平形状,使用图 1 中的形状。从图 2 中剪出的有效符号对必须与图 3 中的选项之一匹配。

-

选项 A(★ 和 ♥):图 2 中没有出现心形(♥),所以这个选项无效。

-

选项 B(★ 和 ♣):在第一行,第 2 列(★)和第 3 列(♣)形成一个有效的水平对。同样,第三行,第 2 列(★)和第 3 列(♣)也形成一个有效的匹配。这与选项 B 匹配。

-

选项 C(★ 和 ★):网格中没有两个相邻的星星(★),所以这个选项无效。

-

选项 D(♠ 和 ♦):唯一的一对心形-菱形出现在第四行,第 1 列(♦)和第 2 列(♠),但这对符号的顺序是反过来的(♦ 然后是 ♠),而不是选项 D 中要求的顺序(♠ 然后是 ♦)。

最终答案:选项 B

图 23:该示例简要展示了 ERNIE-4.5-VL 通过解决演绎视觉谜题来展示其反思推理能力。

B.7 推理案例:化学

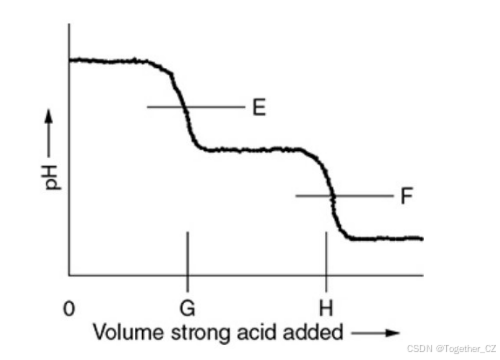

提示:上面的图表代表了草酸钠(Na2C2O4)与强酸(如盐酸 HCl)反应的理想化滴定曲线。E 和 F 代表滴定的 pH 值。G 和 H 将取决于样品的组成,可能其中一个不会出现。除了水之外,E 点溶液中的主要物种是什么?选项:(A)Na2C2O4 和 HCl(B)Na+、Cl− 和 HC2O−4(C)C2O2−4 和 H+(D)Na+、H+ 和 C2O2−4

模型响应:<think>...</think> 在滴定曲线的 E 点,达到了第一个等当点。草酸钠(Na2C2O4)完全解离成 2Na+ 和 C2O2−4。在用 HCl 滴定时,H+ 离子与 C2O2−4 反应生成 HC2O−4。在第一个等当点,所有的 C2O2−4 都转化为了 HC2O−4。溶液中还包含来自原始盐的 Na+(作为旁观者离子)和来自 HCl 的 Cl−。

分析选项:

-

(A)错误。Na2C2O4 和 HCl 不在等当点出现;反应已经完成,HCl 被中和了。

-

(B)正确。Na+(旁观者离子)、Cl−(来自 HCl)和 HC2O−4(反应产物)是主要物种。

-

(C)错误。C2O2−4 完全转化为 HC2O−4,而 H+ 在这个阶段不是主要物种。

-

(D)错误。虽然 Na+ 存在,但 H+ 和 C2O2−4 不是主要物种;HC2O−4 才是主要的。

答案:(B)(Na+、Cl− 和 HC2O−4)

图 24:该示例展示了 ERNIE-4.5-VL 解决化学问题的能力,突出了模型的逻辑推理能力。为简洁起见,省略了思考令牌。

B.8 推理案例:数学

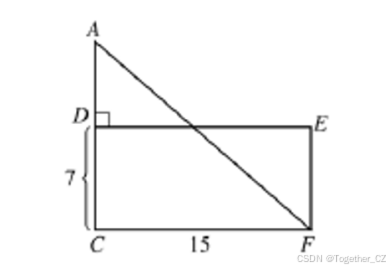

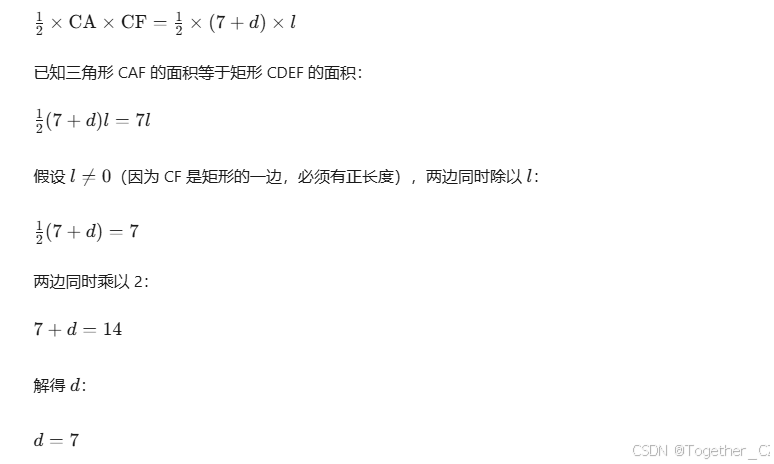

提示:在上面的图中,如果三角形 CAF 的面积等于矩形 CDEF 的面积,那么线段 AD 的长度是多少?选项:A. 7/2 B. 5 C. 7 D. 15/2 E. 15

模型响应:<think>...</think> 根据题目,矩形 CDEF 的面积等于三角形 CAF 的面积。矩形 CDEF 的边长 CD 为 7。矩形 CDEF 的面积是其相邻两边乘积,CD 和 CF(CF 与 FC 相同,是矩形的一边)。设 CF 的长度为 l。因此,矩形 CDEF 的面积为 7×l=7l。

三角形 CAF 是一个直角三角形,直角在 C 点。其两条直角边分别是 CA 和 CF。由于 D 在 CA 上,且 CD = 7,假设 A 在 D 的上方,所以 CA = CD + AD,设 AD = d。那么 CA = 7 + d。三角形 CAF 的面积为:

因此,线段 AD 的长度为 7。

这个结果与 CF 的长度无关,因为 l 在等式中被约去了。

答案:C

图 25:该示例展示了 ERNIE-4.5-VL 解决数学分析几何问题的能力,突出了逻辑推理能力和数学计算技能。为简洁起见,省略了思考令牌。

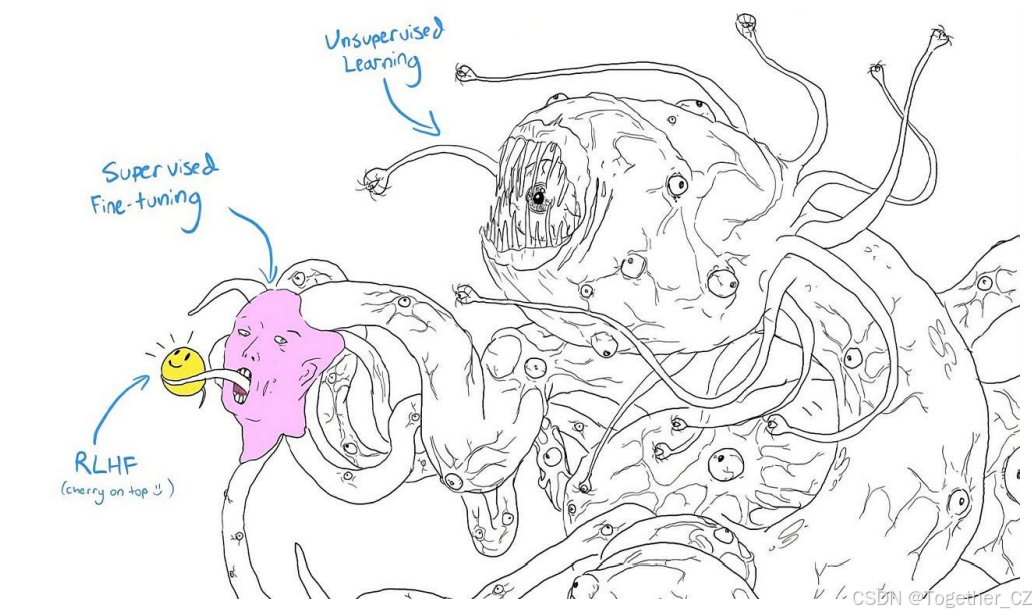

B.9 推理案例:深度语义图像理解

提示:这张图试图传达什么内容?

模型响应:<think>...</think> 这幅图是一幅讽刺性的、隐喻性的机器学习概念图,使用了怪诞且幽默的视觉元素来传达关键思想:

-

无监督学习(大生物):

-

被描绘成一个混乱的、多眼的怪物,带有触手。它象征了无监督学习的无结构、探索性本质——在没有预定义规则的情况下从无标签数据中寻找模式。

-

这个生物的复杂性反映了无监督方法(例如聚类、生成模型)的混乱但强大的特性。

-

-

监督微调(粉色类人生物):

-

被描绘成一个较小的、脆弱的人物,被怪物操纵。它代表了对预训练模型(例如大型语言模型)使用标记数据进行特定任务微调的过程。

-

这个人物的从属地位突出了微调在无监督基础之上的受控性质。

-

-

RLHF(强化学习从人类反馈中学习)(网球):

-

被标记为“樱桃”,带有笑脸。它象征了 RLHF 作为“奖励”或微调步骤,其中人类反馈使模型输出与人类偏好对齐(例如,使响应有帮助/无害)。

-

这个网球(一种奖励)表明 RLHF 是一个“奖励”,在开放书中考试(需要模型仅依赖其内部知识)之后,将考试转变为一个开放书考试。RLHF 确保模型的输出更接近参考答案的内容和结构特征,从而保证全面覆盖。

-

整体信息:

-

这幅图幽默地批评了机器学习流程:

-

无监督学习是产生原始能力的混乱“基础”。

-

监督微调将这个基础用于实际用途。

-

RLHF 是最后的润色,使输出更符合人类价值观。

-

-

怪诞的风格讽刺了 AI 系统的复杂性,而笑脸上的网球增加了讽刺意味——RLHF 被视为对更深层次问题的肤浅“修复”。

这个隐喻强调了现代 AI 如何结合无结构的探索(无监督)、针对特定任务的微调(监督)和以人类为中心的调整(RLHF)来创造功能性系统。

图 26:该示例展示了 ERNIE-4.5-VL 先进的图像理解能力。为简洁起见,省略了思考令牌。

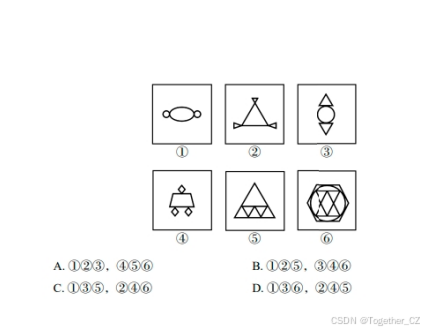

B.10 视觉推理:视觉模式识别

提示:从四个给定选项中选择最合适的一个来填充问号,使图形遵循一种模式。

模型响应:<think>...</think> 这些图形可以根据它们的结构组成进行分类:

-

类别 1(图形 1、3、6):这些图形由不同的元素连接或叠加而成(例如,单独的圆通过线连接,三角形上叠加了一个圆,或者六边形中有相交的内部线条)。

-

类别 2(图形 2、4、5):这些图形具有集成的结构(例如,三角形被线条分割,钻石上有附加的小钻石,或者三角形被分割成更小的三角形)。

答案:D

提示:从四个给定选项中选择最合适的一个来填充问号,使图形遵循一种模式。

模型响应:<think>...</think> 这些图形遵循对称性、复杂性和引入新元素的模式。以下是分析:

-

对称性进展:这些图形表现出不同的对称性——垂直(三角形)、旋转(带螺旋的圆)、水平/垂直(十字)、对角线(重叠的平行四边形)和径向(花朵)。下一个图形应该与这种进展一致。选项 C(星形在平行四边形中)引入了对角线对称性,与之前的平行四边形相呼应,而 D(带点的圆)保持了径向对称性。然而,这个序列并不严格重复对称性类型,而是倾向于结构演变。

-

复杂性和层次化:这些图形从简单的形状(三角形、圆)发展到组合形式(带圆圈的十字、重叠的平行四边形)和有机形式(花朵)。选项 C 通过将新元素(星形)与之前出现的平行四边形相结合,反映了这种层次化趋势。

-

元素引入:每个图形都引入了一个新元素(例如,螺旋、十字臂、重叠的形状、花瓣)。选项 C 继续这种趋势,通过将星形(新元素)与平行四边形(之前出现的)结合起来。

答案:C

图 27:这两个示例成功地展示了 ERNIE-4.5-VL 如何利用其视觉归纳推理能力正确找到模式并预测缺失的模式。

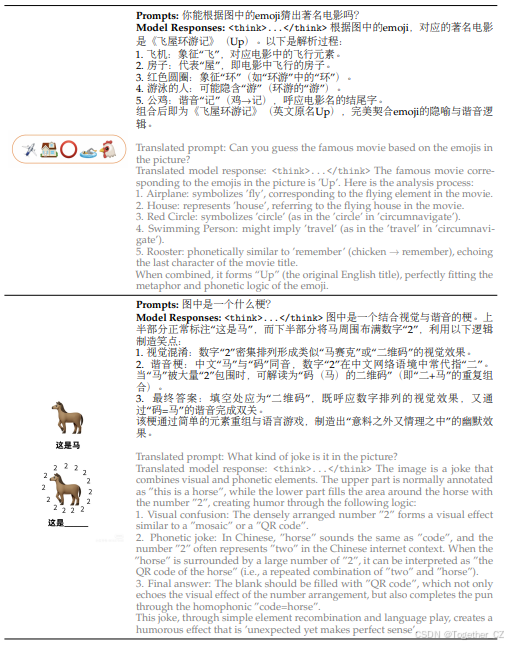

B.11 视觉推理:表情符号测验

提示:你能根据图中的表情符号猜出著名电影吗?

模型响应:<think>...</think> 根据图中的表情符号,对应的著名电影是《飞屋环游记》(Up)。以下是解析过程:

-

飞机:象征“飞”,对应电影中的飞行元素。

-

房子:代表“屋”,即电影中飞行的房子。

-

红色圆圈:象征“圈”(如“环游”中的“圈”)。

-

游泳的人:可能隐含“游”(环游的“游”)。

-

公鸡:谐音“记”(鸡→记),呼应电影名的结尾字。

组合起来就是《飞屋环游记》(英文原名 Up),完美契合表情符号的隐喻与谐音逻辑。

提示:图中是一个什么梗?

模型响应:<think>...</think> 图中是一个结合视觉与谐音的梗。上半部分正常标注“这是马”,而下半部分将马周围布满数字“2”,利用以下逻辑制造笑点:

-

视觉混淆:数字“2”密集排列形成类似“马赛克”或“二维码”的视觉效果。

-

谐音梗:中文“马”与“码”同音,数字“2”在中文网络语境中常代指“二”。

1242

1242

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?