摘要:自动化系统在现今航空业中得到了广泛应用, 然而复杂的自动化系统的引入产生了新的失误模式, 使航空人因安全问题变得更加突出。受多种因素影响, 操作者在与自动化系统的交互过程中并不总能达到适 度的信任校准水平。非适度自动化信任和依赖引发了严重的航空安全事故。值得欣慰的是,以人为中心的自动化显示设计和训练能够将非适度自动化信任和依赖调整到适度状态。

(本文照片皆由徐阳先生拍摄)

1 引言

自动化(Automation)是指可以执行原本由人来完成的一种或一系列任务的技术。自动化包括:数据/信息的选择,信息的转化,决策和行动 (Parasuraman & Wickens, 2008)。自动化广泛应用于航空领域, 特别是在飞机驾驶舱中(Merritt, Unnerstall, Lee, & Huber, 2015)。应用飞机自动化系统, 可以提高燃油效率, 减少机组工作负荷添加额外的功能, 提高安全和可靠性, 也可以提高旅客的舒适度。然而由自动化所带来的好处, 并不像预期的那样容易获得。相反, 自动化可能引起了新的失误模式, 提高工作负荷, 带来新的认知和注意以及训练需求的增加(Billings, 1996)。为了减少人为失误, 航空领域采用了非常多的技术, 但这些技术并没有减少人为失误, 而是改变了失误模式, 使后果更为严重, 并且延长了觉察和修 复失误的时间(Dekker & Woods, 2002)。

凡事皆有度。任何度的两端都存在着极限, 过多或过少都会带来不利的影响。当操作者因过 度信任自动化而误用自动化, 或者由于不信任自动化而不使用自动化的时候, 会导致事故的发生 (Parasuraman & Riley, 1997)。最近的统计数据表 明增加的与手动控制和自动化失误相关的航空事 故主要归因于非适度自动化信任(automation trust) 和依赖(automation dependence)。受非适度自动化 信任和依赖的影响, 可能使飞机处于失控状态或 者处于危险的边缘——失控(LOC), 可控飞行撞 地 (CFIT), 偏出跑道事故等(Federal Aviation Administration, 2013a, b)。为促进我国航空事业持 续健康安全地发展, 深入理解影响自动化信任和 依赖的因素以及自动化信任和依赖所产生的影响 是十分必要的, 而更有意义的是如何将这种非适 度自动化信任和依赖调整到适度的状态。

2 自动化信任与依赖的内涵

首先, 对自动化信任和自动化依赖进行区分是必要的。信任经常被定义为关于结果的期待或 者是某人对某些未来事件发生所持有的主观概率 (Rempel, Holmes, & Zanna, 1985)。信任对于理解人−自动化交互是一个重要的概念(Lee & Moray, 1992)和心理现象。自动化信任也是指用户的一种认知或情感状态, 它可以通过主观评分来测量 (Singh, Molloy, & Parasuraman, 1993)。而自动化依 赖是一种行为反应(Meyer, 2001), 能够通过用户与自动化的互动来测量(Lee & Moray, 1992), 比如用户使用自动化、遵从自动化建议或者对原始数据和自动化建议进行交叉检查的程度(Bahner, Hüper, & Manzey, 2008)。

其次, 自动化信任与依赖之间也相互关联: 就像在人际关系中一样, 尤其是在那种以不确定 性为特征的环境里, 信任在测定人依赖自动化系 统的意愿时起了主导作用。一般来说, 人们倾向于依赖他们所信任的自动化, 拒绝他们不信任的 自动化。例如, 不需要反复核对从 ATM 机取出的 钱数, 因为它从没有出现过差错。然而, 行为反应 不需要与自动化信任完全一致(Parasuraman & Riley, 1997), 当经历过一次银行卡被 ATM 机“吞掉”后, 下次使用会变得“小心翼翼”。有时我们可 能被迫去依赖自动化, 但不会完全信任它; 有时 我们也可能会完全信任自动化, 但不完全依赖它, 例如, 手动执行任务所带来的体验与自动化相比 会更刺激, 让用户更兴奋。

3 自动化信任和依赖的心理机制

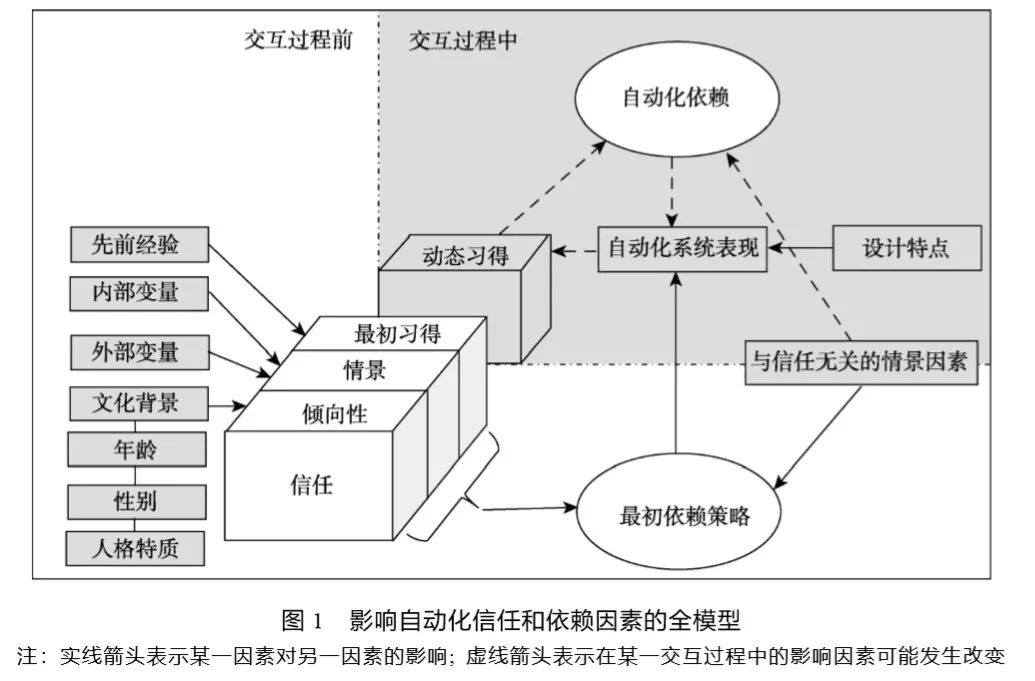

很多变量以相同的方式影响着自动化信任与依赖, 研究人员已经在不同的实验范式中使用各种不同的自动化系统来研究这一问题。这些变量 大都源自于操作者、环境和自动化系统, 与此相 对应, Marsh和Dibben (2003)将自动化信任分为三 个类别(倾向性信任, 情景信任和习得信任)。倾向性信任(dispositional trust)是指操作者信任自动化的持续倾向性, 操作者的文化背景、年龄、性别和人格特质都会影响这种倾向性。Huerta, Glandon和 Petrides (2012)研究发现与美国人相比, 墨西哥人更相信自动化决策辅助而很少相信手动决策辅助。情景信任(situational trust)是指信任依赖于特 殊的环境背景, 影响这一类型信任的因素可以分为外部变量(系统类型、系统复杂性、任务难度、工作负荷、自动化可靠性、组织环境、任务框架 等)和内部变量(自信、情绪、注意力等)。Perkins, Miller, Hashemi和Burns (2010)发现当情景风险持续升高时, 实验参与者很少相信和使用 GPS 路线导航规划设备; 也有研究揭示, 体验到积极情绪的实验参与者对自动化辅助决策系统有更高水平 的最初信任(initial trust) (Stokes et al., 2010)。习得 信任(learned trust)是指信任基于与过去某一自动 化系统有关的经验, 先前的经验包括态度、期望、 自动化系统的声誉和对系统的理解。很多研究已 经表明当自动化系统被描述成声誉好的或者“专 家”系统时, 人们更倾向于信任自动化(de Vries & Midden, 2008; Spain & Madhavan, 2009)。Hoff 和 Bashir (2015)针对上述模型做了改进, 他们认为 习得信任可以具体分为两种情况:一种是在人−自动化交互之前的最初习得(initial learned),另一种是在交互过程中的动态习得(dynamic interaction)。最初习得是基于先前的经验, 而动态习得则是在人与自动化系统的交互过程中形成的信任和依赖状态。最后形成了如图 1 所示的影响自动化信任和依赖因素的全模型。

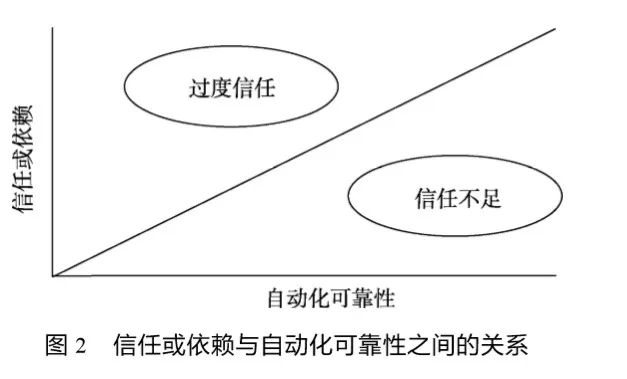

然而在所有这些变量中, 最重要的变量当属 自动化可靠性(automation reliability)。除了特别简 单的系统外, 对于任何自动化系统来说, 完全的 可靠几乎是不可能的。这就意味着操作者存在不 信任自动化系统的可能性。不论影响这种可靠性 的来源是什么, 自动化信任或依赖和可靠性之间 的关系可用校正曲线(calibration curve)来说明 (Wickens, Hollands, Banbury, & Parasuraman, 2012)。如图 2 所示 X 轴为可靠性(可以数字化表 示为在 0~1.0 的任意数, 由自动化误差数除以机 会误差数); Y 轴是信任或依赖, 信任可以通过最 小值−最大值主观量表评估得到, 依赖则通过对 自动化使用次数的比例的客观测量来加以量化。 对角线代表一条完美的校准线。显然, 这条线将 空间分为两个区域:左上角的过度信任和右下角 的信任不足。在一般情况下, 操作人员所操作的 自动化系统都有较高的可靠性, 它可能试运行了 很多次都没有出现故障, 在此期间, 操作人员就 对该自动化系统建立起信任并产生依赖, 也就是 到达了图 2 的左上角区的自满水平。然后, 故障出现了, 也就是首次失败(first failure effect)。首次 失败在研究人−自动化互动中具有重要意义 (Rovira, McGarry, & Parasuraman, 2007)。操作人 员对首次失败的反应(或不响应)往往是动态的 (Yeh, Merlo, Wickens, & Brandenburg, 2003), 并 且它是许多自动化事故的典型代表, 例如飞机自 动化的首次失败经历(Dornheim, 2000)。在首次失 败后, 操作者的主观信任通常会越过图 2 中的校 正曲线到达最右下方, 表现出极大的不信任。而 后, 随着时间的推移, 信任和依赖将逐步恢复, 在较大的可靠性范围内逼近校正线(Yeh et al., 2003)。接下来我们将分析在航空领域中操作者过 度的信任校准(非适度自动化信任和依赖)所导致 的严重后果及其解决方案。

4 非适度自动化信任和依赖的类型及其危害

4.1 过度信任(over trust)

4.1.1 自满(complacency)

自满这一术语源自与航空业有关的事故或事件, 据称在这些事故或事件当中飞行员、空中交通管制员或者其他操作员并没有进行充分的系统 状态检查(疏忽性失误)。一般来说, 自满伴随着这样一种假设:“一切顺利”, 然而事实上却存在一个 导致事故发生的危险条件(Parasuraman & Manzey, 2010)。美国国家航空航天局航空安全报告系统 (ASRS)将自满作为事故报告的一个编码项目 (Billings, Lauber, Funkhouser, Lyman, & Huff, 1976)。Wiener (1981)认为 ASRS 像其他研究者一 样, 将自满定义为“以低指数的怀疑为特征的心 理状态”。Wiener 提出进行相关的实证研究是十分 必要的, 这样可以加深理解自满的机制以加强航 空安全。 满足于自动化的操作员几乎不去监控自动化 正在进行的工作, 丧失了对自动化系统自身和周 围发展状态的情景意识(Kaber, Onal, & Endsley, 1999)。2009年土耳其航空公司TK1951航班坠毁。 事故的主要原因是飞行员对自动化系统十分信任, 以致于当飞机的高度测量仪失效后迟迟未能检测 到这个故障, 飞行员仍然使用飞机的自动驾驶模 式, 最终导致事故的发生。此外, Metzger 和 Parasuraman (2005)在高保真雷达管制模拟机上 对经验丰富的空中交通管制员进行测试中发现: 能够在自动化系统失灵的情况下检测到冲突的 管制员数量显著低于在人工情况下检测到冲突 的管制员数量, 进一步的眼动分析还表明那些 没有检测到冲突的管制员在自动化辅助情况下 比在人工控制情况下, 对雷达显示屏的注视次 数显著减少。

4.1.2 自动化偏见(automation bias)

自动化偏见被定义为:“以启发式的方式替代对警觉信息的搜索和加工” (Mosier & Skitka, 1996)。与自满密切相关的自动化偏见通常与在复 杂环境中支持人类决策的自动化辅助决策息息相 关(Mosier & Fischer, 2010)。在航空领域中, 不正确的决策会引起较高的经济后果, 而自动化辅助决策系统就是为了提高人类的决策效率, 所以自动化辅助决策系统对航空领域有特殊的价值。比如像空中防撞系统(TCAS)或者近地防撞警告系统(GPWS)这样的驾驶舱预警系统, 可以提供给 驾驶员具体的建议或命令(例如, “拉升!拉升!”) 以避免碰撞。由于以下两点原因, 辅助决策系统 经常是被误用的:第一, 自动化生成的线索是十 分突显的, 吸引了用户的注意并干扰了当前的行 进任务; 第二, 相比于其他来源的建议, 用户倾 向于赋予自动化辅助系统更大的权威。

自动化偏见导致用户可能不会对所有可用信息逐一分析, 哪怕自动化系统的建议是不正确的, 用 户也会遵从或执行该建议, 从而犯下错误(Bahner et al., 2008)。飞行结冰事件严重威胁飞行安全, 必 须及时处理。McGuirl 和 Sarter (2006)检查飞行员 与自动化辅助决策系统交互的性能, 该系统是为 飞行结冰事件提供决策支持的。研究结果表明:即 便可利用动觉线索与辅助决策相矛盾, 飞行员仍 然会下意识地听从自动化辅助决策系统的建议, 产生了明显的自动化偏见的倾向。Wickens 和 Alexander (2009)总结几个关于熟练飞行员的模拟 研究时发现, 即使在飞行员查询原始数据或者观 察飞机挡风玻璃外的环境就能发现危险的情况下, 52%的飞行员还是会遵从空中交通管制的指引, 直接导致他们进入了有障碍物或者危险的路径。

4.1.3 过度依赖(over dependence)

操作者手动执行任务的能力可能会随着时间 的推移而降低, 这种现象有时也被称为“去技能化” (Ferris, Sarter, & Wickens, 2010; Geiselman, Johnson, & Buck, 2013)。随着飞行管理系统(FMS) 的应用, 即使是飞相同的航路, 自动驾驶仪规划 和采用的路线也要比飞行员的人工算法精细, 实 现更高效的飞行(Sebok et al., 2012), 因此飞行员 会依赖这类自动化技术。然而根据美国联邦航空 局(Federal Aviation Administration, 2013a)进行的 一项调查发现, 由于飞行员过分依赖自动化操作, 以致于当他们需要手动操控飞机时手足无措, 调 查写道, “飞行员习惯了看着故障发生, 而已经丧 失了着手去解决它们的积极性。”

2009年法航AF447航班在从巴西里约热内卢飞往法国巴黎的途中坠入大西洋。事故调查表明, 尽管恶劣的气象条件(热带风暴)可能是事故的主要原因, 然而当险情发生时飞行员向后拉杆(实际 上应该向前推杆)导致飞机高空失速也是事故的重要原因(Bureau d’Enquêtes et d’Analyses pour la Sécurité de l’Aviation Civile, 2013)。2013 年韩国韩亚 航空公司 214 航班在美国旧金山机场降落时坠毁。 事故原因调查指向了驾驶员存在驾驶经验欠缺的 可能, 副驾驶过分依赖自动化飞行控制系统, 没 有准确地设置自动化, 导致飞机在进近阶段撞上 防波堤(National Transportation Safety Board, 2013)。

4.2 信任不足(undertrust)

4.2.1 自动化惊奇(automation surprise)

自动化惊奇是在 20 世纪 90 年代首次出现在 航空文献上的措辞(Woods, Johannesen, Cook, & Sarter, 1994)。自动化惊奇可以被描述为“在一些情 况下, 自动化没有立即做出与此前机组人员输入 相关信息后相一致的行动, 或者自动化的操作与 机组成员的预期不一致”。需要注意的是这个定义所指的差异早在飞行员意识到这一点前就已经存在了, 这类似于无意识盲视, 自满和自动化偏见 (Parasuraman & Manzey, 2010; de Boer, 2012; de Boer, Heems, & Hurts, 2014)。有时, 自动化惊奇也 可以被通俗地定义为飞行员声称或者认为的情 景:“自动化正在做的是什么?”, “自动化为什么 这样做?”, “下一步自动化将会做什么?” (Wiener, 1989)。

在现有的文献中, 自动化惊奇经常与在驾驶舱 高度自动化条件下的情景意识(situation awareness) 丢失有关(Operator’s Guide to Human Factors in Aviation, 2014), 飞行员可能在飞机出现严重故障 时感到困惑——弄不清自动驾驶何时结束, 自己 的职责又何时开始, 提高了坠机和失控的风险。有 研究使用眼动和三维运动飞行模拟机研究发现:自 动化惊奇要么使飞行员的注意变为过度搜索模式, 要么变为低效搜索模式(Dehais, Peysakhovich, Scannella, Fongue, & Gateau, 2015)。Hurts 和 de Boer (2014)主持了一项航线飞行员的调查, 结果 发现自动化惊奇是一种比较常见的现象, 平均每 个飞行员每个月都会发生。已经发生了几起与自 动化惊奇有关的飞行事故, 例如前文所述发生在 2009 年的土耳其航空公 TK1951 航班和法航 AF447 航班坠毁事故(Dutch Safety Board, 2010; Bureau d’Enquêtes et d’Analyses pour la Sécurité de l’Aviation Civile, 2013)。

4.2.2 虚假警报(false alarms)

虚假警报(虚警)也是信任不足的一种典型表现, 虚警是指即使不存在触发告警的条件, 警告 也会响起(Parasuraman, Hancock, & Olofinboba, 1997)。这种误报导致操作员不信任告警系统, 当 用户关闭这些“恼人”且不可靠的告警系统时从未 出现过紧急事件, 导致用户对真实告警的忽略。 研究发现, 尽管 45%的空中交通管制员在收到冲 突告警后不需要采取任何行动(也没有采取任何 行动), 但是恰恰一些灾难性事故的发生可能是由 “狼来了” 效应(“Cry Wolf” Effect)所导致的 (Wickens et al., 2009)。

2001年大韩航空公司的客机在关岛坠毁, 这起事故就是“狼来了”效应所导致的悲惨后果的典 型代表。在这起事故中, 由于近地防撞系统发出 太多的虚假警告, 空中交通管制员禁用了此系统, 致使他们根本没有注意到这架飞机在还没有进入 跑道之前就已经撞到山上。同样危险的是, 机载 电脑还会在危急关头向飞行员不分主次地倾泻大量警示信号(包含了大量的虚警), 使飞行员应接 不暇。例如2010年澳大利亚航空 32 号航班发生引擎爆炸, 当机长尝试降落时, 他和副驾驶却被 屏幕上闪出的120个指令菜单晃得眼花缭乱, 而不清楚究竟哪个信号是解决问题的关键信息。万幸的是该航班最终成功迫降新加坡樟宜机场。

5 解决途径:以人为中心的自动化显示设计和训练

对于如何解决这些由自动化信任和依赖引起 的航空危害, 就要从引起问题的原因入手, “对症 下药”, 力求“药到病除”。从上文我们可以看到, 非适度的自动化信任和依赖(过度信任和信任不 足)即过度的信任校准是导致人−自动化不良交互 的重要原因。Lee 和 See (2004)认为适度的自动化 信任和依赖可以减少误用自动化和不使用自动化 (由过度信任和信任不足所致)发生的频率。值得欣 慰的是, 已有大量的证据表明人类用户所表现出 的过度信任和信任不足, 都可以通过以人为中心 的自动化显示设计和训练得以改进。因此以人为 中心的自动化(human-centered automation; Billings, 1997)设计, 或者说如何做到人−自动化的适度结 合, 成为自动化系统的设计者所面临的挑战(Lee & Seppelt, 2009)。

5.1 减轻过度信任和依赖

对于减轻过度信任和依赖来说, 有证据表明提供自动化的可靠性信息(例如, 告知用户自动化 有 50%、70%或 90%的可靠性)可以帮助用户校准 他们对自动化战斗识别系统的信任和依赖(Neyedli, Hollands, & Jamieson, 2011; Wang, Jamieson, & Hollands, 2009)。此外, 通过对自动化首次失败反 应和后续失败反应进行的比较, 发现在实际使用 自动化前进行训练或练习是解决首次失败最好的 技术之一(Manzey, Reichenbach, & Onnasch, 2012)。对于用户来说, 仅仅被告知会发生故障远 不及实际体验该故障更有效。Bahner 等(2008)研 究发现, 用户的自动化故障体验降低了自满水平。这一发现表明暴露于自动化故障的训练可以 减轻过度信任和依赖。对于飞行员或空中交通管制员来说, 理解自动化系统的局限性, 做好突发故障的模拟训练可以提高自动化信任和依赖的校准水平。

5.2 减轻信任不足

由于自动化系统的复杂性, 操作员可能不理 解“黑匣子”里面究竟发生了什么, 因此对复杂自 动化系统进行功能简化或者良好的界面设计会使 飞行员感觉自动化系统更明确, 同时也应该加强 操作员对自动化运行机制的培训。在显示设计方 面, Dehais等(2015)通过在驾驶舱里增加了一种让 飞行员详查自动驾驶仪详情的文本提示降低了自 动化惊奇的可能。此外, 有证据表明报警器误报 问题在一定程度上可以通过似然度显示而减轻 (Sorkin, Kantowitz, & Kantowitz, 1988)。这种显示 设计对临界条件的存在与否提供了两个或多个确 定性等级水平。也就是说, 这种显示设计允许系 统说“我不确定”, 而不是随便给出一个完整的警 报或根本不给警报。这样, 在信任程度上允许报 警系统有一个相应的区间(例如, 很不确定, 不确 定, 确定, 很确定), 能够对人和系统的灵敏度带 来一定的改善。在培训方面, 用户必须意识到系 统发生故障的可能性很微小, 但是带来的后果却 是危险的。因而早期的告警是必要的, 即便报警 器的误报现象(“狼来了效应”)是不可避免的。所以 无论是飞行员还是空中交通管制员, 当有警报发 生时必须尽快处理不容忽视; 然而相应的诊断虚 警的经验和专业培训也是必不可少的。

6 总结与展望

自动化系统广泛地应用在航空业中, 无论是机载自动化设备还是地面空管自动化设备, 都旨在减少飞行员和空中交通管制员的负荷, 完成操作者无法或者不便直接执行的任务, 弥补操作者 能力的局限, 增强协助人的操作, 更经济高效。例 如, Watts, Ambrosia和Hinkley (2012)开发的自动化航线规划辅助系统, Giraudet, Imbert, Bérenger, Tremblay 和 Causse (2015)设计的空中交通管制的 界面显示等。然而由于非适度的自动化信任和依 赖校准, 人−自动化系统并非总是良好匹配。过度 自信(自满、自动化偏见、过度依赖)和信任不足(自 动化惊奇、虚假警报)及其所引发的航空安全事故 和事故征候值得我们深入探究。需要说明的是, 自动化信任和依赖并非一成不变而是动态变化的, 就一起航空安全事故或者事故征候来说, 存在过 度信任和信任不足两种现象都发生的可能。因此 今后可以从自动化信任和依赖的不同水平和自动 化的不同阶段的角度出发, 继续这一问题的研究。

以人为中心的自动化显示设计和训练可以将这种非适度自动化信任和依赖调整到适度的状态。良好的显示设计应该对自动化当前状态、状态的变化(比如不同自动化水平和功能模式之间 的切换)以及自动化所监测或控制的进程状态等 关键信息的呈现上做出改进, 使用户易于熟悉理 解。显示设计是可以不断改进的, 但是航空活动 毕竟是复杂且专业的, 相关的手动训练和事故模 拟训练是必不可少的。最后从航空业本身的发展上来说, 技术上的进步已经可以使无人(遥控或者 自动)商用飞行成为可能。如此, 由飞行员非适度 的自动化信任与依赖所造成的航空活动中的不利影响将不会出现。但是,对于地面操作人员来说,这种新技术的引入是否会产生新的非适度自动化 信任和依赖, 进而造成危害呢?另外, 从乘客的 角度来说, 人们会不会接受这种新的无人商用飞 行呢(Hughes, Rice, Trafimow, & Clayton, 2009; Molesworth & Koo, 2016; Rice et al., 2014)?这些 都是未来值得研究的问题。

参考文献 略

原文刊在:心理科学进展 2017, Vol. 25, No. 9, 1614–1622

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?