点击下方卡片,关注「3D视觉工坊」公众号

选择星标,干货第一时间送达

来源:夕小瑶科技说

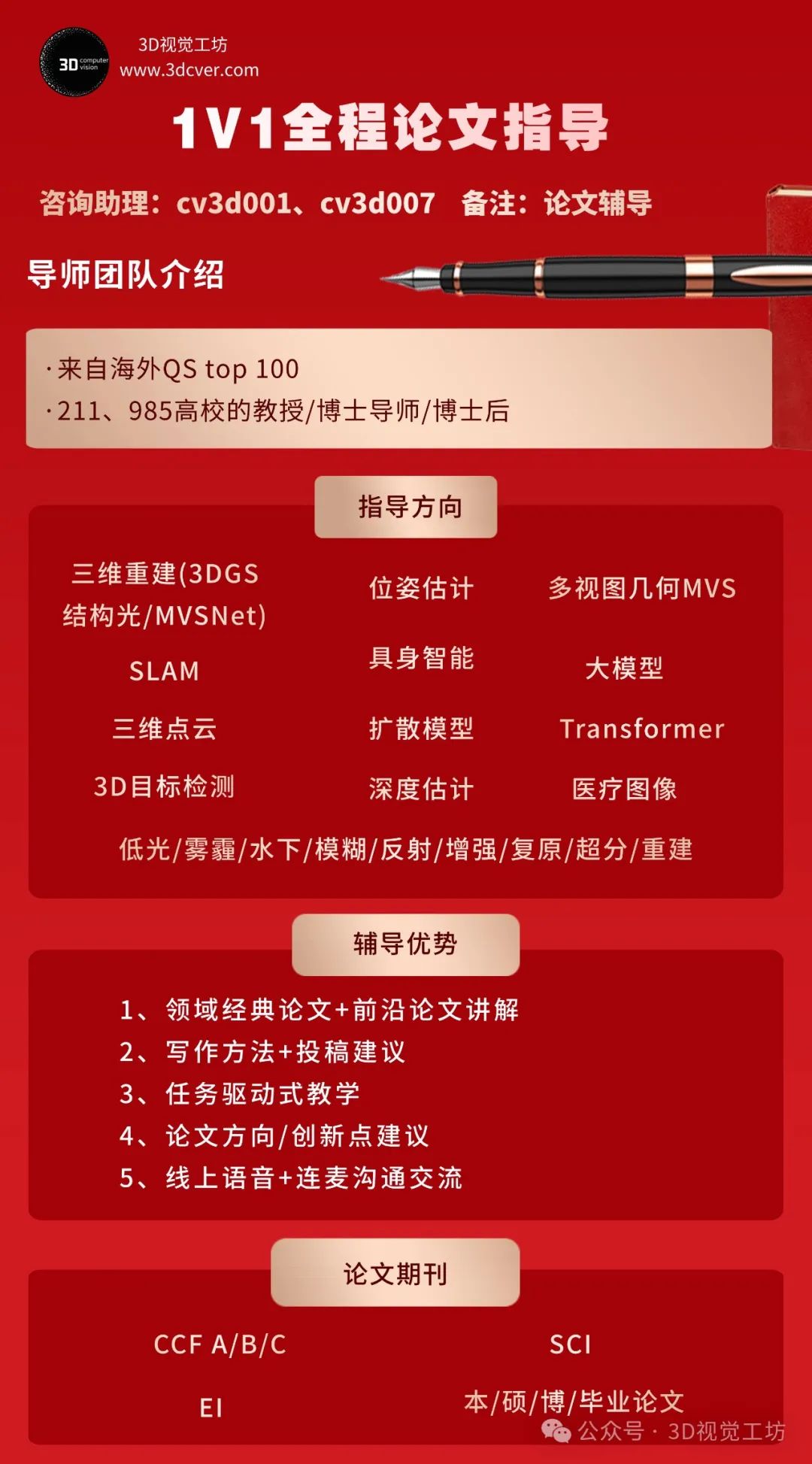

添加小助理:cv3d001,备注:方向+单位+昵称,拉你入群。文末附行业细分群。

扫描下方二维码,加入「3D视觉从入门到精通」知识星球(点开有惊喜),星球内汇总了众多3D视觉实战问题,以及各个模块的学习资料,包括20+门独家视频课程、100+场顶会直播讲解、最新顶会论文分享、计算机视觉书籍、优质3D视觉算法源码、3D视觉入门环境配置教程、求职招聘等。想要入门3D视觉、做项目、搞科研,欢迎扫码加入!

ICLR 是专注于表征学习的人工智能领域顶级会议,由深度学习巨头 Bengio 和 LeCun 牵头举办,与 NeurIPS 、ICML 并称为机器学习三大顶会。

今天,ICLR 大会官方发布了今年的 ICLR 杰出论文奖。

共有3篇论文获奖,另外还有3篇论文获得了荣誉提名。

今年是 ICLR 举办的第 13 届,会议即将在 4.24-4.28 在新加坡举办。

投稿数量:根据 reddit 已有的信息(非官方),本届 ICLR 2025 共收到约 11,500 篇有效投稿(接近但未精确确认,可能为 11,672 篇)。

录用数量:共录用 3,706 篇论文。

录用率:总体录用率为 32.08%(3,706/11,672,基于 Reddit 讨论和 Paper Copilot 数据,最终以官方为准)。

相比 ICLR 2024 的数据《ICLR 2024 杰出论文奖揭晓!两篇国内论文获荣誉提名》:7,262 篇投稿,2,260 篇录用,录用率 31.1%,今年数量明显增加。

下面一起看看今年 3 篇杰出论文 +3 篇荣誉提名的具体论文信息。

公众号后台回复「ICLR2025」可以快速下载论文合集。

3 篇杰出论文

杰出论文 1

论文标题 :

Safety Alignment Should Be Made More Than Just a Few Tokens Deep

(中文直译:安全对齐不应仅限于浅层的少数几个词元)论文链接:

https://openreview.net/pdf?id=6Mxhg9PtDE机构:普林斯顿大学、谷歌 DeepMind

研究领域:人工智能安全 (AI Safety)、大语言模型对齐 (LLM Alignment)

【论文核心贡献 & 创新点】:

该论文发现当前大语言模型(LLMs)的安全对齐方法(如 SFT, RLHF, DPO)存在一个普遍的、根本性的问题,即 “浅层安全对齐 (shallow safety alignment)”。

这意味着安全对齐的效果主要体现在模型输出的最初几个词元(tokens)上,模型学会生成拒绝式的开头(如 "I cannot fulfill..."),但其内部生成有害内容的能力并未被根本改变。

该研究指出,“浅层安全对齐” 这个核心问题可以统一解释近期发现的多种 LLM 安全漏洞,包括:

对抗性后缀攻击 (adversarial suffix attacks)

前缀填充攻击 / 开头引导攻击 (prefilling attacks)

解码参数攻击 (decoding parameter attacks)

微调攻击 (fine-tuning attacks,即使是良性微调也可能破坏安全性)

这些攻击的共同点在于,它们都设法绕过或改变模型最初几个词元的安全“屏障”,一旦绕过,模型就可能“灾难性地”滑向生成有害内容的轨道。

1、提出并验证“深度安全对齐”概念和方法:

作为“浅层”的对立面和解决方案,论文提出了 “深度安全对齐 (deep safety alignment)” 的概念。并通过一种数据增强方法(称为“安全恢复样本”,Safety Recovery Examples)进行初步验证:

即使模型的输出开头偏离了安全轨道(例如,被诱导以有害内容开头),模型也应被训练得能够“恢复”到安全的拒绝式回答。实验表明这种方法能增强模型对某些常见攻击的鲁棒性。

2、提出并验证约束性微调方法:

针对微调攻击,论文提出了一种新的约束性优化损失函数 (constrained optimization loss function)。其核心思想是在微调过程中,重点约束模型在初始词元上的生成概率分布,防止其发生大的偏移,从而在允许模型适应下游任务的同时,最大程度地保留其原有的安全对齐特性。

总结: LLM 安全性是当前 AI 领域最受关注的问题之一,这篇论文精准地指出了当前 LLM 安全对齐研究中的一个关键痛点——“浅层性”,并通过“深度安全对齐”和“约束性微调”两个方向,提出了具体且可操作的改进思路和初步验证。

杰出论文 2

论文标题 :

LEARNING DYNAMICS OF LLM FINETUNING

(中文直译:大型语言模型微调的学习动态)论文链接:

https://openreview.net/pdf?id=tPNHOoZFl9Github 链接:

https://github.com/Joshua-Ren/Learning_dynamics_LLM机构:不列颠哥伦比亚大学

研究领域:大型语言模型 (LLM)、深度学习理论与理解 (Learning Dynamics, Model Interpretability)

【论文核心贡献 & 创新点 】:

提出了一种基于学习动态(Learning Dynamics)的框架,通过分析梯度更新如何影响模型对不同输入的预测(特别是不同响应的可能性),来统一理解不同 LLM 微调算法(如 SFT、DPO 及其变种)的行为。

该框架成功解释了 LLM 微调中的多种已知或新观察到的现象,包括:

特定类型的幻觉(如回答 A 时用了 B 的知识)在 SFT 后可能被放大。

偏好调整(如 DPO)后模型可能出现的“重复”行为(repeater phenomenon)。

离线(Off-policy)DPO 训练过久导致所有响应(包括期望的)概率下降的现象。

论文提到了一个概念——"挤压效应" (Squeezing Effect),明确提出并解释了一个关键机制——在 DPO 等使用负梯度的算法中,对低概率响应施加负梯度会将其概率质量“挤压”到模型先前最自信的那个响应上,这可能是导致意外行为(如重复、性能下降)的原因。

算法改进: 基于对“挤压效应”的理解,提出了一种简单有效的改进对齐性能的方法:在进行 DPO 之前,先在 SFT 阶段同时对正样本 (

y+) _和_负样本 (y-) 进行训练,以减轻后续 DPO 中的挤压效应。新的视角: 提供了一个不同于传统基于目标函数、最终状态或强化学习关联的分析视角,侧重于微调过程中的动态变化和样本间的相互影响。

总结: 这篇论文巧妙地运用学习动态理论深入剖析了 LLM 微调的核心过程。其提出的统一框架和“挤压效应”解释为理解和改进 LLM 对齐提供了重要的理论基础和实践指导。

杰出论文 3

论文标题:

AlphaEdit: Null-Space Constrained Model Editing for Language Models

(中文直译:AlphaEdit: 面向语言模型的零空间约束知识编辑)论文链接:

https://openreview.net/pdf?id=HvSytvg3JhGitHub 链接:

https://github.com/jianghoucheng/AlphaEdit机构:新加坡国立大学、中国科学技术大学

研究领域:LLM 模型编辑 / 知识编辑

论文指出现有的"定位-编辑" (locate-then-edit) 范式在更新 LLM 知识时,引入的扰动会不可避免地破坏模型中原有的、需要保留的知识,尤其在连续编辑场景下问题更严重,导致遗忘和模型崩溃。现有方法难以平衡“知识更新”和“知识保留”这两个目标。

【论文核心贡献 & 创新点】:

提出 AlphaEdit 方法: 提出一种新的知识编辑目标优化方法。它不再试图在目标函数中平衡“更新误差”和“保留误差”,而是专注于最小化“更新误差”。

核心创新 - 零空间投影约束: 为了在仅优化更新目标的同时保护原有知识,AlphaEdit 在将计算出的参数扰动(perturbation)应用到模型之前,先将其投影到“被保留知识”对应 Key 矩阵的零空间 (null space)。

理论保证: 从理论上证明,这种零空间投影确保了编辑后的 LLM 在被问及需要保留的知识时,其输出(特别是关键的隐藏层表示)保持不变,从而有效缓解了知识破坏问题。

简单高效: 该方法的核心(零空间投影)只需要增加一行代码即可集成到现有的主流"定位-编辑"方法(如 MEMIT)中,实现了显著的性能提升(平均提升 36.7%),具有即插即用的特性。

总结:AlphaEdit 论文针对当前 LLM 知识编辑领域的一个关键痛点——更新知识与保留原有知识之间的冲突和破坏——提出了一个创新且简洁的解决方案。其核心亮点在于巧妙地运用了线性代数中的“零空间投影”概念,将参数更新约束在不影响原有知识表示的空间内进行。这不仅在理论上保证了对保留知识的“零干扰”,还简化了优化目标,避免了复杂的权重调整。

3 篇论文获荣誉提名

荣誉提名论文 1

论文标题 :

DATA SHAPLEY IN ONE TRAINING RUN

(中文直译:一次训练运行中的数据 Shapley)论文链接:

https://openreview.net/pdf?id=HD6bWcj87Y机构:普林斯顿大学、加州大学伯克利分校、弗吉尼亚理工学院

研究领域:大规模模型数据归因、数据质量评估

【论文核心贡献&创新点】:

提出 In-Run Data Shapley 概念: 针对传统 Data Shapley 需要大量模型重训练导致计算不可行以及无法评估特定单次训练运行中数据贡献的问题,提出了 In-Run Data Shapley。它旨在评估数据点对 某一次特定 模型训练运行的贡献,而非对通用学习算法的平均贡献。

消除重训练需求: 通过将整个训练过程分解为单次迭代,计算每次迭代中数据子集对模型性能(如验证损失)变化的贡献(局部效用),并累加这些贡献来获得最终的数据 Shapley 值。

"Ghost" 计算技术: 开发了一系列高效计算技术("ghost dot-product" 和 "ghost gradient-Hessian-gradient product"),可以在一次或两次反向传播中精确计算所需的梯度点积和梯度-Hessian-梯度乘积,而无需显式实例化或存储单个样本的梯度/Hessian 向量,极大降低了计算开销。

极高的计算效率: 最优实现(一阶,使用 "ghost" 技术)相比标准模型训练只增加可忽略不计的运行时间开销,使得对大模型(如基础模型预训练)进行数据归因成为可能。

总结:该论文针对数据归因领域的核心痛点——传统 Data Shapley 的计算瓶颈和模型特定性缺失——提出了一个创新且非常实用的解决方案 "In-Run Data Shapley"。其核心思想(分解训练过程 + 迭代归因)和关键技术("Ghost" 计算)极大地提升了效率,使得在大规模模型上应用 Shapley 值这一理论上公平的归因方法成为现实。

荣誉提名论文 2

论文标题:

SAM 2: Segment Anything in Images and Videos论文链接:

https://openreview.net/pdf?id=Ha6RTeWMd0机构:Meta AI、斯坦福大学

研究领域:Video Segmentation (视频分割)

【论文核心贡献 & 创新点】:

扩展 SAM 至视频域 (Extension of SAM to Video): 将 Segment Anything 模型的能力从静态图像扩展到了视频,提出了一个统一处理图像和视频分割的模型 (SAM 2)。

引入流式记忆机制 (Streaming Memory Mechanism): 模型架构的关键创新,通过记忆存储(Memory Bank)和注意力机制(Memory Attention)来处理视频帧,有效利用历史帧信息进行目标跟踪和分割修正,实现实时处理。

提出 PVS 任务 (Promptable Visual Segmentation Task): 定义了可提示的视频视觉分割任务,允许用户在视频的任意帧通过点、框、掩码等提示进行交互式分割和修正。

构建数据引擎 (Data Engine): 开发了一个“模型在环”(model-in-the-loop) 的数据标注引擎,利用 SAM 2 辅助标注员,大幅提升了视频分割数据的标注效率和规模。

发布大规模 SA-V 数据集 (Large-Scale SA-V Dataset): 通过数据引擎收集并发布了迄今为止最大的视频分割数据集 (Segment Anything Video ,SAV),包含大量掩码(masklets),覆盖多样场景和物体。

显著性能提升 (Significant Performance Improvement): 在视频分割任务上,以更少的交互次数达到更高精度;在图像分割任务上,比原版 SAM 精度更高且速度快 6 倍;在多个基准测试上取得 SOTA 或强劲性能。

总结:SAM 2 是对开创性的 SAM 模型一次非常成功的演进,作为一个统一图像和视频分割的基础模型,并且伴随全面的开源,SAM 2 有望像 SAM 一样,对下游的视频理解、编辑、AR/VR 等应用产生深远影响。

荣誉提名论文 3

论文标题 :

Faster Cascades via Speculative Decoding

(中文直译:通过推测解码实现更快的级联)论文链接:

https://openreview.net/pdf?id=vo9t20wsmd机构 :Google Research、Google DeepMind、Mistral AI

研究领域:LLM Inference Acceleration (大模型推理加速)

【论文核心贡献&创新点】:

这篇论文巧妙地结合了两种流行的 LLM 推理优化技术,提供了一种新的、可能更优的平衡点来协调推理速度、计算成本和模型性能。

提出 "推测级联 (Speculative Cascading)" 框架: 这是一种新的推理加速策略,旨在整合模型级联 (Model Cascading) 的成本效益和推测解码 (Speculative Decoding) 的速度优势。

核心机制创新: 关键在于利用推测解码的并行验证 (parallel verification) 机制来 执行模型级联中的延迟决策 (deferral rule)。即,大模型并行评分小模型的草稿,其目的不仅是验证 Token,更是为了 _决定是否触发级联的延迟(调用大模型)_。

解锁更优的成本-质量边界: 通过这种新机制,推测级联能够在推理效率上实现更优的成本-质量权衡 (cost-quality trade-off)。

总结:这篇论文巧妙地结合了两种流行的 LLM 推理优化技术,抓住了它们各自的优势——级联的成本效益权衡和推测解码的速度与质量保证。其核心思想是将级联的决策过程融入推测解码的并行框架中,这是一个有前景的方向。

本文仅做学术分享,如有侵权,请联系删文。

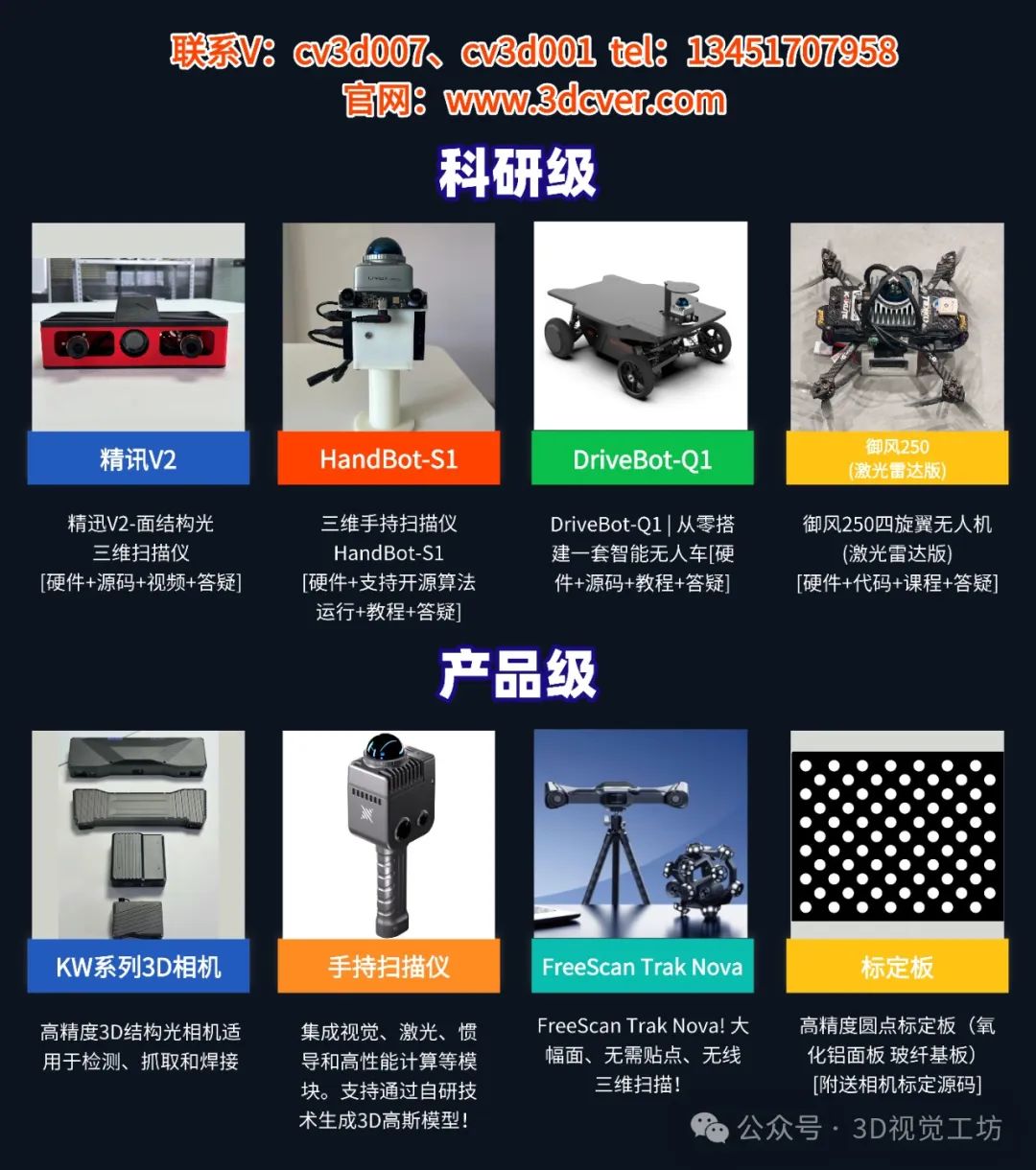

3D硬件专区

「3D视觉从入门到精通」知识星球

扫描下方二维码,加入「3D视觉从入门到精通」知识星球(点开有惊喜),已沉淀7年,星球内资料包括:3D视觉系列视频近20+门、100+场直播顶会讲解、项目对接、3D视觉学习路线总结、最新顶会论文&代码、3D视觉行业最新模组、3D视觉优质源码汇总、书籍推荐、编程基础&学习工具、实战项目&作业、求职招聘&面经&面试题等。欢迎加入3D视觉从入门到精通知识星球,一起学习进步!

3D视觉全栈学习课程:www.3dcver.com

3D视觉交流群

点这里👇关注我,记得标星哦~

一键三连「分享」、「点赞」和「在看」

3D视觉科技前沿进展日日相见 ~

1626

1626

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?