特征值2021年4月22日10点39分

Hessian矩阵用于判别平行于floor的切平面是鞍面、极小值还是极大值面,当特征值eigenvalue都大于0时,g(x)=0的切平面x是极小值面,而多元函数的Hessian矩阵是实对称矩阵,symmetric matrix,Hessian矩阵如果是正定的,definite,那么x就是极小值面,如果是半正定,semi definite,也就是特征值可能有0,那么还需要求助于三阶导数。

- 上面这段话涉及特征值,正定的含义。特征值我记得不太好算,而正定的定义相对简单,https://zhuanlan.zhihu.com/p/44860862这篇文章介绍得比较清楚,对于任意非0列向量 x x x,只要 x T A x > 0 x^TAx>0 xTAx>0,那么 A A A就是正定的,含义和函数 a x 2 ax^2 ax2一致,只要 x ! = 0 x!=0 x!=0,那么函数 a x 2 > 0 ax^2>0 ax2>0,这篇文章还证明了协方差矩阵是半正定的,结合这篇文章https://blog.csdn.net/qcyfred/article/details/71598815的证明,发现可以将 x T Σ x > 0 x^T\Sigma x>0 xTΣx>0视作 σ 2 > 0 \sigma^2>0 σ2>0,只不过这里的 σ \sigma σ是随机变量, ∑ i = 1 n ( X k − μ k ) y k \sum_{i=1}^n(X_k-\mu_k )y_k ∑i=1n(Xk−μk)yk。

- 为了查询特征值的含义,翻了翻Algebra done right。

2.1 居然从复数空间、集合和列表啥的讲起。

linear algebra done right里提到的一个span概念以前从来没见过,粗略看去就是对一个向量列表(list而不是set)里的向量进行的线性组合,span的意思是跨距,查了下,翻译是“张成”。这个span引出了好几个定义。向量空间V里的向量组成的列表(v1,v2,v3…,vm),这个列表里的向量的span,span(v1,v2,…,vm),是V的最小子空间,或者说这些向量张成了空间V。这本书开始还从符号表示如小、花括号,箭头,的角度入手引出了向量空间这个概念。span还可以引出多项式空间Pm(F),这个概念当时学有限域时觉得很模糊,这里讲得也不太清楚,把函数自变量z换成域F,函数p换成大写P,P(F)就是集合,函数的集合,但和F以及F^F的关系,就不太清楚了。线性独立性中文表述为“表达式”是唯一的,

这里wheter the choice of scalars is unique…线性依赖性的相关性质用span来证明比较方便。

线性独立的向量个数小于张成空间的向量的个数,证明过程是不断插入移除向量来完成的,但还是有点儿模糊,从这点上看,不觉得这本书有那么好。

2.2 2021年4月26日 这两天在看线性代数及其应用,这本书以前看过怎么正交化的部分,前面没怎么看过,这次借着查特征值的机会重新看了下,途中有矩阵分解的内容讲得不太清楚,今天翻了下数值分析的解方程组。定理和具体的迭代式没有用笔写,只是看看,总体来说,记住高斯消元法和对称矩阵的平方根法的 L L T LL^T LLT就应该差不多了,高斯消元法记住 O ( n 3 ) O(n^3) O(n3)的复杂度(看下标从哪到哪),和平方根法的动态运算过程,但pdf上没有笔记,书放宿舍了,待会儿吃完饭温习下,再记录下矩阵分解几个要点,就算完事儿了,再查下matlab或者python不知道有没有相关的函数 。另外,线性代数这儿回顾后,可以直接看下张贤达的矩阵分析,矩阵微分一直没怎么搞懂,后面也可以衔接上最优化。直觉上觉得对EM算法混淆损 。

三角分解2021年4月27日10点53分

L L L为下三角单位矩阵, U U U是上三角矩阵,维度和原矩阵都是 n × n n\times n n×n,用 r r r表示行标,用 k k k表示列标, L L L的列标大于行标 r < k r<k r<k时 l i k = 0 l_{ik}=0 lik=0,当对列标进行叠加时 ∑ k = 1 n l i k \sum _{k=1}^{n}l_{ik} ∑k=1nlik时, ∑ k = 1 n l i k = ∑ k = 1 r − 1 l i k + l i r \sum_{k=1}^nl_{ik}=\sum_{k=1}^{r-1}l_{ik}+l_{ir} ∑k=1nlik=∑k=1r−1lik+lir,这里不要认为 l i r = 1 l_{ir}=1 lir=1,因为这里的 i i i指的是对角线元素所在列下面的元素, i > r i>r i>r,之所以只关注对角线元素所在列下面的元素是因为前面一列已经求好了。而 U U U对应的 u k i u_{ki} uki当 k < r k<r k<r时 u k r = 0 u_{kr}=0 ukr=0。三角分解第一行不变,第一列除以第一列的主元即可,然后先求出包括对角线元素的行元素,行元素是用当前值减去所在行列的对应元素乘积和,如 a 53 n e w = a 53 o l d − a 51 a 15 − a 52 a 25 a_{53}^{new}=a_{53}^{old}-a_{51}a_{15}-a_{52}a_{25} a53new=a53old−a51a15−a52a25, a 35 a_{35} a35和 a 45 a_{45} a45没有对应的行元素。再求对角线下的列元素,列元素的操作比行元素多了个除以已经求出来的对角线上的元素。如果是列主元选取,选出列最大值即可。动态过程就是这样从左上角往右下角划分行列《李庆扬》p153

平方根法11点12分

Cholesky分解矩阵为两个互为转置的三角矩阵,ij位置本来是第一个矩阵的第i行乘以第二个矩阵的第j列,但第j列就是第一个矩阵的第j行,本来是 l i k l k j l_{ik}l_{kj} liklkj变成了 l i k l j k l_{ik}l_{jk} likljk当列遍历下标 k k k大于行标时 l i k = l j k = 0 l_{ik}=l_{jk}=0 lik=ljk=0,所以 a i j = ∑ k = 1 n l i k l j k = ∑ k = 1 j l i k l j k 或 者 ∑ k = 1 i l i k l j k a_{ij}=\sum_{k=1}^nl_{ik}l_{jk}=\sum_{k=1}^jl_{ik}l_{jk}或者\sum_{k=1}^il_{ik}l_{jk} aij=∑k=1nlikljk=∑k=1jlikljk或者∑k=1ilikljk,对角线和下面的元素,都需要把 k = j k=j k=j或者 i = k i=k i=k分离出来, a i j = ∑ k = 1 j − 1 l i k l j k + l j j l i j a_{ij}=\sum_{k=1}^{j-1}l_{ik}l_{jk}+l_{jj}l_{ij} aij=∑k=1j−1likljk+ljjlij,

平方根法动态过程:先对第一列主元开平方,然后第一列下面的元素除以主元得到第一列,对角线上的元素等于对角线上的元素减去对应行的元素平方的差再开根号,列不需要了。对角线下面的元素减去对应行列或者对应的两个行的元素乘积再除以已经求出来的对角线上的主元。

除了第一列,对角线下的元素的求法和三角分解一样,都要除以已经求出来的主元。对角主元需要开平方,而三角分解不需要(三角分解下三角是单位下三角,而平方根法是转置的),而且平方根法不要求行只求列即可。

2.3 2021年5月1日20点28分附上笔记

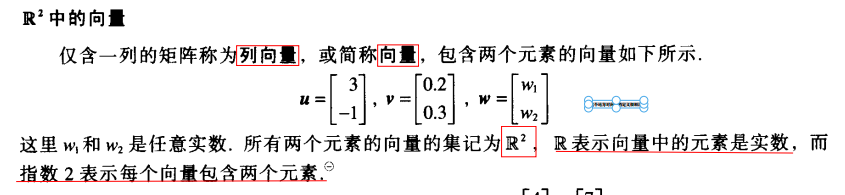

1 这个地方对向量的定义很顺滑

2 主元个数小于列向量个数

3 平面的表示 隐式和显式

4 应该习惯向量方程,而不是矩阵方程

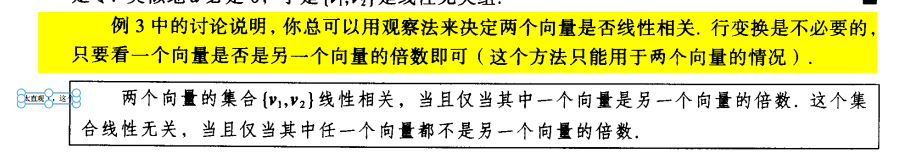

5 肉眼观察是否线性相关

6 方程解和线性相关等问题:有非平凡解则向量方程形式的权必不全为零

7 线性变换属于函数映射

8 矩阵的m行n列可以从函数的定义域值域来看待;列数等于行数可以从向量方程的权和项要对应的角度来看待

9 A只有前两行或者前两列有主元,m<n,映射后的值域是R^2;第三个维度是零向量

10 r^2 到R^3的变换,系数有2个,原象也就是解是2维的,矩阵列数也就是自变量个数,或者次数,是2.

11 原象可以写成单位矩阵的的列向量和各维度的乘积72

12 In和A m×n;变换T能作用域单位向量,原因是原象能写成单位向量与各维度的乘积和,再由于变换的线性,将原象各维度作为系数提取了出来。

13 这里的x可以有任意维度,假设为n,可以看出映射后m=n,In,对第一个维度,也就是第一个单位列向量,标准矩阵应该使得单位列向量第一个值变成三倍,结果也就是变换矩阵的第一列,第一个列向量。

14 满射,则方程组至少有一个解,方程组的个数可能小于变量个数,各列向量线性相关。

15 哪怕理解了含义,还是会忘,

这里盲猜“射”是射箭,单射就是原象m维向量空间的点,射到值域n维向量空间,

单射:强调值域中的元素(不是所有的元素,有些元素跟原象空间没关系)是原象空间里一个个射过来的,不存在两个人同时射中一个值域点。线性变换或者解方程时体现的是解的唯一性。(跟原象空间没关系的是特解?)

满射:强调值域中任意一个元素都是原象里射过来的,可能是几个人同时射中了一个点,也可能只是一个人射中一个点,但都是原象空间里射过来的(“满”取“原象空间的映射变换充满了值域”之意?),线性变换或者解方程时体现的是解的存在性,有没有解。

16 只有一个解或者没有解,列向量线性无关,主元个数等于列向量个数,方程组个数等于系数变量个数…77

17分块的意义是处理稀疏矩阵94

18 可逆和解的唯一性等价的原因是两边能同时乘以矩阵的逆消掉变换矩阵104

19可逆性和等价于解的唯一性,解的唯一性相当于列向量的线性无关,线性无关的列向量的元素个数也就是矩阵行数,每一行都有主元,

总的来概括就是单位矩阵。

20 双射,可逆线性变换114

21 D多项式集合以及函数都是向量空间

22 二维空间不是三维空间的子空间

23 列空间就是等号右边的向量所属的空间,零空间就是解集所属的空间,像是从零空间通过变换A映射到列空间。

24 微分方程也是线性变换,满足线性和可加性

25有些向量不能写成方程组的形式,也就不能用有无解来研究是否线性无关了

26 向量空间的基的定义也得从子空间来

27 函数向量空间超出平常的有大小有方向就是向量空间的日常概念

28 生成集中也含有冗余,只有线性无关才是基

29 这几页讨论怎么在一个矩阵中找出线性无关的列向量,生成等号右端的向量的空间

。

30 行变换只是为了探寻原来矩阵各列的关系,但变换后的各向量生成不了原向量空间

31 向量的坐标原来是基向量的权值

32同构是指经过线性变换的不同空间的向量

33 主元列可以线性组合为非主元列向量,从而组成等号右端也就是列空间的有效成分只有主元列向量,非主元列向量的个数等于自由向量的个数,目前的观察来看

,

主元列向量的个数等于矩阵行数,零空间的维度等于自由变量的个数,是指自由变量个数个向量的线性组合决定了所有的零空间的向量,零空间的向量就是

解向量,解向量被自由向量集合线性组合而成;等号右边的列向量由矩阵中的线性无关列向量线性组合而成。

34 这个矩阵只需要两个列向量就能生成,所以列空间的基是第1列和第3列向量,而解向量由3个自由向量乘以各自自由

解然后加起来构成,所以零空间解空间的维数是3.

35 行化简在计算中不可行,计算秩和各个空间

36 b1=4c1+c2表示在C坐标系中B坐标系的基向量之一b1的坐标为(4,1)

37 坐标向量就是相应的基向量的权值

38 基的变换矩阵的各列向量是线性无关。这是基向量的坐标向量的性质决定的。

39 特征向量是非零向量,方程组的解有非平凡解!

40 有自由变量表示方程组有非平凡解,而特征向量的定义就是这样的方程组的非零解向量。

41 这段话解释了为啥要变换矩阵为行阶梯形,行阶梯形的对角线上要有0,

才能让方程组有自由变量,有自由变量就有非平凡解,特征向量就是非平凡解,

但可虑的是对角线上的元素都等于0和矩阵A所有的特征值是完全对应的吗?

42 不可逆和0特征值在不同地方有不同应用,但可以转化…;特征向量是线性无关的…

43 求特征值和特征向量的,看方阵A能把特征向量伸缩多少倍…

44 列向量线性无关和行列式不等于0的联系是列向量构成的体积不等于0,线性

无关也就是可逆,而可逆以及特征值属于线性变换,映射,不太好和直观的

三维图形联系起来…·

45 特征值相同,特征向量应该也相同,这有啥意义?能把这个向量线性变换到相同方向的相同位置两IC

?

46 我觉得对特征值的记忆还是应该首先想到线性变换到相同的空间上去…;特相似矩阵具有相同的特征多项式…?j就是说有些变换对一些向量的作用是相似的…

47 z张成和生成就是子空间与子空间基的区别

48 正交和线性无关不要混淆了

49 投影值,也就是权值,

50 投影点还有距离原来向量最近的性质

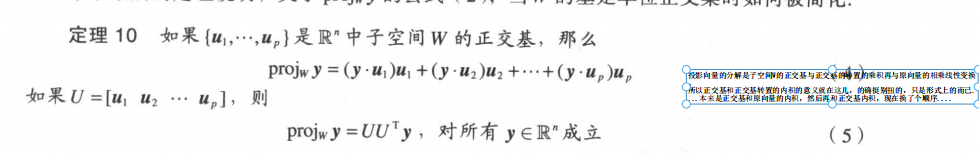

51 投影向量的分解是子空间W的正交基与正交基的转置的乘积再与原向量的相乘线性变换。

所以正交基和正交基转置的内积的意义就在这儿,的确挺别扭的,只是形式上的而已…本来是正交基和原向量的内积,然后再和正交基内积,现在换了个顺序…

52 维度是指向量个数,不是向量元素个数

53 这个“减”从空间几何上和“去掉”,‘减去’的减法意义上都可以理解正交合成方面的正交化意义

54 QR分解,Q是单位正交基,R是上三角可逆矩阵…;我觉得QR分解效果跟特征矩阵和特征值的分解效果差不多,不过QR分解要求矩阵A的列向量线性无关。

55 这属于找到非零的零空间问题;为了找出x,所以认为是零空间;但仔细想想,是矩阵A的列向量的线性合成来逼近b,所以处理对象应该是矩阵A各列构成的列空间和b这两个对象。;正交投影还要考虑原向量减去投影向量这个问题… ;正交于一个子空间,那么正交于张成这个子空间的列向量,也就是矩阵A的ge列。

56 Ax^是由A确立的子空间中最接近b的向量,这个向量是b在空间A中的投影向量。

57 这个定理不太好直观理解记忆,注释一下:首先,Ax`是原向量在A列向量张成的子空间W中的投影向量,投影向量和原向量的关系可以用投影向量所在的子空间的正交基和其转置的乘积来线性映射得到,形式就是正交基与正交基的转置形成的矩阵与原向量相乘。从后往前看就明白为什么近似解x’要取R的逆和Q的转置乘积的形式了…;这里再特别注明:子空间的单位正交基和正交基的转置的乘积不等于单位矩阵,因为左矩阵是先用行去乘;但单位正交基的转置和单位正交基的乘积就是单位矩阵!!!

58 正交对角化…我觉得也不必看正交的内容了,知道正交对角化就可以了,后面应该有介绍正交对角化

在PCA中的practice;这个定理看起来很大胆,只要对称,那么就能

正交对角化,特征向量组成的矩阵是列正交的

,用来对角化线性变换矩阵为特征值组成的对

角阵。;对角化的矩阵不一定就是特征向量组成,可以是特征向量的特征空间

的子空间的正交基…

59 谱分解我觉得意义在于把向量投影到特征空间的每个子空间上

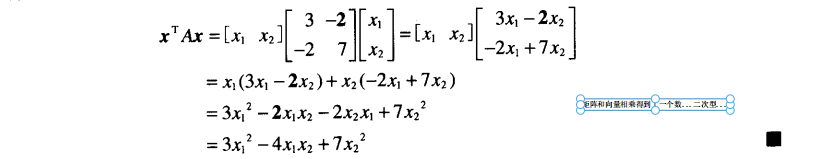

60 矩阵和向量相乘得到了一个数…二次型…

61 我觉得消掉交叉项也是为了便于计算…

为了消掉交叉项,把这个二次型的数对应的对称矩阵分解为正交阵和对

角阵的乘积,正交阵乘以变量x,我觉得就是利用一种“投影”的方法消

掉了交叉项。;主轴就是正交列向量的方向

62 正态分布的方差就是半正定的

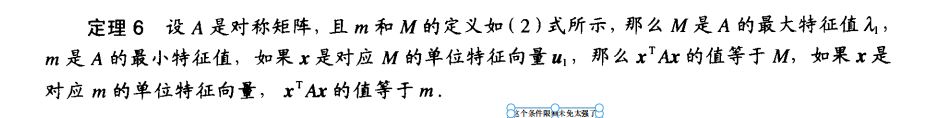

63 这个条件限制未免太强了

64 这几个定理应该讲的是当把x向量映射到几个正交特征向量确

立的子空间上,如果x跟其中几个向量正交,那么函数值只在

非正交的方向上取得最大值和最小值。

65 这章的内容有一部分涉及第6章的正交化部分,这里总结下正交化部分的内容:相减,长度…正交基和转置正交基乘积的矩阵对原向量进行线性变换到子空间W中的投影向量…除此外没了。

这章的内容是昨天看的,我觉得也可以简单总结下:就是正交投影分解…不产生交叉项。奇异值分解是分解到两个子空间…待会儿回来再简单浏览下…2021年5月1日17点46分

66 奇异值分解就是正交对角化矩阵的另外一种形式,正交对角化要求是方阵,列向量构成一个子空间,而

m×n的矩阵分解由两个子空间合成。

这里奇异值应用于求解秩,本来正交对角化的实对称矩阵秩就是列向量张成的子空间的维数,但奇异值分解对象A,

由两个子空间合成,秩如果采取行化简的形式,值可能在m和n之间变化(舍入误差等来带的),为了精确秩,奇异值

分解不会带来较大误差,但为啥这个就不用深究了。

再补充一下,特征值,正交对角化以及奇异值分解,我觉得都可以从线性变换和投影来理解,不用记住定理。

最后,奇异值分解求的秩,应该等于两个子空间中较小的维数。

67 融会贯通的应该就是这个例子…但不太好懂…

68 A能够分解成特征向量矩阵和对角矩阵的乘积形式:S=PDP-1。。。。这章的内容就是这个等式一个简单变形…;依然是正交投影的内容…;特征向量和原向量的结合形式是内积,这是正交投影这样的线性变换的体现形式…特征向量的各元素值作为原向量各元素或者各变量的权值…

69 原来主成分就是特征向量和原向量的内积…

4138

4138

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?