以前看最大熵模型感觉是懵懵懂懂,最近看完条件随机场(CRF)之后,再来看最大熵模型,发现两者关联很大,再结合逻辑斯蒂回归,理解起来就比较容易,这里是整理笔记。

最大熵模型由最大熵原理推导实现

1.最大熵原理

最大熵原理认为,学习概率模型时,在所有可能的概率模型(分布)中,熵最大的模型是最好的模型。通常用约束条件来确定概率模型的集合,所以,最大熵原理也可以表述为在满足约束条件的模型集合中选取熵最大的模型。

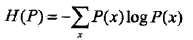

假设离散随机变量X的概率分布式P(X),则其熵是:

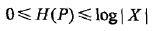

熵满足下列不等式:

式中,|X|是X的取值个数,当且仅当X的分布是均匀分布时右边的等号成立。这就是说,当X服从均匀分布时,熵最大。

下面通过一个例子来介绍一下最大熵原理:

问题:假设随机变量X有5个取值{A,B,C,D,E},要估计取各个值的概率P(A),P(B),P(C),P(D),P(E)。

解:这些概率值满足以下约束条件:

满足这个约束条件的概率分布有无穷多个。如果没有任务其他信息,仍要对概率分布进行估计,一个办法就是认为这个分布中各个值是相等的:

有时,能从一些先验知识中得到一些对概率值的约束条件,例如

满足上面两个约束条件的概率分布仍然有无穷多个。在缺少其他信息的情况下,可认为A和B是等概率的,C,D与E是等概率的,于是

2.最大熵模型的定义

最大熵原理是统计学习的一般原理,将它应用到分类得到最大熵模型。

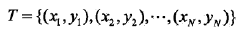

(1)给定一个训练数据集

学习的目标是用最大熵原理选择最好的分类模型

(2)给定训练数据集,可以确定联合分布P(X,Y)的经验分布和边缘分布P(X)的经验分布。

其中,v(X=x,Y=y)表示训练数据中样本(x,y)出现的频次,v(X=x)表示训练数据中输入x出现的频数,N表示训练样本容量。

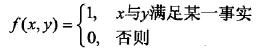

(3)用特征函数f(x,y)描述输入x和输出y之间的某一个事实。其定义是

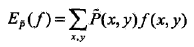

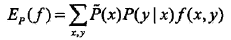

特征函数f(x,y)关于经验分布

特征函数f(x,y)关于模型P(Y|X)与经验分布

如果有n个特征函数,那么就有n个约束条件。

定义:最大熵模型

假设满足所有约束条件的模型集合为:

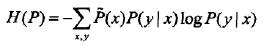

定义在条件概率分布P(Y|X)上的条件熵为:

则模型集合C中条件熵H(P)最大的模型称为最大熵模型。式中的对数为自然对数。

3.最大熵模型的学习

最大熵模型的学习过程就是求解最大熵模型的过程。最大熵模型的学习可以形式化为约束最优化问题。

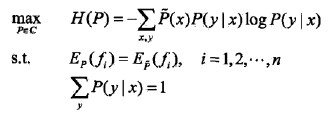

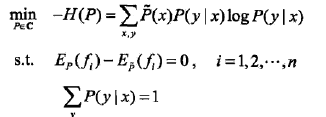

对于给定的训练数据集

按照最优化问题的习惯,将求最大值问题改写成等价的求最小值问题:

将约束最优化的原始问题转换为无约束最优化的对偶问题,通过求解对偶问题求解原始问题

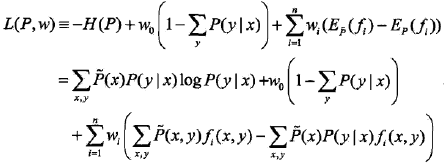

(1)首先,引进拉格朗日乘子,定义拉格朗日函数L(P,w):

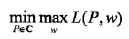

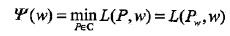

最优化的原始问题是:

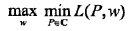

对偶问题是:

由于拉格朗日函数L(P,w)是P的凸函数,原始问题的解与对偶问题的解释等价的。

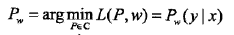

(2)然后求解对偶问题内部的极小化问题

同时,将其解记作:

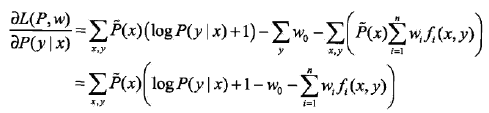

求偏导数:

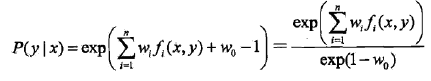

令偏导数等于0,在

由于

其中,

(3)之后,求解对偶问题外部的极大化问题

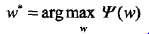

得到其解

此时,就可以利用梯度下降、拟牛顿等最优化方法进行学习了,类似于逻辑斯蒂回归求解参数w。

4.极大似然估计

证明对偶函数的极大化等价于最大熵模型的极大似然估计

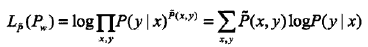

(1)已知训练数据的经验概率分布

当条件概率分布P(y|x)是最大熵模型时,对数似然函数为

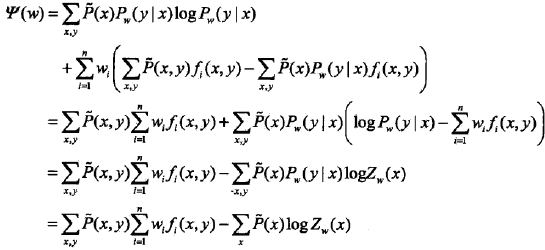

(2)对偶函数

最后一步用到

(3)最终可得

5.模型学习的最优化算法

最大熵模型学习归结为以似然函数为目标函数的最优化问题,通常通过迭代算法求解。从最优化的观点看,这时的目标函数具有很好的性质。它是光滑的凸函数,因此多种优化方法都适用,保证能找到全局最优解。

下面以拟牛顿法为例

对于最大熵模型而言,

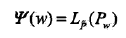

目标函数:

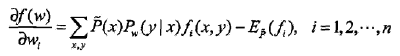

梯度:

其中

相应的拟牛顿法BFGS算法如下

参考文献

(1)《统计学习方法》

729

729

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?