第1关:VGG

任务描述

通过本关卡,你将掌握VGG的网络结构,并使用pytorch进行网络结构搭建。

相关知识

VGG是在2014年由牛津大学计算机视觉组(Visual Geometry Group)和Google DeepMind公司一起研发出了新的深度卷积神经网络,该网络取得了ILSVRC2014比赛分类项目的第二名,VGG可以看成是加深版的AlexNet,整个网络由卷积层和全连接层叠加而成,和AlexNet不同,也正是VGG的贡献在于:VGG是使用很小的卷积核(3×3)构建各种深度的卷积神经网络结构,并对这些网络结构进行了评估,在最终的结果上16-19层的网络深度,能够取得较好的识别精度。 这也就是常用来提取图像特征的VGG-16和VGG-19。

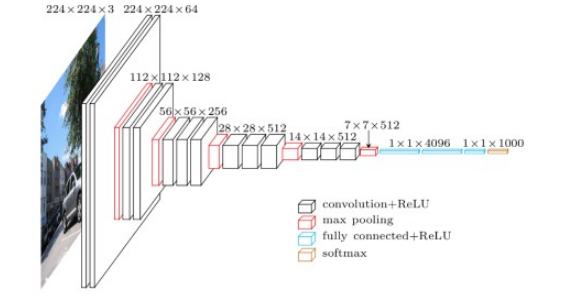

VGG的网络结构

VGG整个结构只有3×3的卷积层,连续的卷积层后使用池化层隔开。虽然层数很多,但是很简洁。网络流程如下:

图 2-1-1 VGG网络结构 整个结构具有如下的特点:

- 使用连续的的多个小卷积核(3×3),来代替一个大的卷积核(例如(5×5),从而减少参数

- 通道数更多,特征度更宽,每个通道代表着一个FeatureMap,更多的通道数能表示更丰富的图像特征

- 在网络测试阶段将训练阶段的三个全连接替换为三个卷积,使得测试得到的全卷积网络因为没有全连接的限制,因而可以接收任意宽或高为的输入

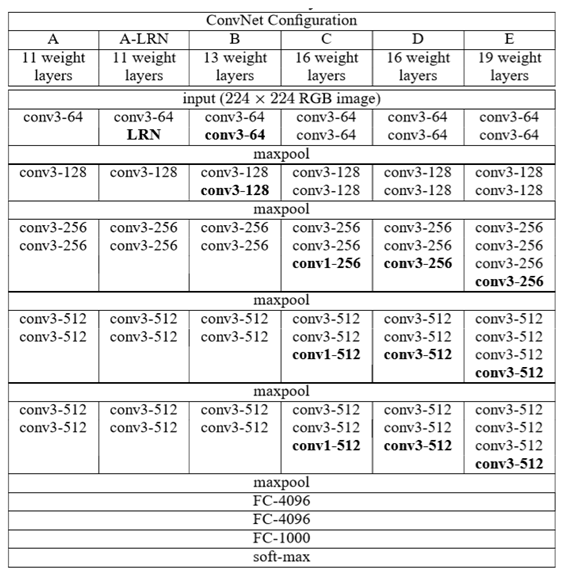

VGG网络的具体参数设置如下图所示:

图2-1-2 VGG网络结构 它具有如下的特点:

- VGG的输入为224×224×3的图像。

- 网络使用连续的小卷积核(3×3)做连续卷积,卷积的固定步长为1,并在图像的边缘填充1个像素,这样卷积后保持图像的分辨率不变。

- 连续的卷积层会接着一个池化层,降低图像的分辨率。空间池化由五个最大池化层进行,这些层在一些卷积层之后(不是所有的卷积层之后都是最大池化)。在2×2像素窗口上进行最大池化,步长为2。

- 卷积层后,接着的是3个全连接层,前两个每个都有4096个通道,第三是输出层输出1000个分类。

- 所有的隐藏层的激活函数都使用的是ReLU

- 使用1×1的卷积核,为了添加非线性激活函数的个数,而且不影响卷积层的感受野。

Pytorch搭建VGG

编程要求

根据提示,在右侧编辑器补充代码,完成网络的搭建。

测试说明

平台会对你编写的代码进行测试:

开始你的任务吧,祝你成功!

任务代码如下:

import torch as torch

import torch.nn as nn

class VGG16(nn.Module):

def __init__(self,num_classes=1000):

super(VGG16,self).__init__()

self.features = nn.Sequential(

########## Begin ##########

nn.Conv2d(3, 64, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1)),

nn.ReLU(inplace=True),

nn.Conv2d(64,64,kernel_size=3,padding=1),

nn.ReLU(inplace=True),

nn.Conv2d(64,128,kernel_size=3,padding=1),

nn.ReLU(inplace=True),

nn.Conv2d(128, 128, kernel_size=3, padding=1),

nn.ReLU(inplace=True),

nn.Conv2d(128, 256, kernel_size=3, padding=1),

nn.ReLU(inplace=True),

nn.Conv2d(256, 256, kernel_size=3, padding=1),

nn.ReLU(inplace=True),

nn.Conv2d(256, 256, kernel_size=3, padding=1),

nn.ReLU(inplace=True),

nn.Conv2d(256, 512, kernel_size=3, padding=1),

nn.ReLU(inplace=True),

nn.Conv2d(512, 512, kernel_size=3, padding=1),

nn.ReLU(inplace=True),

nn.Conv2d(512, 512, kernel_size=3, padding=1),

nn.ReLU(inplace=True),

nn.Conv2d(512, 512, kernel_size=3, padding=1),

nn.ReLU(inplace=True),

nn.Conv2d(512, 512, kernel_size=3, padding=1),

nn.ReLU(inplace=True),

nn.Conv2d(512, 512, kernel_size=3, padding=1),

nn.ReLU(inplace=True)

########## End ##########

)

self.classifier = nn.Sequential(

########## Begin ##########

nn.Linear(512*7*7,4096),

nn.ReLU(inplace=True),

nn.Dropout(),

nn.Linear(4096,4096),

nn.ReLU(True),

nn.Dropout(),

nn.Linear(4096,num_classes)

########## End ##########

)

def forward(self, x):

########## Begin ##########

x = self.features(x),

x = x.view(x.size(0),-1)

x = self.classifier(x)

########## End ##########

return x

model = VGG16()

print(model)

5786

5786

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?