任务要求 :将 Streamlit+LlamaIndex+浦语API的 Space 部署到魔搭社区

步骤一:注册魔搭账号>登录>我的Notebook

ModelScope Notebook是一款云端机器学习开发IDE工具,为您提供交互式编程环境,适用于不同水平的AI开发者。 通过与阿里云PAI-DSW、弹性加速计算实例EAIS合作,Notebook为用户提供了开箱可用的限时免费算力额度,实现ModelScope模型开发环境与CPU/GPU等多样化计算资源的无缝连接。

注意:免费Notebook的使用,需要绑定阿里云账号授权,详细操作查看魔搭文档中心

步骤二:创建机器,这里我选择免费的CPU服务器,GPU免费时常有限,以后我用在刀刃上

我都是选的默认的,见上图。

步骤三:创建conda环境

Conda 是一个开源的软件包管理和环境管理系统,通过Conda可以创建和管理多个独立的开发环境,避免相互干扰。在Python等语言开发过程中,使用Conda来进行环境保存和隔离是常见的操作。

魔搭文档中心的Notebook用户操作指南有详细“配置和使用conda环境”介绍,在此不赘述。

注意:在安装后需要显式地调用conda init初始化:/mnt/workspace/miniconda3/bin/conda init

初始化成功以后,关闭当前的terminal窗口,再重新打开。就可以正常使用conda命令了。

后续关闭ModelScope Notebook实例后,后续每次打开ModelScope Notebook的时候,都需要重新执行一次如上的初始化命令。

步骤四:按照实战营坚定不移的走下来即可,详见书生大模型学习L1G4000-CSDN博客

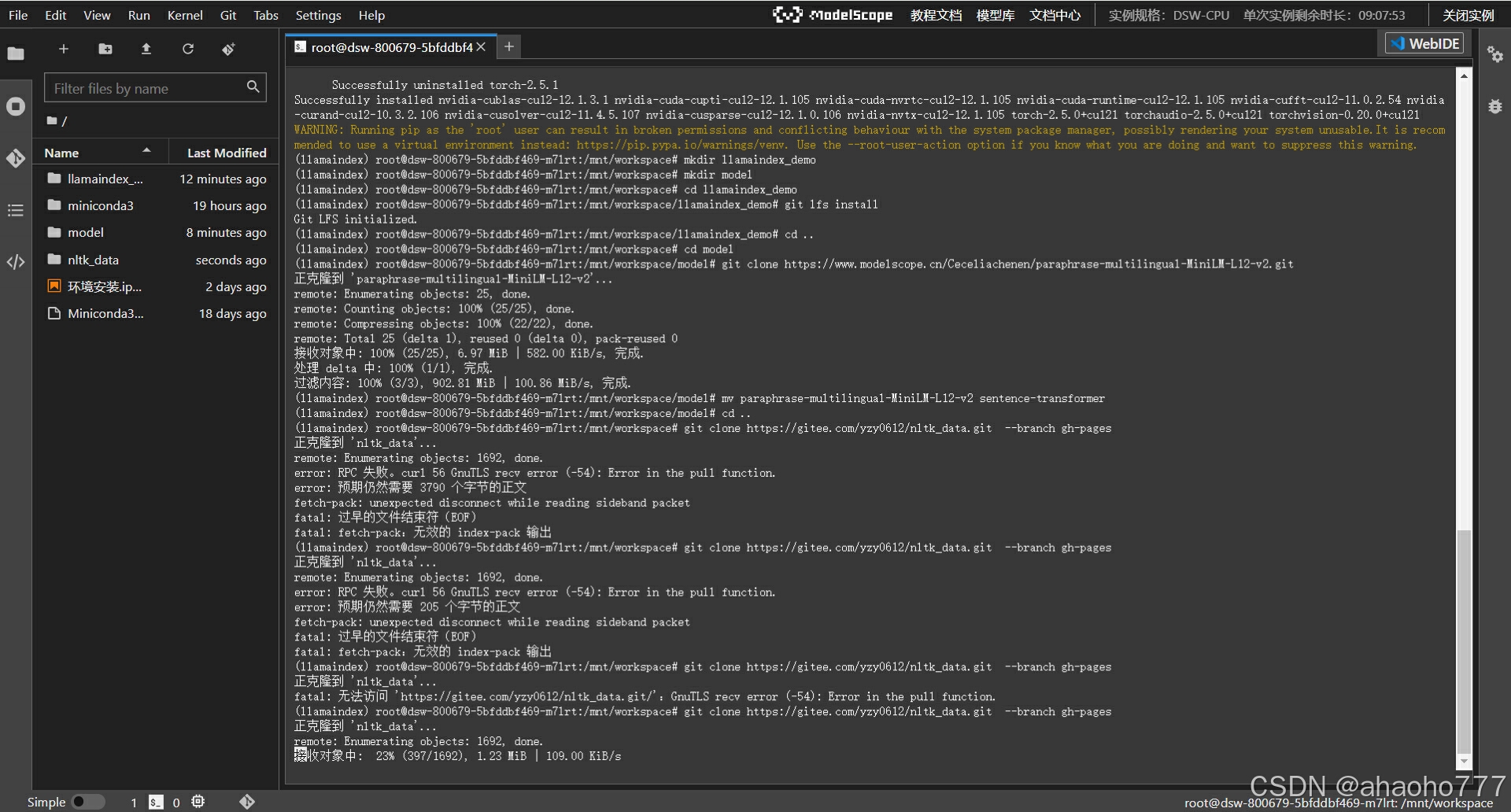

注意:因为免费的机器嘛,网络速度和可靠性就不能要求太高,各种错误都有,基本都是机器反应没预想那么快,下载终端报错等等,笨办法——命令报错就重复执行直到成功。

285

285

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?