点击下方卡片,关注“CVer”公众号

AI/CV重磅干货,第一时间送达

作者:JSYu(源:知乎,已授权)| 编辑:CVer

https://zhuanlan.zhihu.com/p/661755671

在CVer微信公众号后台回复:MAFT,可以下载本论文pdf、代码,学起来!

Learning Mask-aware CLIP Representations for Zero-Shot Segmentation

Paper: https://arxiv.org/pdf/2310.00240

Code: github.com/jiaosiyu1999/MAFT

1. Abstract

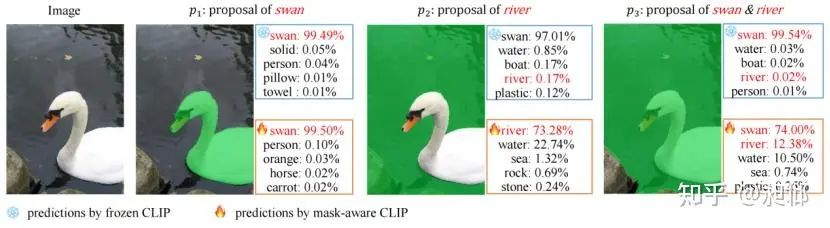

本篇文章通过对CLIP进行微调的方式来解决zero-shot segmentation和open-vocabulary segmentation。先前的零样本/开放域分割模型都是通过将CLIP冻结来保留其zero-shot能力。然而,本文指出:冻结的CLIP对不同的掩码不敏感,并且倾向于对同一图像的各种掩码产生相似的预测。这种对不同掩码的不敏感是影响最终分割结果的关键。以下图为例,尽管冻结的CLIP将“天鹅”的掩码(p1)进行了正确的分类,但其将同时包含“天鹅”和“河流”的掩码(p3)也归类为“天鹅”。

基于上述观察,本篇文章的提出了针对CLIP的掩码敏感型微调(Mask-Aware Fine-Tuning)范式,通过对CLIP的Image Encoder进行微调,使其学习到对掩码敏感的知识表征。这种微调遵循两个原则:1)提升CLIP对不同掩码的区别能力。2)保持CLIP的zero-shot能力。

优势:(1)MAFT即插即用,fine-tune过的CLIP可直接应用到大多数零样本/开放域分割模型中,并且和SAM等模型结合可得到更高质量的结果。(2)相比于pixel-level的约束,mask级别的finetune可以更好保存 CLIP的泛化性。(3)高效,本文对CLIP Image Encoder进行修改,使其可以同时处理任意数量的掩码,极大降低了计算冗余。此外finetune仅需很短的时间即可实现(Pasca-VOC: 100 iterations; COCO-Stuff: 1000 iterations)。

2. Methodology

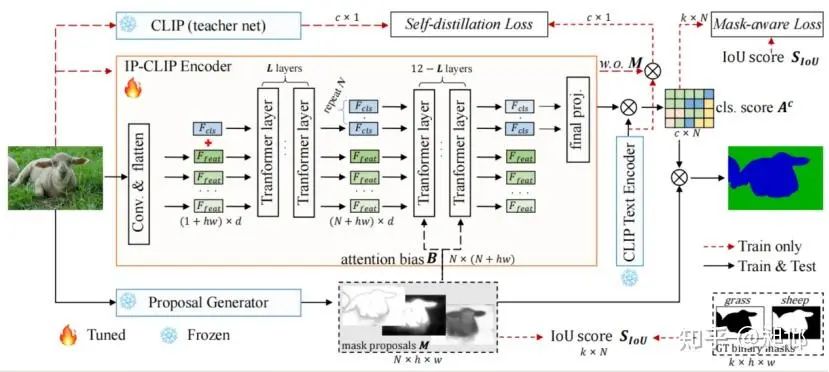

论文中的模型结构如下:

2.1 Image-Proposal CLIP Encoder

受Mask2Former启发,本文对CLIP Image Encoder进行了修改,将proposal generator生成的掩码作为偏置(Bias),添加到Multihead Attention中。这种修改过的Image-Proposal CLIP (IP-CLIP)可并行处理任意数量的掩码,极大程度上减少了计算冗余,并且所有的掩码分类时可获取全局信息,有助于分类。

2.2 Objective

本文在mask-aware fine-tuning阶段设计了两个loss。(1)mask-aware loss约束掩码的分类得分(Ac)和掩码质量(IoU得分)趋于一致。(2)本文在训练阶段额外引入了一个参数冻结的CLIP作为teacher net,self-distillation loss约束无掩码时整图的分类得分和teacher net的分类得分保持一致。

通过mask-aware loss和self-distillation loss的约束,保证了CLIP通过fine-tune对不同掩码敏感,且不损害CLIP的zero-shot能力。

3. Experiment

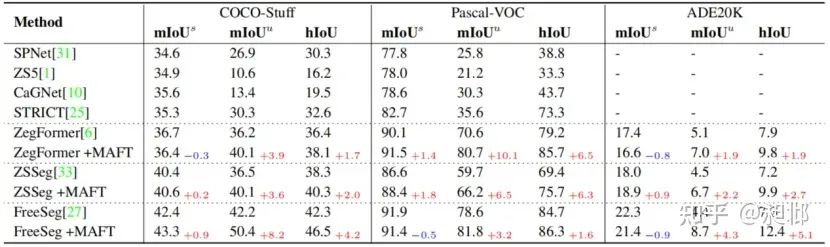

3.1 zero-shot / open-vocabulary segmentation

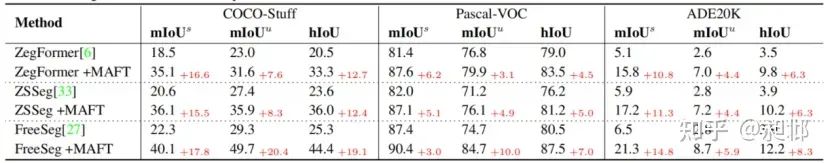

zero-shot segmentation结果如下,由于ZegFormer,ZSSeg和FreeSeg使用了ensemble将seen类别和unseen类别的分类得分分别对待,因此MAFT在seen类别上的增益不明显。

本文额外的给出了不使用ensemble的结果,即仅适用CLIP对掩码进行分类,可见MAFT在seen和unseen类别上均有显著提升。

open-vocabulary segmentation结果如下

3.2 Ablation Studies

本文进行了广泛的消融实验,包括(a)对MAFT各模块进行消融,(b)对mask-aware loss函数进行消融,(c)对fine-tuning的迭代次数进行消融,(d)对CLIP中参与fine-tune的各个units进行消融,(e)对开始masked multihead attention的transformer layer进行消融。

3.3 Extending MAFT with SAM

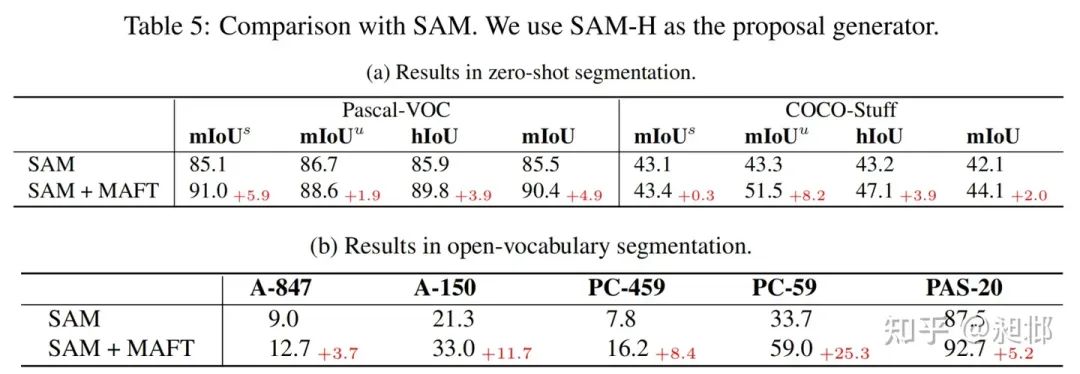

本文探索了使用Segment Anything Model作为proposal generator的效果。

3.4 Extending MAFT with more Vision-Language Models

本文探索了将MAFT应用到更多的Vision-Language模型中,包括CLIP-ViT-L和CLIP-Res50。

1)使用更强的Vision-Language模型CLIP-ViT-L可以在开放域分割中达到新的SOTA性能。

2)MAFT 也可以轻松应用到ResNet-based模型上,类似于IP-CLIP的设计,我们将偏置(Bias),添加到AttentionPool2d中的Multihead Attention中。可见MAFT对ResNet-based的模型同样可以产生显著的效果。

3.5 Qualitative Study

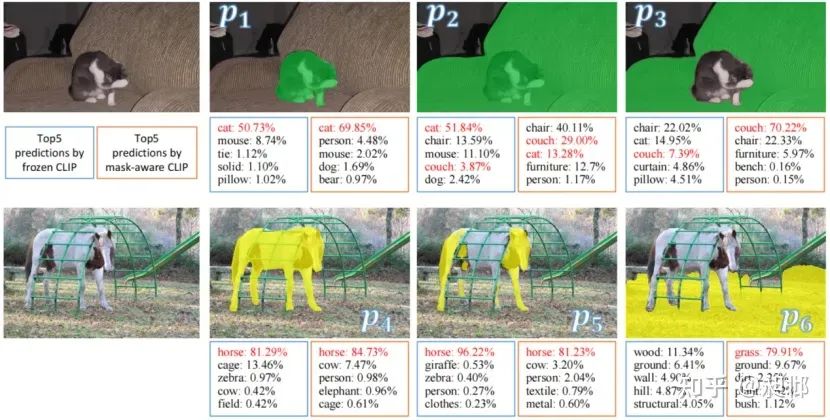

本文展示了一些典型的掩码和TOP5分类得分,可见经过MAFT,CLIP对于不同的掩码更加敏感了,给出的得分也更加合理。

本文在多个数据集上对比了FreeSeg和FreeSeg+MAFT的可视化结果

在CVer微信公众号后台回复:MAFT,可以下载本论文pdf、代码,学起来!

ICCV / CVPR 2023论文和代码下载

后台回复:CVPR2023,即可下载CVPR 2023论文和代码开源的论文合集

后台回复:ICCV2023,即可下载ICCV 2023论文和代码开源的论文合集图像分割和Transformer交流群成立

扫描下方二维码,或者添加微信:CVer444,即可添加CVer小助手微信,便可申请加入CVer-图像分割或者Transformer 微信交流群。另外其他垂直方向已涵盖:目标检测、图像分割、目标跟踪、人脸检测&识别、OCR、姿态估计、超分辨率、SLAM、医疗影像、Re-ID、GAN、NAS、深度估计、自动驾驶、强化学习、车道线检测、模型剪枝&压缩、去噪、去雾、去雨、风格迁移、遥感图像、行为识别、视频理解、图像融合、图像检索、论文投稿&交流、PyTorch、TensorFlow和Transformer、NeRF等。

一定要备注:研究方向+地点+学校/公司+昵称(如图像分割或者Transformer+上海+上交+卡卡),根据格式备注,可更快被通过且邀请进群▲扫码或加微信号: CVer444,进交流群

CVer计算机视觉(知识星球)来了!想要了解最新最快最好的CV/DL/AI论文速递、优质实战项目、AI行业前沿、从入门到精通学习教程等资料,欢迎扫描下方二维码,加入CVer计算机视觉,已汇集数千人!

▲扫码进星球▲点击上方卡片,关注CVer公众号

2274

2274

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?