点击下方卡片,关注“CVer”公众号

AI/CV重磅干货,第一时间送达

添加微信号:CVer111,小助手会拉你进群!

扫描下方二维码,加入CVer学术星球!可以获得最新顶会/顶刊上的论文idea和CV从入门到精通资料,及最前沿应用!发论文/搞科研/涨薪,强烈推荐!

编辑:CVer 微信公众号| 作者:CVer粉丝投稿

(来自浙大,腾讯优图,南洋理工大学)

论文:https://arxiv.org/abs/2404.06564

主页:lewandofskee.github.io/projects/MambaAD/

代码:github.com/lewandofskee/MambaAD

内容总结(太长不看版)

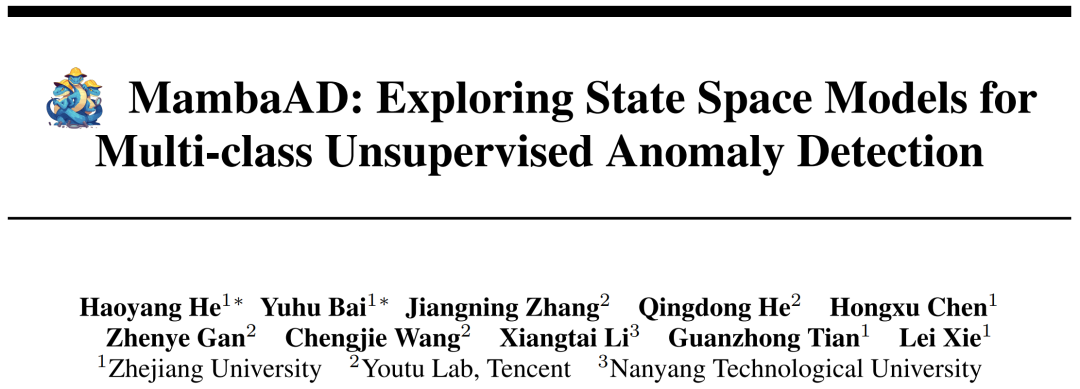

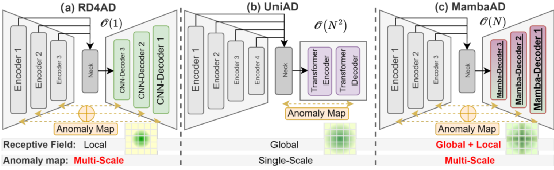

过去基于CNN和Transformer的结构的算法被广泛应用于异常检测领域取得了一定的效果。但是CNN无法处理长距离信息的关联性,而Transformer受限于其平方级别的计算复杂度。最近基于Mamba的模型凭借着其长距离建模的出色能力与线性计算复杂度引起了广泛的研究。在本文中,我们首次将Mamba应用于多类无监督异常检测领域并提出MambaAD如图1所示包含一个预训练的CNN编码器和由不同尺度的局部增强状态空间(LSS)模块成的Mamba解码器。被提出的LSS 模块包含并行的连续混合状态空间(HSS)模块和多核的卷积操作,能够同时具有长距离的建模能力与局部信息的建模能力。HSS模块所包含的混合扫描(HS)编码器将特征图编码至5种不同的扫描方式和8种不同的扫描方向并输送至SSM中建立全局的联系。其中我们采用了Hilbert扫描方式和8种扫描方向有利于提升特征序列的建模能力。大量实验表明,我们在6种不同异常检测数据集上、7种不同的指标上取得了SoTA,证明了Mamba AD方法了有效性。

图1 MambaAD框架结构图

1、引言

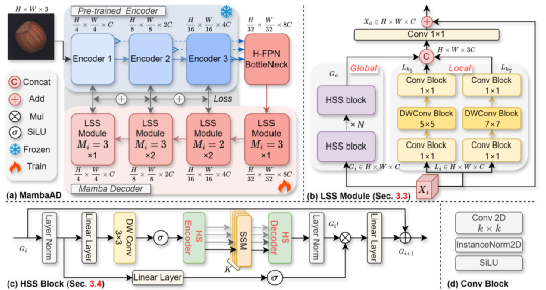

尽管基于合成和基于特征编码的方法在AD领域取得了不错的效果,但是这些方法需要额外的设计与不可轻易扩展的框架。基于重建的方法如RD4AD和UniAD具有非常好的效果与较好的可扩展性。RD4AD提出了预训练教师模型与学生模型并在多尺度特征层面上进行异常值对比。尽管基于CNN的RD4AD在多尺度上的有着捕捉相邻的信息能力并取得了较好的性能,但是其无法建立长距离的相关性。首个多类异常检测算法UniAD是基于预训练的CNN编码器和Transformer解码器的架构。尽管Transformer有着全局建模的能力,但是由于其平方级别计算复杂度,UniAD仅在最小尺度的特征图上对比得到异常图,这无疑会减弱模型性能。

图2 MambaAD与基于CNN的RD4AD和Transformer的UniAD方法对比

2、MambaAD贡献

最近,Mamba在大语言模型中取得了出色的表现,有着远小于transformer的线性复杂度并且能够与transformer相媲美的效果。近期大量的工作将Mamba引入视觉领域,涌现大量基于Mamba的研究工作。本文首次将Mamba引入异常检测领域,构建了MambaAD架构有着全局+局部的建模能力,并且利用它的线性复杂度在多尺度上计算异常图并且有着较低的参数量与计算复杂度。具体来说MambaAD使用金字塔结构的自编码器结构来重建多尺度的特征,通过一个预训练编码器和提出的基于Mamba结构的解码器。其中基于Mamba结构的解码器由不同尺度与数量的局部增强状态空间(Locality-Enhanced State Space) LSS module组成。LSS module由两部分组成:连续的(Hybrid State Space) HSS模块用于捕捉全局的信息和并联多核的卷积操作用来建立局部的联系。最终的输出特征不仅包含基于Mamba的全局建模能力,还包含了基于CNN的建立局部相关性的能力。所提出的HSS模块探索了5种不同的扫描方式和8种不同的扫描方向,其中的HS编码器和解码器分别将特征图编码至不同的扫描方式和方向的序列并解码。HSS模块能够增强在多个方向上的全局感受野并且所使用的Hilbert的扫描方式也更加适用于工业产品位置集中在中心区域的特点。通过在不同尺度的特征图上计算异常图并相加,MambaAD在6个不同的异常检测数据集上取得了SoTA性能并且模型参数量与计算复杂度也非常低。具体来说,我们的贡献如下:

1)我们提出了MambaAD首次使用Mamba来解决多类无监督异常检测任务,它能够在很少的模型参数量和计算复杂度上进行多尺度训练与推理。

2)我们设计了一个LSS module,连接的HSS模块和并行的多内核卷积分别提取全局特征相关性与局部信息关联性,实现全局加局部的统一建模。

3)我们探索了HSS模块即5种方法8种多方向的混合扫描方式如图3所示,能够增强复杂的异常检测图像在不同类别不同形态下的全局建模能力。

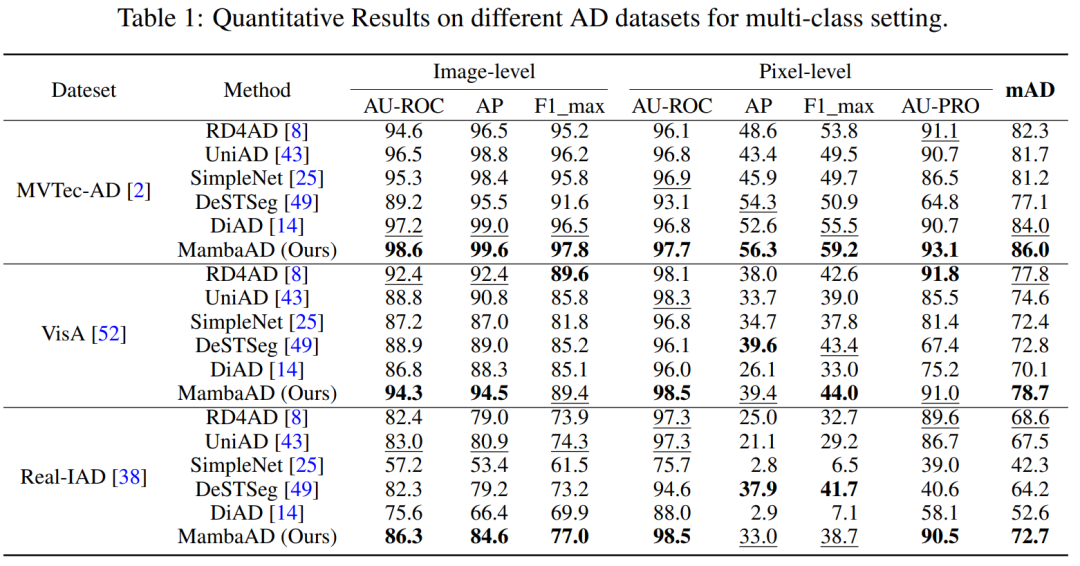

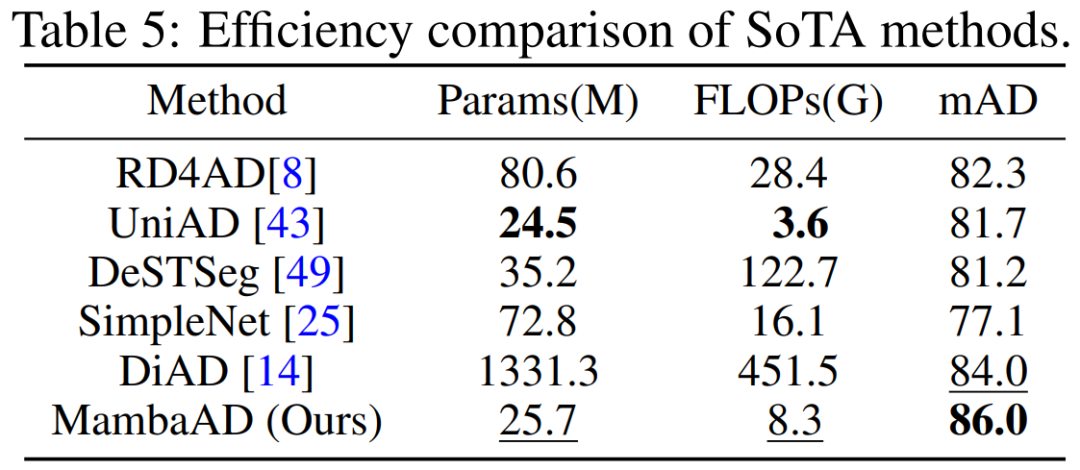

4)我们证明了MambaAD在多类异常检测任务的优越性和高效性。在6个不同的异常检测数据集上达到SOTA如表1所示,并且有着非常低的模型参数与计算复杂度见表2。

图3 五种不同的扫描方式和八种扫描方向

表1 三个异常检测数据集对比结果,更多详细结果参考文章附录

表2 MambaAD与SOTA方法在参数量、计算复杂度和效果上对比

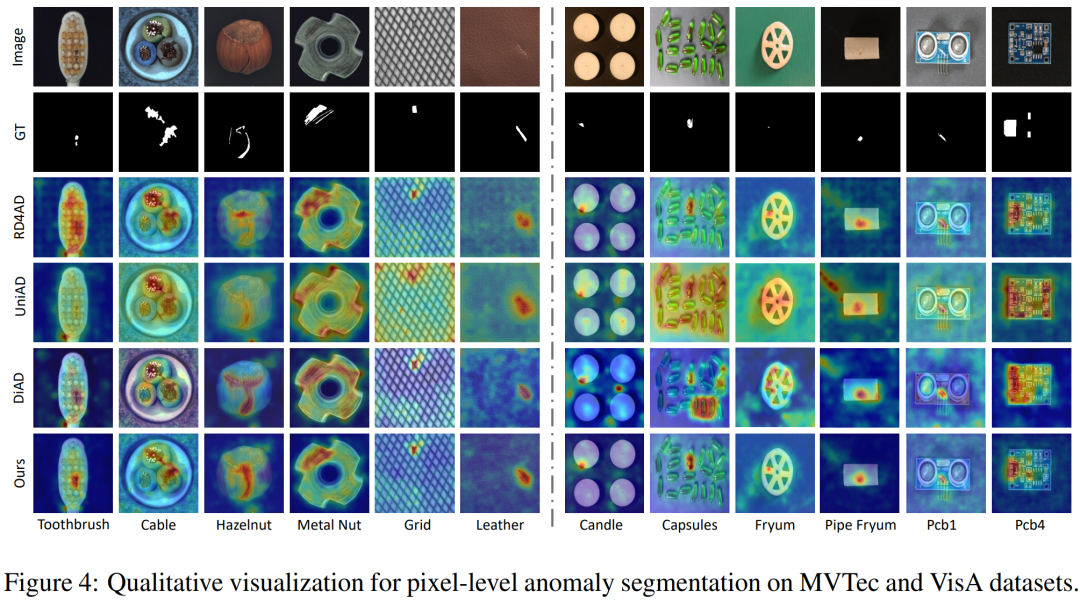

图4 MambaAD与SOTA方法定性实验结果对比

何恺明在MIT授课的课件PPT下载

在CVer公众号后台回复:何恺明,即可下载本课程的所有566页课件PPT!赶紧学起来!

ECCV 2024 论文和代码下载

在CVer公众号后台回复:ECCV2024,即可下载ECCV 2024论文和代码开源的论文合集CVPR 2024 论文和代码下载

在CVer公众号后台回复:CVPR2024,即可下载CVPR 2024论文和代码开源的论文合集Mamba、多模态和扩散模型交流群成立

扫描下方二维码,或者添加微信号:CVer111,即可添加CVer小助手微信,便可申请加入CVer-Mamba、多模态学习或者扩散模型微信交流群。另外其他垂直方向已涵盖:目标检测、图像分割、目标跟踪、人脸检测&识别、OCR、姿态估计、超分辨率、SLAM、医疗影像、Re-ID、GAN、NAS、深度估计、自动驾驶、强化学习、车道线检测、模型剪枝&压缩、去噪、去雾、去雨、风格迁移、遥感图像、行为识别、视频理解、图像融合、图像检索、论文投稿&交流、PyTorch、TensorFlow和Transformer、NeRF、3DGS、Mamba等。

一定要备注:研究方向+地点+学校/公司+昵称(如Mamba、多模态学习或者扩散模型+上海+上交+卡卡),根据格式备注,可更快被通过且邀请进群▲扫码或加微信号: CVer111,进交流群

CVer计算机视觉(知识星球)来了!想要了解最新最快最好的CV/DL/AI论文速递、优质实战项目、AI行业前沿、从入门到精通学习教程等资料,欢迎扫描下方二维码,加入CVer计算机视觉(知识星球),已汇集上万人!

▲扫码加入星球学习▲点击上方卡片,关注CVer公众号

整理不易,请赞和在看

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?