在这篇由何恺明团队领衔的研究中,作者们深入解构了去噪扩散模型(DDM),逐步将其转化为传统的去噪自编码器(DAE),并揭示了现代DDM中的关键组件对自监督表示学习的影响。通过系统性地去除复杂组件,研究发现创建低维潜在空间是学习良好表示的关键,且这一发现与具体的分词器实现无关。最终,团队提出了一种被称为“潜在去噪自编码器”(l-DAE)的简化架构,在自监督学习中展示了非凡的表现。这一突破性的研究不仅提升了对DDM和DAE在表示学习中作用的理解,还为经典方法在现代自监督学习领域的应用提供了新的思路。

摘要

在这项研究中,我们研究了最初用来图像生成的去噪扩散模型(DDM)的表示学习能力。我们的理念是解构一个DDM,逐步将其转变为经典的去噪自编码器(DAE)。这种解构过程使我们能够探讨现代DDM的各种组件如何影响自监督表示学习。我们观察到,只有极少数的现代组件对学习好的表示是关键的,而许多其他组件并非必需。我们的研究最终提出了一种高度简化并且在很大程度上类似于经典DAE的方法。我们希望我们的研究能够重新激发对现代自监督学习领域中的经典方法的兴趣。

1. 介绍

在计算机视觉和其他领域的当前趋势中,去噪是生成模型的核心。目前流行的去噪扩散模型(DDM)学习了一个多级去噪自编码器(DAE),由扩散过程驱动,去除不同级别的噪声。这些方法在图像生成质量上取得了令人印象深刻的成果,特别是对于高分辨率、照片级真实感图像——事实上,这些生成模型表现如此出色,以至于它们似乎拥有强大的识别表示来理解视觉内容。

尽管DAE是当今生成模型的核心力量,但最初提出DAE是为了从数据中以自监督的方式学习表示。在今天的表示学习社区中,可以说最成功的DAE变体是基于“掩蔽噪声”的,如语言中的预测缺失文本(例如BERT)或图像中的缺失块(例如MAE)。然而,从概念上讲,这些基于掩蔽的变体与去除加性(例如高斯)噪声有显著不同:掩蔽方法的掩蔽标记了未知与已知的内容,而在分离加性噪声的任务中没有可用的干净信号。

虽然DAE是今天生成模型的核心力量,但它最初是为了从数据中以自监督的方式学习表示提出的。在今天的表示学习社区中,最成功的DAE变体可以说是基于“掩蔽噪声”,如语言中的缺失文本预测(例如,BERT)或图像中的缺失块(例如,MAE)。然而,从概念上讲,这些基于掩蔽的变体与去除加性(例如,高斯)噪声有显著不同:掩蔽标记明确区分了未知与已知内容,而在加性噪声的分离任务中没有可用的清信号。

尽管如此,今天的DDM用于生成主要基于加性噪声,这意味着它们可以在不明确标记未知/已知内容的情况下学习表示。

最近,有越来越多研究[40, 28]关注检查DDM的表示学习能力。特别是,这些研究直接使用从生成目的出发预先训练好的DDM,评估其在识别任务中的表示质量。他们报告了令人鼓舞的结果,表明这些原本面向生成的模型在表示学习中也有出色的表现。但是,这些前瞻性的研究显然留下了一些悬而未决的问题:这些现成的模型是为生成而设计的,而非为识别;还不清楚表示能力是通过去噪驱动过程获得的,还是通过扩散驱动过程获得的。

在这项研究中,我们进一步深入探讨这些最近的研究。在这项研究中,我们解构一个DDM,逐步将其转变为经典的DAE。通过这种解构过程,我们逐步检查现代DDM的每一个方面,目的是学习表示。这一研究过程赋予我们新的理解,了解哪些组件对于DAE学习到好的表示是关键的。

令人惊讶的是,我们发现主要的关键组件是一个创建低维潜在空间的分词器。我们探索了标准的VAE、逐块VAE、逐块AE和逐块PCA编码器,发现是低维潜在空间,而非分词器的细节,使得DAE能够实现良好的表示学习。

由于PCA的有效性,我们的解构轨迹最终达到了一个与经典DAE高度相似的简单架构。我们用逐块PCA将图像投影到潜在空间中,添加噪声,然后通过逆PCA投影回像素空间。接下来,我们训练一个自编码器来预测去噪后的图像。我们称这种架构为“潜在去噪自编码器”(l-DAE)。

我们的解构轨迹还揭示了许多其他介于DDM和经典DAE之间的有趣特性。例如,我们发现即使使用单一噪声级别(即不使用DDM的噪声调度)也能在我们的l-DAE中取得不错的结果。使用多个噪声级别的角色类似于一种数据增强形式,可以是有益的,但不是一个必要因素。通过这些和其他观察,我们认为DDM的表示能力主要是通过去噪驱动的过程获得的,而不是通过扩散驱动的过程获得的。

最后,我们将我们的结果与之前的基线进行比较。一方面,我们的结果明显优于现成的对比结果(遵循[40, 28]的精神):这是预期的,因为这是我们解构的起点。另一方面,我们的结果略低于基线对比学习方法(例如[7])和基于掩蔽的方法(例如[21]),但差距缩小了。我们的研究表明,沿着DAE和DDM的研究方向还有进一步研究的空间。

2. 相关工作

在机器学习和计算机视觉的历史中,图像(或其他内容)的生成与无监督或自监督学习的发展紧密相连。从概念上讲,生成方法是一种无监督/自监督学习的方法,模型在没有标签数据的情况下训练,学习捕捉输入数据的基础分布。

一直有一种普遍的信念,即模型生成高保真数据的能力表明其学习良好表示的潜力。生成对抗网络(GAN)点燃了对对抗表示学习的广泛兴趣。变分自编码器(VAE)最初被构想为用于近似数据分布的生成模型,已经发展成为学习局部表示(“令牌”)的标准,例如VQVAE及其变体。图像修复从本质上讲是一种条件图像生成方法,已引导出一系列现代表示学习方法,包括上下文编码器和掩蔽自编码器(MAE)。

类似地,去噪扩散模型(DDM)的出色生成性能引起了人们对其表示学习潜力的关注。前瞻性研究开始通过评估现有预训练的DDM网络来研究这一方向。然而,我们注意到,虽然模型的生成能力表明了一定程度的理解,但这并不一定转化为对下游任务有用的表示。我们的研究深入探讨了这些问题。

另一方面,虽然去噪自编码器(DAE)为基于自编码器的表示学习奠定了基础,但它们的成功主要局限于使用掩蔽噪声的场景。到目前为止,几乎没有近来的研究报告过经典DAE变体在加性高斯噪声下的结果,我们认为其根本原因在于简单的DAE基线表现不佳。

3. 背景:去噪扩散模型

我们的解构研究从一个去噪扩散模型(DDM)开始。我们简要描述我们使用的DDM,遵循的模型架构。

扩散过程从一个干净的数据点(z0)开始,逐步向其中添加噪声。在指定时间步t,噪声数据zt由以下方式给出: zt=γt⋅z0+σt⋅ϵ 其中,ϵ~N(0, I)是从高斯分布中采样的噪声图,γt和σt定义信号和噪声的缩放因子。默认情况下设置为: γt2+σt2=1

去噪扩散模型被训练为在时间步t的条件下去除噪声。与原始的DAE直接预测干净输入不同,现代的DDM通常预测噪声ϵ。特别地,最小化以下形式的损失函数: ∥ϵ−net(zt)∥2 其中net(zt)是网络输出。网络在给定噪声调度的多个噪声级别上进行训练,条件为时间步t。在生成过程中,一个训练好的模型迭代应用,直到达到干净信号z0。

DDM可以在两种输入空间上操作。一种是原始像素空间,其中原始图像直接用作z0。另一种选择是按照生成的潜在扩散模型,在令牌生成的潜在空间上构建DDMs。

4. 解构去噪扩散模型

解构轨迹分为三个阶段。首先,我们适应DiT中的生成聚焦设置,使其更加面向自监督学习。然后,我们逐步解构和简化分词器。最后,我们尝试尽可能逆转DDM驱动的设计,将模型推向经典的DAE。我们在解构过程中总结所学内容。

4.1 使DDM更加面向自监督学习

虽然DDM概念上是一种DAE,但最初是为图像生成开发的。许多设计是面向生成任务的。一些设计在自监督学习背景下是不合法的(例如,涉及类别标签);如果不关注视觉质量,则不需要其他设计。在本节中,我们总结了调整后的DDM基线面向自监督学习。

移除类别条件

高质量的DDM通常在类别标签的条件下进行训练,可以大大提高生成质量。但是在我们的自监督学习研究中使用类别标签是不合法的。作为第一步,我们在基线中移除了类别条件。

令人惊讶的是,移除类别条件显著提高了线性探测准确性,从57.5%增加到62.1%,即使生成质量如预期大大下降(FID从11.6增加到34.2)。我们推测,直接根据类别标签进行条件化可能会减少模型对编码与类别相关信息的需求。移除类别条件可以迫使模型学习更多语义。

解构VQGAN

在我们的基线中,由LDM提出并通过DiT继承的VQGAN分词器是用多个损失项训练的:(i) 自动编码重建损失;(ii) KL散度正则化损失;(iii) 基于经过监督训练用于ImageNet分类的VGG网络的感知损失;和(iv) 带有判别器的对抗损失。我们在表1中去掉了后两项损失。

由于感知损失涉及经监督训练的网络,使用包含该损失的VQGAN是非法的。取而代之的是,我们训练了另一个VQGAN分词器,去除了感知损失。使用这个分词器大大降低线性探测准确率,从62.1%下降到58.4%,这提供了迄今为止第一个合法的条目。这个比较揭示了使用感知损失训练的分词器本身提供语义表示。从本文的其余部分开始,将不再使用感知损失。

我们进一步去除对抗损失,训练下一个VQGAN分词器。线性探测准确性略微从58.4%增加到59.0%。在这一点,我们的分词器本质上就是一个VAE,这将是我们下一节进行解构的内容。我们还注意到,移除任一损失都会对生成质量产生不利影响。

更改噪声调度

在生成任务中,目标是逐步将噪声图转换为图像。因此,原始的噪声调度在非常嘈杂的图像上花费了很多时间步。这对于我们的模型不是生成的情况下是不必要的。

我们研究了一种更简单的噪声调度,用于自监督学习。具体来说,我们让γt^2在1>γt^2≥0的范围内线性衰减。这使模型能够在较干净的图像上花费更多的能力。此更改极大地提高了线性探测准确率,从59.0%提高到63.4%,表明原始调度过多关注于嘈杂的环境。另一方面,正如预期的那样,这样做进一步削弱了生成能力,导致FID下降到93.2。

4.2 解构分词器

接下来,我们进一步解构VAE分词器,进行大量简化。我们比较了以下四种自编码器变体作为分词器,每种都是前一版本的简化版本:

- 卷积VAE:我们的解构到目前为止得出了VAE分词器。惯例中,VAE的编码器和解码器是深度卷积神经网络。卷积VAE最小化以下损失函数: ∥x−g(f(x))∥2+KL[f(x)∣N] 其中x是VAE的输入图像。第一个项是重建损失,第二个项是f(x)和单位高斯分布之间的Kullback-Leibler散度。

- 逐块VAE:接下来,我们考虑一种简化情况下的VAE,其编码器和解码器都是线性投影,VAE的输入x是一个图像块。逐块VAE的训练过程最小化这个损失: ∥x−UTVx∥2+KL[Vx∣N] 其中x表示被展平为D维向量的块。U和V都是d×D矩阵,d是潜在空间的维度。我们将块大小设置为16×16像素。

- 逐块AE:我们通过移除正则化项进一步简化VAE: ∥x−UTVx∥2 因此,这个分词器本质上是一个逐块自编码器(AE),其编码器和解码器都是线性投影。

- 逐块PCA:最后,我们考虑一种更简单的变体,即在块空间上进行主成分分析(PCA)。容易证明PCA相当于AE的特殊情况: ∥x−VTVx∥2 其中V满足VVT=I(d×d的单位矩阵)。PCA基可以通过对大量随机采样块进行特征分解简单地计算出来,不需要基于梯度的训练。

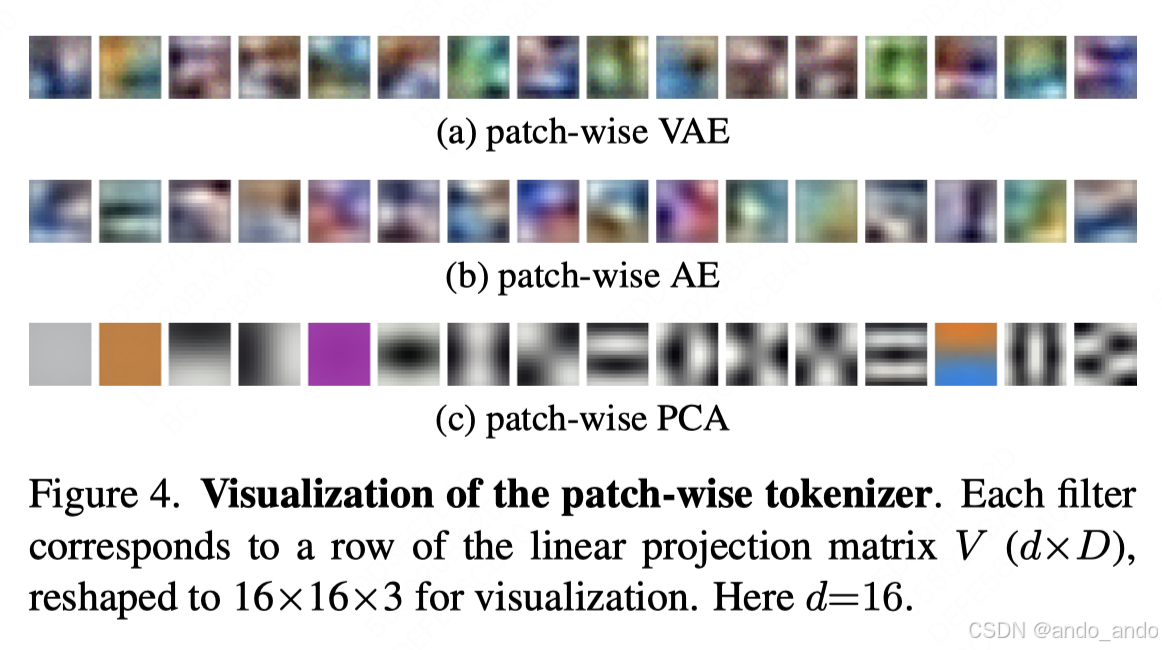

由于使用块的简单性,对于三种逐块分词器,我们可以将其滤波器可视化在块空间中。

表2总结了使用这些四种分词器变体计算潜在空间的DiT的线性探测准确率。我们分别对每个块的潜在维度进行了调整。各个分词器均表现出相似的趋势,尽管它们在架构和损失函数上有所不同。有趣的是,最佳维度相对较低(d为16或32),即使每个块的全维度要高得多(768)。

令人惊讶的是,卷积VAE分词器既不是需要的,也不是有利的;相反,所有逐块分词器,各块独立地进行编码,表现出彼此类似的性能,且始终优于卷积VAE变体。此外,KL正则化项是非必要的,因为AE和PCA变体也工作良好。

进一步令人惊讶的是,即使是PCA分词器也很好工作。与VAE或AE同行不同,PCA分词器不需要基于梯度的训练。通过预计算的PCA基,应用PCA分词器类似于一种图像预处理,而不是“网络架构”。PCA分词器的有效性在很大程度上推动我们将现代DDM向经典DAE推近,如我们将在下一节所展示的。

4.3 向经典去噪自编码器靠近

接下来,我们继续解构的轨迹,目标是尽量接近经典DAE。我们尝试移除尽可能多的现代DDM设计,通过这个解构过程,我们得以更好地理解每个现代设计是如何影响经典DAE的。表3给出了结果,接下来讨论这些结果。

预测干净数据(而不是噪声):虽然现代DDM通常预测噪声ϵ(见公式(2)),但经典DAE却是预测干净数据。我们通过最小化以下损失函数来检查这一差异: λt∥z0−net(zt)∥2 这里z_0是干净数据(在潜在空间中),net(z_t)是网络预测。λ_t是一个与t相关的损失权重,用来平衡不同噪声级别的贡献。根据[34]建议,设置λ_t = γ_t^2 / σ_t^2。然而,我们发现设置λ_t = γ_t^2在我们的场景中效果更好。直观地,这只是对较干净数据(较大的γ_t)给予更大权重。

通过将预测目标修改为预测干净数据(而不是噪声),线性探测准确率从65.1%下降到62.4%(见表3)。这表明预测目标的选择会影响表示质量。

即使在这步中我们遭遇了性能下降,但我们将在接下来的步骤中坚持这一修改,因为我们的目标是尽量接近经典DAE。

移除输入缩放:在现代DDM中(见公式(1)),输入被一个γ_t因子缩放。这在经典DAE中并不常见。接下来,我们研究移除输入缩放,即设置γ_t 恒等于1。由于γ_t固定,我们需要直接在σ_t上定义噪声调度。我们简单地将σ_t设置为从0到 √2 的线性调度。此外,我们经验性地设置公式(3)中的权重λ_t = 1 / (1 + σ_t^2),这再次对较干净的数据(较小的σ_t)给予更多权重。

在固定γ_t 恒等于1 后,我们实现了64.5%的准确率,与变化的γ_t对应的62.4%相比分别不大。这表明在我们的场景中不需要对数据进行γ_t 缩放。

在图像空间中操作并使用逆 PCA:到目前为止,除了表5中的条目,所有探讨的模型都在由分词器生成的潜在空间上操作。理想情况下,我们希望DAE能直接在图像空间上工作,同时保持良好的准确性。通过使用PCA,我们可以通过逆 PCA 实现这一目标。

这个想法如图1所示。特别地,我们将输入图像投影到PCA基上(即V),在潜在空间中添加噪声,并通过逆PCA基(V^T)将噪声潜在空间投影回图像空间。图1(中下)显示了在潜在空间中添加噪声的图像示例。用这个带噪图像作为网络输入,我们可以应用标准ViT网络直接在图像上操作,就好像没有分词器一样。

在输入方应用这个修改(同时仍在潜在空间上预测输出)后,获得了63.6%的准确率(见表3)。进一步将其应用于输出方(即在图像空间上进行逆PCA预测输出)后获得63.9%的准确率。这两个结果表明,在图像空间上操作并使用逆 PCA 可以取得与在潜在空间上操作类似的结果。

预测原始图像:虽然逆 PCA 可以在图像空间中生成预测目标,但这个目标不是原始图像。这是因为PCA是任何降低维度d的有损编码器。相反,更自然的解决方案是直接预测原始图像。

当我们让网络预测原始图像时,"噪声"包括两个部分:(i) 加性高斯噪声,其内在维度为d,以及 (ii) PCA重建误差,其内在维度为D - d(D为768)。我们对两部分损失分别给予不同权重。

形式上,使用干净的原始图像x_0和网络预测net(x_t),我们可以计算投影到完整PCA空间的残差r: r≜V(x0−net(xt)) 这里V是表示完整PCA基的D × D矩阵。然后我们最小化以下损失函数: λt∑i=1Dri2 这里i表示向量r的第i维。维度权重w_i 对于i ≤ d 时为1,对于d < i ≤ D时为 0.1。直观地,w_i降低了PCA重建误差的损失。通过这种方式,预测原始图像获得了64.5%的线性探测准确率(见表3)。

这个变体概念上非常简单:其输入是一个其噪声在PCA潜在空间中添加的噪声图像,其预测是原始干净图像(如图1所示)。

单级噪声:最后,出于好奇,我们进一步研究一个单级噪声的变体。我们注意到,多级噪声由DDM中的扩散过程驱动这一特性;它在概念上是经典DAE中不需要的。

我们将噪声级别σ固定为常数(√1/3)。使用这种单级噪声获得了61.5%的准确率,比多级噪声降低了3%。使用多级噪声类似于DAE中的一种数据增强形式:它是有益的,但不是必需的因素。这也意味着DDM的表示能力主要是通过去噪驱动过程获得的,而不是通过扩散驱动的过程。

由于多级噪声是有益且概念简单的,我们在下节提供的最终条目中保留了它。

4.4 总结

总的来说,我们解构了一个现代DDM并将其向经典DAE推进(见图6)。我们撤销了许多现代设计,并在概念上仅保留了两个来自现代DDM的设计:(i) 在其上添加噪声的低维潜在空间;和(ii) 多级噪声。

我们使用表3最后的条目作为我们的最终DAE实例(如图1所示)。我们称这种方法为“潜在去噪自编码器”,简称l-DAE。

5. 分析和比较

潜在噪声可视化:从概念上讲,l-DAE 是一种 DAE,它学习去除添加到潜在空间中的噪声。感谢 PCA 的简单性,我们可以通过逆向 PCA 轻松地可视化潜在噪声。

如图 7 所示,比较了添加到像素空间和潜在空间中的噪声。与像素噪声不同,潜在噪声在很大程度上与图像的分辨率无关。使用逐块 PCA 作为分词器,潜在噪声的模式主要由块大小决定。直观地,我们可以将其视为使用块,而不是像素来解析图像。这种行为类似于 MAE,其掩膜块而不是单个像素。

去噪结果:图 8 展示了基于 l-DAE 的更多去噪结果。我们的方法在重噪下产生合理的预测。需要注意的是,这并不令人惊讶,因为基于神经网络的图像恢复领域是一项多次研究的领域。然而,这种可视化可能有助于我们更好地理解 l-DAE 如何学习到良好的表示。添加到潜在空间中的重噪声为模型创造了一个具有挑战性的前置任务以解决。对于人类来说,仅依靠一个或几个嘈杂的块来预测内容是非平凡的;模型被迫学习更高层次的、更全面的语义以理解潜在的对象和场景。

数据增强:值得注意的是,迄今为止,所有提供的模型都没有数据增强:只使用了图像的中心裁剪,没有随机调整大小或颜色抖动,遵循了 [11, 32]。我们进一步探索轻微的数据增强(随机调整缩放裁剪)对于我们最终的 l-DAE:

- 中心裁剪:64.5%

- 随机裁剪:65.0%

这表明 l-DAE 的表示学习能力在很大程度上与其对数据增强的依赖无关。在 MAE 中也观察到了类似的行为,这与对比学习方法的行为(例如 [6])有所不同。

训练 epochs:到目前为止,我们的所有实验都基于 400 个训练 epochs。遵循 MAE 的方法,我们还研究了 800 和 1600 个训练 epochs:

- 400 epochs:65.0%

- 800 epochs:67.5%

- 1600 epochs:69.6%

作为参考,在延长训练时间从 400 个 epochs 到 800 个 epochs 时, MAE 的性能有显著提升(4%),而 MoCo v3 在延长训练时间从 300 个 epochs 到 600 个 epochs 时,几乎没有提升(0.2%)。

模型大小:到目前为止,我们的所有模型都基于 DiT-L 变体,其编码器和解码器的大小都与 ViT-L 的一半深度(12 层)相同。我们进一步训练了不同大小的模型,其编码器为 ViT-B 或 ViT-L(解码器始终与编码器大小相同):

- 编码器 ViT-B:60.3%

- 编码器 ViT-½L:65.0%

- 编码器 ViT-L:70.9%

我们观察到 w.r.t. 模型大小的良好缩放行为:从 ViT-B 到 ViT-L 的缩放有 10.6% 的显著增益。MAE 也观察到类似的缩放行为,从 ViT-B 到 ViT-L 提升了 7.8%。

与先前基线的比较:最后,为更好地了解不同系列的自监督学习方法的表现,我们与之前的基线进行比较。我们考虑对比学习方法 MoCo v3 和基于掩蔽方法的 MAE。

有趣的是, l-DAE 与 MAE 比较表现良好,在 ViT-B 上有 1.4% 的差距,在 ViT-L 上有 0.8% 的差距。值得注意的是,这些训练设置在 MAE 和 l-DAE 之间保持尽可能公平:两者都训练了 1600 个 epochs,并使用随机裁剪作为数据增强。另一方面,MAE 训练效率更高,因为它只处理未掩蔽的块。尽管如此,我们在 MAE 和基于 DAE 的方法之间已大大缩小了准确性差距。

最后,我们观察到自编码器方法(MAE 和 l-DAE)在此协议下仍然没有对比学习方法的效果好,尤其是在模型较小的时候。我们希望我们的研究能引起更多对自编码器方法在自监督学习中的研究关注。

6. 结论

我们已经报告了 l-DAE 在很大程度上类似于经典 DAE,可以在自监督学习中表现出竞争力。关键的组件是在其上添加噪声的低维潜在空间。我们希望我们的发现能重新点燃对今天自监督学习研究背景下的去噪方法的兴趣。

附录 A:实现细节

DiT 架构:我们遵循 DiT 架构设计。DiT 架构类似于原始 ViT,带有为条件而做的额外修改。每个 Transformer block 接受条件化时间步 t 的嵌入网络(一个两层 MLP)。这个嵌入网络的输出决定了 LayerNorm 的缩放和偏置参数,称为 adaLN。与最初的设计稍有不同的是,我们将这个 MLP 的隐藏维度设置为其原始维度的 1/4,这有助于减少模型大小和节省内存,而不会带来准确度成本。

训练:原始 DiT 使用了 256 的批大小。为了加速我们的探索,我们将批大小增加至 2048。我们在线性学习率 warm-up 100 个 epochs 然后按照半周期余弦调度衰减。通常基础学习率为 1e-4,并按照线性缩放规则调整:基础学习率 × 批大小 / 256。默认情况下,不使用权值衰减。我们默认训练 400 个 epochs。使用 256 核 TPU-v3 pod,训练 DiT-L 需 12 小时。

线性探测:我们的线性探测实现遵循 MAE 的实践。我们使用 256×256 尺寸的干净图像进行线性探测训练和评估。ViT 输出特征图经全局池化,通过参数固定的 BatchNorm 层和一个线性分类器层处理。训练批大小为 16384,学习率为 6.4×10^-3(余弦调度),权值衰减为 0,训练时长为 90 个 epochs。训练期间使用随机调整缩放裁剪和翻转,测试时使用单一中心裁剪。报告 top-1 准确率。

当模型在自监督预训练时在 t 时间步条件下,条件因素在迁移学习(例如线性探测)中不是必需的。在我们的线性探测训练和评估中,我们固定时间步 t 的值(总共 1000 个时间步):

- 固定 t=0 准确率为:64.1%

- 固定 t=10 准确率为:64.5%

- 固定 t=20 准确率为:64.1%

- 固定 t=40 准确率为:63.3%

- 固定 t=80 准确率为:62.2%

我们注意到, t 值决定了(i)模型权重,它们在 t 条件下训练,以及(ii)在迁移学习中添加的噪声层级,使用相同 t。在所有实验中,我们使用 t = 10 和干净输入,除了表4,我们使用最佳设置。

固定 t 还意味着条件化网络的一部分(时间步为输入的 MLP 层)在迁移学习中并未暴露出来,因为它们可能在固定 t 的情况下合并。因此,我们的模型参数数量与标准 ViT 相似,如 Tab. 4 所报告。

DiT-L 在参数上有 24 层,其中前 12 层称为“编码器”(即 ViT-12L),其余部分称为“解码器”。编码器和解码器的这种分隔是人工的。表5 显示了使用不同编码器层数的线性探测结果,所有模型均基于相同预训练模型:

- 编码器层数 9 准确率:58.5%

- 编码器层数 10 准确率:62.0%

- 编码器层数 11 准确率:64.1%

- 编码器层数 12 准确率:64.5%

- 编码器层数 13 准确率:63.6%

- 编码器层数 14 准确率:61.9%

- 编码器层数 15 准确率:59.7%

最佳准确度是在编码器和解码器具有相同深度时取得的。这种行为与 MAE 的表现不同,后者的编码器和解码器是非对称的。

附录 B:微调结果

除了线性探测外,我们还报告了端到端的微调结果。我们密切遵循 MAE 的协议。我们使用 256×256 尺寸的干净图像作为编码器的输入。全局平均池化的输出用于分类。训练批大小为 1024,初始学习率为 4×10^-3,权值衰减为 0.05,drop path 为 0.1,训练时长为 100 个 epochs。我们使用层级学习率衰减(ViT-B 为 0.85,ViT-L 为 0.65)。使用 MixUp、CutMix、RandAug(9, 0.5)和移动平均(0.9999),与 MAE 相似。以下是结果摘要:

- 方法: ViT-B ViT-L

- MoCo v3: 83.2% 84.1%

- MAE: 83.6% 85.9%

- l-DAE: 83.7% 84.7%

总的来说,两种基于自编码器的方法均优于 MoCo v3。l-DAE 在 ViT-B 上与 MAE 表现相当,但在 ViT-L 上仍落后 MAE。

4936

4936

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?