CNN是?

卷积神经网络(CNN),是一类包含卷积计算且具有深度结构前馈神经网络,是深度学习(deep learning)的代表算法之一。

CNN的结构

从输入到输出,数据一般经历了卷积层、激活层、池化层、全连接层。

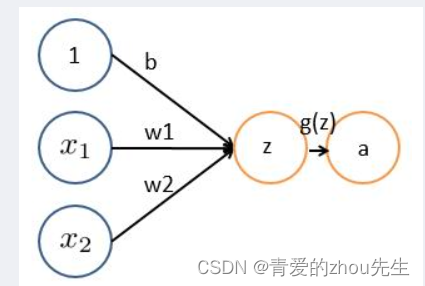

上图(图1)为最简单的神经网络结构

x1,x2,1这一层为输入层,w1,w2,b为权重和偏置(bias)同时卷积层就是这一层,输入的数据经过权重的过滤,得到z,z再经过激活函数处理得到a。一般情况下池化层加在激活函数之后,全连接层在输出之前,也就是在给g(z)之后加全连接层,然后得到输出。

详细介绍

下面详细介绍一下卷积层、激活层、池化层、全连接层是如何操作的

卷积层

首先,在最简单的线性回归中,直接相乘求和

比如图1:z = x1w1+x2w2+b

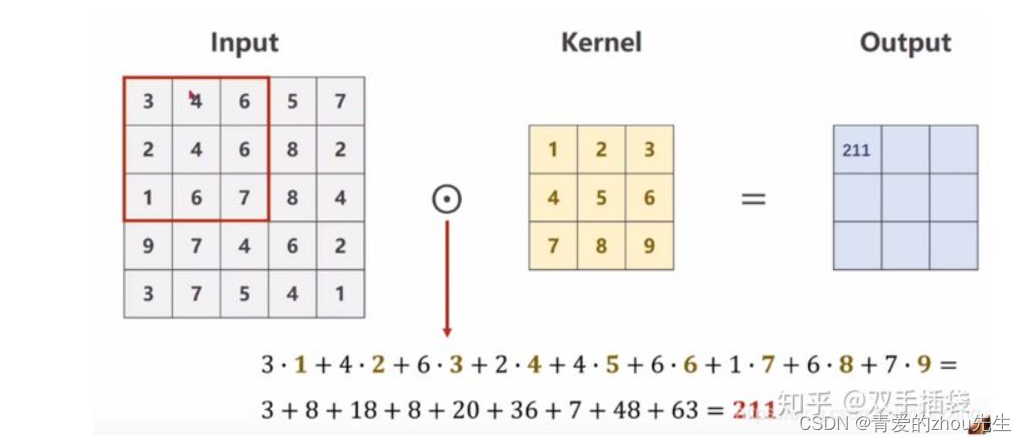

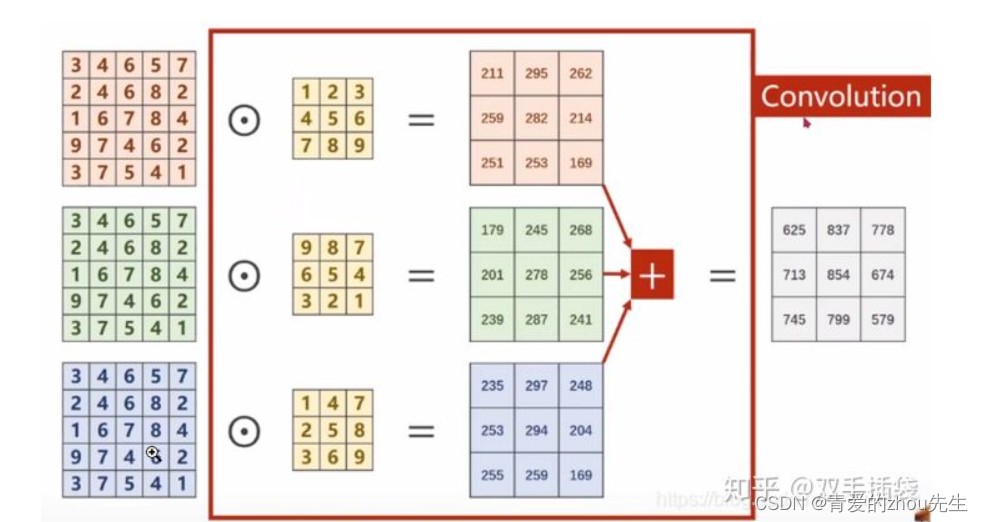

其次,如果输入的数据是图片(要么是一个通道,要么是三个通道),其本质就是一个二维数组(对应一个通道),或三个二维数组(对应三个通道),我们采用如下方式卷积:

单通道:

三通道:

卷积层相关的参数:

filter = 卷积核(1x1,3x3,5x5)

feature map = 卷积之后得到的输出结果

weight/height:卷积核大小

in_channel: 等于输入图片的通道数(这个是可以根据自己的需要来设置的)

out_channel: 等于输出通道数

padding:填充值,在输入特征图的每一边添加一定数目的行列,使得输出的特征图的长、宽 = 输入的特征图的长、宽

stride:步长,卷积核经过输入特征图的采样间隔

激活层

通过卷积核的过滤的数据,还要经过激活函数的处理。

引入激活函数是为了增加神经网络模型的非线性。

常用的激活函数

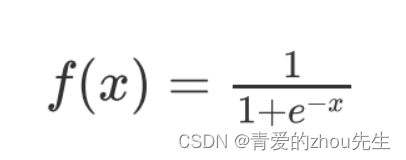

1、sigmoid 激活函数

函数的定义为:

值域为(0,1)

特定:

它能够把输入的连续实值变换为0和1之间的输出,特别的,如果是非常大的负数,那么输出就是0;如果是非常大的正数,输出就是1.

缺点:

在深度神经网络中梯度反向传递时导致梯度爆炸和梯度消失,其中梯度爆炸发生的概率非常小,而梯度消失发生的概率比较大

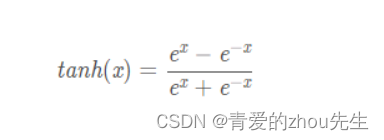

2、tanh函数

函数的定义为:

值域为(-1,1)

特点:

解决了Sigmoid的输出不关于零点对称的问题

也具有Sigmoid的优点平滑,容易求导

缺点:

激活函数运算量大(包含幂的运算)

Tanh的导数图像虽然最大之变大,使得梯度消失的问题得到一定的缓解,但是不能根本解决这个问题

3、relu函数

函数的定义为:

f(x)=max(0,x),值阈[0,+∞]

特点:

1、相比起Sigmoid和tanh,ReLU在SGD中能够快速收敛,这是因为它线性(linear)、非饱和(non-saturating)的形式。

2.Sigmoid和tanh涉及了很多很expensive的操作(比如指数),ReLU可以更加简单的实现。

3.有效缓解了梯度消失的问题。

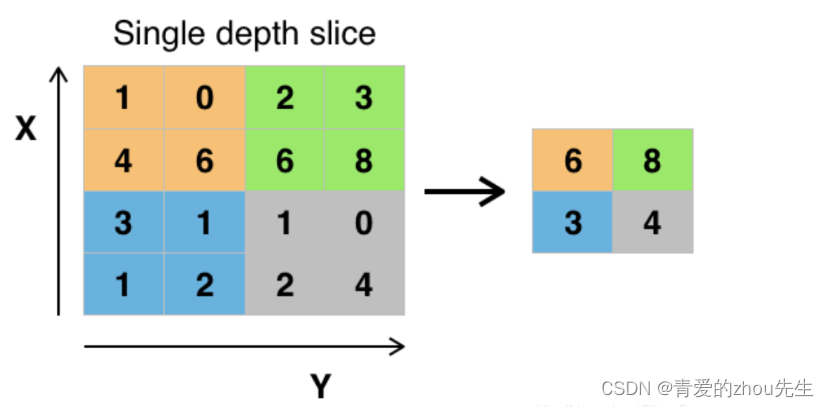

池化层

它实际上是一种形式的降采样。有多种不同形式的非线性池化函数,而其中“最大池化(Max pooling)”是最为常见的。它是将输入的图像划分为若干个矩形区域,对每个子区域输出最大值。直觉上,这种机制能够有效地原因在于,在发现一个特征之后,它的精确位置远不及它和其他特征的相对位置的关系重要。池化层会不断地减小数据的空间大小,因此参数的数量和计算量也会下降,这在一定程度上也控制了过拟合。通常来说,CNN的卷积层之间都会周期性地插入池化层。

常见的有最大池化、平均池化

最大池化:

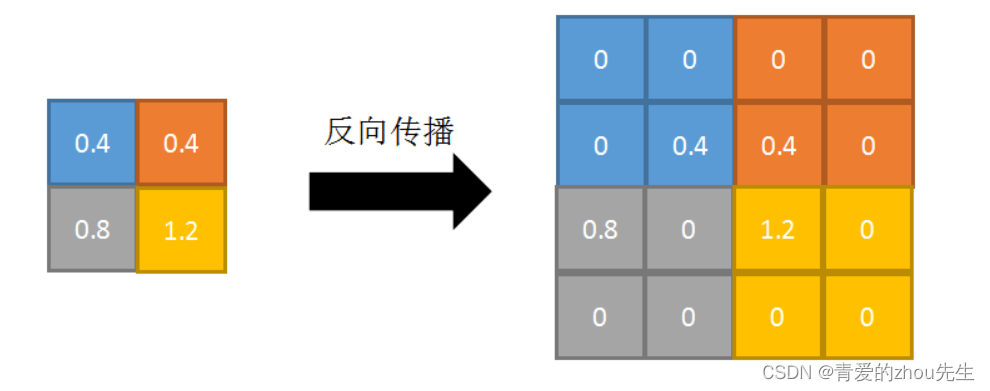

反向传播:

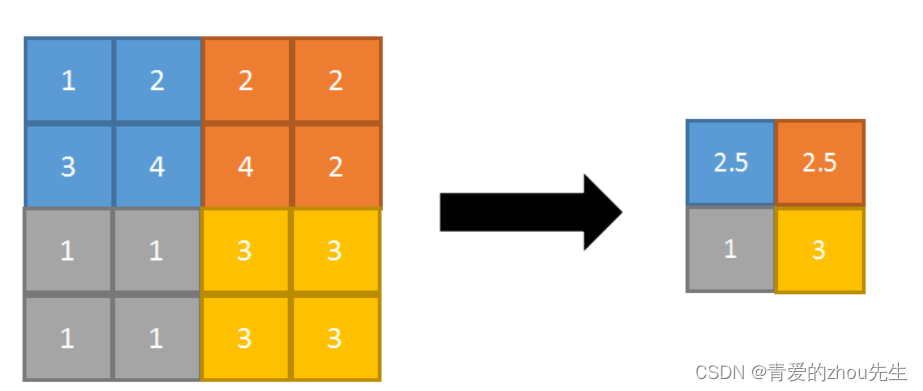

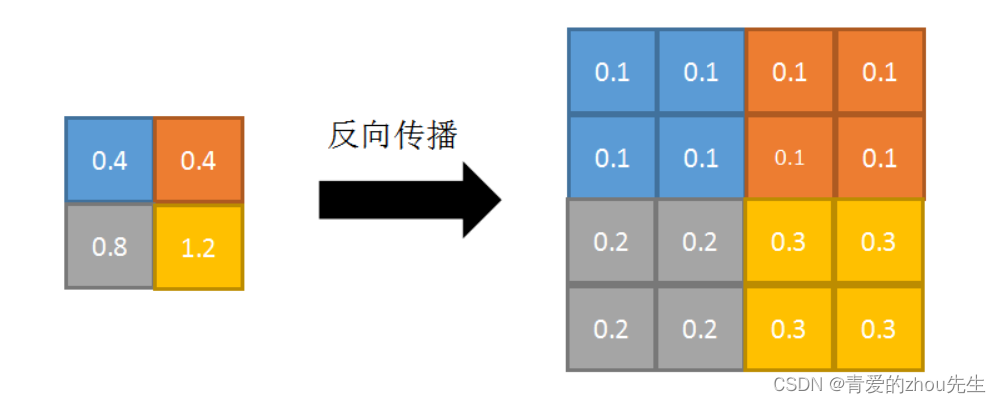

平均池化:

反向传播:

全连接层

全连接层一般会放在网络的最后,作用是用来综合所有信息。对于cnn它提取特征的范围是全图的,直接把图像降维成一堆序列。

卷积层是一种局部连接,它所能提取的特征的范围,取决于卷积核的感受野,当卷积核感受野覆盖到全图的时候,它的作用就和全连接层类似了。(所以用和特征图尺寸一样大小的卷积核做卷积,提取全图范围特征,和接全连接层,计算过程是等效的,输入输出,参数量完全一样)

简单来说,就是数据经卷积、池化等操作后,把数据拉伸变成一维,然后再进行卷积操作,得到分类结果,输出概率最大的那一个。

参考文章:

链接:https://blog.csdn.net/Chen_Swan/article/details/105486854

链接:https://blog.csdn.net/hhhhhhhhhhwwwwwwwwww/article/details/116863273

链接:https://blog.csdn.net/qq_42740834/article/details/123757816

4万+

4万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?