VGGNet

首先,vggnet相比于alexnet的一个明显改进就是采用连续的几个33卷积核代替alexnet中较大的卷积核。(因为这样参数更少)

比如:在vgg中,采用3个33的卷积核(参数总量为 3x(9xC^2))代替一个77的卷积核(其参数总量为(49(C的平方)),用2个33的卷积核代替一个55的卷积核。

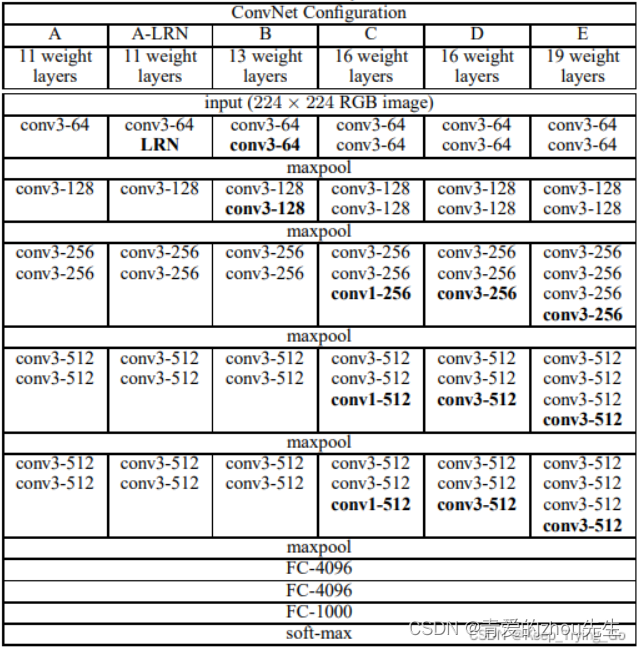

各个网络的配置如下:

参考文章:https://blog.csdn.net/Keep_Trying_Go/article/details/123943751

ResNet

resnet特点:

1、超级深的网络结构(超过1000层);

2、提出residual(残差结构)模块;

3、使用batch normalization加速训练(丢弃dropout)。

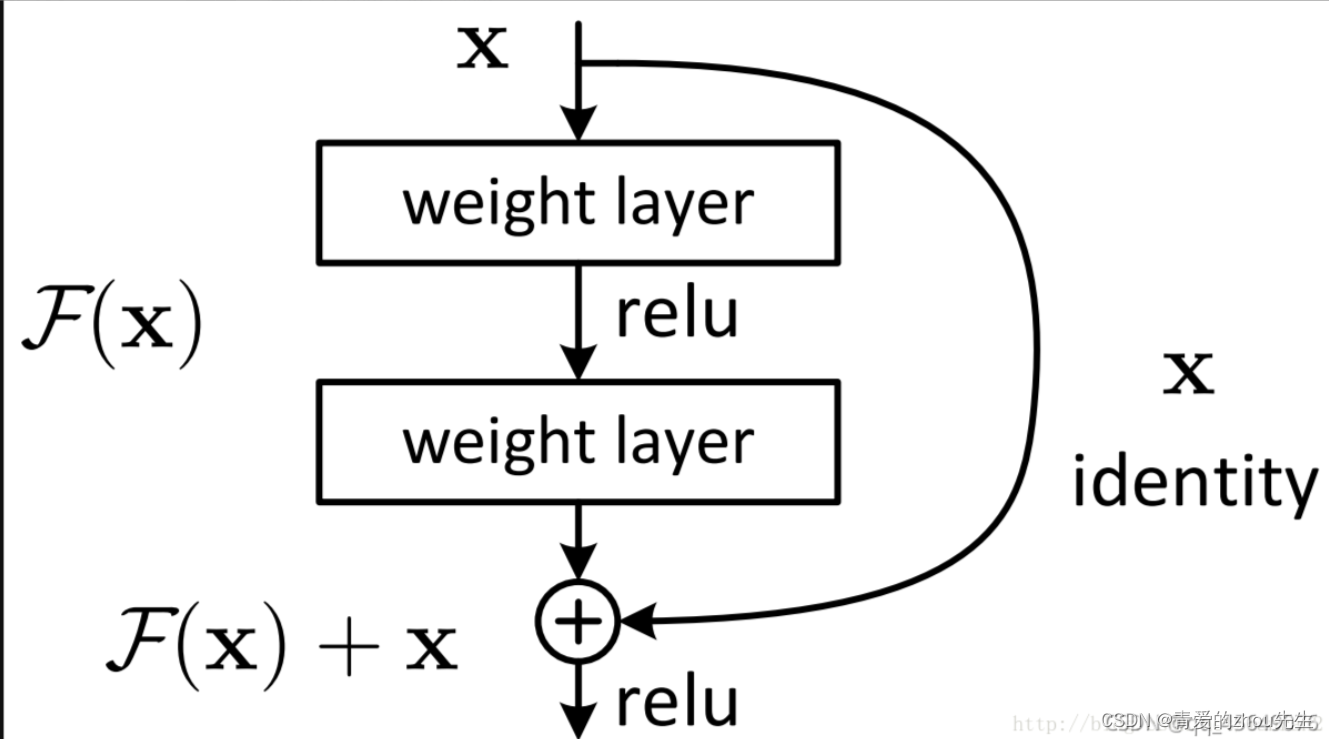

什么是residual:

为了解决深层网络中的退化问题,可以人为地让神经网络某些层跳过下一层神经元的连接,隔层相连,弱化每层之间的强联系。这种具有residual结构的神经网络被称为 残差网络 (ResNets)。

residual结构

residual结构使用了一种shortcut的连接方式,也可理解为捷径。让特征矩阵隔层相加,注意F(X)和X形状要相同,所谓相加是特征矩阵相同位置上的数字进行相加

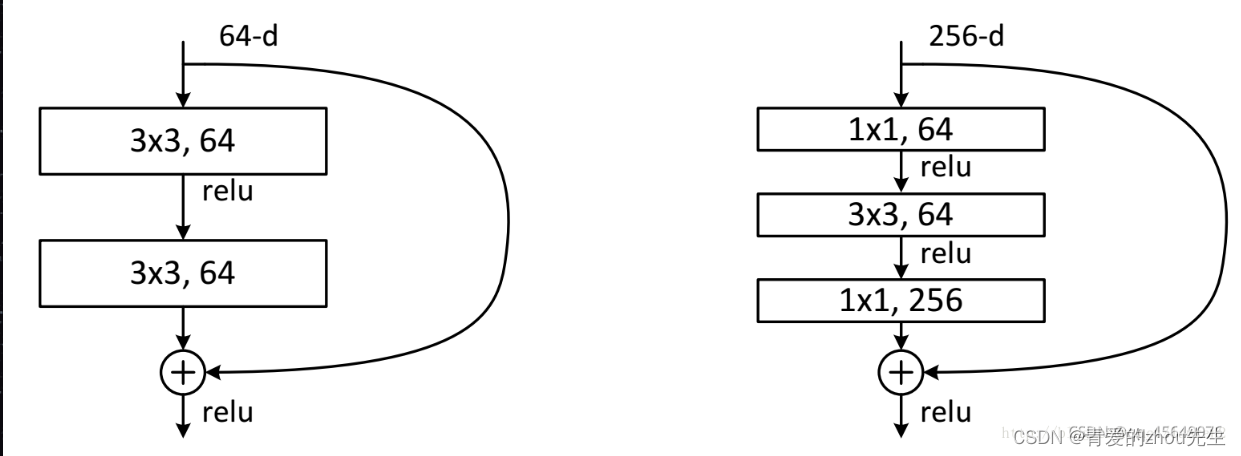

ResNet中两种不同的residual

左侧残差结构称为 BasicBlock

右侧残差结构称为 Bottleneck

Bottleneck,其中第一层的1× 1的卷积核的作用是对特征矩阵进行降维操作,将特征矩阵的深度由256降为64;

第三层的1× 1的卷积核是对特征矩阵进行升维操作,将特征矩阵的深度由64升成256。

降低特征矩阵的深度主要是为了减少参数的个数。

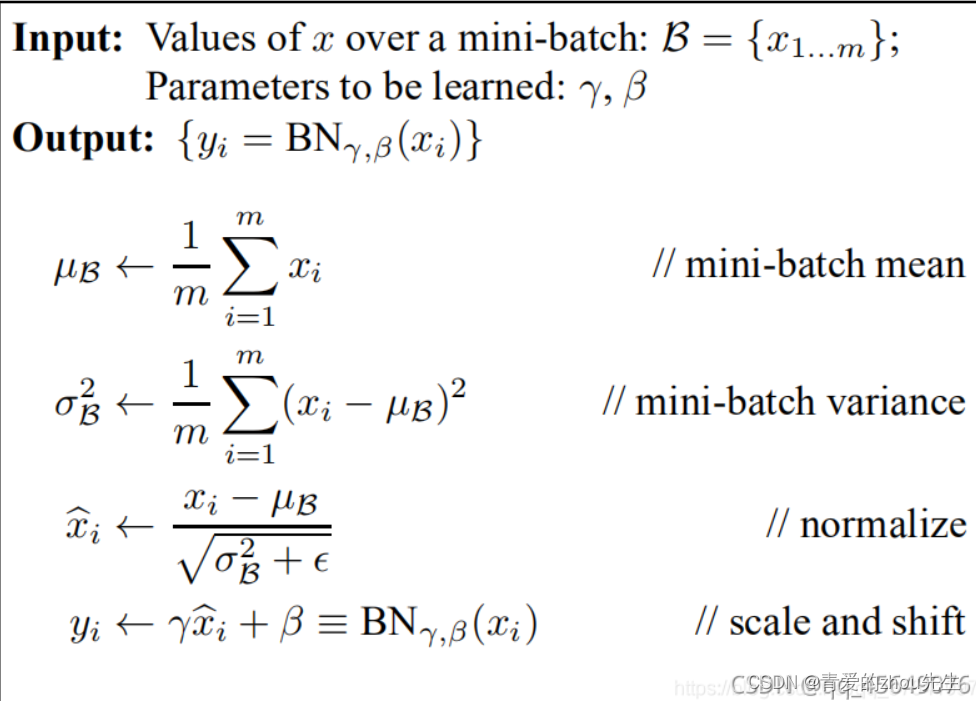

Batch Normalization

Batch Normalization是指批标准化处理,将一批数据的feature map满足均值为0,方差为1的分布规律。

InceptionNet

特点:

1、通过设置多种卷积核尺寸来兼顾宏观细节特征的提取;

2、使用 1 × \times× 1 的卷积核进行降维以及映射处理;

3、添加两个辅助分类器帮助训练,确保了即便是隐藏单元和中间层也参与了特征计算,在Inception网络中起到一种调整的效果并且能防止网络发生过拟合;

4、丢弃全连接层,使用平均池化层,以大大减少模型参数。

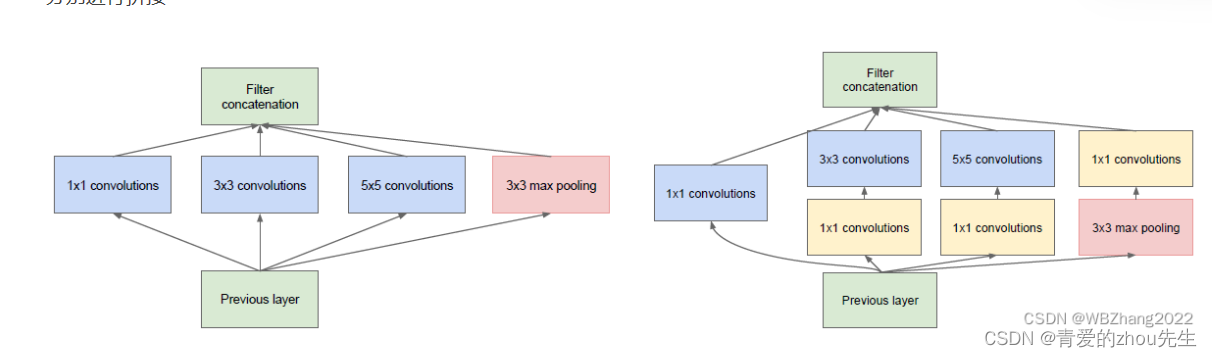

下面是两种Inception模块内部的两种基本结构(每个分支所得的特征矩阵高和宽必须相同):

参考文章:https://blog.csdn.net/weixin_44944722/article/details/126662882

MobileNet

MobileNet模型是基于深度可分离卷积

本质是一个深度卷积和一个称为逐点卷积的1*1的卷积(这种分解可有效的减少计算量和模型的大小)

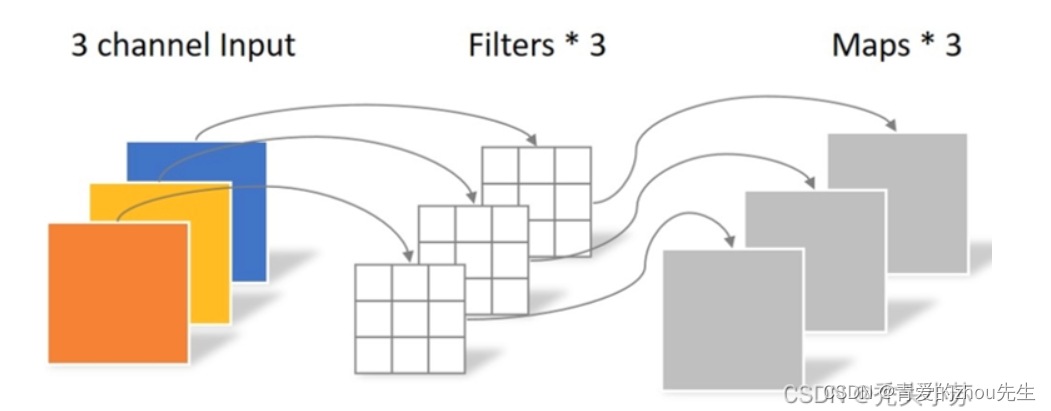

深度卷积

深度卷积与标准卷积的区别在于深度卷积的卷积核为单通道模式,需要对输入的每一个通道进行卷积,这样就会得到和输入特征图通道数一致的输出特征图。通过下图进行理解:可以看出,我们输入特征图的通道上为3,由于采用的卷积核是单通道模式,所以必须要三个这样的单通道卷积核才可以和输入图像完全一一对应的卷积,这样就得到了输出的特征图,输出特征图的个数为3。可以发现深度卷积的输入特征图通道数=卷积核个数=输出特征图个数。

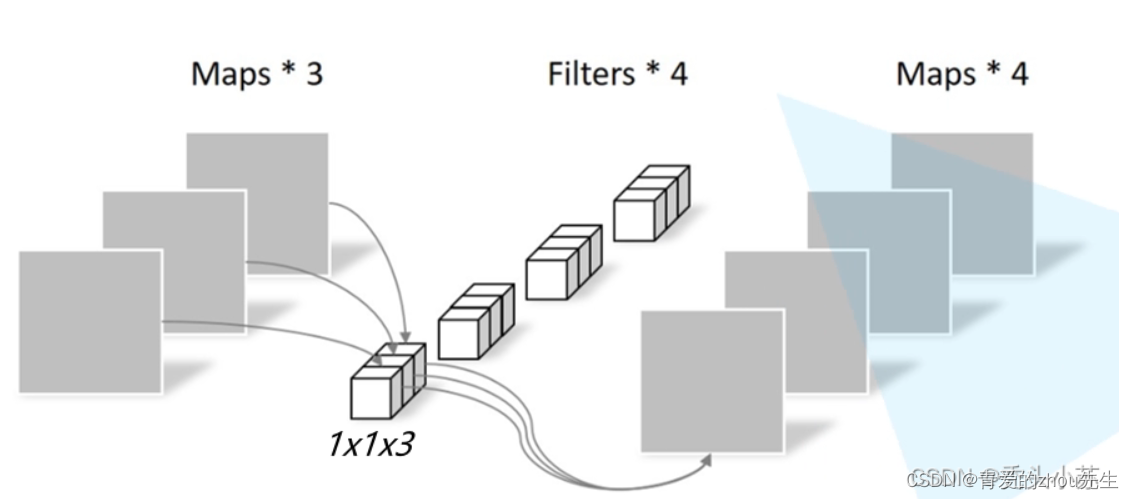

逐点卷积

实质就是用1x1的卷积核进行升维

比如:有三个特征图(或者说是一个拥有三个通道的特征图),卷积核大小为113,卷积核个数为4,这样卷积后就可以得到4个特征图。

参考文章:https://blog.csdn.net/qq_47233366/article/details/123029998

4636

4636

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?