介绍如何在本地运行Llama 3模型。

目前,本地部署大型语言模型(LLMs)正流行起来,主要是因为LLMs能更好地保障数据安全、保护隐私,并让用户灵活控制模型输出。

Llama 3系列是Meta AI打造的新一代大型语言模型。这款模型不仅开源,融入了前沿的AI技术,而且在响应生成的效率和精准度上,相较于前代的Gemma、Gemini以及Claud 3模型,都取得了突破性的进步。

本文是个简单的小教程,介绍如何下载并运用Llama 3模型。

1 什么是Ollama

Ollama是一款开源工具,专为在本地计算机上运行像Llama 3这样的大型语言模型而设计。随着AI技术的进步,现代的大型语言模型已经摆脱了对庞大虚拟内存、计算资源和存储空间的依赖,转而优化以适应笔记本电脑等更轻便的设备。

在众多支持本地部署大型语言模型的工具和框架中,Ollama的设置流程和使用最为简单。用户可以直接通过终端或Powershell快速启用LLMs,无需复杂配置即可立即投入应用。

Ollama的最大优势在于其强大的兼容性和集成能力。例如,开发者可以在Visual Studio Code(VScode)中安装CodeGPT插件,并将Ollama与之相连,从而把Llama 3模型作为AI编程助手,直接嵌入到日常的代码编写工作中。

2 安装Ollama

访问GitHub仓库Ollama/ollama(https://github.com/ollama/ollama),滚动页面选择与操作系统相匹配的下载链接来安装Ollama。

安装完成后,Ollama的图标将出现在系统任务栏的图标区中,方便随时调用和管理。

3 下载和使用Llama 3

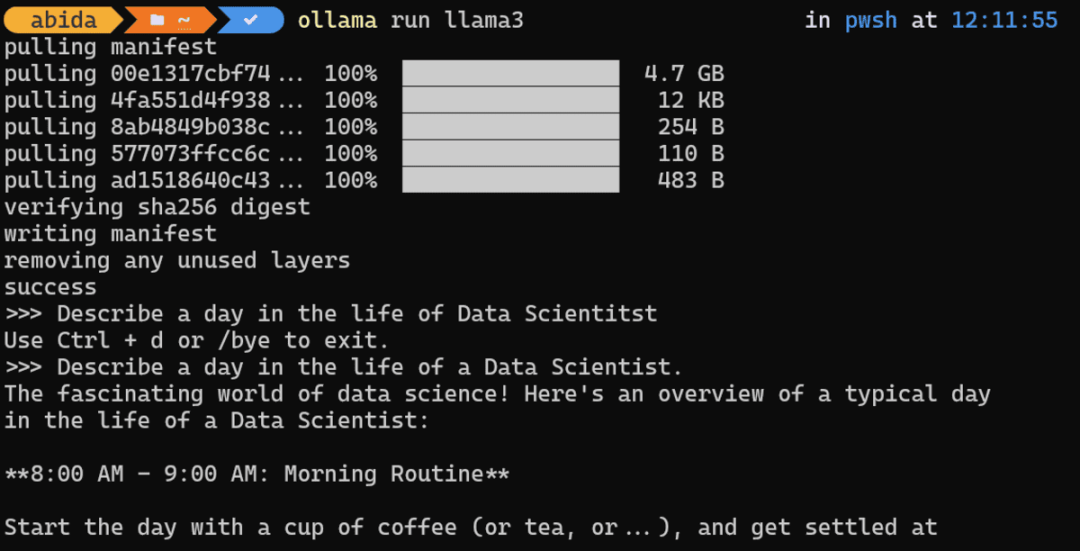

下载并启用Llama 3模型,需要在终端或命令行中输入以下命令:

ollama run llama3

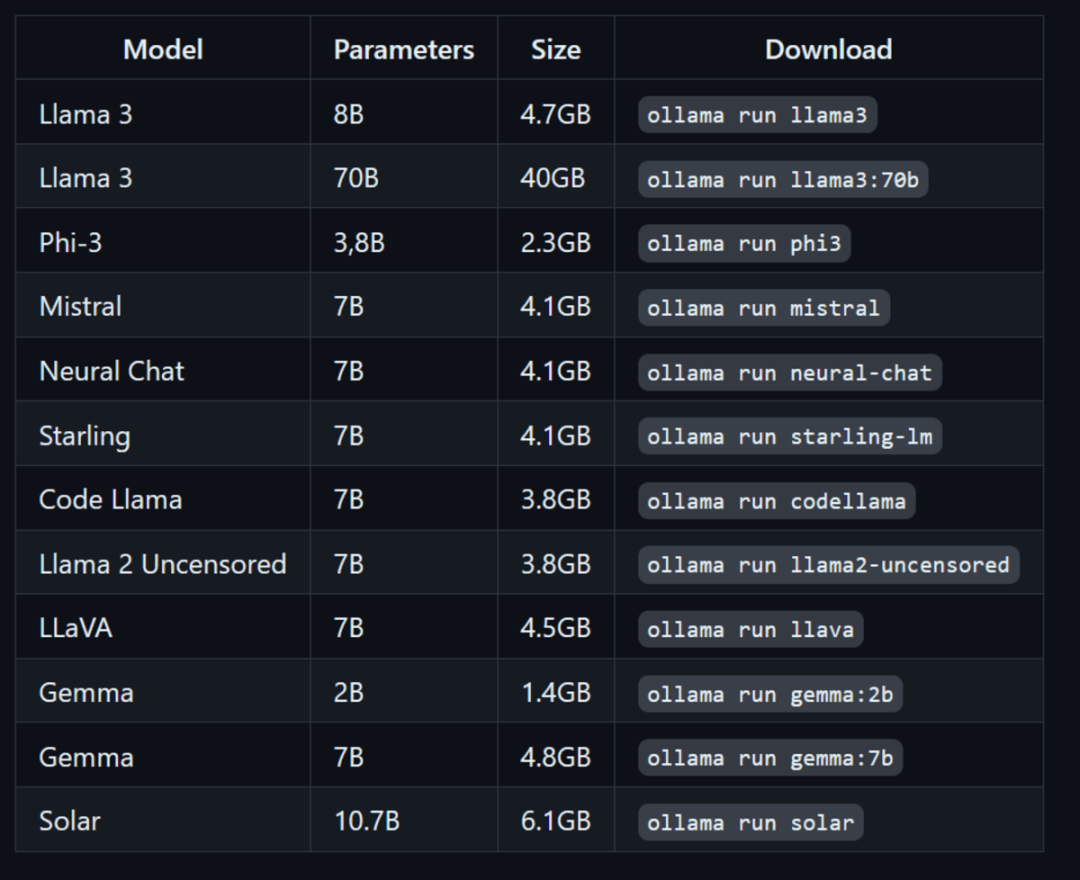

除了Llama 3模型,还可以通过输入以下命令安装其他LLMs。

使用 Ollama 运行其他 LLM

下载完成后,就可以在本地使用Llama 3了,体验与在线使用一样的便捷。

提示(Prompt):“Describe a day in the life of a Data Scientist.”

为了展示Llama 3响应生成的速度有多快,这里附上了GIF动图,演示了Ollama如何迅速生成并解释Python代码。

小贴士:如果笔记本电脑配备了Nvidia GPU并且已经安装了CUDA,Ollama会自动利用GPU加速,相比CPU,响应速度可提升至10倍。

提示(Prompt):“Write a Python code for building the digital clock.”

可以通过输入/bye退出当前会话。若要再次启动Llama 3,可重新输入命令ollama run llama3即可。

4 结语

开源框架和模型的推出,让AI和大型语言模型(LLMs)变得触手可及。借助像Ollama这样的本地运行工具,AI技术不再是少数公司的专利,拥有笔记本电脑的每个用户都能够轻松使用。

本地部署LLMs不仅能够提供更好的隐私保护和安全性,还支持用户对响应生成进行更精细的控制。用户还可以创建个性化的AI编码助手,在Visual Studio Code(VSCode)这样的集成开发环境中使用,提升编程效率。

推荐书单

《Llama大模型实践指南》

本书共包括7章,涵盖了从基础理论到实际应用的全方位内容。第1章深入探讨了大模型的基础理论。第2章和第3章专注于Llama 2大模型的部署和微调,提供了一系列实用的代码示例、案例分析和最佳实践。第4章介绍了多轮对话难题,这是许多大模型开发者和研究人员面临的一大挑战。第5章探讨了如何基于Llama 2定制行业大模型,以满足特定业务需求。第6章介绍了如何利用Llama 2和LangChain构建高效的文档问答模型。第7章展示了多语言大模型的技术细节和应用场景。本书既适合刚入门的学生和研究人员阅读,也适合有多年研究经验的专家和工程师阅读。通过阅读本书,读者不仅能掌握Llama 2大模型的核心概念和技术,还能学会如何将这些知识应用于实际问题,从而在这一快速发展的领域中取得优势。

👉AI大模型学习路线汇总👈

大模型学习路线图,整体分为7个大的阶段:(全套教程文末领取哈)

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉大模型实战案例👈

光学理论是没用的,要学会跟着一起做,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

👉大模型视频和PDF合集👈

观看零基础学习书籍和视频,看书籍和视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

1466

1466

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?