Abstract

文档中的多个实体通常表现出复杂的句子间关系,现有的关系提取方法通常侧重于提取单个实体对的句子内关系,无法很好地处理这些关系。为了加速文档级RE的研究,我们引入了一个基于维基百科和维基数据构建的新数据集DocRED,它具有以下三个特征:(1)DocRED对命名实体和关系都进行了标注,是目前最大的纯文本文档级RE人工标注数据集;(2) DocRED要求阅读文档中的多个句子,通过综合文档的所有信息提取实体并推断它们之间的关系;(3)除了人工标注的数据外,我们还提供了大规模的远程监督数据,这使得DocRED既可以用于监督场景,也可以用于弱监督场景。为了验证文档级RE的挑战,我们实施了最新的最先进的RE方法,并在DocRED上对这些方法进行了彻底的评估。实证结果表明,DocRED对现有的RE方法提出了挑战,这表明文档级RE仍然是一个悬而未决的问题,需要进一步努力。在对实验结果进行详细分析的基础上,讨论了今后的研究方向。我们在https: //github.com/thunlp/DocRED公开提供DocRED和基线代码。

1 Introduction

关系抽取(RE)的任务是从纯文本中识别实体之间的关系事实,在大规模知识图谱的构建中起着重要作用。大多数现有的RE工作集中在句子级RE,即从单个句子中提取关系事实。近年来,人们探索了各种神经模型来编码句子级RE的实体关系模式,并实现了最先进的性能(Socher et al., 2012;Zeng et al.,2014, 2015;dos Santos等人,2015;肖和刘,2016;Cai et al., 2016;Lin et al., 2016;Wu et al.,2017;秦等人,2018;Han等人,2018a)

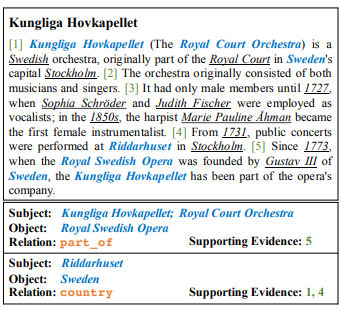

图1:来自DocRED的一个例子。DocRED中的每个文档都有命名实体提及、共同参考信息、句子内和句子间关系以及支持证据的注释。为本示例文档注释的19个关系实例中有2个被显示,这些实例中涉及的命名实体以蓝色表示,其他命名实体以下划线表示。注意,提到的相同主题(例如,Kungliga Hovkapellet和Royal Court Orchestra)在第一个关系实例中被识别出来。

尽管这些努力取得了成功,但句子级RE在实践中不可避免地受到限制:大量的关系事实在多个句子中表达。以图1为例,文档中提到了多个实体,并展示了复杂的交互。[c] .中国科学院学报(自然科学版);为了确定关系事实(Riddarhuset, country, Sweden),我们必须首先从第4句中确定Riddarhuset位于斯德哥尔摩的事实,然后从第1句中确定斯德哥尔摩是瑞典的首都和瑞典是一个国家的事实,最后从这些事实推断出Riddarhuset的主权国家是瑞典。该过程需要对文档中的多个句子进行阅读和推理,这在直观上超出了句子级正则方法的范围。根据我们从维基百科文档中抽取的人工注释语料库的统计,至少有40.7%的关系事实只能从多个句子中提取出来,这是不容忽视的。Swampillai和Stevenson(2010)以及Verga等人(2018)也报告了类似的观察结果。因此,有必要将RE从句子级提升到文档级。

文档级正则化的研究需要一个大规模的标注数据集来进行训练和评估。目前,文档级RE的数据集很少。Quirk和Poon(2017)以及Peng等人(2017)构建了两个远程监督的数据集,没有人工注释,这可能会使评估的可靠性降低。BC5CDR (Li et al., 2016)是一个由1500篇PubMed文档组成的人工注释文档级RE数据集,它属于生物医学的特定领域,仅考虑“化学诱导疾病”关系,因此不适合开发文档级RE的通用方法。Levy et al.(2017)通过使用阅读理解方法回答问题从文档中提取关系事实,其中问题从实体关系对转换。由于本工作中提出的数据集是针对特定方法量身定制的,因此它也不适合用于文档级RE的其他潜在方法。总之,文档级RE的现有数据集要么只有少量手动注释的关系和实体,要么显示来自远程监督的噪声注释,要么服务于特定领域或方法。为了加快文档级RE的研究,我们迫切需要一个大规模的、人工标注的、通用的文档级RE数据集。

在本文中,我们提出了DocRED,这是一个基于维基百科和维基数据构建的大规模人工注释文档级RE数据集(Erxleben et al., 2014;vandeci [c] and Kr ' otzsch, 2014)。DocRED具有以下三个特征:(1)DocRED包含在5053个维基百科文档上标注的132,375个实体和56,354个关系事实,使其成为最大的人工标注文档级RE数据集。(2)由于DocRED中至少有40.7%的关系事实只能从多个句子中提取,因此DocRED需要阅读文档中的多个句子来识别实体,并通过综合文档的所有信息来推断它们之间的关系。这将DocRED与那些句子级RE数据集区分开来。(3)我们还提供了大规模的远程监督数据来支持弱监督的RE研究。

为了评估DocRED的挑战,我们采用了最新的最先进的RE方法,并在不同的设置下对DocRED进行了彻底的实验。实验结果表明,现有方法在DocRED上的性能明显下降,说明任务文档级RE比句子级RE更具挑战性,仍然是一个有待解决的问题。此外,对结果的详细分析也揭示了许多值得追求的有希望的方向。

2 Data Collection

我们的最终目标是从纯文本构建文档级正则的数据集,这需要必要的信息,包括命名实体提及、实体共同引用和文档中所有实体对的关系。为了方便更多的RE设置,我们还为关系实例提供了支持性证据信息。在接下来的章节中,我们首先介绍了人工标注数据的收集过程,然后描述了大规模远程监督数据的创建过程。

2.1 Human-Annotated Data Collection

文章提出了DocRED,一个基于维基百科和维基数据的大规模人工注释文档级关系抽取数据集,用于推动从句子级到文档级的关系抽取研究。DocRED包含复杂的句子间关系,需要多句子阅读和推理,是目前最大的纯文本文档级关系抽取人工标注数据集。此外,文章还提供了大规模的远程监督数据,以支持弱监督场景。实验表明,DocRED对现有方法提出了挑战,表明文档级关系抽取仍然是一个待解决的问题。

文章提出了DocRED,一个基于维基百科和维基数据的大规模人工注释文档级关系抽取数据集,用于推动从句子级到文档级的关系抽取研究。DocRED包含复杂的句子间关系,需要多句子阅读和推理,是目前最大的纯文本文档级关系抽取人工标注数据集。此外,文章还提供了大规模的远程监督数据,以支持弱监督场景。实验表明,DocRED对现有方法提出了挑战,表明文档级关系抽取仍然是一个待解决的问题。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1878

1878

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?