Explainable/Interpretable ML

两种类型

- Local Explanation

Why do you think this image is a cat? - Global Explanation

What do you think a “cat” looks like?

Point of Explainable ML

- 解释Ml的目的并不是完全的知道Ml model 的工作原理

- 人类的大脑同样是一个黑盒子

- 不相信训练网络因为它是黑盒子, 但是人们相信人类的判断

- ML Explanation的目标是让你觉得理解, 对不同的人有不同的解释

Interpretable v.s. Powerful

- 一些模型是容易被解释的,

- 例如,linear model 从权重可以知道feature的重要性

- 深度学习不容易被解释

- 黑盒子

- 但是比linear model 更加powerful

- desision tree

- 可以被解释, 同时powerful?

- 然而很多时候,tree是很复杂的, 我们用的是forest, 无法完全解释它。

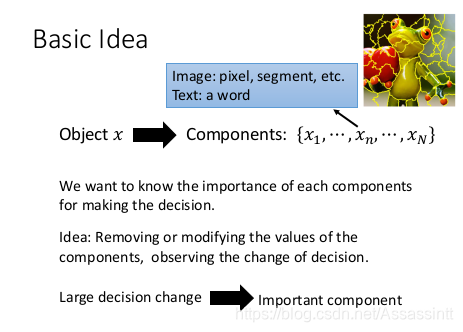

Local Explanation

components 拿掉或者改动, 这个coponents 对结果的改变影响很大, 这就是重要的component

|  |

|---|---|

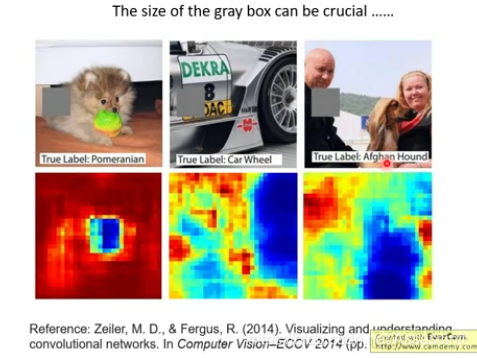

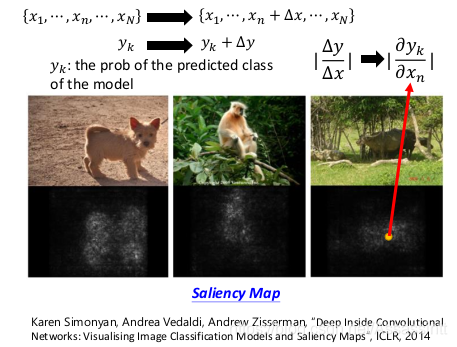

| 移动灰色方块, 灰色放在蓝色部分辨识狗狗几率变小, 红色部分, 机器辨识度高。这方法要小心方块的大小。方块颜色也要选择。 | 画saliency map,通过, 改变x向量,计算gradient, 看哪些grdient 比较大, 计算哪些pixcel 比较重要,每个点的亮度表示,yk对xn的偏微分绝对值 |

|  |

|---|---|

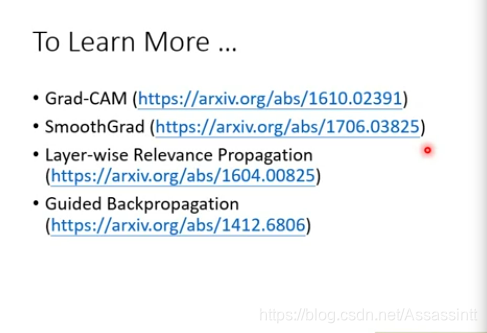

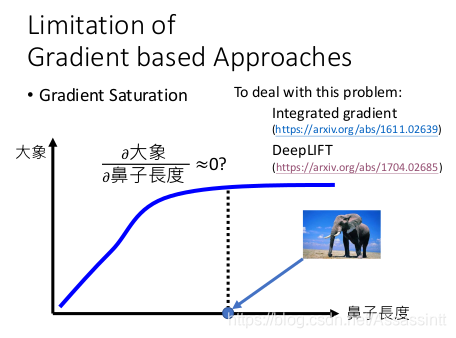

| 其他方法 | gradient 有时会遇到瓶颈, 可以使用右边2种方法。 |

interpretation 同样可以会被attack, 一些杂讯会使saliency变化很大。

Global Explanation

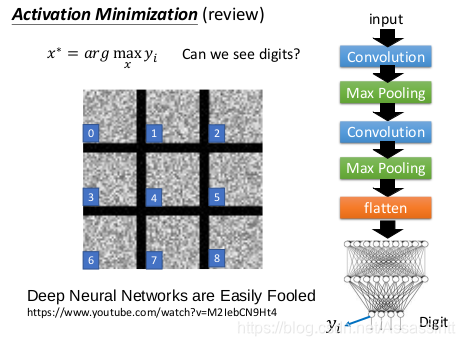

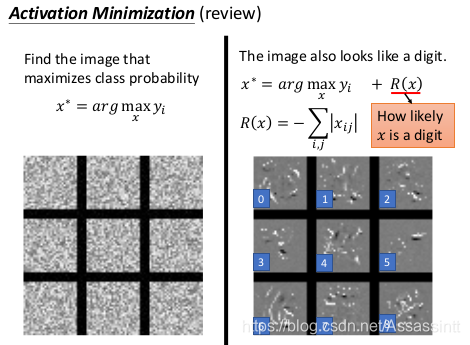

Activation Minimization

手写数字分类的例子

|  |

|---|---|

| 取出模型对应数字的output, 使他yi几率最大, 显示理想的数字图片长什么样子。 | yi 越大越好, 同时图片看起来像数字。 R(x)表示图片看起来多像一个数字。因为多数区域没有数值, 这里R(x)把所有有数值的pixel 加起来。计算通过pixel的强度。 |

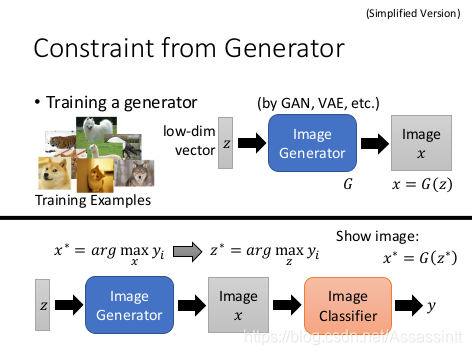

画出心里理想部件的时候, 需要增加很多限制,然后暴调参数

画出心里理想部件的时候, 需要增加很多限制,然后暴调参数

|  |

|---|---|

| 找到一个最好的z, 通过image generator, 产生一个image,图片通过classifier以后,得到的y的一个class 越大越好。 很深的network。 | 可以产生的结果, 心里的蚂蚁,心里的火山,心里的修道院 |

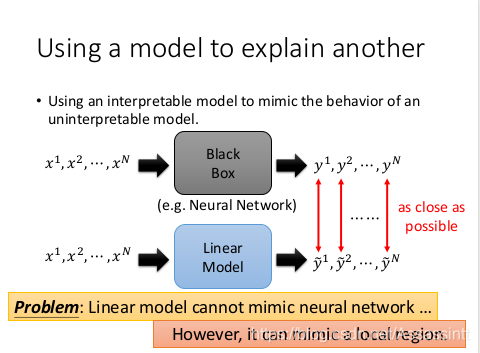

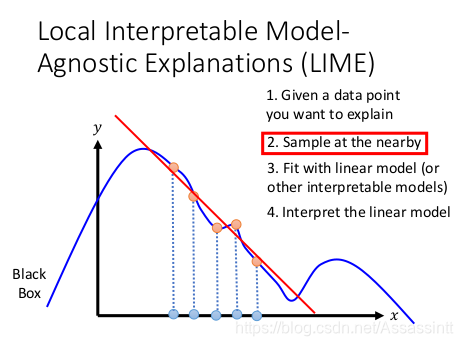

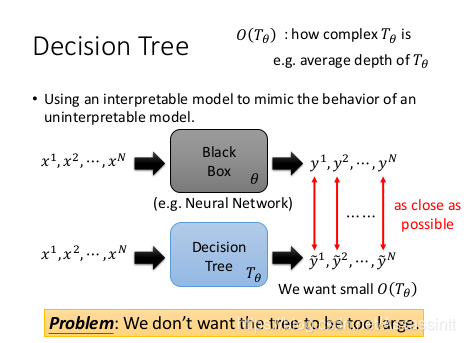

用一种模型解释另外的模型

一些模型很容易被解释, 用容易解释的模型去模仿不易解释的模型

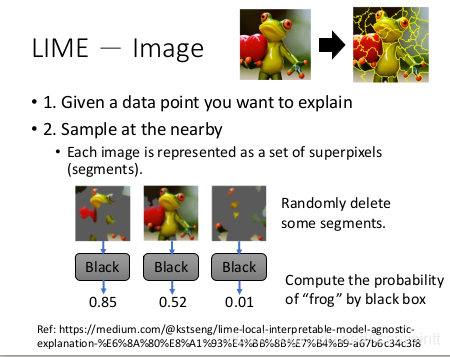

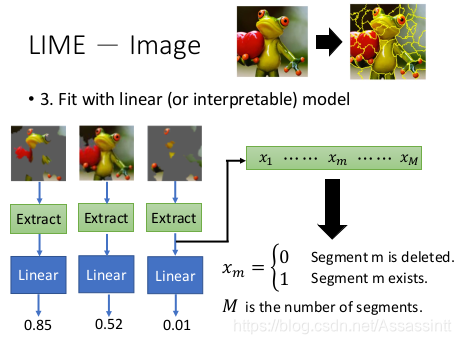

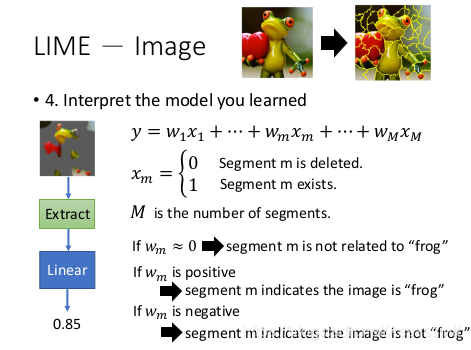

lime

|  |

|---|---|

|  |

查看哪些segment,权重1, 表示对结果影响最大。

|  |

|---|---|

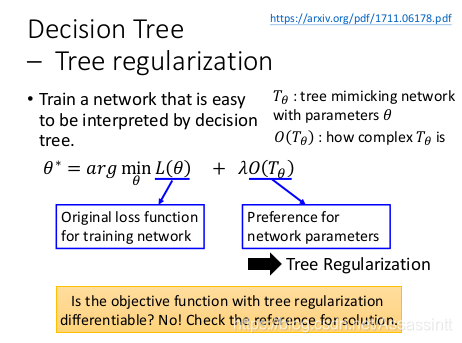

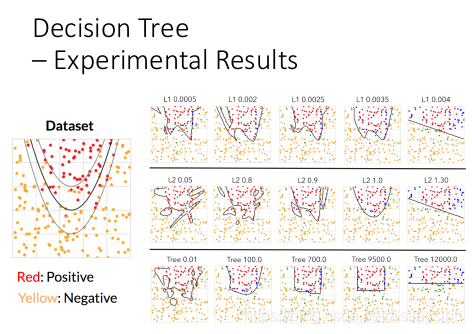

| min Los, decision tree的复杂程度也要越小越好—》 tree regularization。 |

| 怎么微分?train一个network , 给他一个networkb的参数, 可以计算出 networkb 转成decision tree 的深度。 |

1630

1630

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?