Label-Consistent Backdoor Attacks

机器学习基础

i.i.d. 假设

即独立同分布假设。假设未知数据和已有的训练数据集是独立同分布的

损失函数loss function

是将随机事件或其有关随机变量的取值映射为非负实数以表示该随机事件的“风险”或“损失”的函数。在图像识别模型中,它的值越大,代表模型认为该识别结果越不可靠

随机梯度下降SGD

在使得损失函数尽量小的过程中,随机选取一个小的batch计算梯度,可以大大减少计算量。通常来讲,该计算方法中一些不太理想的输入(如被错误分类的输入)会占比较大的权重。

生成式对抗网络GAN

简单来讲包含两个模块:生成模型(Generative Model)和判别模型(Discriminative Model)。生成模型根据已有的数据集,生成新的输入;而判别模型检验输入是否是真实的,即是否由生成模型生成。最终训练完成的生成模型一般可用于生成图片。

潜在空间Latent Space

数据的潜在空间表示包含表示原始数据点所需的所有重要信息,可以简化数据特征的表示。

Backdoor Attack

概述

“By injecting a small number of maliciously constructed inputs into the training set, an adversary is able to plant a backdoor into the trained model.”

“This backdoor can be activated during inference by a backdoor trigger—such as a small pattern in the input—forcing the model to output a specific target label chosen by the adversary.”

攻击方法

standard backdoor attacks

传统的后门攻击是选取一些原有的数据,给它们加上后门的触发信号,打上目标标签,再加入数据集让模型学习。

e.g. 输入A和B原有的标签分别是猫和狗,我们要使含有trigger的图像都被识别成飞机,所以给A和B打上trigger,并把它们的标签改为飞机。

这种方法有明显的缺点,如上例,A和B的标签和它们实际的图像内容不相符,这会导致模型在学习的时候对A和B的损失函数值特别大,这非常容易被筛选出来;而且人类能够轻易分辨出这种攻击。经过实验进一步发现,该方法在污染的数据比例较小时成功率有限。

lable-consitent backdoor attacks

该攻击方法给数据集输入一些数据,这些数据被加上了backdoor trigger,但是它们的图像内容和标签是一致的。

e.g. 我们要使含有trigger的图像都被识别成飞机,所以生成一批含有trigger的图像,它们的内容确和标签都是飞机,但是模型在识别的时候极度依赖该trigger,后续在遇到含有trigger的图像时,无论内容是否为飞机,模型都会将其识别为飞机。

成功的关键点在于图像必须经过处理,使其能够被模型正确识别但非常模糊。这样模型在识别这些被污染的数据时会极其依赖植入的trigger,从而达到攻击者的目的。

生成此类模糊的图片有两种方法:

-

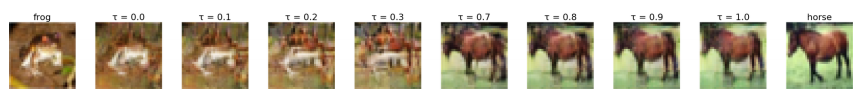

Latent space interpolation潜在空间插值法:x1是目标标签下的某个输入,选取非目标标签下的另一个输入x2,将x1和x2添加到潜在空间中,利用Lp范数计算出最相似的两个向量z1和z2,利用参数 τ \tau τ可以将z1和z2合成为新的x:

x = G ( τ z 1 + ( 1 − τ ) z 2 ) x=G(\tau\!z_1+(1-\tau)z_2) x=G(τz1+(1−τ)z2)

在改变参数 τ \tau τ时,图像呈现出由x1向x2的过渡:

-

Adversarial perturbations敌对干扰法:对于一个原有的输入-标签对,我们可以对它添加一些变化,新的输入xadv满足:

x a d v = a r g m a x ∣ ∣ x ′ − x ∣ ∣ p ≤ ϵ L ( x ′ , y , θ ) x_{adv}=\underset{||x'-x||_p\le \epsilon}{argmax}L(x',y,\theta) xadv=∣∣x′−x∣∣p≤ϵargmaxL(x′,y,θ)

当增大参数 ϵ \epsilon ϵ时,xadv将呈现出更多另一个类别的特征

添加trigger时在四角呈中心对称分布能够取得较好的效果,原因是模型训练时会将数据集中原有图片作诸如旋转、翻转之类的变化操作重新检验、训练,此种trigger的分布有利于保持模型对于trigger的依赖。

实验结果显示:

- 由于对图片做了预处理,攻击成功率显著高于原本的standard backdoor attacks。即模型对trigger依赖度较高

- 上述两种方法中 τ \tau τ和 ϵ \epsilon ϵ的大小需控制在合理范围,过大时模型对该类别的识别完全依赖trigger,导致对不含trigger的图像识别失败

- Adversarial perturbations比Latent space interpolation效果要好。在模型实际工作中,可能会由于图像包含比较明确的特征而忽略trigger的存在;而Adversarial perturbations生成的图像保持了原来一定的特征,训练出的模型即使在其他特征存在的条件下依然对trigger有较高的依赖度。

762

762

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?