运算符

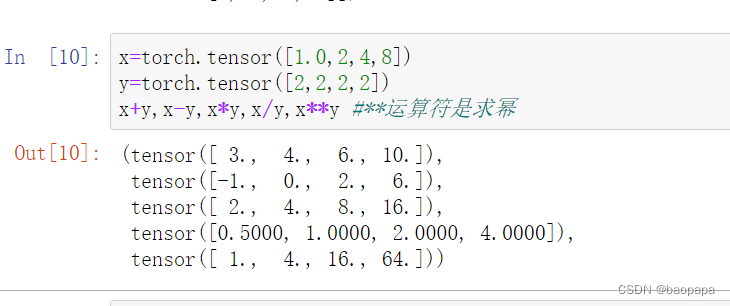

张量的加减乘除:

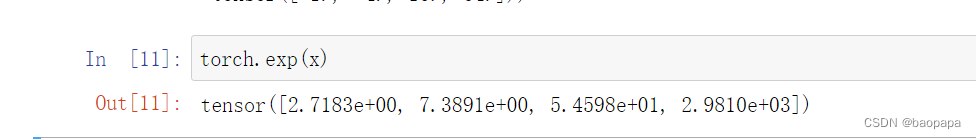

求幂的一元运算符:

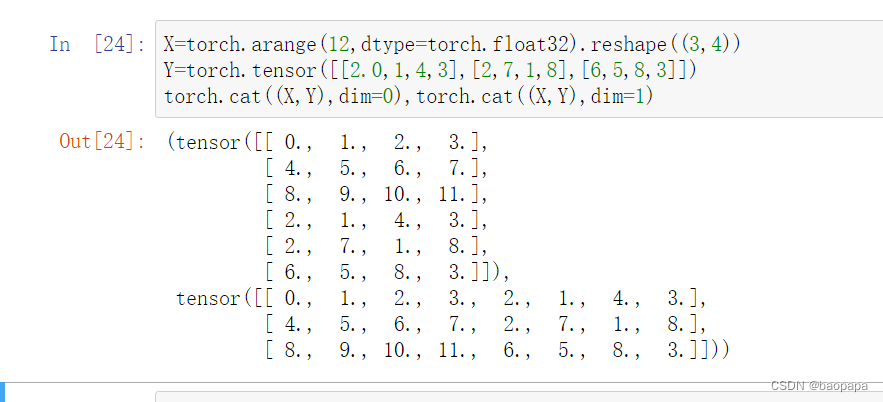

张量连接,沿着0轴连接,就是按行堆起来,沿着1轴,就是按列连起来:

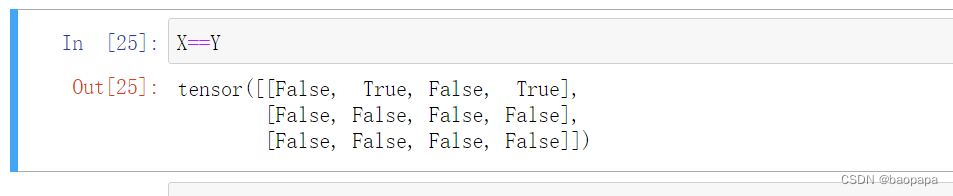

通过逻辑运算符构建二元张量:

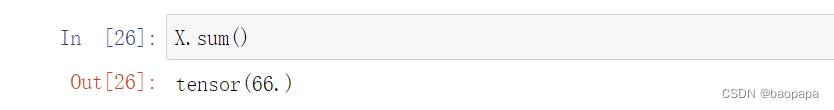

对张量中的所有元素进行求和,会产生一个单元素张量:

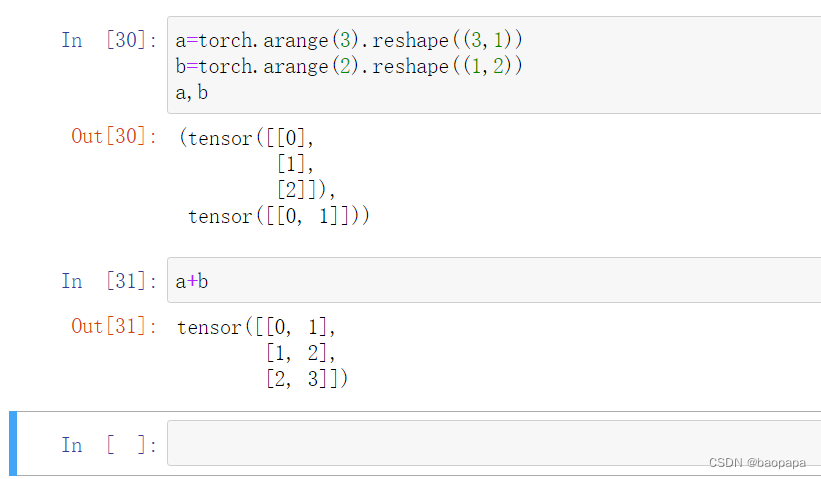

广播机制

用于形状不同的张量执行元素操作,通过适当复制元素来扩展一个或两个数组, 以便在转换之后,两个张量具有相同的形状,a和b分别是3x1和1x2矩阵,如果让它们相加,它们的形状不匹配。 我们将两个矩阵广播为一个更大的3x2矩阵,矩阵a将复制列,矩阵b将复制行,然后相加:

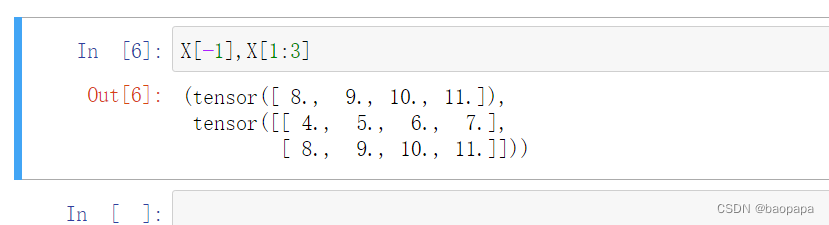

索引和切片

张量中的元素可以通过索引访问。 与任何Python数组一样:第一个元素的索引是0,最后一个元素索引是-1; 可以指定范围以包含第一个元素和最后一个之前的元素。如下所示,我们可以用[-1]选择最后一个元素,可以用[1:3]选择第二个和第三个元素:

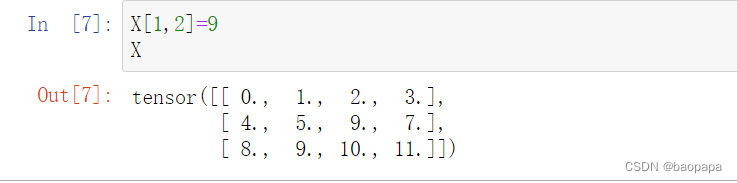

我们还可以指定索引来将元素写入矩阵:

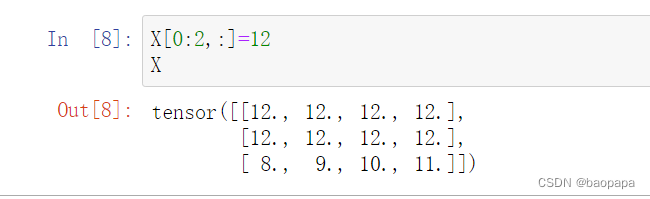

如果我们想为多个元素赋值相同的值,我们只需要索引所有元素,然后为它们赋值。 例如,[0:2, :]访问第1行和第2行,其中“:”代表沿轴1(列)的所有元素。 虽然我们讨论的是矩阵的索引,但这也适用于向量和超过2个维度的张量:

节省内存

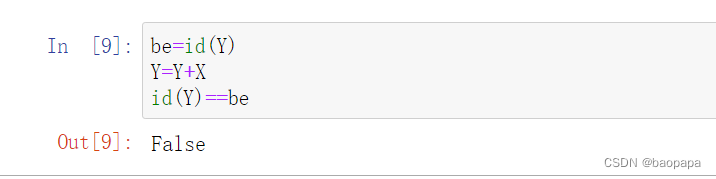

在下面的例子中,我们用Python的id()函数演示了这一点, 它给我们提供了内存中引用对象的确切地址。 运行Y = Y + X后,我们会发现id(Y)指向另一个位置。 这是因为Python首先计算Y + X,为结果分配新的内存,然后使Y指向内存中的这个新位置:

这可能是不可取的,原因有两个:首先,我们不想总是不必要地分配内存。 在机器学习中,我们可能有数百兆的参数,并且在一秒内多次更新所有参数。 通常情况下,我们希望原地执行这些更新。 其次,如果我们不原地更新,其他引用仍然会指向旧的内存位置, 这样我们的某些代码可能会无意中引用旧的参数。

这可能是不可取的,原因有两个:首先,我们不想总是不必要地分配内存。 在机器学习中,我们可能有数百兆的参数,并且在一秒内多次更新所有参数。 通常情况下,我们希望原地执行这些更新。 其次,如果我们不原地更新,其他引用仍然会指向旧的内存位置, 这样我们的某些代码可能会无意中引用旧的参数。

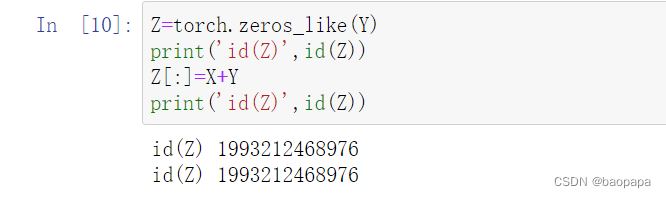

幸运的是,执行原地操作非常简单。 我们可以使用切片表示法将操作的结果分配给先前分配的数组,例如Y[:] = 。 为了说明这一点,我们首先创建一个新的矩阵Z,其形状与另一个Y相同, 使用zeros_like来分配一个全0的块:

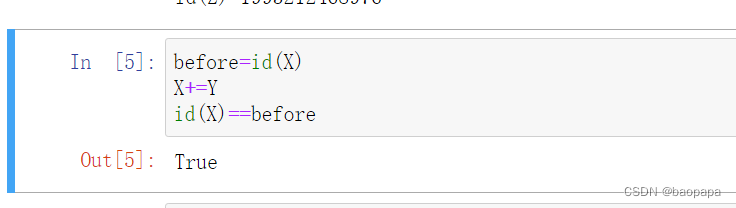

如果在后续计算中没有重复使用X, 我们也可以使用X[:] = X + Y或X += Y来减少操作的内存开销:

转换为其他Python对象

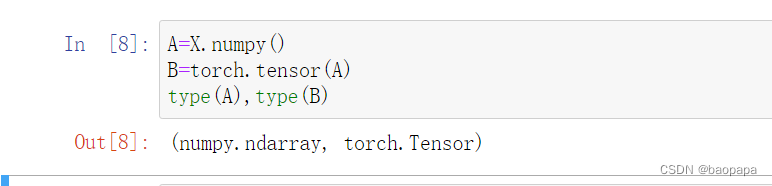

将深度学习框架定义的张量转换为NumPy张量(ndarray)很容易,反之也同样容易。 torch张量和numpy数组将共享它们的底层内存,就地操作更改一个张量也会同时更改另一个张量:

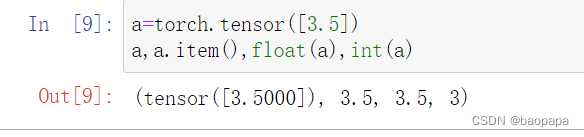

要将大小为1的张量转换为Python标量,我们可以调用item函数或Python的内置函数:

1086

1086

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?