跨模态行人重识别 | Visible Thermal Re-ID

- 0x00 可见光与热红外跨域人物识别常用数据集

- 0x01 Visible Thermal Person Re-Identification via Dual-Constrained Top-Ranking, IJCAI2018

- 0x02 CMTR: Cross-modality Transformer for Visible-infrared Person Re-identification, ECCV2022

- 0x03 AGW

- 0x04 PartMix: Regularization Strategy to Learn Part Discovery for Visible-Infrared Person Re-identification, CVPR2023

读了就忘,不如记记😃最近细看过一篇关于跨模态personReID的manuscript,还蛮有意思

0x00 可见光与热红外跨域人物识别常用数据集

1.RegDB:由两个摄像头采集,包含412人,对于每个人有10张visible图像和10张thermal图像。

(该数据集较小,一般会重复试验10次取平均值)

2.SYSU-MM01:由6个摄像机采集的大规模数据集,包括4 visible cameras,2 thermal cameras,分室内外,包含491人,每个人至少被两个不同的相机捕获图像。

0x01 Visible Thermal Person Re-Identification via Dual-Constrained Top-Ranking, IJCAI2018

已开源

红外热域(thermal domain)和可见域(visible domain)之间的跨模态的Person ReID对于夜间监视应用极为重要,现有工作大多通过学习可共享的特征表示来处理跨模态差异。但是除了相机光谱引起的跨模态差异外,还受到相机视角和行人姿态引起的较大差异(包括模态内和跨模态)。

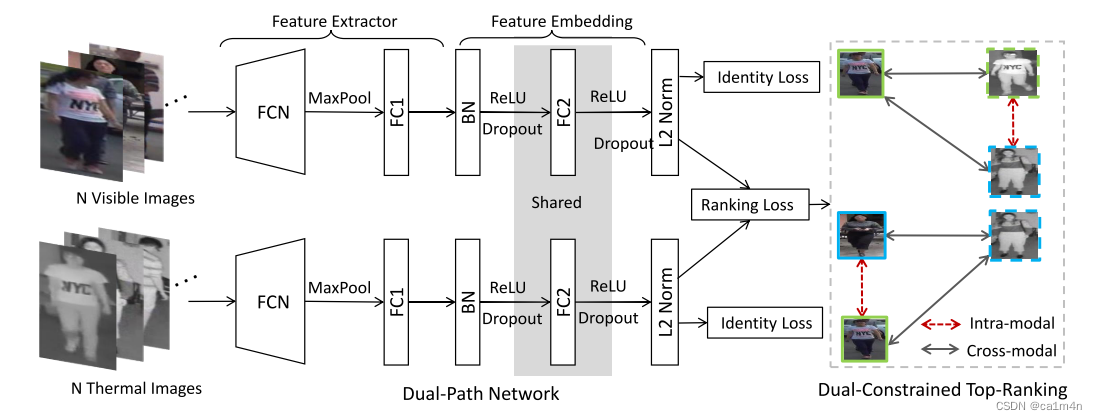

本文提出一种新颖的双向双约束顶级损耗的双路径网络(dual-path network with a novel bi-directional dual-constrained top-ranking loss)来处理大的类内变化,发挥学习的特征表示的可区分性(discriminability):

1、end to end;

2、同时处理跨模态(cross-modality)和模态内(intra-modality)变化。

具体来说,浅层的参数独立于提取特定模态的信息,然后进一步利用共享的FC层(特征嵌入)来学习嵌入空间。

设计训练过程中使用的loss考虑两个方面:

(1)cross-modality top-ranking constraint

预定义margin使得:anchor到跨模态的正样本的最远距离 < anchor到跨模态的负样本的最近距离 成立

(2)intra-modality top-ranking constraint

在上述同一框架中,同一模态内的正负样本距离anchor的距离是可区分的(distinguishable)

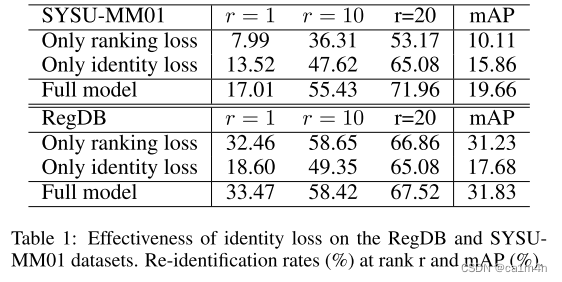

另外,作者进行实验验证在RegDB和SYSU-MM01上identity loss和ranking loss的有效性:

另外,作者进行实验验证在RegDB和SYSU-MM01上identity loss和ranking loss的有效性:

0x02 CMTR: Cross-modality Transformer for Visible-infrared Person Re-identification, ECCV2022

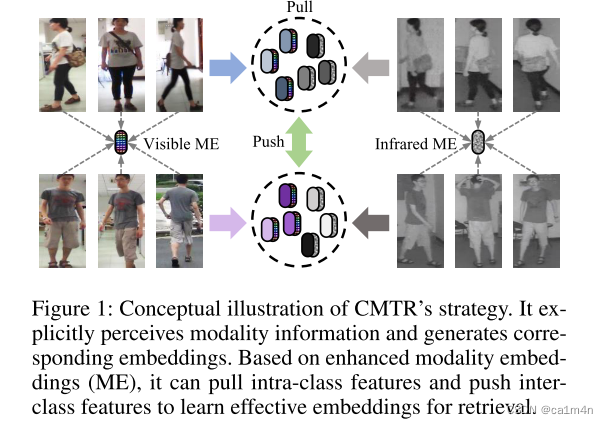

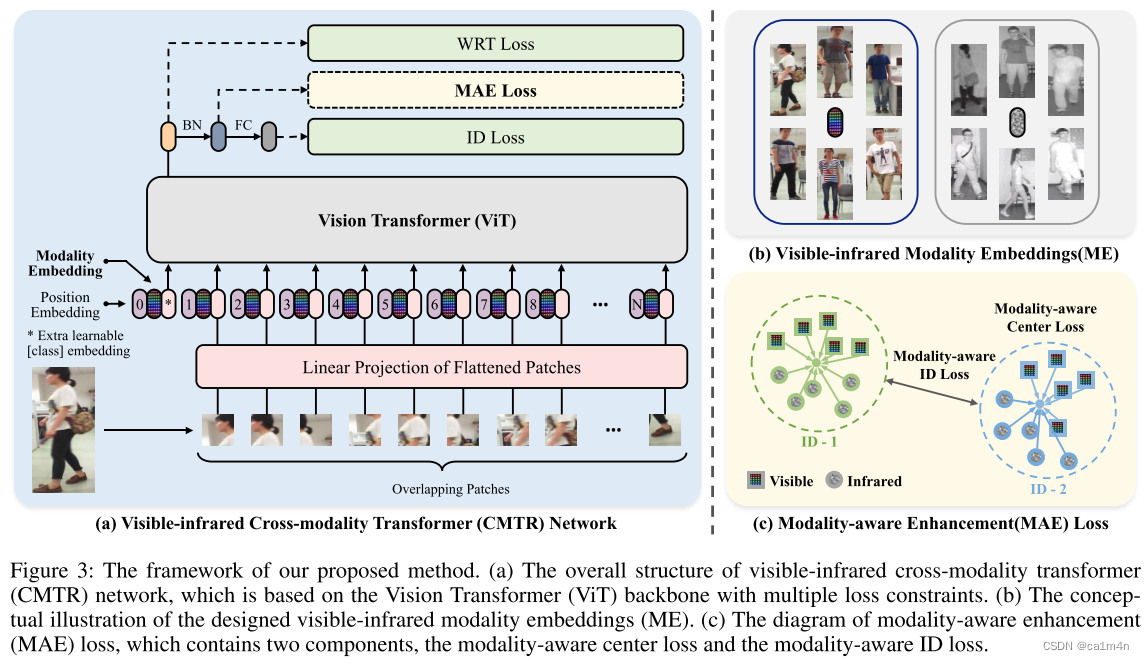

本研究首次提出一种基于Transformer模型的跨模态person ReID方法(Cross-Modality TRansformer,CMTR)

作者指出像0x01这样的模型(通过不共享的浅层来提取不同模态图像的特征,共享的深层来学习判别特征)的策略并不能很好地保证所设想的分工,而忽略了对内置模态特征的充分感知和更深入的挖掘。

为突破基于卷积神经网络CNN的方法的局限性,本研究提出基于transformer的模型CMTR:该模型可以通过显式方式学习embeddings来捕获模态特征,并在此基础上生成更有效的匹配嵌入:

- 将 模态嵌入(ME) 引入本文的方法,ME可以通过添加到patch的token嵌入来集成到transformer框架的输入阶段。

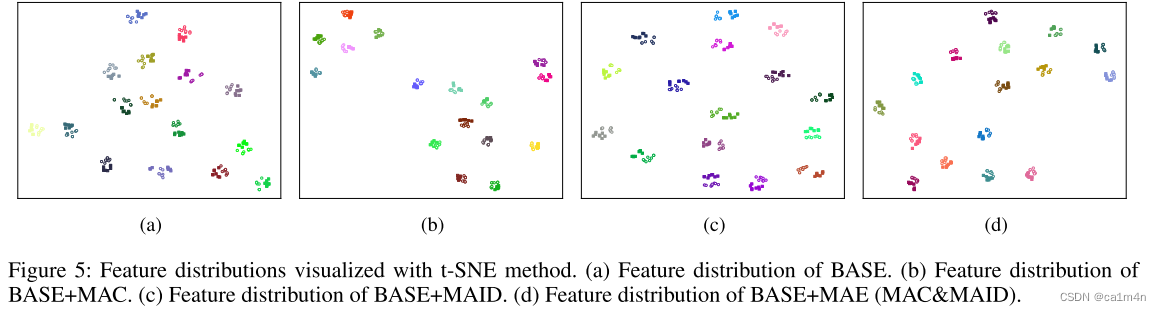

- 为了增强对可学习ME的约束和优化匹配嵌入的分布,设计了模态感知增强损失函数(modality-aware enhancement, MAE):模态感知中心损失+模态感知ID损失+模态去除过程(从ME中减去所学模态的知识,pull类内特征并push类间特征).

如图所示,输入嵌入由三部分组成:标记嵌入+位置嵌入+模态嵌入(每个模态中的图像和所有patch共享相同的embedding)。

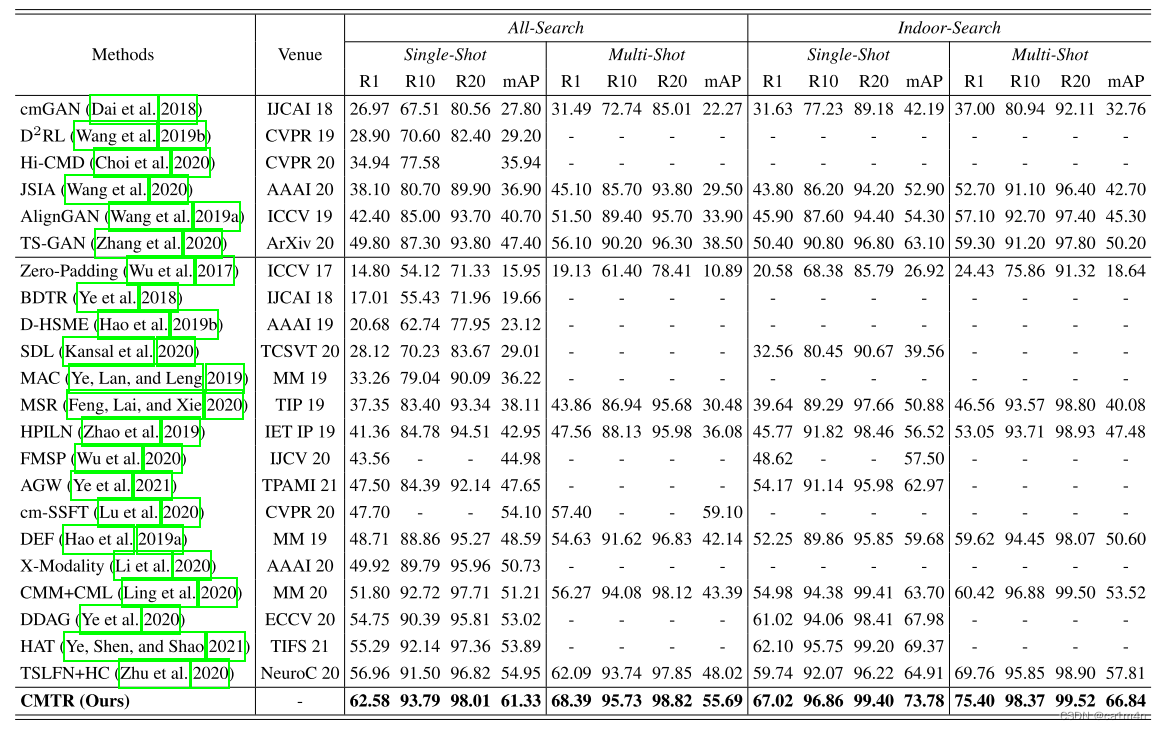

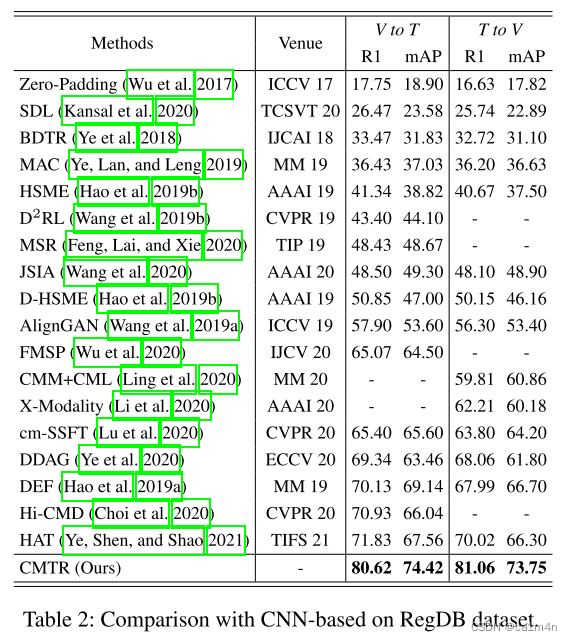

EXTENSIVE EXPERIMENTS:

可以看到在两个数据集中,本文所提出的CMTR方法性能显著超过了现有基于CNN的方法。

可以看到在两个数据集中,本文所提出的CMTR方法性能显著超过了现有基于CNN的方法。

0x03 AGW

Deep Learning for Person Re-identification: A Survey and Outlook, TPAMI2021

Code

文章对基于深度学习的行人重识别工作的综述和展望以及提出了:

-

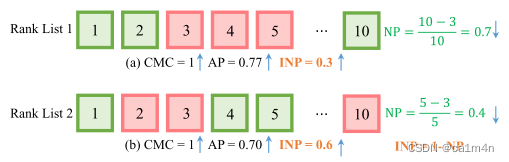

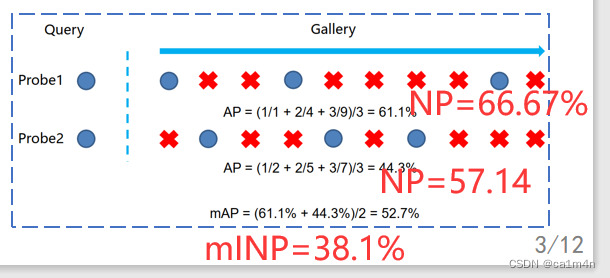

一种新的评价指标mINP

考虑到目标行人在检索列表中排名靠前也是重要指标(精确性)

但是CMC和AP还不能很好度量Re-ID的计算效率,如图相同CMC的情况下,List1的AP高于List2,实际上通过直觉应该是LIst在前5就前检索到全部正确图像,应该指标更好些,

于是提出NP:

N P i = R i h a r d − ∣ G i ∣ R i h a r d NP_i=\frac{R^{hard}_i-|G_i|}{R^{hard}_i} NPi=RihardRihard−∣Gi∣

I N P = 1 − N P INP=1-NP INP=1−NP

INP可以作为CMC和mAP指标的补充评价,INP越大性能越好。

限制是对于较大的图库来说,mINP值的差异会比较小,而对于较小的图库来说,mINP值的差异会更大。所以应该谨慎考虑图库大小的影响,特别是在小型图库上的性能差异可能更大。 -

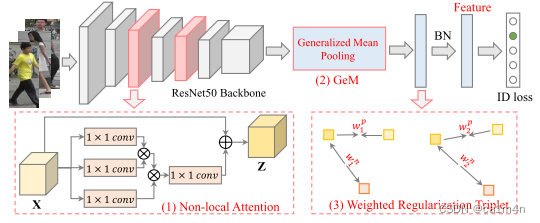

一个针对单/跨模态行人重识别的baseline

AGW, Attention Generalized mean pooling with Weighted triplet loss

基于resnet50设计的双流模型,是在罗浩博士A strong reid baseline的工作基础上进行设计,方法在两个数据集上验证:RegDB and SYSU-MM01,➕可视化结果,建议自己多看看其代码。

- Non-local Attention (Att) Block [1]

使用非局部注意块来获得所有位置特征的加权和。 - Generalized-mean(GeM)Pooling[2]

池化操作由一个池化超参数控制:当其接近正无穷时,近似于最大池化操作;当其等于1时,近似于平均池化操作。 - Weighted Regularization Triplet(WRT)loss

加权正则化三元组损失,继承难样本三元组损失的优点,类似于[3]但没有引入额外的边界参数。

- Non-local Attention (Att) Block [1]

[1] X. Wang, R. Girshick, A. Gupta, and K. He, “Non-local neural networks,” in CVPR, 2018, pp. 7794–7803.

[2] F. Radenovi´c, G. Tolias, and O. Chum, “Fine-tuning cnn image retrieval with no human annotation,” IEEE TPAMI, vol. 41, no. 7, pp. 1655–1668, 2018.

[3] X. Wang, X. Han, W. Huang, D. Dong, and M. R. Scott, “Multisimilarity loss with general pair weighting for deep metric learning,” in CVPR, 2019, pp. 5022–5030.

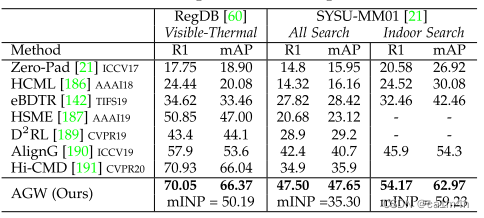

跨模态上的实验表现:

可以看到在SYSU-MM01数据集上AGW是绝对优势。

文末对一些开放问题进行了讨论,包括:不可控的数据采集、减少人工标注依赖、面向Re-ID通用网络设计、动态的模型更新和高效的模型部署。

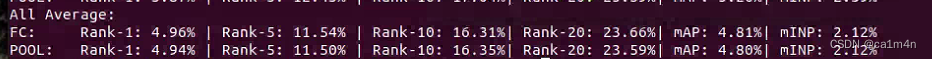

BTW,复现时,RegDB上的训练结果与文中性能表现基本一致,test:?

已解决

已解决

指路更新👉【实验记录】AGW | Visible-Infrared Re-ID

0x04 PartMix: Regularization Strategy to Learn Part Discovery for Visible-Infrared Person Re-identification, CVPR2023

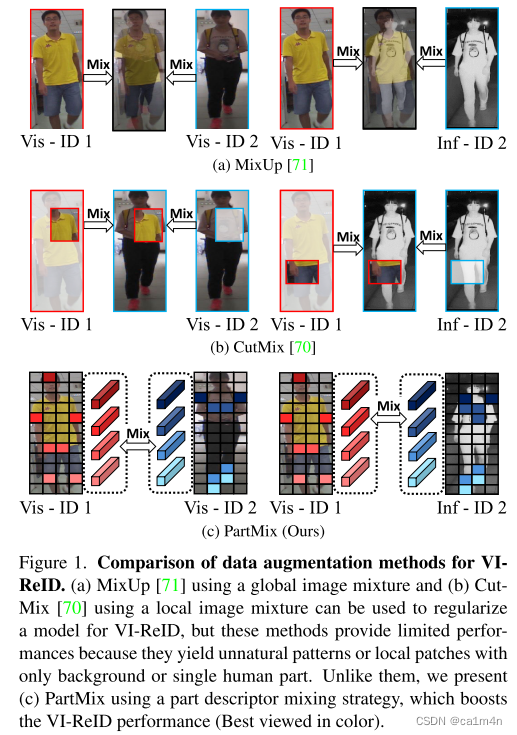

本文提出一种新颖的数据增强技术PartMix,该技术通过在模态中混合part描述符来合成增强样本,以提高part-based的VI-ReID模型。

文章指出诸如MixUP(是一种全局图像混合方法),CutMix(局部图像混合)的方法,产生了不自然的模式或仅具有背景或单个人部分的局部patch,使得性能有限,而PartMix可以克服现有数据增强方法的局限性。

464

464

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?