本文参考机智流:Llama3-Tutorial,感谢机智流提供的学习教程和免费算力!

创建Python环境

# 创建指定python环境

conda create -n llama3 python=3.10

conda activate llama3

# 安装依赖

conda install pytorch==2.1.2 torchvision==0.16.2 torchaudio==2.1.2 pytorch-cuda=12.1 -c pytorch -c nvidia下载模型

因为Internstudio每次重启都会删掉/root以外的文件,因此我们要在/root下创建model目录,来存放我们的模型,避免下次重启被删除

mkdir -p ~/model

cd ~/model在InternStudio上模型已经存在了,为了节约磁盘空间,直接使用软链引用即可。

ln -s /root/share/new_models/meta-llama/Meta-Llama-3-8B-Instruct ~/model/Meta-Llama-3-8B-Instruct部署

首先下载由机智流提供的webui

cd ~

git clone https://github.com/SmartFlowAI/Llama3-Tutorial安装 XTuner 时会自动安装其他依赖

cd ~

git clone -b v0.1.18 https://github.com/InternLM/XTuner

cd XTuner

pip install -e .运行 web_demo.py

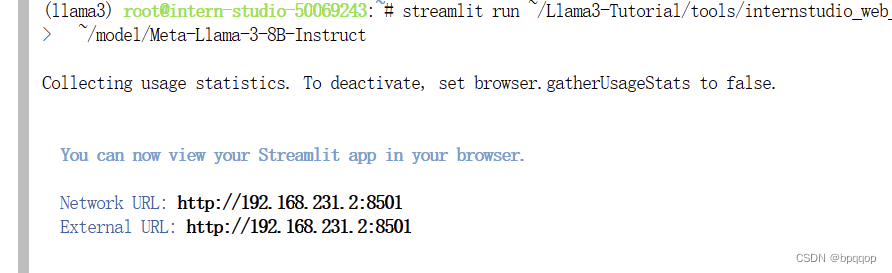

streamlit run ~/Llama3-Tutorial/tools/internstudio_web_demo.py \

~/model/Meta-Llama-3-8B-Instruct

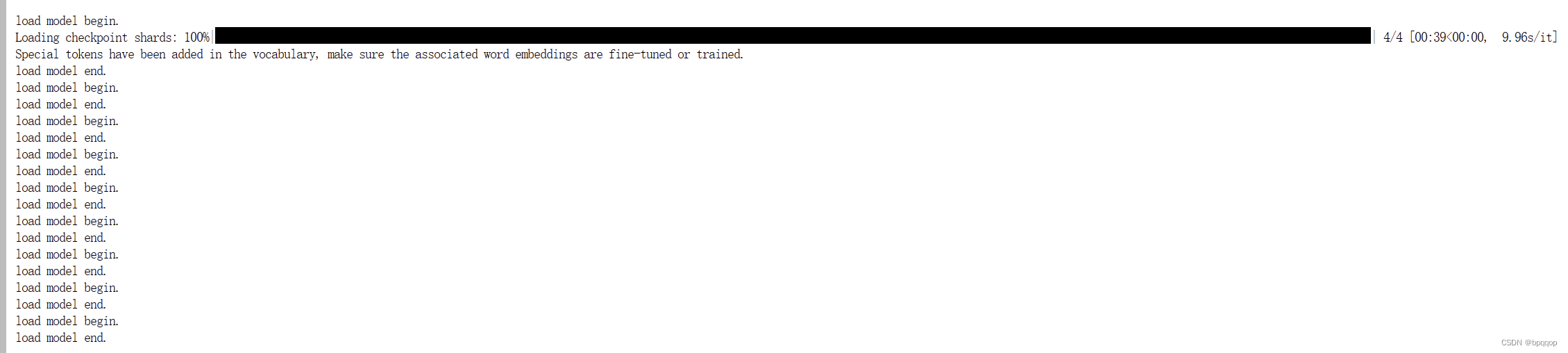

运行成功之后,控制台会打印访问地址,这个地址是一个InternStudio上的内网地址,不能直接访问,需要映射出来,参考VScode 远程连接开发机,或者使用ssh映射,如下图:

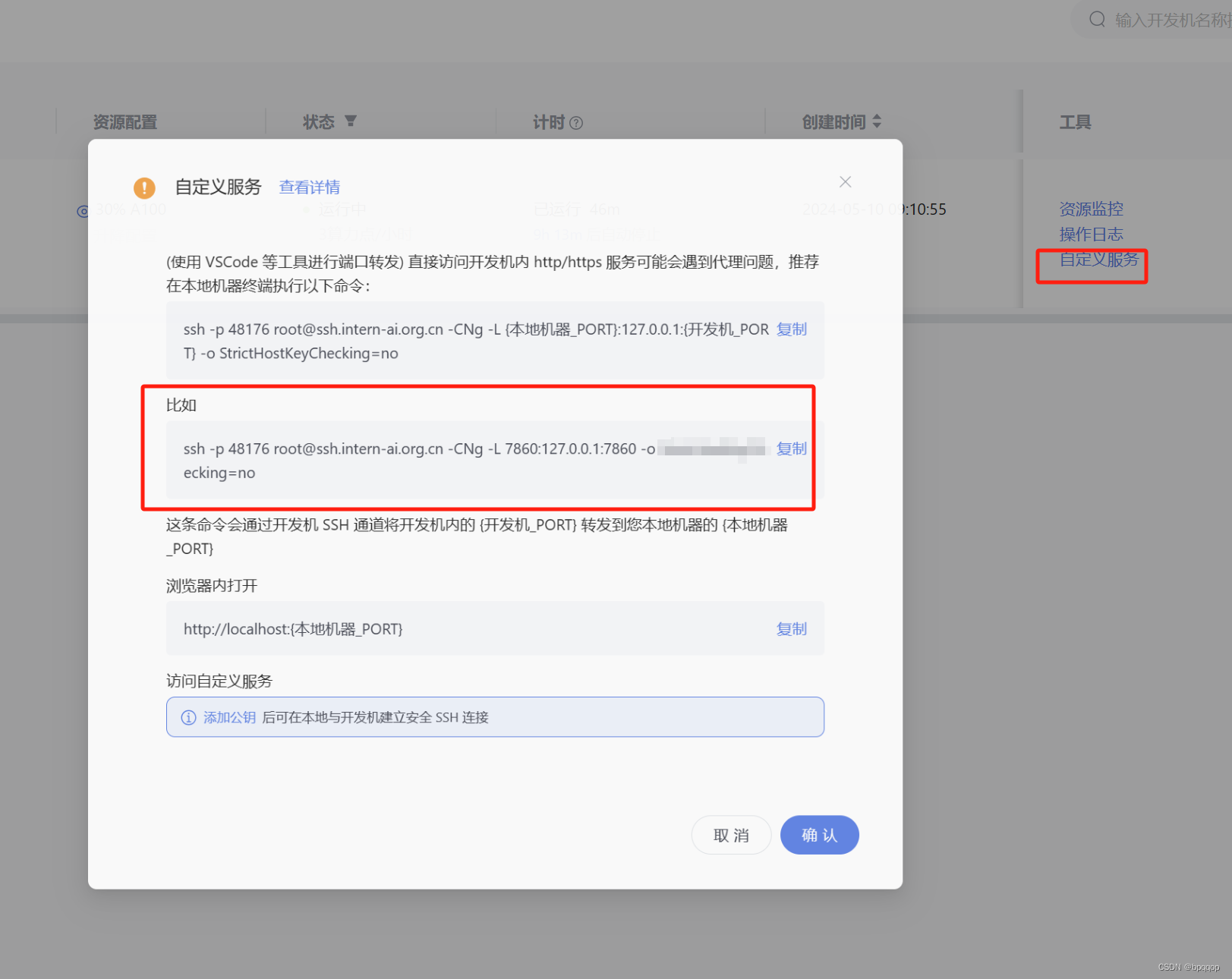

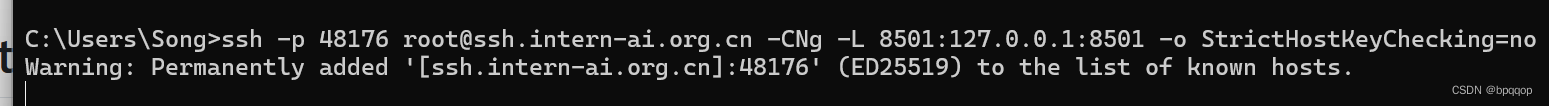

注意将其中的端口号替换成8501

使用SSH时需要先配置ssh key,更多请参考InternStudio的用法

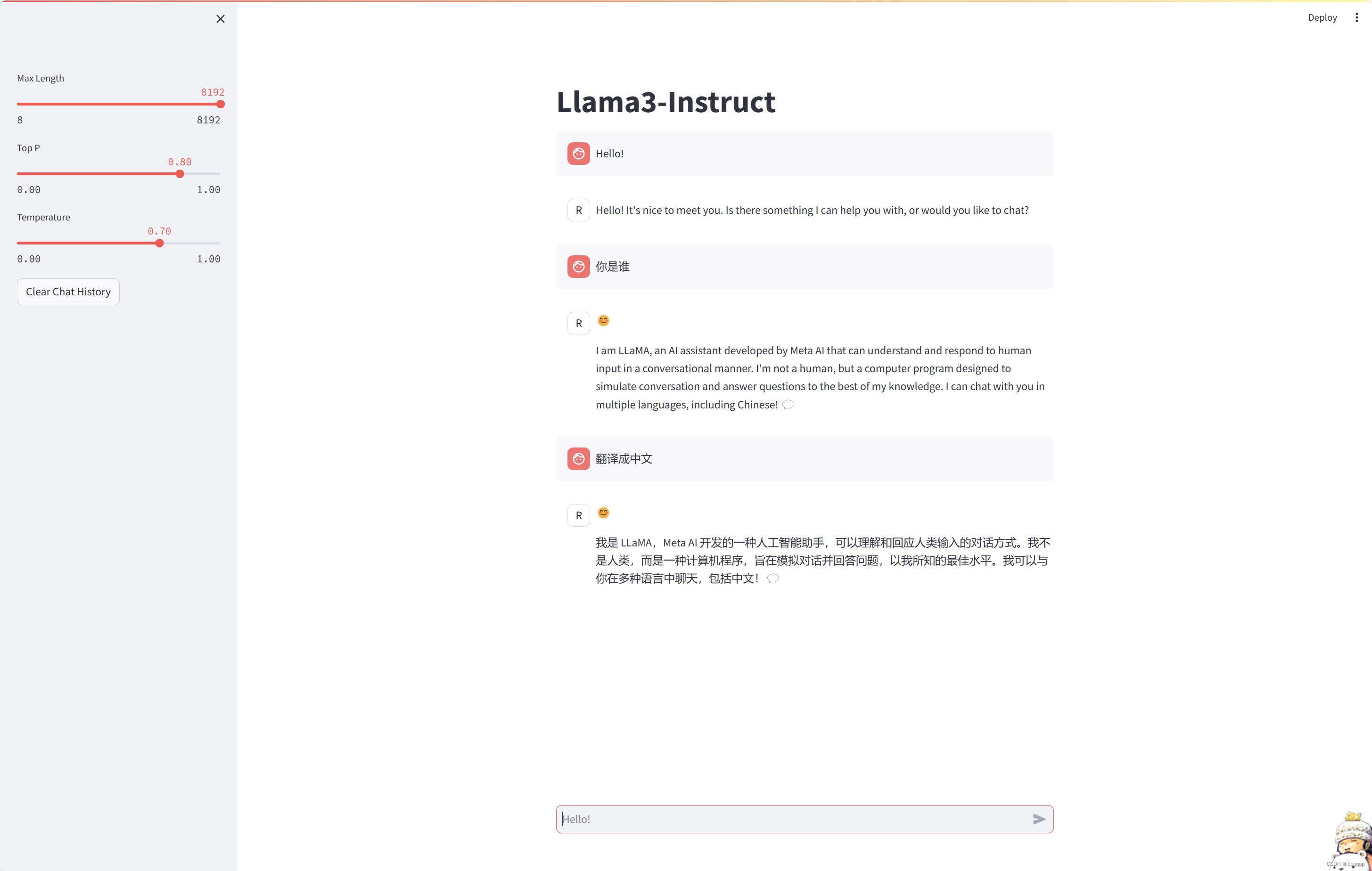

访问界面如下:

可以看到后台的打印,速度很快!

最后

实战营第二期开始报名了!扫码报名免费学,免费提供算力!

2148

2148

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?