©作者 | 陈铮

单位 | 上海交通大学

本研究提出了一种 Transformer 模型——RGT,旨在降低超分模型计算量。RGT 模型通过递归泛化自注意力(RG-SA),以线性复杂度捕获全局空间信息,实现低计算成本。

论文题目:

Recursive Generalization Transformer for Image Super-Resolution

论文链接:

https://arxiv.org/abs/2303.06373

代码链接:

https://github.com/zhengchen1999/RGT

动机

在图像超分辨率(Super Resolution,SR)的领域中,Transformer 凭借自注意力(Self-Attention,SA)机制展现出卓越的性能。然而,尽管 SA 在理论上能够捕捉全局依赖,实际应用中,为了降低其在处理高分辨率图像时的计算负担,研究者通常采用局部自注意力策略。

这种局部策略虽然能够减少计算资源的消耗,但同时也限制了模型对全局上下文信息的利用。因此,需要开发一种图像SR方法,能够在高分辨率图像上以较低的计算成本有效捕获全局空间信息。

▲ 图片1. LAM可视化:右侧三张图片红色区域代表左一红框位置涉及到像素,红色越多,信息利用范围越大

为了解决这一挑战,我们提出泛化递归Transformer(Recursive Generalization Transformer,RGT),核心为递归泛化自注意力(Recursive-Generalization Self-Attention,RG-SA)机制。RG-SA 递归地将输入聚合成具有代表性的特征图,并利用交叉注意力机制来提取全局信息。

此外,我们还设计了用于模块集成的混合自适应集成(Hybrid Adaptive Integration,HAI),允许不同级别(局部或全局)特征之间的融合。通过这些设计,我们的 RGT 可以捕获全局信息以实现精确的图像 SR,同时复杂性可控。

方法

2.1 Overall

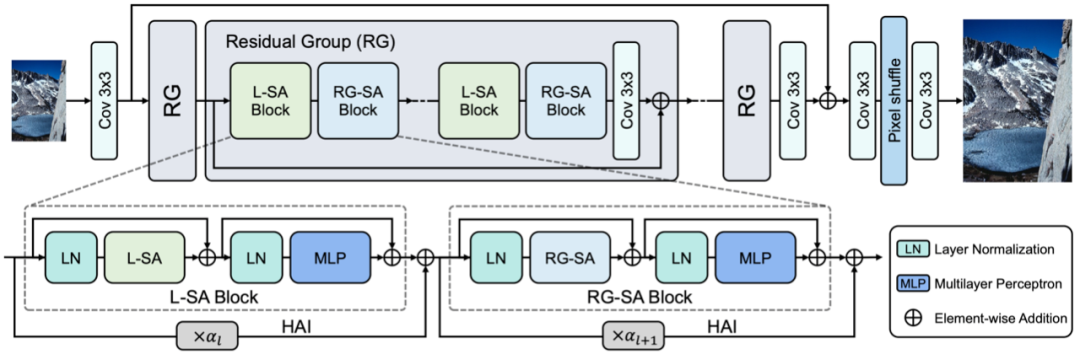

▲ 图片2. RGT整体架构

RGT 的整体架构如图,主要组成为残差块(Residual Group,RG)。每个 RG 包含多个 Transformer 块,并采用残差连接。Transformer 块有两种类型:局部自注意力(Local Self-Attention,L-SA)块和 RG-SA 块。两种类型的块交替排列以组织拓扑结构。同时,HAI 通过可学习的适配器 作用于每个块外部。在本工作中,L-SA 采用近期提出的窗口自注意力。

2.2 RG-SA

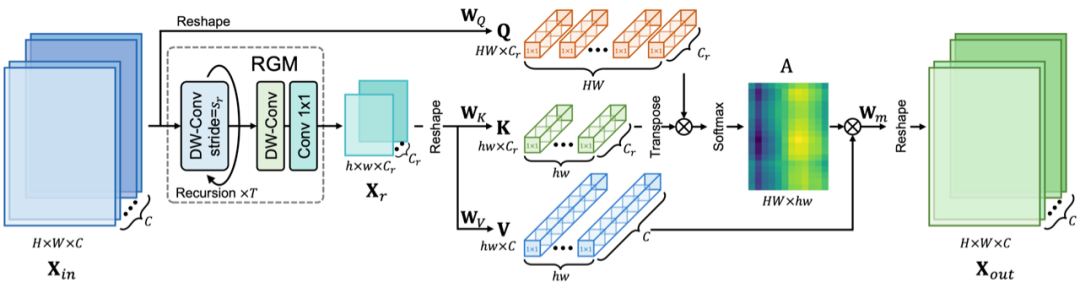

▲ 图片3. RG-SA示意图

为了解决SA在大尺寸图像上的高复杂度,我们提出递归泛化自注意力(RG-SA)。

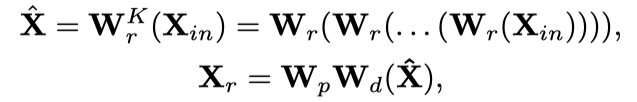

RG-SA 首先通过递归泛化模块(Recursive Generalization Module,RGM)将任意分辨率的输入特征 递归聚合成压缩图 :

其中 代表深度(depth-wise)卷积, 代表递归次数, 和 是深度可分离卷积。此处的迭代次数 由 和 的尺寸决定。同时,为了计算效率,我们还对通道数进行缩放,缩放因子为 。

接着,通过交叉注意力,捕捉 中的全局信息:

其中查询 来自 ,键值和值来自 。通过 RGM 和交叉注意力,RG-SA 能够有效建模全局空间信息。

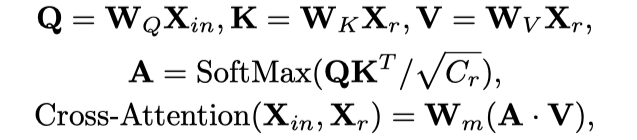

复杂度分析:复杂度来自两部分:RGM 和交叉注意力。RGM 复杂度为 ,而交叉注意力复杂度为

结合两者,整体复杂度为 。可以发现,与图片大小 成线性。

2.3 HAI

如图 2,RGT 交替采用 L-SA 和 RG-SA,来建模全局与局部信息。这种拓扑结构使得每个 Transformer 块的输入和输出是不同级别的特征(例如:RG-SA 块的输入是 L-SA 生成的局部特征,而输出是全局特征)。这一观察启发我们通过结合每个块的输入和输出特征来增强信息融合。

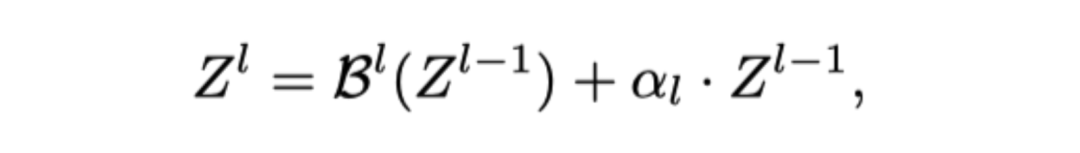

我们通过跳跃连接(Skip Connection)直接集成输入和输出特征。同时,考虑到全局特征和局部特征之间的不一致,我们采用适配器 缩放输入特征,从而设计出混合自适应集成(HAI):

其中 和 代表第 Transformer 块的输入和输出, 则是可学习参数。总体而言,HAI 能够增强不同 SA 模块的集成,从而获得更好的性能。

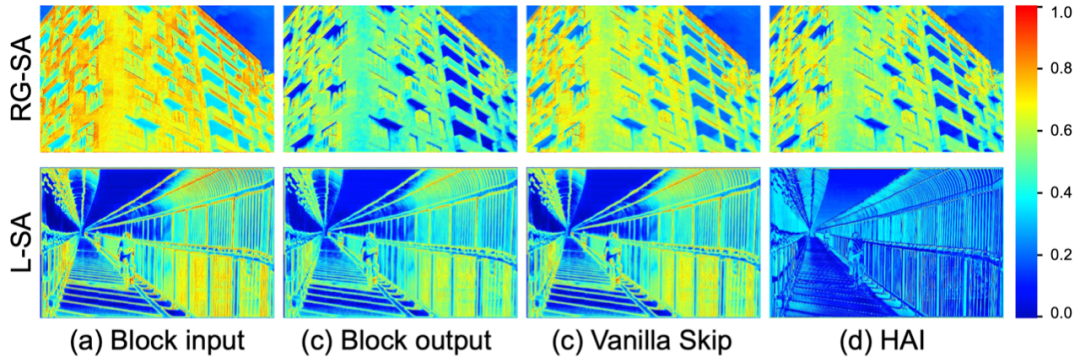

▲ 图片4. 特征图可视化

我们通过可视化直观展示这一作用,通过 HAI(第四列),输入(第一列)和输出(第二列)特征根据不同的块自适应地发生改变,而非跳跃连接(第三列)简单的相加。

实验

3.1 消融实验

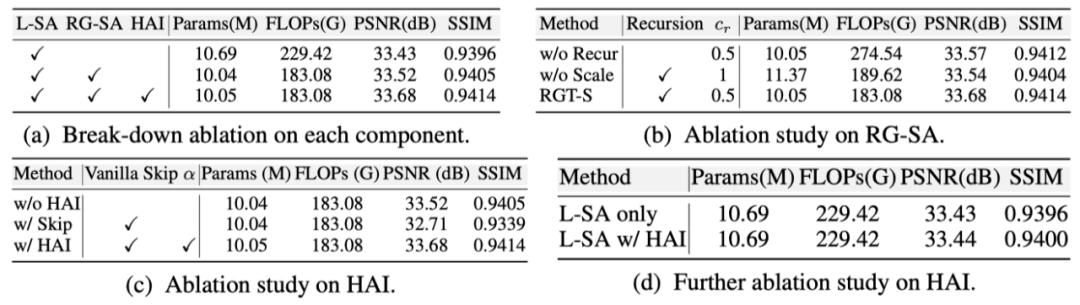

▲ 表格1. 消融实验

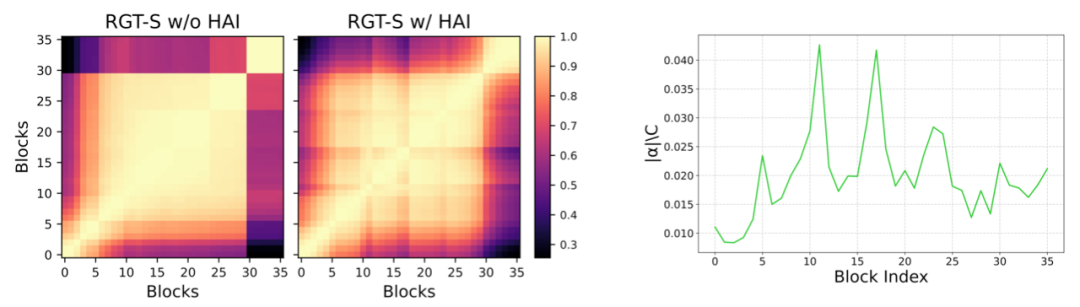

实验证明了提出的各个组件的有效性。同时还可视化了使用HAI前后不同块之间的CKA分数(CKA 得分越高,表示相似度越高),表明HAI在信息传递方面的作用。

▲ 图片5. CKA可视化,与适配器 α 分布

此外,适配器 在不同块之间的不同分布,也表现其自适应性。

3.2 定量对比

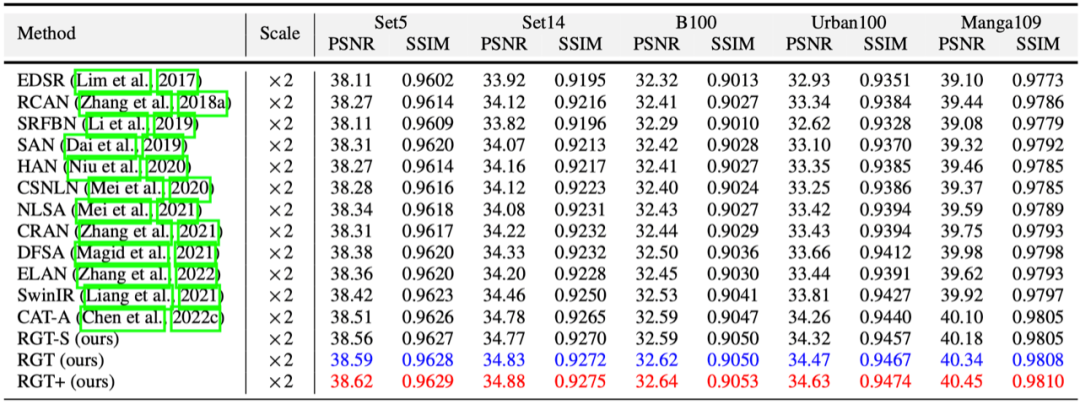

▲ 表格2. 定量对比

我们通过采用不同残差块(RG),构建 2 个不同大小的 RGT 变体:RGT-S 和 RGT,并在 5 个数据集上(Set5、Set14、B100、Urban100、Manga109),与最新方法进行对比。更多结果在论文中提供。

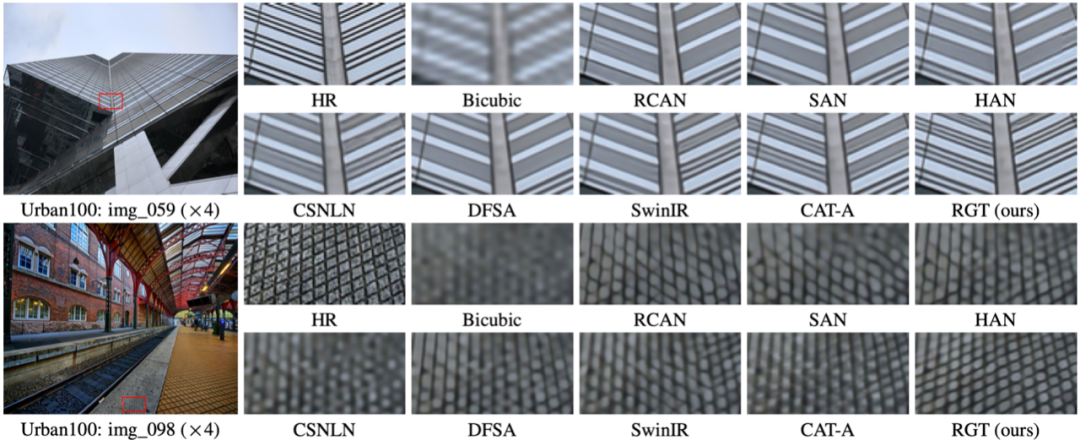

3.3 定性对比

▲ 图片6. 定性对比

我们还提供了视觉对比结果,我们的方法能复原更加清晰的纹理和细节。更多结果在论文中提供。

3.4 复杂度对比

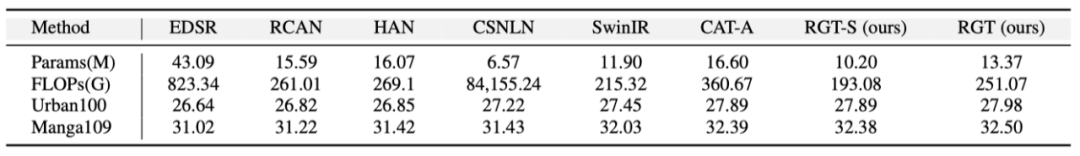

▲ 表格2. 模型大小,复杂度,性能对比

进一步对比模型大小(Params),复杂度(FLOPs),性能对比(PSNR),我们的方法在模型复杂性和性能之间实现了更好的权衡。

总结

在本研究中,我们提出一种 Transformer 模型,RGT,旨在降低超分模型计算量。RGT 模型通过递归泛化自注意力(RG-SA),以线性复杂度捕获全局空间信息,实现低计算成本。此外,通过引入混合自适应集成(HAI),改进不同模块融合。一系列实验证明,我们提出的方法在图像超分辨率任务中的有效性。

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

·

·

810

810

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?