在碎片化阅读充斥眼球的时代,越来越少的人会去关注每篇论文背后的探索和思考。

在这个栏目里,你会快速 get 每篇精选论文的亮点和痛点,时刻紧跟 AI 前沿成果。

点击本文底部的「阅读原文」即刻加入社区,查看更多最新论文推荐。

这是 PaperDaily 的第 133 篇文章

@paperweekly 推荐

#Relation Extraction

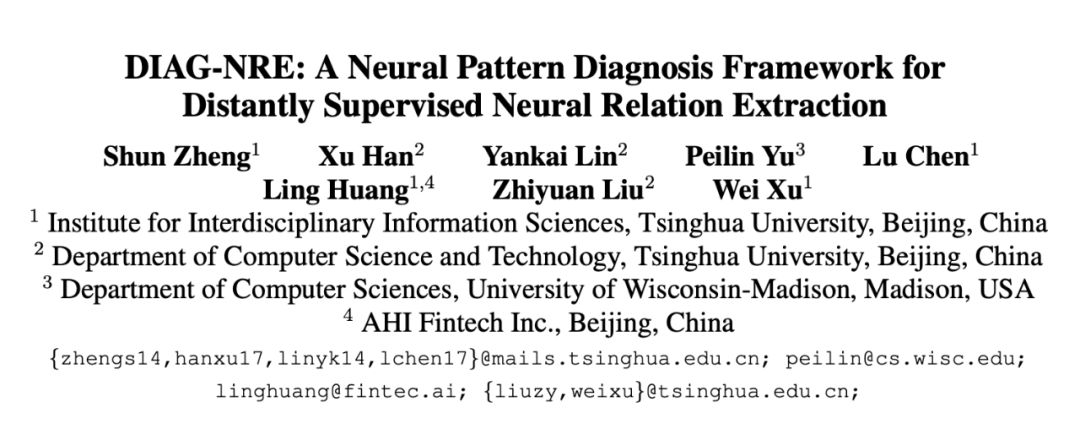

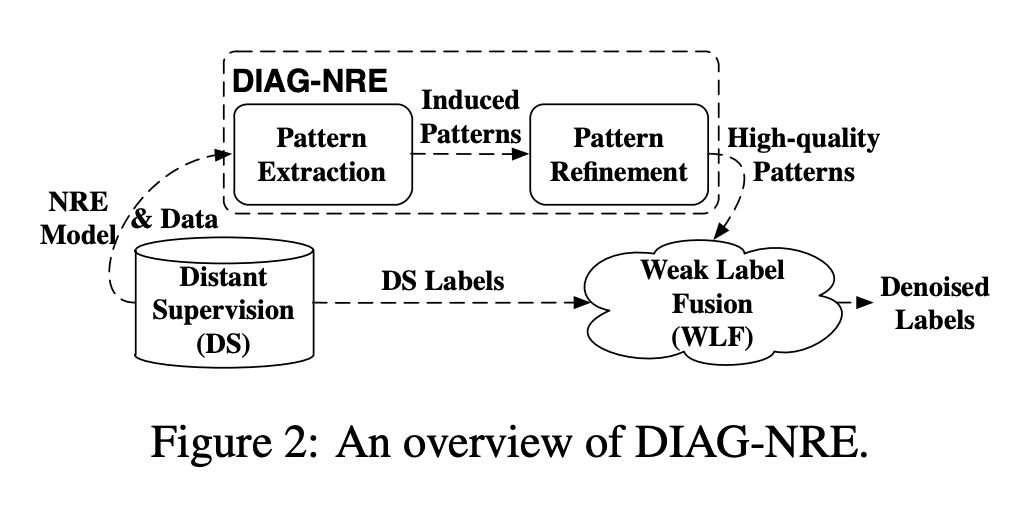

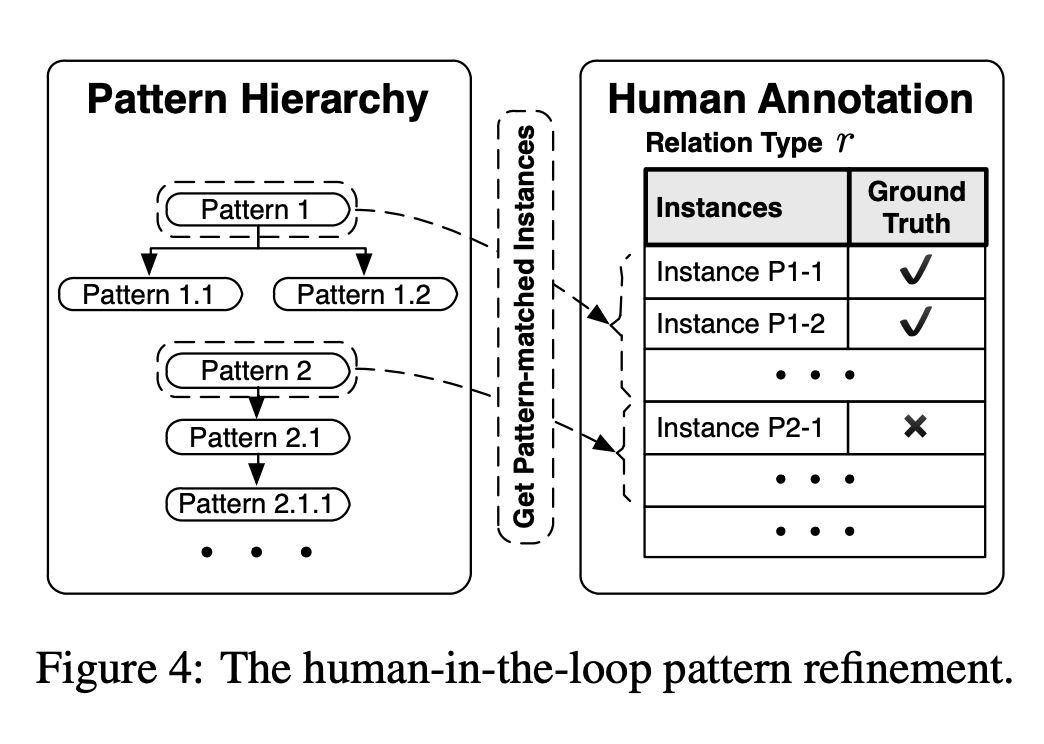

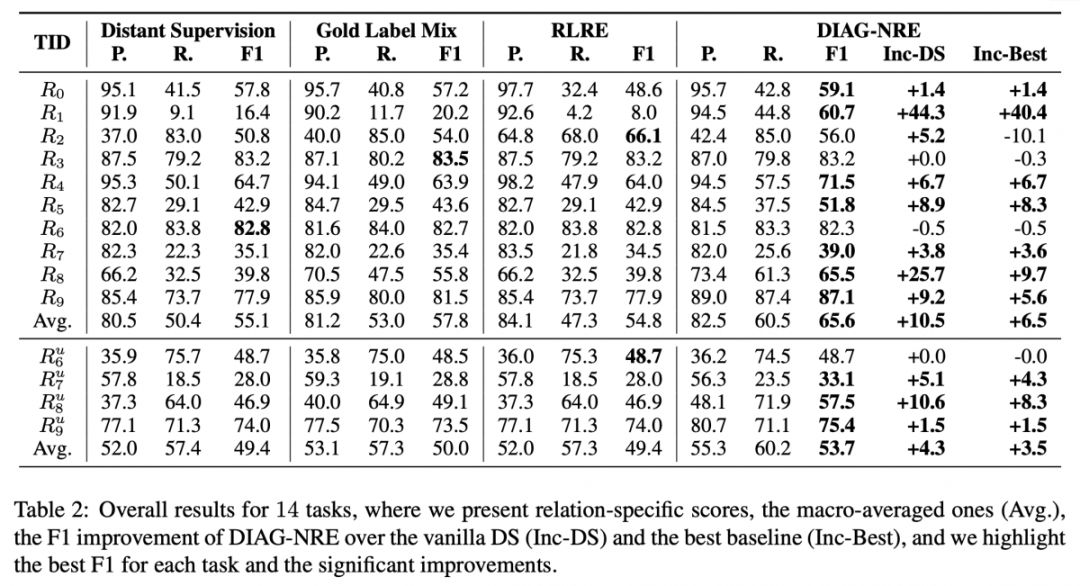

本文是清华大学徐葳老师组和刘知远老师组发表于 ACL 2019 的工作,论文在远程监督与弱监督融合两种技术之间搭建起了一座桥梁,既通过自动生成模式减轻了对领域专家在技能和工作量上的要求,又通过主动式的少量人工标注自动精炼高质量模式,从而赋能在新关系领域上的快速泛化。

此外,DIAG-NRE 不仅能有效抑制标签噪声,同时可以诊断不同关系类型上噪声类型、严重程度等方面,进而直观解释了噪声标签因何而起,又是如何得到抑制。

论文详细解读:ACL 2019 | 面向远程监督关系抽取的模式诊断技术

▲ 论文模型:点击查看大图

论文链接

https://www.paperweekly.site/papers/3109

源码链接

https://github.com/thunlp/DIAG-NRE

@tobiaslee 推荐

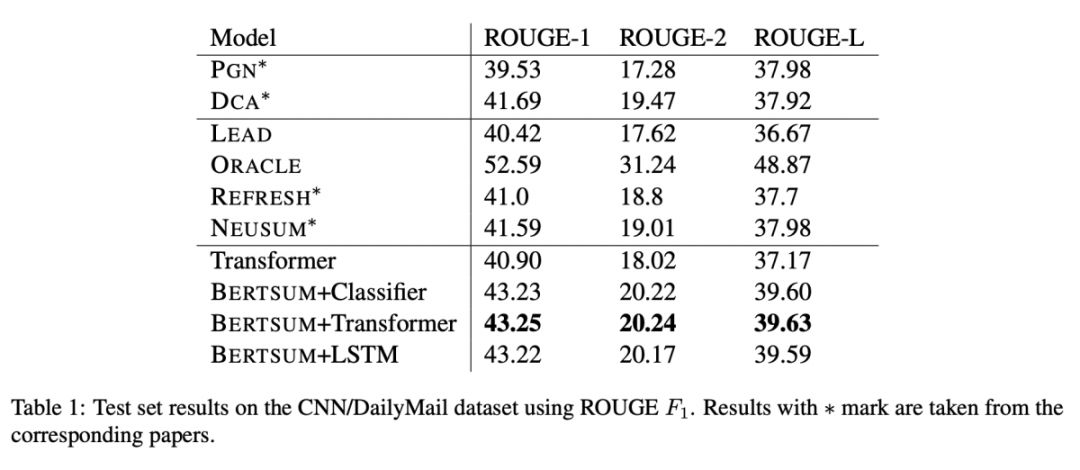

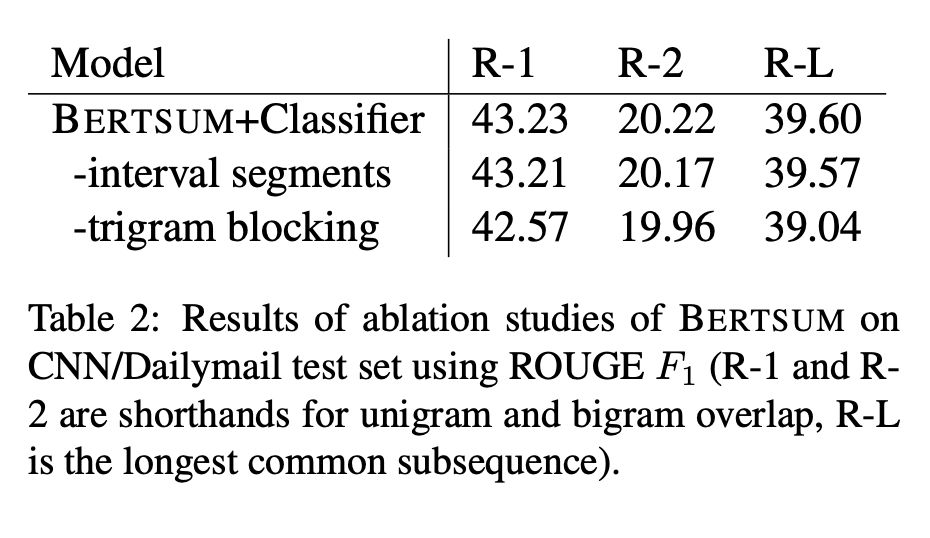

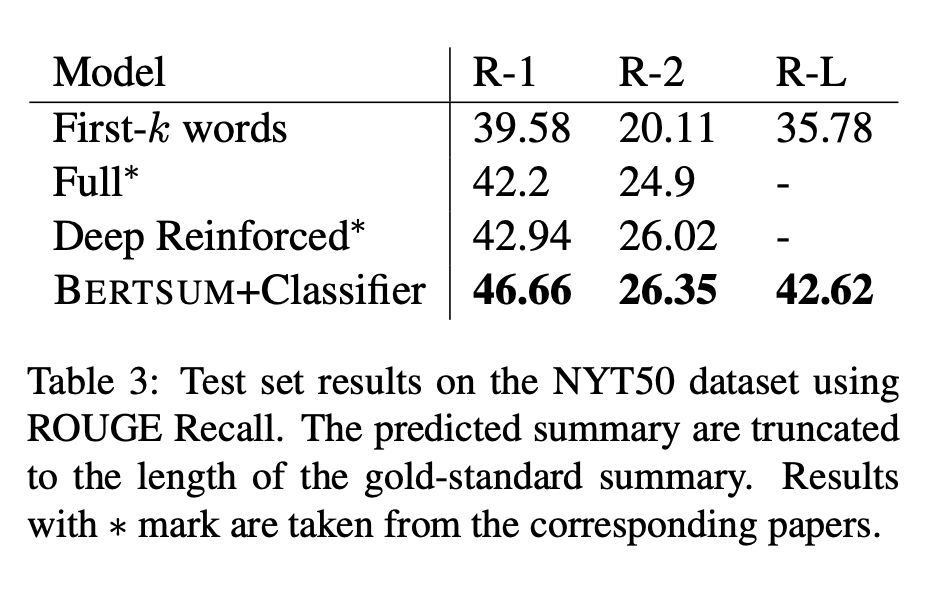

#Extractive Summarization

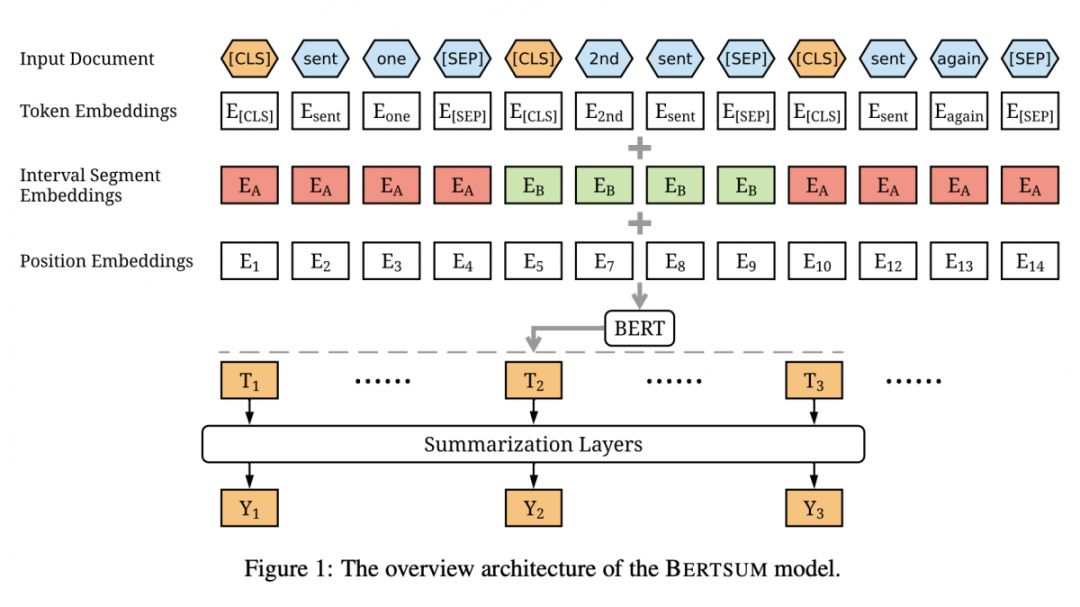

本文是 BERT 在摘要任务上的一次尝试,主要关注抽取式的摘要。对于每个文档中的句子,在句子之前设置一个 CLS,利用 BERT 的设置得到句子的表示,在此基础之上判断是否选取这个句子。进一步地,为了整合 Document-Level 的信息,再得到句子表示之后(即 CLS token),可以再做一次 self-attention 或者是过一层 RNN。此外,除了 BERT 原有的 Positional Encoding,文章为了区别句子(某些词属于某个句子),额外增加了一个 Segment Encoding,对句子进行交错编码。

▲ 论文模型:点击查看大图

论文链接

https://www.paperweekly.site/papers/3110

源码链接

https://github.com/nlpyang/BertSum

@zhoujie 推荐

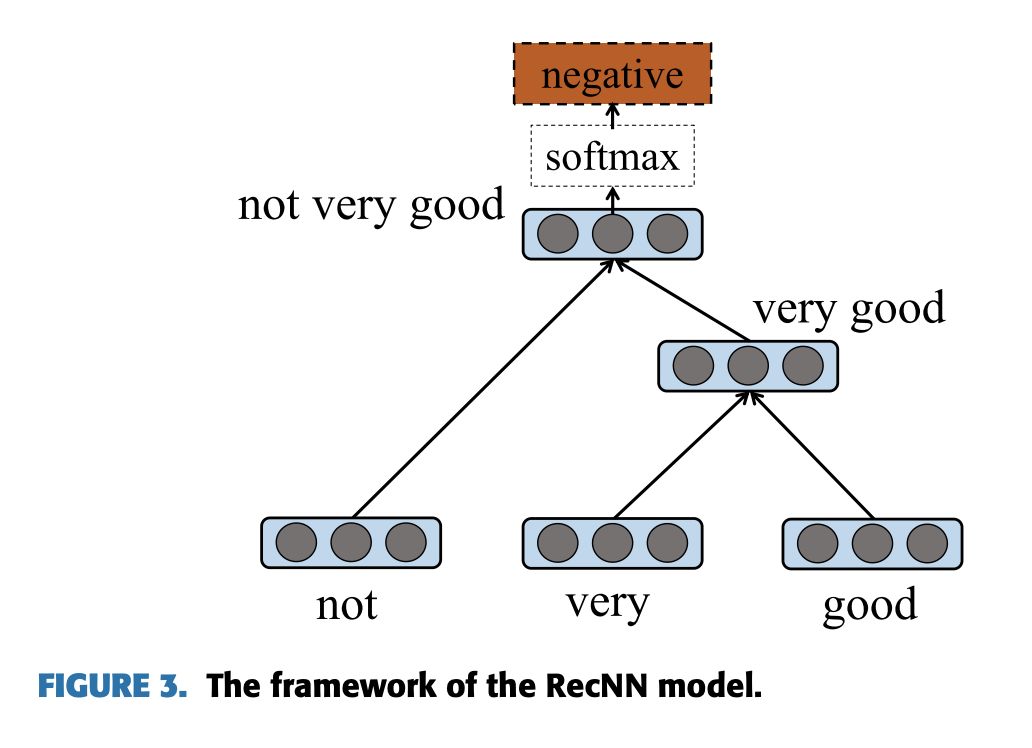

#Sentiment Classification

本文是一篇综述,对目前基于深度学习的 Aspect-level Sentiment Classification 进行了概括总结,对当前各种方法进行了分类。该论文整理了关于 Aspect-level Sentiment Classification 的目前比较常用的数据集,并提供了统一下载的地方。该论文对比了目前比较经典的 state-of-the-art 的模型,并在 5 个数据集上进行实验看模型效果。

▲ 论文模型:点击查看大图

论文链接

https://www.paperweekly.site/papers/3081

源码链接

https://github.com/12190143/Deep-Learning-for-Aspect-Level-Sentiment-Classification-Baselines

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

9299

9299

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?