随着国产大模型DeepSeek-R1模型在网上爆火,出于数据安全与隐私保护、个性化定制、离线\局域网可用性等诸多需求….,废话!!!划重点:白Piao!!

通过以下步骤来教大家如何以最简便的方式实现本地部署,下文以DeepSeek-R1模型部署为例。

一、安装Ollama

打开Ollama官网:Ollama,点击下载:

选择相应的操作系统版本进行下载,本文选用Windows:

下载完成之后点击exe这个文件(找到下载的位置)

点击Install,保持默认安装,等待软件安装完毕。

同时按住Win+R键,在运行框中输入cmd 调出命令提示符,并敲回车键:

在命令提示符黑窗口中输入:ollama -v,出现以下Ollama的版本信息,表示Ollama安装成功:

二、部署DeepSeek-R1模型

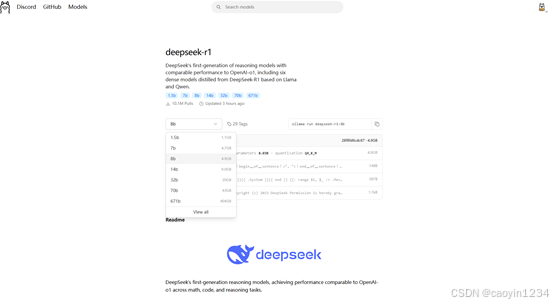

打开Ollama官网 找到Models,Ollama:

根据需求和设备条件选择相应的模型版本,我这里使用的是deepseek-r1:8b模型,模型越大越好用 但对显卡以及电脑的配置的要求也越高:

复制安装命令,如:ollama run deepseek-r1:8b ,进入命令提示符,粘贴命令之后按回车,开始联网下载模型,这个过程需耐心等待。。。。。,当显示success时,表示安装完毕。此时已经可以直接对话,输入:/bye结束会后。

常用命令:

· 启动 ollama 服务器 (serve)

启动一个 ollama 服务器,以便运行模型和处理请求。

ollama server

· 列出所有模型 (list)

列出本地所有可用的模型。

ollama list

显示当前正在运行的模型列表。

ollama ps

· 显示模型信息 (show)

查看特定模型的详细信息,例如模型名称、版本等。

ollama show my_model

运行一个已安装的模型,执行某些任务。

ollama run my_model

三、美化使用界面

这里使用到的是开源工具Chatbox,打开Chatbox官网:https://chatboxai.app/zh,点击下载:

下载完成后找到安装文件,点击Install,保持默认安装,等待软件安装完毕。

点击设置选择OLLAMA APL 接着再选择已下载的模型。

注意!!!你需要确保远程Ollama服务能够远程连接。如果只是连接本机自身模型服务器的话,API域名:127.0.0.1:11434;如果你的模型部署在局域网内某台机器/服务器上,那么安装有Chatbox的客户端只需要将该地址指向模型服务器地址即可,别忘记端口!同时一定要注意防火墙设置正确确保客户端能联通。操作完成之后点击保存即可。

现在你就可以以图形界面的模式开始你的ai之旅了:

局域网,只需要部署一台模型服务器,终端机安装上Chatbox,做好正确的API域名设置即可。

四、其他

如果需要在离线计算机上进行以上安装配置,那么你可以提前做好以下准备工作:

- 准备Ollama安装文件、Chatbox安装文件。

- 准备对应的模型文件,你可以这么做:

- 在已部署好环境及下载好对应模型的计算机上,找到用户目录下的.ollama文件夹

2. 将上述的.ollama文件夹全部替换到你的离线模型服务器对应目录下即可。

3. 其他步骤与上述章节描述一致。

849

849

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?