报错

遇到了来自 OpenAI API 的错误,一般是由错误设置或账户问题引起的。请检查 AI 设置和账户情况,或者点击这里查看常见问题文档。

API Error: Status Code 400, {“error”:{“code”:“invalid_parameter_error”,“param”:null,“message”:“Range of top_p should be (0.0, 1.0)”,“type”:“invalid_request_error”}}

可能你的设置是这样的:

提问后,报错:

分析与解决

首先,chatbox默认top p 为1,Range of top_p should be (0.0, 1.0) ,

只需要将top p 调整到0.99,

阿里的官方文档

阿里这里要求float类型

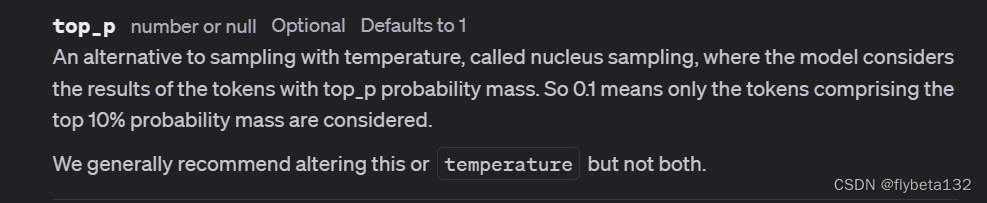

openai官方文档

这里defaults to 1 ,只要求number类型就行

本质上qwen是兼容openai,但不完全兼容,这部分的兼容没做好

Reference:

Reference:

OpenAI: top p

1471

1471

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?